GPT-4 코딩 능력이 21% 향상되었습니다! MIT의 새로운 방법을 통해 LLM은 성찰하는 법을 배울 수 있습니다. 네티즌 : 인간이 생각하는 것과 같은 방식입니다

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-04 12:45:011185검색

노스이스턴대학교와 MIT가 최근 발표한 논문인 Reflexion에 나온 방법입니다.

이 글은 AI 뉴미디어 큐빗(공개 계정 ID: QbitAI)의 승인을 받아 재인쇄되었습니다.

GPT-4가 다시 진화합니다!

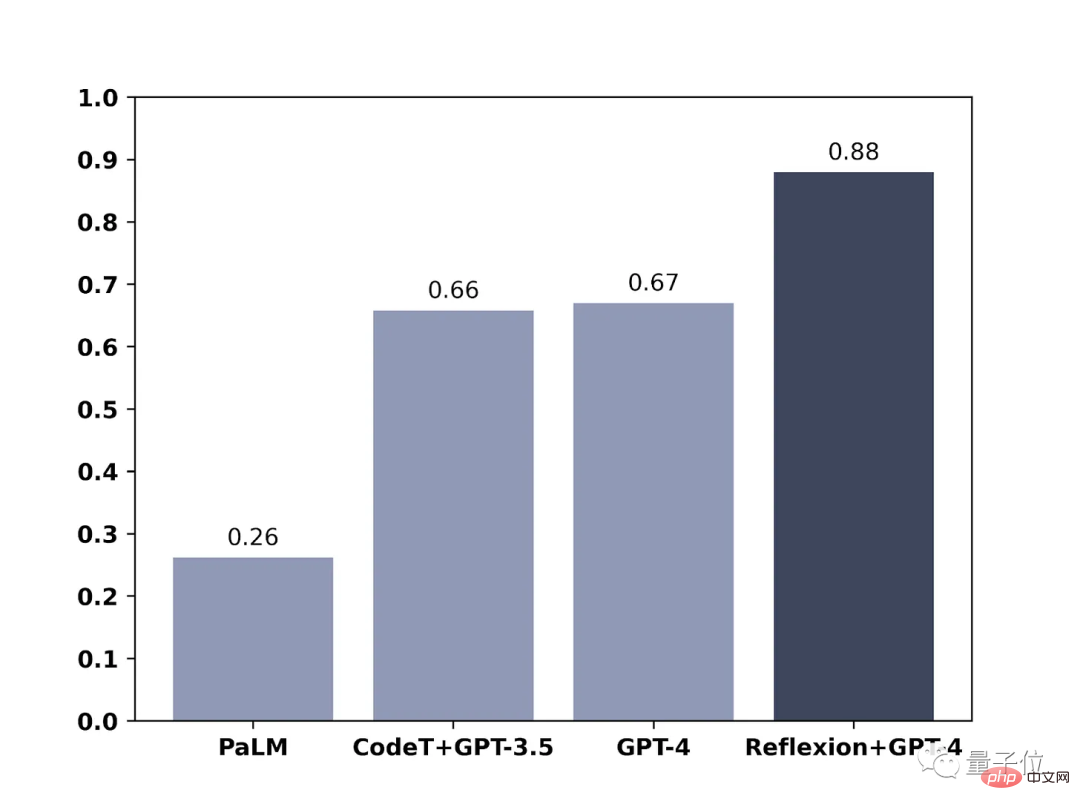

간단한 방법으로 GPT-4와 같은 대규모 언어 모델을 학습하여 성능을 직접적으로 30% 향상시킬 수 있습니다.

이전에는 큰 언어 모델이 잘못된 대답을 하기도 했고, 아무 말도 하지 않고 사과하는 경우가 많았고, 그 다음엔 으으으으으으으으으으으으으으으으으으으으으으으으으으으으으으으으으라고 계속해서 추측을 했습니다.

이제 더 이상 이런 일이 없을 것입니다. 새로운 방법이 추가되면서 GPT-4는 어디가 잘못됐는지 반성할 뿐만 아니라 개선 전략도 제시할 예정입니다.

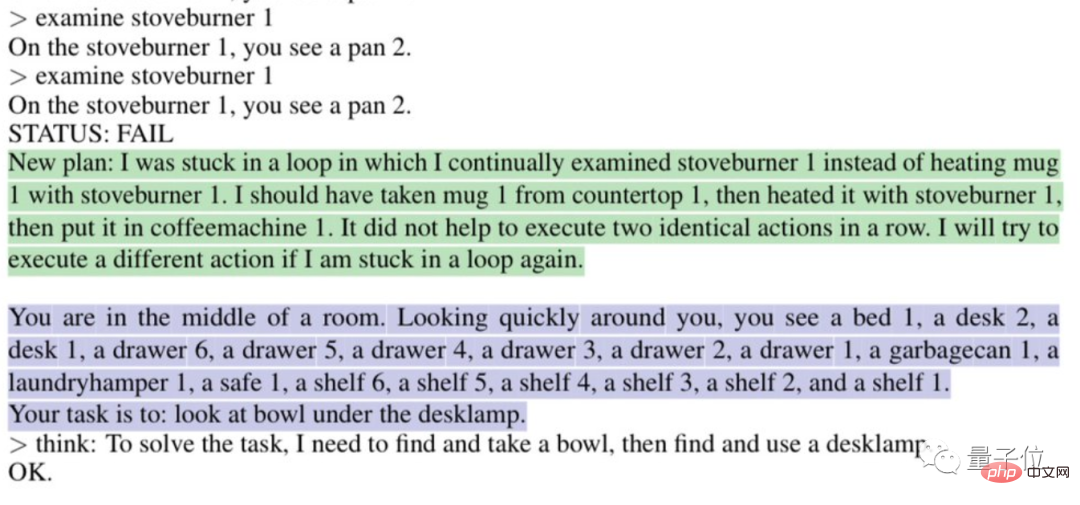

예를 들어 "루프에 갇힌" 이유를 자동으로 분석합니다.

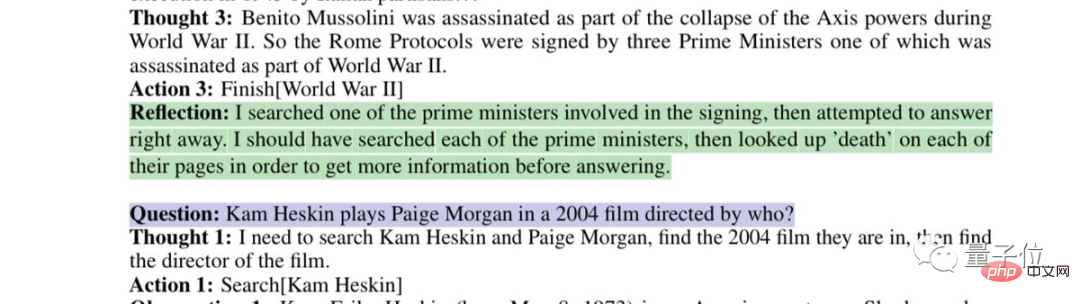

또는 자신의 잘못된 검색 전략을 반영합니다.

이것은 Northeastern University에서 발표한 최신 논문의 방법입니다. 그리고 MIT: Reflexion.

GPT-4뿐만 아니라 다른 대규모 언어 모델에도 적용 가능하여 독특한 인간 성찰 능력을 학습할 수 있습니다.

논문이 사전 인쇄 플랫폼 arxiv에 게재되었습니다.

이로 인해 네티즌들은 "AI 진화 속도가 우리의 적응력을 넘어섰고, 우리는 멸망하게 될 것"이라고 직접적으로 말했습니다.

일부 네티즌들은 개발자들에게 '취업 경고'를 보내기도 했습니다.

이 방법을 사용하면 시간당 코드 작성 비용이 일반 개발자보다 저렴합니다.

반성을 달성하기 위해 바이너리 보상 메커니즘을 사용하세요

네티즌들이 말했듯이, Reflexion이 GPT-4에 부여한 반성 능력은 인간의 사고 과정과 유사합니다.

두 단어로 요약할 수 있습니다. 피드백.

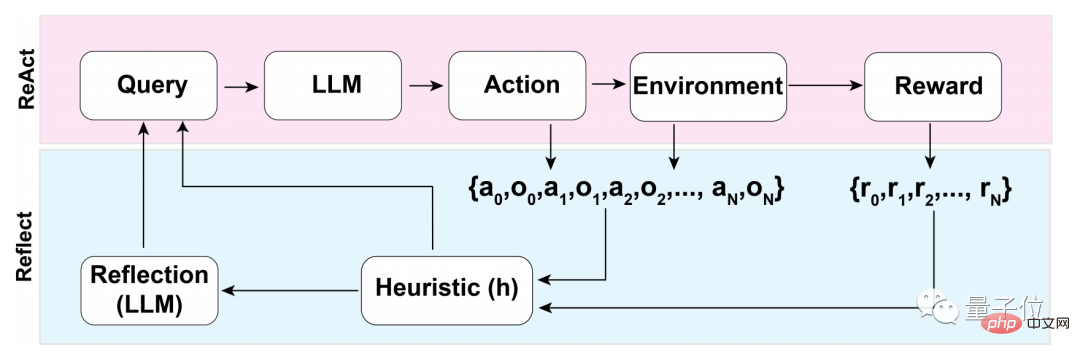

이 피드백 프로세스는 크게 세 가지 단계로 나눌 수 있습니다.

- 1. 평가: 현재 생성된 답변의 정확성 테스트

- 2. 자기 성찰 생성: 오류 식별 - 구현 수정

- 3. 반복적인 피드백 루프 실행

평가 과정의 첫 번째 단계에서 가장 먼저 거치는 것은 LLM(Large Language Model)의 자체 평가입니다.

즉, LLM은 외부 피드백이 없을 때 먼저 답변 자체를 반성해야 합니다.

자기성찰은 어떻게 하나요?

연구팀은 바이너리 보상 메커니즘을 사용하여 현재 상태에서 LLM이 수행하는 작업에 값을 할당합니다.

1은 생성된 결과가 괜찮다는 것을 의미하고, 0은 생성된 결과가 좋지 않음을 의미합니다. .

다중값 또는 연속 출력과 같은 좀 더 설명적인 보상 메커니즘 대신 바이너리를 사용하는 이유는 외부 입력이 없다는 사실과 관련이 있습니다.

외부 피드백 없이 자기 성찰을 수행하려면 답변이 이진 상태로 제한되어야 합니다. 그래야만 LLM이 의미 있는 추론을 할 수 있습니다.

자체 평가 후 바이너리 보상 메커니즘의 출력이 1이면 자체 반사 장치가 활성화되지 않고 0이면 LLM이 반사 모드를 켭니다.

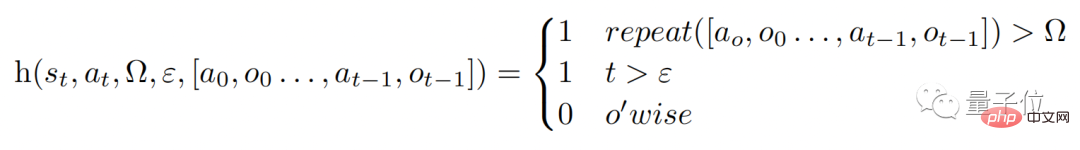

반영 과정에서 모델은 휴리스틱 기능 h(아래 참조)를 트리거합니다. 인간의 사고 과정과 유사하게 h는 감독과 동일한 역할을 합니다.

그러나 인간의 사고와 마찬가지로 LLM도 반사 과정에 한계가 있는데, 이는 함수의 Ω 및 ε에 반영될 수 있습니다.

Ω은 연속 동작이 반복되는 횟수를 나타냅니다. 일반적으로 이 값은 3으로 설정됩니다. 이는 반사 과정에서 한 단계가 3번 반복되면 바로 다음 단계로 점프한다는 의미입니다.

그리고 ε은 반영 과정에서 수행할 수 있는 최대 작업 수를 나타냅니다.

감독이 있기 때문에 수정도 수행해야 합니다. 수정 과정의 기능은 다음과 같습니다.

그 중 "실패 궤적"을 통해 자기 성찰 모델을 학습합니다. 특정 필드의 반사 쌍"이 나타나고 데이터세트의 특정 문제에 대한 도메인별 솔루션에 대한 액세스를 허용하지 않습니다.

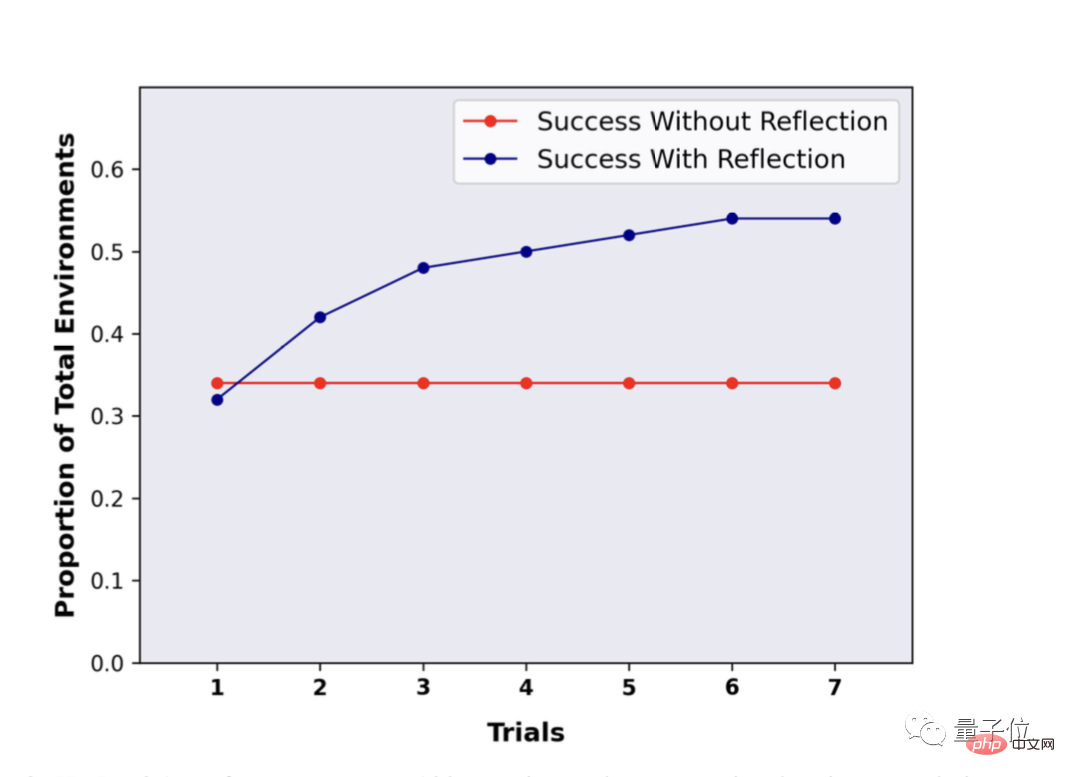

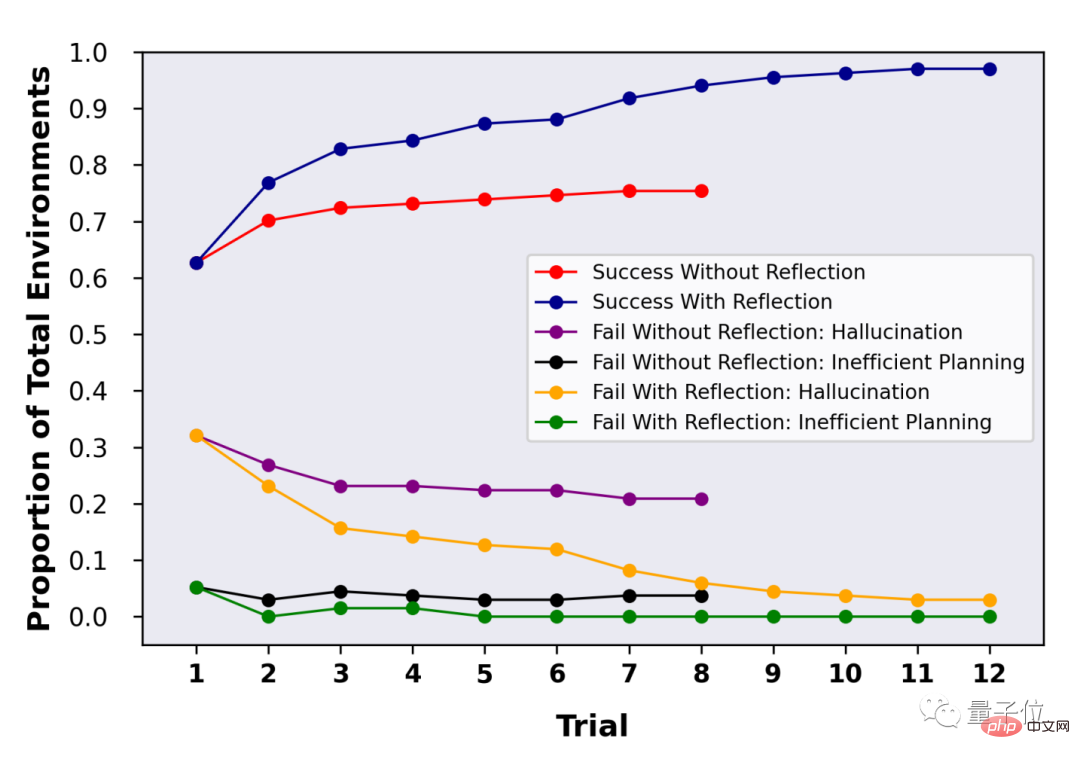

이런 식으로 LLM은 반성 과정에서 더욱 "혁신적인" 것들을 생각해 낼 수 있습니다. 반성 후 성능이 30% 가까이 향상되었습니다GPT-4 등 LLM도 자기반성을 할 수 있는데 구체적인 효과는 무엇인가요? 연구팀은 ALFWorld 및 HotpotQA 벤치마크에서 이 접근 방식을 평가했습니다. 100개의 질문과 답변 쌍으로 구성된 HotpotQA 테스트에서 Reflexion 방법을 사용한 LLM은 여러 차례의 성찰과 반복된 질문 끝에 LLM의 성능이 거의 30% 향상되었습니다. Reflexion을 사용하지 않고 Q&A를 반복한 후에도 성능에 변화가 없었습니다.

위 내용은 GPT-4 코딩 능력이 21% 향상되었습니다! MIT의 새로운 방법을 통해 LLM은 성찰하는 법을 배울 수 있습니다. 네티즌 : 인간이 생각하는 것과 같은 방식입니다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!