Golang을 사용하여 Bing 배경화면을 크롤링하는 방법에 대한 자세한 설명

- 青灯夜游앞으로

- 2023-02-20 19:38:283197검색

말할 필요도 없이 Python을 사용하여 크롤러를 만들면 요청 하나로 세상을 해결할 수 있습니다. 하지만 golang에 내장된 http 패키지가 매우 강력하다고 들었습니다. 별다른 작업을 하지 않아도 새로운 것을 배우고 관련 지식 포인트를 복습하고 싶을 뿐입니다. http 프로토콜의 요청과 응답. 더 이상 고민하지 말고 바로 본론으로 들어가겠습니다requests包走天下。但是呢,听说golang中内置的http包非常牛逼,咱就是说不得整点活,也刚好学习学习新东西,复习下http协议的请求和响应相关的知识点。话不多说,咱直接开整

本文章爬下必应壁纸先小试牛刀。狗头保命 狗头保命 狗头保命

爬虫流程概述

graph TD 请求数据 --> 解析数据 --> 数据入库

上图的流程图大家可以看到,其实爬虫并不麻烦,整个流程就只有三步而已。接下来具体聊聊每一步需要做什么

请求数据:在这里我们需要使用golang中的内置包http包向目标地址发起请求,这一步就完成了

解析数据:这里我们需要对请求到的数据进行解析,因为不是整个请求到的数据我们都需要,我们只需要某些具体的关键的数据而已。这一步也叫数据清洗

数据入库:不难理解,这就是将解析好的数据进行入库操作

实战分析

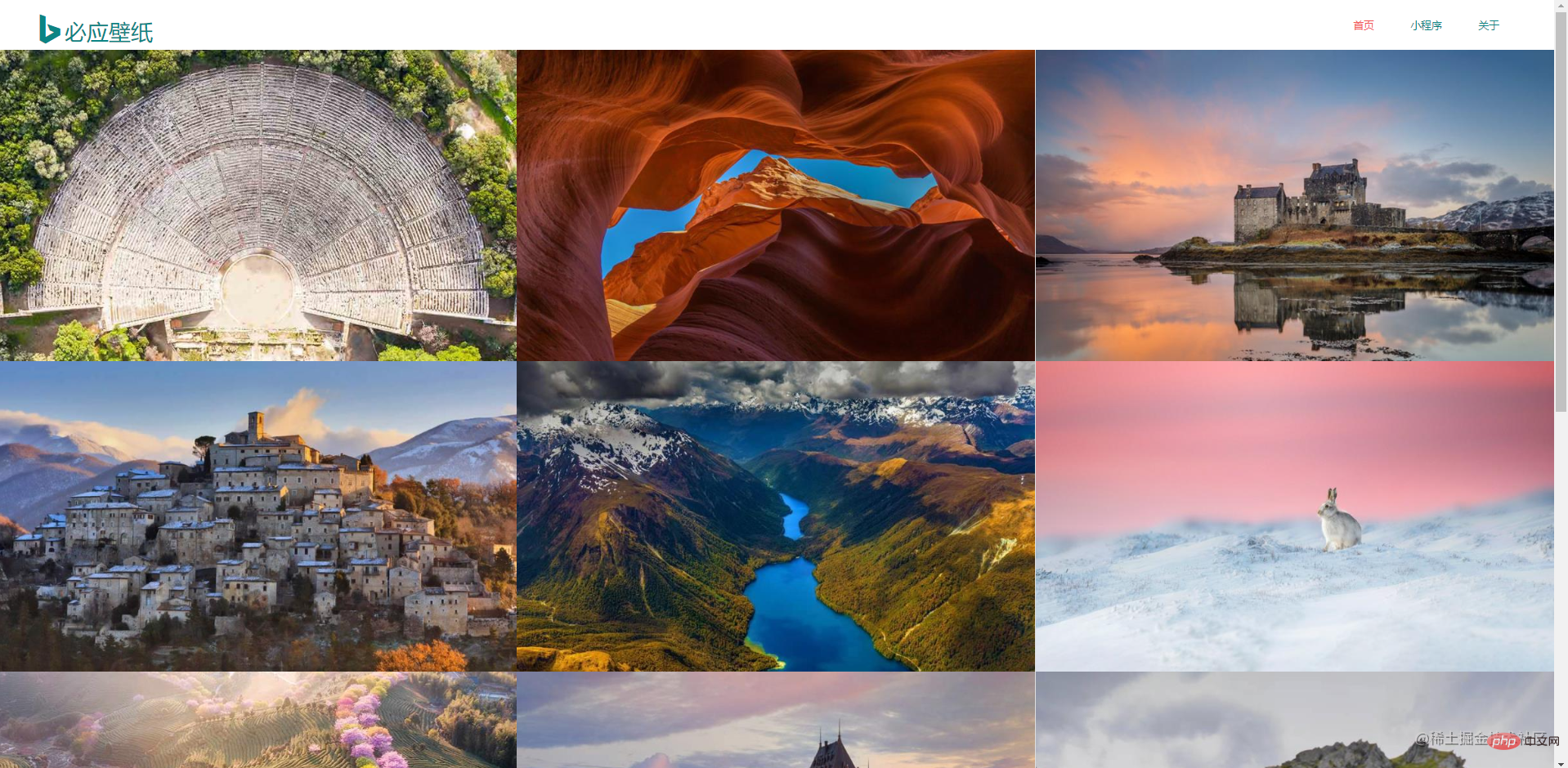

先到必应壁纸官网上观察,做爬虫的话是需要对数据特别敏感的。这是首页信息,整个页面是非常简洁的

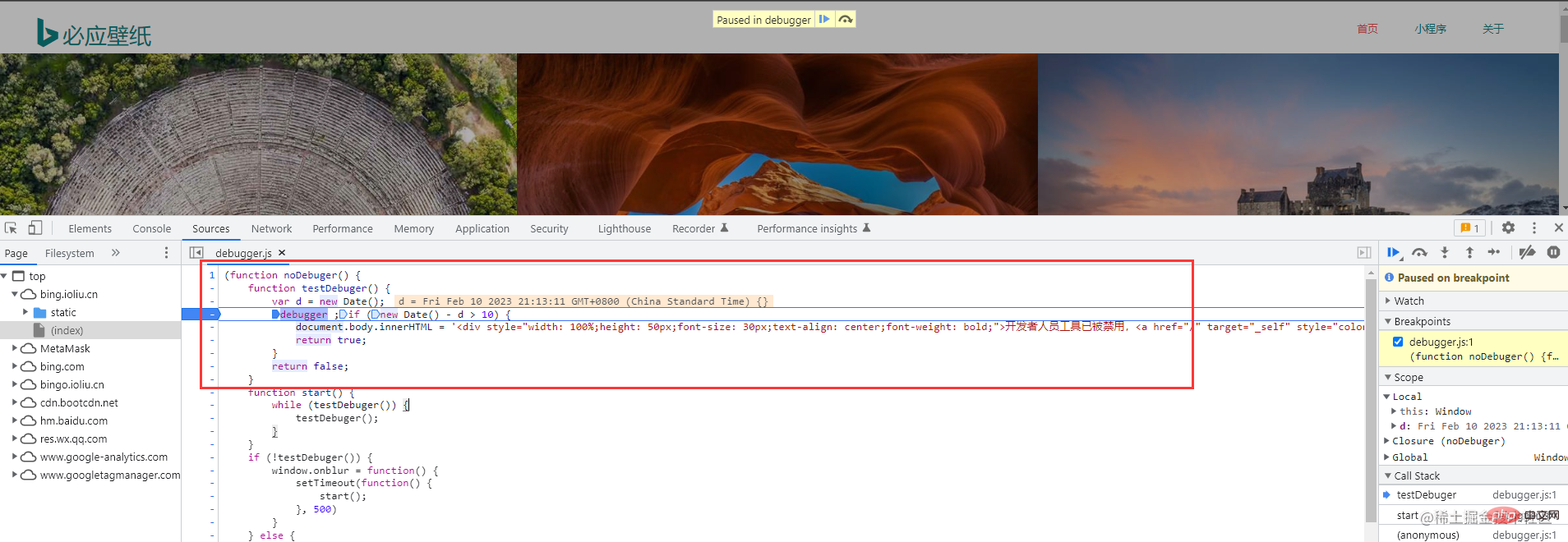

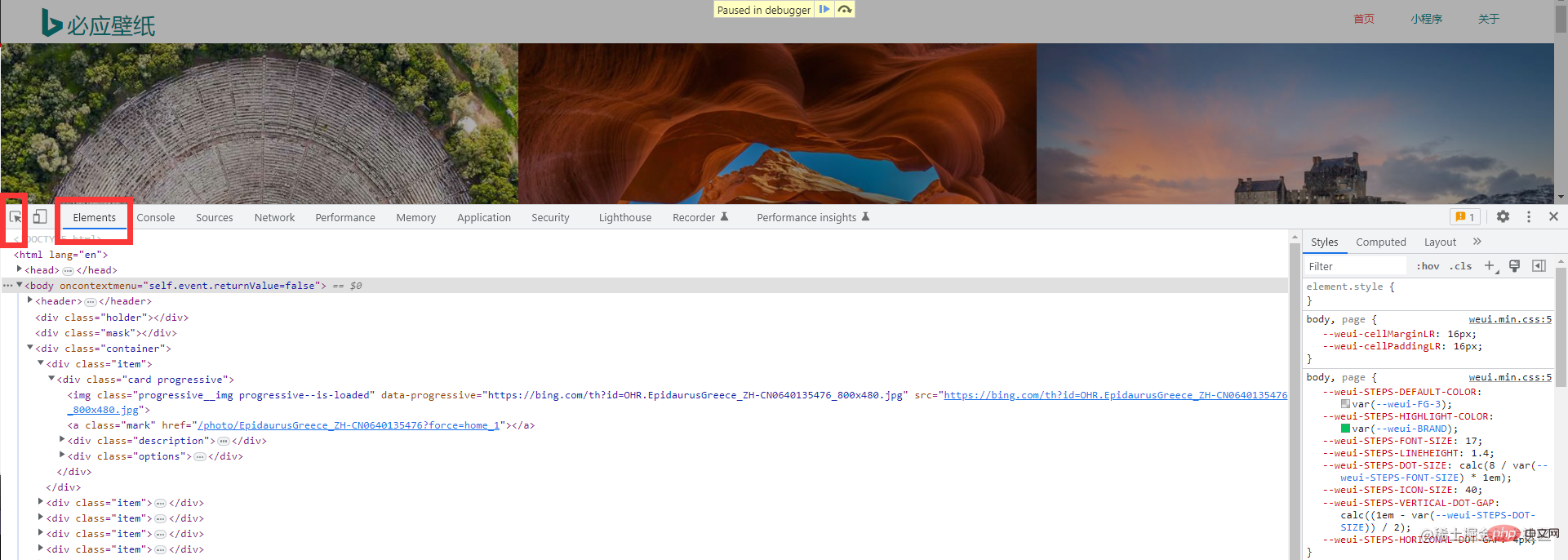

接下来,需要调出浏览器的开发者工具(这个大家应该都非常熟悉吧,不熟悉的话很难跟下去的喔)。直接按下F12

크롤러 프로세스 개요이 기사를 아래로 내려가세요Bing Wallpaper

먼저 사용해 보겠습니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다.

package main

import (

"fmt"

"github.com/PuerkitoBio/goquery"

"io"

"io/ioutil"

"log"

"net/http"

"os"

"time"

)

func Run(method, url string, body io.Reader, client *http.Client) {

req, err := http.NewRequest(method, url, body)

if err != nil {

log.Println("获取请求对象失败")

return

}

req.Header.Set("user-agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36")

resp, err := client.Do(req)

if err != nil {

log.Println("发起请求失败")

return

}

if resp.StatusCode != http.StatusOK {

log.Printf("请求失败,状态码:%d", resp.StatusCode)

return

}

defer resp.Body.Close() // 关闭响应对象中的body

query, err := goquery.NewDocumentFromReader(resp.Body)

if err != nil {

log.Println("生成goQuery对象失败")

return

}

query.Find(".container .item").Each(func(i int, s *goquery.Selection) {

imgUrl, _ := s.Find("a.ctrl.download").Attr("href")

imgName := s.Find(".description>h3").Text()

fmt.Println(imgUrl)

fmt.Println(imgName)

DownloadImage(imgUrl, i, client)

time.Sleep(time.Second)

fmt.Println("-------------------------")

})

}

func DownloadImage(url string, index int, client *http.Client) {

req, err := http.NewRequest("POST", url, nil)

if err != nil {

log.Println("获取请求对象失败")

return

}

req.Header.Set("user-agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36")

resp, err := client.Do(req)

if err != nil {

log.Println("发起请求失败")

return

}

data, err := ioutil.ReadAll(resp.Body)

if err != nil {

log.Println("读取请求体失败")

return

}

baseDir := "./image/image-%d.jpg"

f, err := os.OpenFile(fmt.Sprintf(baseDir, index), os.O_CREATE|os.O_TRUNC|os.O_WRONLY, 0666)

if err != nil {

log.Println("打开文件失败", err.Error())

return

}

defer f.Close()

_, err = f.Write(data)

if err != nil {

log.Println("写入数据失败")

return

}

fmt.Println("下载图片成功")

}

func main() {

client := &http.Client{}

url := "https://bing.ioliu.cn/?p=%d"

method := "GET"

Run(method, url, nil, client)

}위의 흐름도에서 볼 수 있듯이 크롤러는 실제로 그렇지 않습니다. 번거롭습니다. 전체 프로세스에는 세 단계만 있습니다. 다음으로 각 단계에서 수행해야 할 작업에 대해 이야기하겠습니다

데이터 요청: 여기서는 golang에 내장된 http 패키지를 사용하여 시작해야 합니다. 대상 주소에 대한 요청이 한 단계로 완료

데이터 요청: 여기서는 golang에 내장된 http 패키지를 사용하여 시작해야 합니다. 대상 주소에 대한 요청이 한 단계로 완료

데이터 구문 분석: 요청한 데이터 전체가 필요하지 않고 특정 핵심 데이터만 필요하기 때문에 여기서는 요청된 데이터를 구문 분석해야 합니다. 이 단계는 데이터 정리라고도 합니다

데이터 저장: 이해하기 어렵지 않습니다. 이는 구문 분석된 데이터를 데이터베이스에 저장하는 것입니다

실용 분석

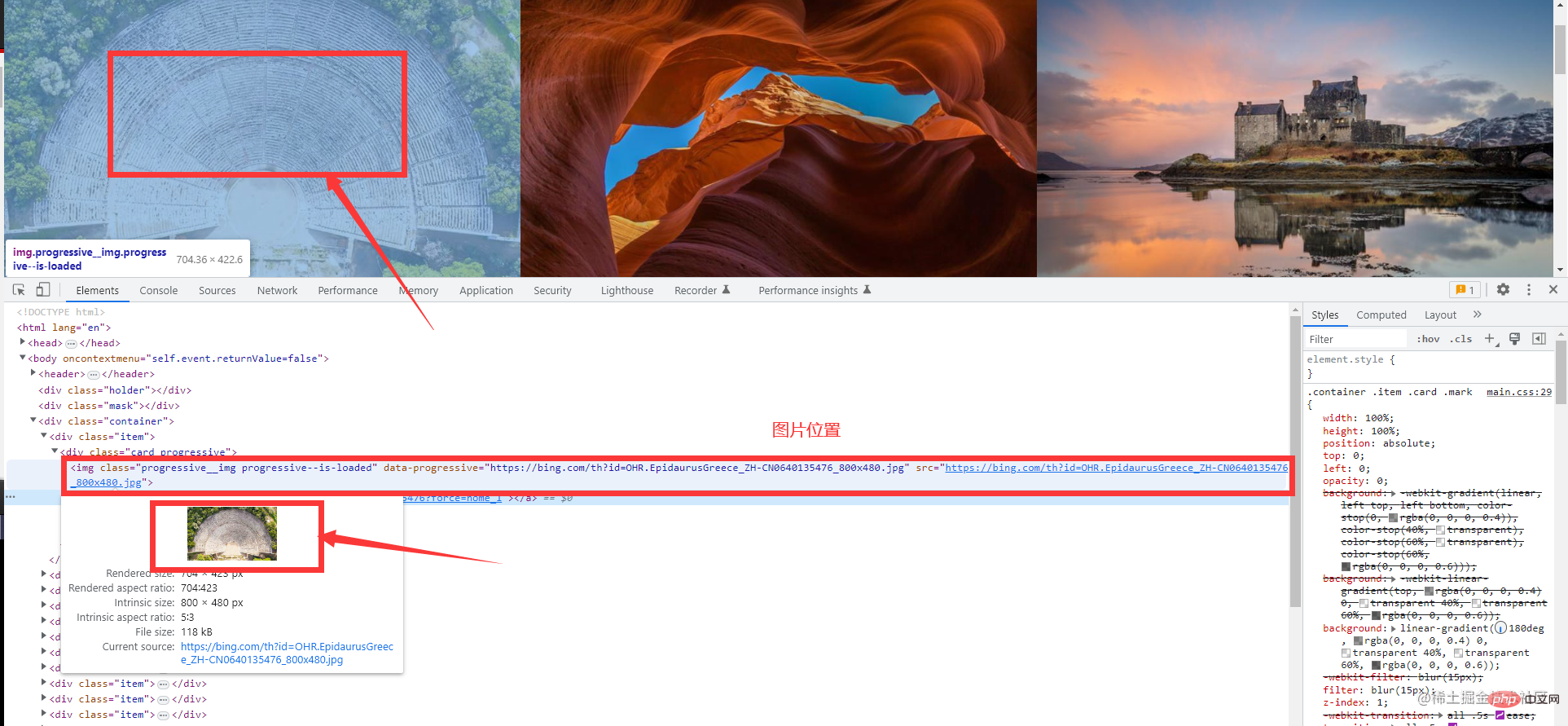

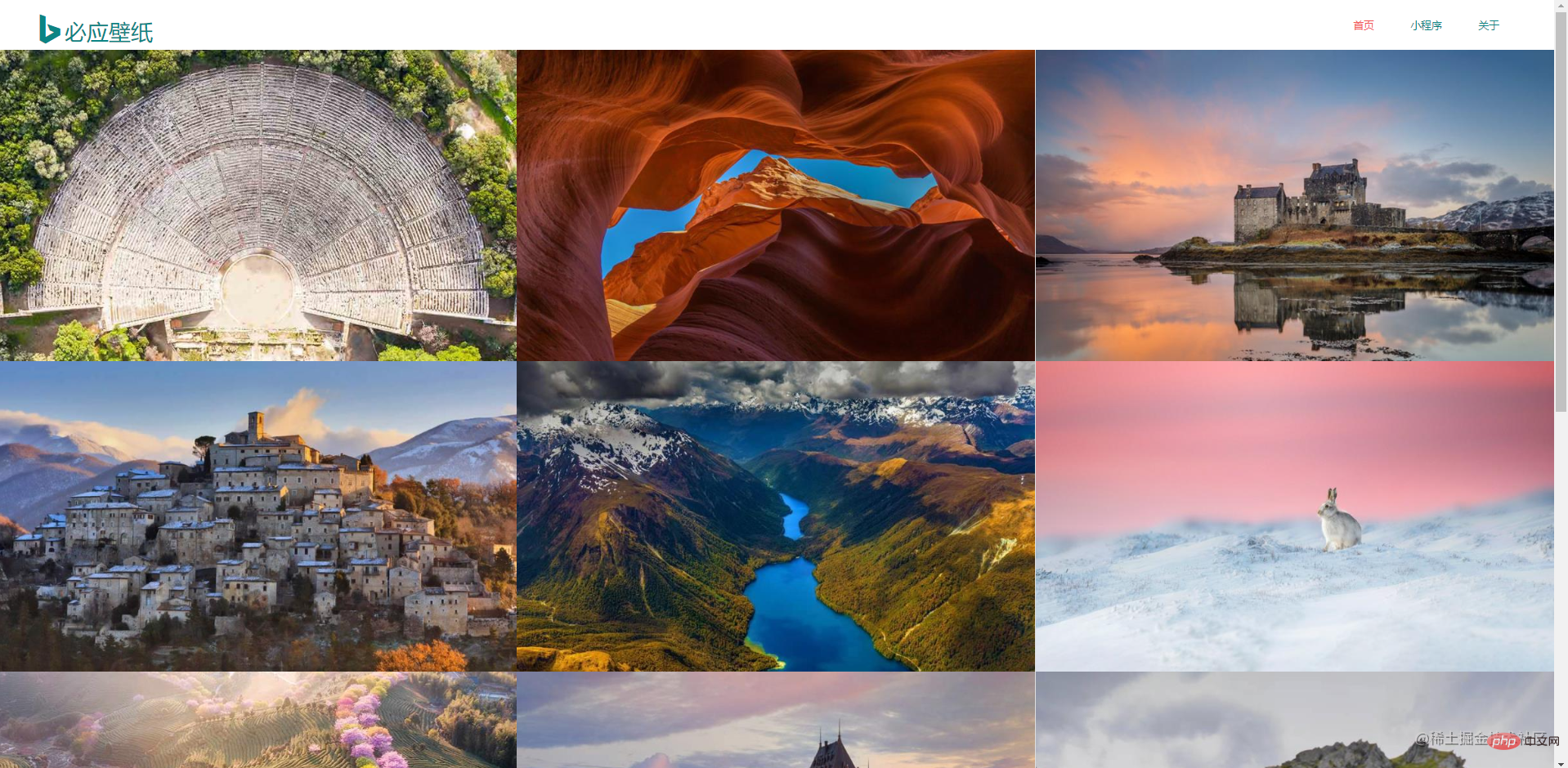

먼저 Bing Wallpaper 공식 웹사이트로 이동하여 관찰하고 크롤러를 수행합니다. 그렇다면 데이터에 특히 민감해야 합니다. 홈페이지 정보가 매우 간결합니다.

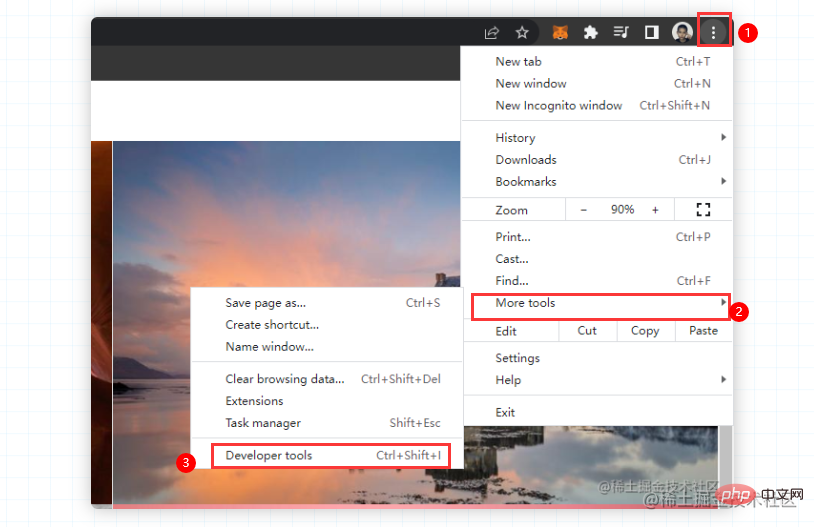

F12를 누르거나 마우스 오른쪽 버튼을 클릭하여 확인하세요. 하지만 어쩌죠? Bing 배경 화면에서는 마우스 오른쪽 버튼을 클릭해도 콘솔을 호출할 수 없으며 수동으로만 호출할 수 있습니다. 걱정하지 마시고 첫 번째 사진을 따라가시면 됩니다. 같은 반 친구의 크롬이 중국어로 되어 있으면 도구를 더 선택하고 개발자 도구를 선택하면 동일한 작업이 수행됩니다. 벽지 웹사이트의 크롤링 오류. (오래전에 크롤링할 때는 이러한 크롤링 방지 오류가 발생하지 않았습니다.) 이는 작업에 영향을 미치지 않습니다 다음으로, 원하는 요소를 빠르게 찾는 데 도움이 되는 이 도구를 선택하세요 그러면 필요한 것을 찾을 수 있습니다. 정보

// 爬取多页的main函数如下

func main() {

client := &http.Client{}

url := "https://bing.ioliu.cn/?p=%d"

method := "GET"

for i := 1; i < 5; i++ { // 实现分页操作

Run(method, fmt.Sprintf(url, i), nil, client)

}

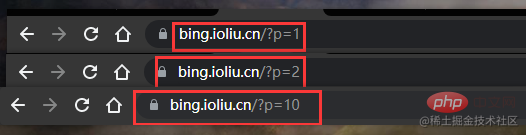

}찾은 것이 있나요? 첫 번째 페이지 p=1, 두 번째 페이지 p=2, 열 번째 페이지 p=10

🎜그러므로 for 루프를 시작한 다음 이전에 단일 페이지를 크롤링했던 코드를 재사용합니다🎜rrreee🎜🎜요약🎜🎜🎜 이 예에서는 정규식을 사용하는 것이 너무 번거롭기 때문에 타사 도구 패키지를 사용하여 웹 페이지 데이터를 구문 분석합니다. 🎜🎜🎜css 선택기 사용: 🎜goQuery🎜🎜🎜xpath 선택기 사용: 🎜htmlquery🎜🎜 🎜regular : 내장 패키지, 권장하지 않음, 일반 규칙 작성이 어려움🎜🎜🎜추천 학습:🎜Golang 튜토리얼🎜🎜위 내용은 Golang을 사용하여 Bing 배경화면을 크롤링하는 방법에 대한 자세한 설명의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

이 기사를 아래로 내려가세요

이 기사를 아래로 내려가세요 먼저 사용해 보겠습니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다.

먼저 사용해 보겠습니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다. 개 머리가 생명을 구합니다.