소개

국내 쇼핑사이트에 비해 아마존 홈페이지는 파이썬의 가장 기본적인 요청을 직접 활용하여 요청을 할 수 있습니다. 액세스가 너무 빈번하지 않으며 보호 메커니즘을 트리거하지 않고도 원하는 데이터를 얻을 수 있습니다. 이번에는 다음 세 부분을 통해 기본 크롤링 프로세스를 간략하게 소개하겠습니다.

요청의 get 요청을 사용하여 Amazon 목록 및 세부 정보 페이지의 페이지 콘텐츠를 가져옵니다.

css/xpath를 사용하여 콘텐츠 획득 및 핵심 데이터 획득

동적 IP의 역할 및 사용 방법

1. Amazon 목록 페이지 정보 가져오기

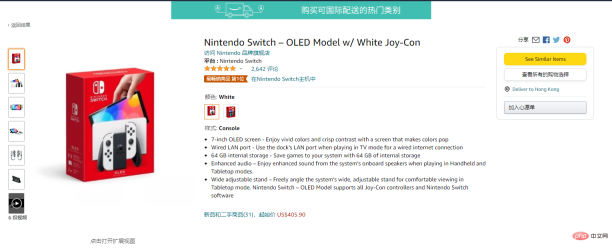

게임 영역을 예로 들어보세요:

제품 이름, 세부 정보 링크, 기타 콘텐츠에 대한 추가 액세스 등 목록에서 얻을 수 있는 제품 정보를 가져옵니다.

requests.get()을 사용하여 웹 콘텐츠를 가져오고, 헤더를 설정하고, xpath 선택기를 사용하여 관련 태그의 콘텐츠를 선택하세요.

import requests

from parsel import Selector

from urllib.parse import urljoin

spiderurl = 'https://www.amazon.com/s?i=videogames-intl-ship'

headers = {

"authority": "www.amazon.com",

"user-agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 10_3_3 like Mac OS X) AppleWebKit/603.3.8 (KHTML, like Gecko) Mobile/14G60 MicroMessenger/6.5.19 NetType/4G Language/zh_TW",

}

resp = requests.get(spiderurl, headers=headers)

content = resp.content.decode('utf-8')

select = Selector(text=content)

nodes = select.xpath("//a[@title='product-detail']")

for node in nodes:

itemUrl = node.xpath("./@href").extract_first()

itemName = node.xpath("./div/h2/span/text()").extract_first()

if itemUrl and itemName:

itemUrl = urljoin(spiderurl,itemUrl)#用urljoin方法凑完整链接

print(itemUrl,itemName)현재 목록 페이지에서 현재 사용할 수 있는 정보는 여기에서 얻었습니다. 시간:

II, 세부정보 페이지 정보 가져오기

세부정보 페이지 입력:

세부정보 페이지에 들어간 후 더 많은 콘텐츠를 얻을 수 있습니다.

requests.get()을 사용하여 웹을 가져옵니다. content를 클릭하고 CSS를 사용하여 관련 태그의 콘텐츠를 선택합니다.

res = requests.get(itemUrl, headers=headers)

content = res.content.decode('utf-8')

Select = Selector(text=content)

itemPic = Select.css('#main-image::attr(src)').extract_first()

itemPrice = Select.css('.a-offscreen::text').extract_first()

itemInfo = Select.css('#feature-bullets').extract_first()

data = {}

data['itemUrl'] = itemUrl

data['itemName'] = itemName

data['itemPic'] = itemPic

data['itemPrice'] = itemPrice

data['itemInfo'] = itemInfo

print(data)이때 세부 페이지 데이터의 정보가 생성되었습니다.

현재 관련된 내용은 Amazon 및 해당 정보를 얻으려면 CSS/xpath를 사용하십시오.

3. 프록시 설정

현재 국내 아마존 접속이 매우 불안정하여 접속이 안될 확률이 높습니다. 정말로 Amazon의 정보를 크롤링해야 한다면 안정적인 프록시를 사용하는 것이 가장 좋습니다. 여기서는 5억 개의 트래픽을 무료로 얻을 수 있는 ipidia의 프록시를 사용합니다. 프록시가 있으면 접속 성공률이 높아지고 속도도 빨라집니다.

웹사이트는 여기입니다: http://www.ipidea.net/?utm-source=PHP&utm-keyword=?PHP

프록시를 사용하는 방법에는 두 가지가 있습니다. 하나는 프록시를 통해 IP 주소를 얻는 것입니다. api를 사용하고 다른 하나는 계정 비밀번호를 사용하는 것입니다. 다음과 같은 방법을 사용하십시오.

3.1.1 api를 사용하여 에이전트를 얻습니다.

3.2.1 에이전트 획득을 위한 계정 비밀번호(등록 주소: http://www.ipidea.net/?utm-source=PHP&utm-keyword=?PHP )

)

계정 및 비밀번호 인증이기 때문에, 하위 계정을 만들려면 계정 센터에 가서 정보를 입력해야 합니다.

계정 및 비밀번호 인증이기 때문에, 하위 계정을 만들려면 계정 센터에 가서 정보를 입력해야 합니다.

하위 계정을 만든 후 계정 번호와 비밀번호를 기반으로 링크를 얻습니다. 3.2. 2 계정 비밀번호에 대한 에이전트 코드 얻기

def getProxies():

# 获取且仅获取一个ip

api_url = '生成的api链接'

res = requests.get(api_url, timeout=5)

try:

if res.status_code == 200:

api_data = res.json()['data'][0]

proxies = {

'http': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

'https': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

}

print(proxies)

return proxies

else:

print('获取失败')

except:

print('获取失败')에이전트 사용 후 Amazon 제품 정보 획득이 많이 개선되었습니다. 이전 코드에서는 요청 요청 전에 프록시 획득 방법을 호출하여 다양한 연결 오류를 보고했습니다. 이 메서드는 프록시 IP를 반환하고 요청 요청 매개변수를 추가하여 프록시 요청을 구현합니다. 通过上面的步骤,可以实现最基础的亚马逊的信息获取。 目前只获得最基本的数据,若想获得更多也可以自行修改xpath/css选择器去拿到你想要的内容。而且稳定的动态IP能是你进行请求的时候少一点等待的时间,无论是编写中的测试还是小批量的爬取,都能提升工作的效率。以上就是全部的内容。 四、全部代码

# coding=utf-8

import requests

from parsel import Selector

from urllib.parse import urljoin

def getProxies():

# 获取且仅获取一个ip

api_url = '生成的api链接'

res = requests.get(api_url, timeout=5)

try:

if res.status_code == 200:

api_data = res.json()['data'][0]

proxies = {

'http': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

'https': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

}

print(proxies)

return proxies

else:

print('获取失败')

except:

print('获取失败')

spiderurl = 'https://www.amazon.com/s?i=videogames-intl-ship'

headers = {

"authority": "www.amazon.com",

"user-agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 10_3_3 like Mac OS X) AppleWebKit/603.3.8 (KHTML, like Gecko) Mobile/14G60 MicroMessenger/6.5.19 NetType/4G Language/zh_TW",

}

proxies = getProxies()

resp = requests.get(spiderurl, headers=headers, proxies=proxies)

content = resp.content.decode('utf-8')

select = Selector(text=content)

nodes = select.xpath("//a[@title='product-detail']")

for node in nodes:

itemUrl = node.xpath("./@href").extract_first()

itemName = node.xpath("./div/h2/span/text()").extract_first()

if itemUrl and itemName:

itemUrl = urljoin(spiderurl,itemUrl)

proxies = getProxies()

res = requests.get(itemUrl, headers=headers, proxies=proxies)

content = res.content.decode('utf-8')

Select = Selector(text=content)

itemPic = Select.css('#main-image::attr(src)').extract_first()

itemPrice = Select.css('.a-offscreen::text').extract_first()

itemInfo = Select.css('#feature-bullets').extract_first()

data = {}

data['itemUrl'] = itemUrl

data['itemName'] = itemName

data['itemPic'] = itemPic

data['itemPrice'] = itemPrice

data['itemInfo'] = itemInfo

print(data)

위 내용은 Python을 사용하여 Amazon 제품 정보 얻기의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

파이썬의 주요 목적 : 유연성과 사용 편의성Apr 17, 2025 am 12:14 AM

파이썬의 주요 목적 : 유연성과 사용 편의성Apr 17, 2025 am 12:14 AMPython의 유연성은 다중 파리가 지원 및 동적 유형 시스템에 반영되며, 사용 편의성은 간단한 구문 및 풍부한 표준 라이브러리에서 나옵니다. 유연성 : 객체 지향, 기능 및 절차 프로그래밍을 지원하며 동적 유형 시스템은 개발 효율성을 향상시킵니다. 2. 사용 편의성 : 문법은 자연 언어에 가깝고 표준 라이브러리는 광범위한 기능을 다루며 개발 프로세스를 단순화합니다.

파이썬 : 다목적 프로그래밍의 힘Apr 17, 2025 am 12:09 AM

파이썬 : 다목적 프로그래밍의 힘Apr 17, 2025 am 12:09 AMPython은 초보자부터 고급 개발자에 이르기까지 모든 요구에 적합한 단순성과 힘에 호의적입니다. 다목적 성은 다음과 같이 반영됩니다. 1) 배우고 사용하기 쉽고 간단한 구문; 2) Numpy, Pandas 등과 같은 풍부한 라이브러리 및 프레임 워크; 3) 다양한 운영 체제에서 실행할 수있는 크로스 플랫폼 지원; 4) 작업 효율성을 향상시키기위한 스크립팅 및 자동화 작업에 적합합니다.

하루 2 시간 안에 파이썬 학습 : 실용 가이드Apr 17, 2025 am 12:05 AM

하루 2 시간 안에 파이썬 학습 : 실용 가이드Apr 17, 2025 am 12:05 AM예, 하루에 2 시간 후에 파이썬을 배우십시오. 1. 합리적인 학습 계획 개발, 2. 올바른 학습 자원을 선택하십시오. 3. 실습을 통해 학습 된 지식을 통합하십시오. 이 단계는 짧은 시간 안에 Python을 마스터하는 데 도움이 될 수 있습니다.

Python vs. C : 개발자를위한 장단점Apr 17, 2025 am 12:04 AM

Python vs. C : 개발자를위한 장단점Apr 17, 2025 am 12:04 AMPython은 빠른 개발 및 데이터 처리에 적합한 반면 C는 고성능 및 기본 제어에 적합합니다. 1) Python은 간결한 구문과 함께 사용하기 쉽고 데이터 과학 및 웹 개발에 적합합니다. 2) C는 고성능과 정확한 제어를 가지고 있으며 게임 및 시스템 프로그래밍에 종종 사용됩니다.

파이썬 : 시간 약속과 학습 속도Apr 17, 2025 am 12:03 AM

파이썬 : 시간 약속과 학습 속도Apr 17, 2025 am 12:03 AMPython을 배우는 데 필요한 시간은 개인마다 다릅니다. 주로 이전 프로그래밍 경험, 학습 동기 부여, 학습 리소스 및 방법 및 학습 리듬의 영향을받습니다. 실질적인 학습 목표를 설정하고 실용적인 프로젝트를 통해 최선을 다하십시오.

파이썬 : 자동화, 스크립팅 및 작업 관리Apr 16, 2025 am 12:14 AM

파이썬 : 자동화, 스크립팅 및 작업 관리Apr 16, 2025 am 12:14 AM파이썬은 자동화, 스크립팅 및 작업 관리가 탁월합니다. 1) 자동화 : 파일 백업은 OS 및 Shutil과 같은 표준 라이브러리를 통해 실현됩니다. 2) 스크립트 쓰기 : PSUTIL 라이브러리를 사용하여 시스템 리소스를 모니터링합니다. 3) 작업 관리 : 일정 라이브러리를 사용하여 작업을 예약하십시오. Python의 사용 편의성과 풍부한 라이브러리 지원으로 인해 이러한 영역에서 선호하는 도구가됩니다.

파이썬과 시간 : 공부 시간을 최대한 활용Apr 14, 2025 am 12:02 AM

파이썬과 시간 : 공부 시간을 최대한 활용Apr 14, 2025 am 12:02 AM제한된 시간에 Python 학습 효율을 극대화하려면 Python의 DateTime, Time 및 Schedule 모듈을 사용할 수 있습니다. 1. DateTime 모듈은 학습 시간을 기록하고 계획하는 데 사용됩니다. 2. 시간 모듈은 학습과 휴식 시간을 설정하는 데 도움이됩니다. 3. 일정 모듈은 주간 학습 작업을 자동으로 배열합니다.

파이썬 : 게임, Guis 등Apr 13, 2025 am 12:14 AM

파이썬 : 게임, Guis 등Apr 13, 2025 am 12:14 AMPython은 게임 및 GUI 개발에서 탁월합니다. 1) 게임 개발은 Pygame을 사용하여 드로잉, 오디오 및 기타 기능을 제공하며 2D 게임을 만드는 데 적합합니다. 2) GUI 개발은 Tkinter 또는 PYQT를 선택할 수 있습니다. Tkinter는 간단하고 사용하기 쉽고 PYQT는 풍부한 기능을 가지고 있으며 전문 개발에 적합합니다.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경