워드2벡터 원리

- (*-*)浩원래의

- 2020-01-10 10:54:573467검색

단어를 새로운 공간에 매핑하여 다차원 연속 실수 벡터로 표현하는 것을 "단어 표현" 또는 "단어 임베딩"이라고 합니다.

21세기 이후 사람들은 단어 벡터의 원래 희소 표현에서 저차원 공간의 현재 밀집 표현으로 점차 전환했습니다.

실용적인 문제를 해결하기 위해 희소 표현을 사용하면 차원의 저주에 직면하는 경우가 많아 의미 정보를 표현할 수 없고 단어 간의 잠재적인 연결을 밝힐 수 없습니다.

저차원 공간 표현의 사용은 차원 재해 문제를 해결할 뿐만 아니라 단어 간의 연관된 속성을 탐색하여 벡터 의미의 정확성을 향상시킵니다.

word2vec 학습 과제

다음과 같은 문장이 있다고 가정해 보겠습니다. 오늘 오후 2시에 검색 엔진 그룹에서 그룹 회의가 열립니다.

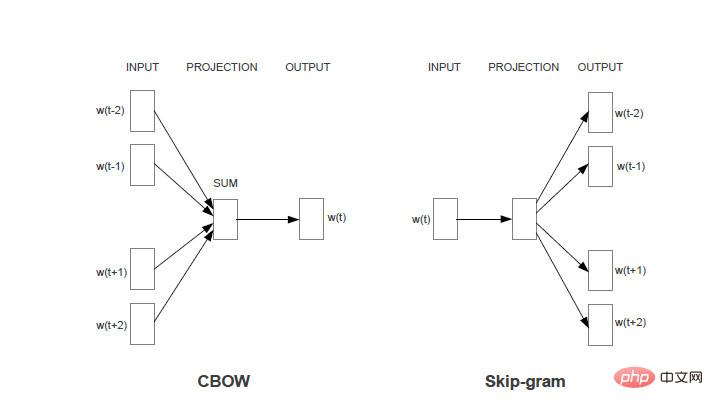

과제 1: 각 단어에 대해 단어 주변의 단어를 사용하여 현재 단어가 생성될 확률을 예측합니다. 예를 들어 "오늘, 오후, 검색, 엔진, 그룹"을 사용하면 "2시"가 생성됩니다.

과제 2: 각 단어에 대해 단어 자체를 사용하여 다른 단어가 생성될 확률을 예측합니다. 예를 들어, "2시"를 사용하여 "오늘, 오후, 검색, 엔진, 그룹"의 각 단어를 생성합니다.

두 작업의 공통 제한 사항은 다음과 같습니다. 동일한 입력에 대해 각 단어가 출력될 확률의 합은 1입니다.

Word2vec 모델은 기계 학습을 통해 위 작업의 정확성을 향상시키는 방법입니다. 두 가지 작업은 각각 두 가지 모델(CBOW 및 skim-gram)에 해당합니다. 특별한 지시가 없는 경우에는 태스크 1에 해당하는 모델인 CBOW를 사용하여 아래 분석을 진행합니다.

스킴그램 모델 분석 방법은 동일합니다.

더 많은 Word 관련 기술 기사를 보려면 Word Tutorial 열을 방문하여 알아보세요!

위 내용은 워드2벡터 원리의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!