Spark에서 Python을 실행할 수 있나요?

- 藏色散人원래의

- 2019-08-06 11:53:503394검색

Spark에서 Python을 실행할 수 있나요?

spark는 Python 프로그램을 실행할 수 있습니다. Python으로 작성된 알고리즘이나 sklearn과 같은 확장 라이브러리를 Spark에서 실행할 수 있습니다. 대부분의 알고리즘에 사용 가능한 Spark의 mllib를 직접 사용하는 것도 가능합니다.

Spark는 SQL 쿼리, 텍스트 처리, 기계 학습 등을 포함한 다양한 작업을 완료하는 데 사용할 수 있는 범용 엔진입니다.

이 실험은 Spark 환경의 Linux에서 실행되었습니다. Spark 버전은 1.6.1이며 이는 Spark에서 로컬로 실행하는 것과 같습니다. Spark 파일은 /opt/moudles/spark-1.6.1/에 있습니다. 코드는 참조)

파이썬 테스트 프로그램 작성

#test.py文件

# -*- coding:utf-8 -*-

import os

import sys

#配置环境变量并导入pyspark

os.environ['SPARK_HOME'] = r'/opt/moudles/spark-1.6.1'

sys.path.append("/opt/moudles/spark-1.6.1/python")

sys.path.append("/opt/moudles/spark-1.6.1/python/lib/py4j-0.9-src.zip")

from pyspark import SparkContext, SparkConf

appName ="spark_1" #应用程序名称

master= "spark://hadoop01:7077"#hadoop01为主节点hostname,请换成自己的主节点主机名称

conf = SparkConf().setAppName(appName).setMaster(master)

sc = SparkContext(conf=conf)

data = [1, 2, 3, 4, 5]

distData = sc.parallelize(data)

res = distData.reduce(lambda a, b: a + b)

print("===========================================")

print (res)

print("===========================================")파이썬 프로그램 실행

다음 명령 실행

python test.py

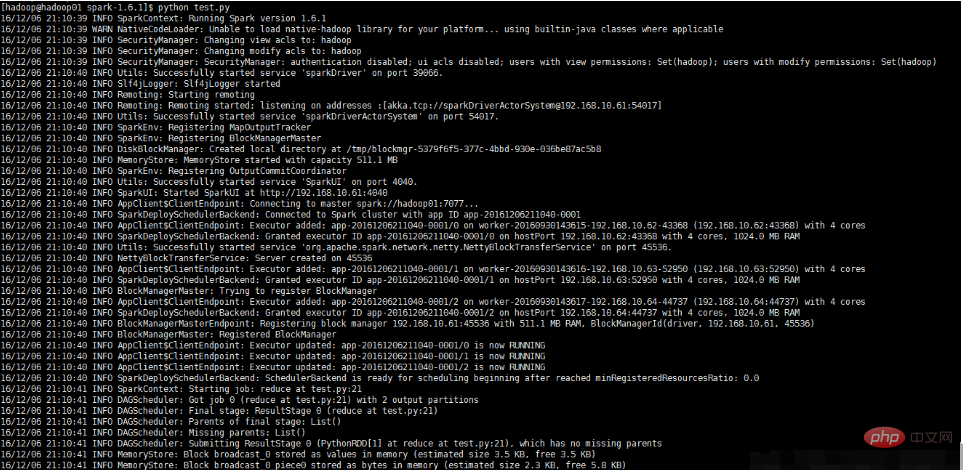

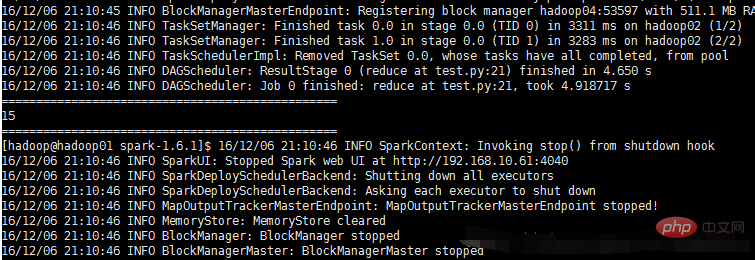

실행 및 결과는 아래 그림과 같습니다.

위 내용은 Spark에서 Python을 실행할 수 있나요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

성명:

본 글의 내용은 네티즌들의 자발적인 기여로 작성되었으며, 저작권은 원저작자에게 있습니다. 본 사이트는 이에 상응하는 법적 책임을 지지 않습니다. 표절이나 침해가 의심되는 콘텐츠를 발견한 경우 admin@php.cn으로 문의하세요.

이전 기사:한 기사로 Python의 자기 이해하기다음 기사:한 기사로 Python의 자기 이해하기