파이썬 크롤러는 무엇을 의미합니까?

- silencement원래의

- 2019-05-14 17:29:0551540검색

Python 크롤러는 웹 스파이더 및 웹 로봇으로도 알려진 Python 웹 크롤러를 말하며, 특정 규칙에 따라 월드 와이드 웹 정보를 자동으로 캡처하는 프로그램 또는 스크립트입니다. 개미, 자동 인덱서, 에뮬레이터 또는 웜이 포함됩니다.

간단히 말하면, 인터넷은 사이트와 네트워크 장치로 구성된 대규모 네트워크이며, 우리는 브라우저를 통해 사이트에 접속합니다. 사이트 HTML, JS 및 CSS 코드는 브라우저에 의해 구문 분석되고 렌더링되며 다채로운 웹 페이지가 우리에게 표시됩니다. 🎜#인터넷을 대형 스파이더 웹에 비유하면 데이터가 저장됩니다. 파이썬 크롤러는 작은 거미이며,

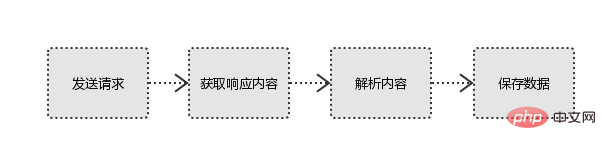

네트워크를 따라 먹이를 크롤링합니다. (데이터) 크롤러는 웹사이트에 요청을 시작하고, 리소스를 획득하고, 유용한 데이터를 분석하고 추출합니다. 반환된 HTML 코드/JSON 데이터/바이너리 데이터(사진, 비디오)를 로컬로 크롤링한 후 필요한 데이터를 추출, 저장 및 사용합니다.

1 요청 시작

http 라이브러리를 사용하여 다음을 수행합니다. 대상 사이트, 즉 요청 보내기# 🎜🎜#요청에는 요청 헤더, 요청 본문 등이 포함됩니다.

요청 모듈 결함: JS 및 CSS 코드를 실행할 수 없습니다#🎜🎜 # 2. 응답 콘텐츠 가져오기

2. 응답 콘텐츠 가져오기

#🎜🎜 #HTML 데이터 구문 분석: 정규식(RE 모듈), Beautifulsoup, pyquery 등과 같은 타사 구문 분석 라이브러리#🎜🎜 #

json 데이터 구문 분석: json 모듈바이너리 데이터 구문 분석: wb 파일에 쓰기 4. 데이터 저장Database( MySQL, MongDB, Redis)위 내용은 파이썬 크롤러는 무엇을 의미합니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!