집 >데이터 베이스 >MySQL 튜토리얼 >MySQL 마스터-슬레이브 복제를 기반으로 한 Mycat 읽기 및 쓰기 분리의 예

MySQL 마스터-슬레이브 복제를 기반으로 한 Mycat 읽기 및 쓰기 분리의 예

- 黄舟원래의

- 2017-10-01 07:43:103387검색

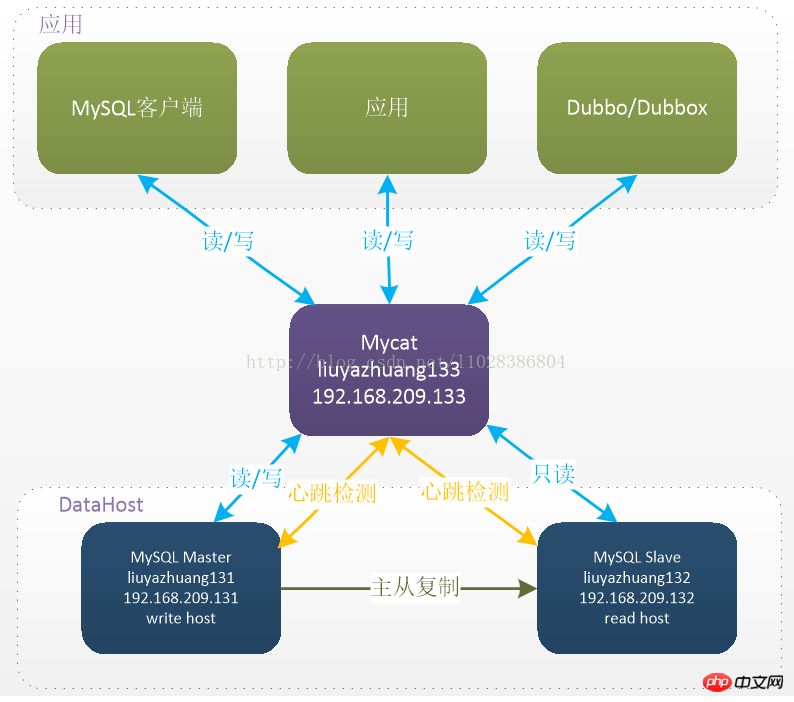

오늘은 Mycat이 MySQL 마스터-슬레이브 복제를 기반으로 읽기-쓰기 분리를 구현하는 방법에 대한 기사를 가져왔습니다. 여기서 주목해야 할 점은 MySQL의 마스터-슬레이브 복제는 Mycat이 아닌 마스터-슬레이브 복제 메커니즘에 의존한다는 것입니다. MySQL의 마스터-슬레이브 복제를 담당하는 MySQL의 마스터-슬레이브 복제 구성에 대해서는 블로그 게시물 "MySQL - 마스터-슬레이브 복제 구성"을 참조하세요. 자, 오늘의 주제로 들어가겠습니다.

1. 환경

운영 체제: CentOS-6.5-x86_64-bin-DVD1.iso

JDK 버전: jdk1.7.0_80

MyCat 버전: Mycat-server-1.5.1-RELEASE-20170717215510-linux.tar. gz (소스 코드 다운로드 및 직접 컴파일)

MyCat 노드 IP: 192.168.209.133 호스트 이름: liuyazhuang133 호스트 구성: 4코어 CPU, 4G 메모리

MySQL 버전: mysql-5.6.32.tar.gz

마스터 노드 IP : 192.168.209.131 호스트 이름: liuyazhuang131 호스트 구성: 4-core CPU, 4G 메모리

슬레이브 노드 IP: 192.168.209.132 호스트 이름: liuyazhuang132 호스트 구성: 4-core CPU, 4G 메모리

2. MyCat 소개(MyCat 공식 홈페이지 : http://mycat .io/ )

MyCat의 읽기-쓰기 분리는 백엔드 MySQL 클러스터의 마스터-슬레이브 동기화를 기반으로 구현되며, MyCat은 명령문 배포 기능을 제공합니다. MyCat 1.4는 MySQL 마스터-슬레이브 복제 상태 바인딩의 읽기-쓰기 분리 메커니즘을 지원하기 시작하여 읽기를 더욱 안전하고 안정적으로 만듭니다.

3. MyCat 설치

1. MyCat의 호스트 이름과 IP와 호스트 이름 간의 매핑을 설정합니다

# vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=liuyazhuang133

# vi /etc/hosts 127.0.0.1 liuyazhuang133 192.168.209.131 liuyazhuang131 192.168.209.132 liuyazhuang132 192.168.209.133 liuyazhuang133

2. MyCat은 Java로 개발되기 때문에 필요합니다. 실행하려면 JDK를 설치하세요(정확히는 JRE이면 충분합니다). JDK1.7 이상이 필요합니다

# vi /etc/profile ## java env export JAVA_HOME=/usr/local/java/jdk1.7.0_80 export JRE_HOME=$JAVA_HOME/jre export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib/rt.jar export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin # source /etc/profile # java -version

3. 설치 패키지를 업로드하세요

Mycat-server-1.5.1-RELEASE-20170717215510-linux.tar를 업로드하세요. .gz MyCat 서버의 /home/mycat 디렉토리로 이동하여 압축을 풀고 /usr/local/mycat 디렉토리로 이동합니다

$ tar -zxvf Mycat-server-1.5.1-RELEASE-20170717215510-linux.tar.gz

# mv /home/mycat/mycat /usr/local/ # cd /usr/local/mycat/ # ll

4. Mycat 환경 변수

# vi /etc/profile ## mycat env export MYCAT_HOME=/usr/local/mycat export PATH=$PATH:$MYCAT_HOME/bin # source /etc/profile

4를 설정합니다.

1. MySQL 마스터-슬레이브 복제가 정상인지 확인MyCat을 구성하기 전에 MySQL 마스터-슬레이브 복제 설치 구성이 완료되어 정상적으로 실행되는지 확인하세요. MySQL 마스터-슬레이브 데이터의 동기화는 MySQL에서 구성되며 MyCat은 데이터 동기화 문제에 대해 책임을 지지 않습니다.보충:

(1) MySQL 마스터-슬레이브 복제 구성에서 함수 또는 저장 프로시저의 동기 복제가 포함된 경우 /etc/my.cnf의 [mysqld] 섹션에 log_bin_trust_function_creators=true 구성을 추가해야 합니다. 클라이언트 Set set global log_bin_trust_function_creators = 1;(2) 읽기-쓰기 분리 하에서 마스터-슬레이브 전환을 수행하려는 경우 슬레이브 노드도 쓰기 노드가 될 수 있으므로 슬레이브 노드를 읽기-쓰기로 설정할 수 없습니다. 읽기 전용=1입니다.

(3) Linux 버전의 MySQL은 MySQL 대소문자를 구분하지 않도록 설정해야 합니다. 그렇지 않으면 테이블을 찾을 수 없는 문제가 발생할 수 있습니다. /etc/my.cnf의 [mysqld] 섹션에 lower_case_table_names=1을 추가할 수 있습니다.

2. MyCat의 Schema.xml 구성

MyCat 하트비트 확인 문은 슬레이브 상태 표시로 구성되며 두 개의 새로운 속성이 정의됩니다. dataHost: switchType="2" 및 SlaveThreshold= "100"은 MySQL 마스터-슬레이브 복제 상태 바인딩의 읽기-쓰기 분리 및 전환 메커니즘을 켜는 것을 의미합니다. MyCat 하트비트 메커니즘은 "Seconds_Behind_Master", "Slave_IO_Running" 및 "Slave_IO_Running" 세 가지 필드를 감지합니다. 슬레이브 상태 표시의 "Slave_SQL_Running" 현재 마스터-슬레이브 동기화 상태 및 Seconds_Behind_Master 마스터-슬레이브 복제 지연을 결정합니다. Seconds_Behind_Master가 SlaveThreshold보다 크면 읽기-쓰기 분리 필터가 이 슬레이브 시스템을 필터링하여 오래 전의 오래된 데이터를 읽지 못하게 합니다. 마스터 노드가 다운되면 스위치 로직은 슬레이브의 Seconds_Behind_Master가 0인지 확인합니다. 0이면 마스터와 슬레이브가 동기화되어 안전하게 전환될 수 있음을 의미합니다.

3. 구성 server.xml

server.xml은 주로 시스템 변수 설정, 사용자 관리, 사용자 권한 설정 등에 사용됩니다.

[root@liuyazhuang133 conf]$ cd /usr/local/root/conf/ [root@liuyazhuang133 conf]$ vi schema.xml

<?xml version="1.0"?>

<!DOCTYPE mycat:schema SYSTEM "schema.dtd">

<mycat:schema xmlns:mycat="http://org.opencloudb/">

<!-- 定义MyCat的逻辑库,逻辑库的概念与MySQL中的 database 概念相同 -->

<!-- schema name="rc_schema1" checkSQLschema="false" sqlMaxLimit="100" dataNode="rc_dn1"></schema -->

<!--schema name="pay_schema1" checkSQLschema="false" sqlMaxLimit="100" dataNode="pay_dn1"></schema-->

<schema name="lyz_schema1" checkSQLschema="false" sqlMaxLimit="100" dataNode="lyz_dn1"></schema>

<schema name="lyz_schema2" checkSQLschema="false" sqlMaxLimit="100" dataNode="lyz_dn2"></schema>

<!-- 其中checkSQLschema表明是否检查并过滤SQL中包含schema的情况,如逻辑库为 TESTDB,则可能写为select * from TESTDB.edu_user,此时会自动过滤TESTDB,SQL变为select * from edu_user,若不会出现上述写法,则可以关闭属性为false -->

<!--sqlMaxLimit默认返回的最大记录数限制,MyCat1.4版本里面,用户的Limit参数会覆盖掉MyCat的sqlMaxLimit默认设置-->

<!-- 定义MyCat的数据节点 -->

<dataNode name="lyz_dn1" dataHost="dtHost2" database="lyzdb1" />

<dataNode name="lyz_dn2" dataHost="dtHost2" database="lyzdb2" />

<!-- dataNode 中的 name 数据表示节点名称, dataHost表示数据主机名称, database表示该节点要路由的数据库的名称 -->

<!-- dataHost配置的是实际的后端数据库集群(当然,也可以是非集群) -->

<!-- 注意:schema中的每一个dataHost中的host属性值必须唯一,否则会出现主从在所有dataHost中全部切换的现象 -->

<!-- 定义数据主机dtHost1,只连接到MySQL读写分离集群中的Master节点,不使用MyCat托管MySQL主从切换 -->

<!--

<dataHost name="dtHost1" maxCon="500" minCon="20" balance="0"

writeType="0" dbType="mysql" dbDriver="native" switchType="1" slaveThreshold="100">

<heartbeat>select user()</heartbeat>

<writeHost host="hostM1" url="192.168.1.205:3306" user="root" password="lyz" />

</dataHost>

-->

<!-- 使用MyCat托管MySQL主从切换 -->

<!-- 定义数据主机dtHost2,连接到MySQL读写分离集群,并配置了读写分离和主从切换 -->

<dataHost name="dtHost2" maxCon="500" minCon="20" balance="1"

writeType="0" dbType="mysql" dbDriver="native" switchType="2" slaveThreshold="100">

<!-- 通过show slave status检测主从状态,当主宕机以后,发生切换,从变为主,原来的主变为从,这时候show slave status就会发生错误,因为原来的主没有开启slave,不建议直接使用switch操作,而是在DB中做主从对调。 -->

<heartbeat>show slave status</heartbeat>

<!-- can have multi write hosts -->

<writeHost host="hostM2" url="192.168.209.131:3306" user="root" password="root" />

<writeHost host="hostS2" url="192.168.209.132:3306" user="root" password="root" />

</dataHost>

<!-- 参数balance决定了哪些MySQL服务器参与到读SQL的负载均衡中 -->

<!-- balance="0",为不开启读写分离,所有读操作都发送到当前可用的writeHost上-->

<!-- balance="1",全部的readHost与stand by writeHost参与select语句的负载均衡-->

<!-- balance="2",所有读操作都随机的在writeHost、readHost上分发-->

<!-- MyCat1.4版本中,若想支持MySQL一主一从的标准配置,并且在主节点宕机的情况下,从节点还能读取数据,则需要在MyCat里配置为两个writeHost并设置balance="1" -->

<!-- writeType="0",所有写操作都发送到可用的writeHost上 -->

<!-- writeType="1",仅仅对于galera for mysql集群这种多主多节点都能写入的集群起效,此时Mycat会随机选择一个writeHost并写入数据,对于非galera for mysql集群,请不要配置writeType=1,会导致数据库不一致的严重问题 -->

</mycat:schema>4. 방화벽에서 포트 8066 및 9066을 엽니다

MyCat의 기본 데이터 포트는 8066입니다. Mycat은 이 포트를 통해 데이터베이스 클라이언트로부터 액세스 요청을 받습니다.

관리 포트는 9066으로, mycat 모니터링 명령 수신, mycat 실행 상태 쿼리, 구성 파일 다시 로드 등에 사용됩니다.[root@liuyazhuang133 conf]$ vi server.xml추가됨:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mycat:server SYSTEM "server.dtd">

<mycat:server xmlns:mycat="http://org.opencloudb/">

<system>

<property name="defaultSqlParser">druidparser</property>

<property name="charset">utf8mb4</property>

<!-- <property name="useCompression">1</property>-->

<!--1为开启mysql压缩协议-->

<!-- <property name="processorBufferChunk">40960</property> -->

<!--

<property name="processors">1</property>

<property name="processorExecutor">32</property>

-->

<!--默认是65535 64K 用于sql解析时最大文本长度 -->

<!--<property name="maxStringLiteralLength">65535</property>-->

<!--<property name="sequnceHandlerType">0</property>-->

<!--<property name="backSocketNoDelay">1</property>-->

<!--<property name="frontSocketNoDelay">1</property>-->

<!--<property name="processorExecutor">16</property>-->

<!-- <property name="mutiNodeLimitType">1</property> 0:开启小数量级(默认) ;1:开启亿级数据排序

<property name="mutiNodePatchSize">100</property> 亿级数量排序批量

<property name="processors">32</property> <property name="processorExecutor">32</property>

<property name="serverPort">8066</property> <property name="managerPort">9066</property>

<property name="idleTimeout">300000</property> <property name="bindIp">0.0.0.0</property>

<property name="frontWriteQueueSize">4096</property>

<property name="processors">32</property>

-->

</system>

<!-- 用户1,对应的MyCat逻辑库连接到的数据节点对应的主机为MySQL主从复制配置中的Master节点,没实现读写分离,读写都在该Master节点中进行 -->

<!--

<user name="user1">

<property name="password">roncoo.1</property>

<property name="schemas">rc_schema1,pay_schema1</property>

</user>

-->

<!-- 用户2,对应的MyCat逻辑库连接到的数据节点对应的主机为主从复制集群,并通过MyCat实现了读写分离 -->

<user name="lyz">

<property name="password">lyz.123</property>

<property name="schemas">lyz_schema1,lyz_schema2</property>

</user>

<!-- 用户3,只读权限-->

<user name="userlyz">

<property name="password">lyz.123</property>

<property name="schemas">lyz_schema1,lyz_schema2</property>

<property name="readOnly">true</property>

</user>

</mycat:server>방화벽 다시 시작:

[root@liuyazhuang133 mycat]# vi /etc/sysconfig/iptables5. 로그 수준을 디버깅으로 수정

MyCat 기반 MySQL 데이터베이스 클러스터의 데이터 작업을 로그를 통해 확인하려면 로그 수준을 디버그하세요. 읽고 쓰는 분리 상태(공식 제작 전 정보 수준으로 변경 가능)

## MyCat -A INPUT -m state --state NEW -m tcp -p tcp --dport 8066 -j ACCEPT -A INPUT -m state --state NEW -m tcp -p tcp --dport 9066 -j ACCEPT

6、启动root

[root@liuyazhuang133 bin]$ cd /usr/local/root/bin/

(1) 控制台启动,这种启动方式在控制台关闭后,root服务也将关闭,适合调试使用:

[root@liuyazhuang133 bin]$ ./root console

(2) 可以采用以下后台启动的方式:

[root@liuyazhuang133 bin]$ ./root start Starting root-server...

(对应的,重启: root restart , 关闭: root stop )

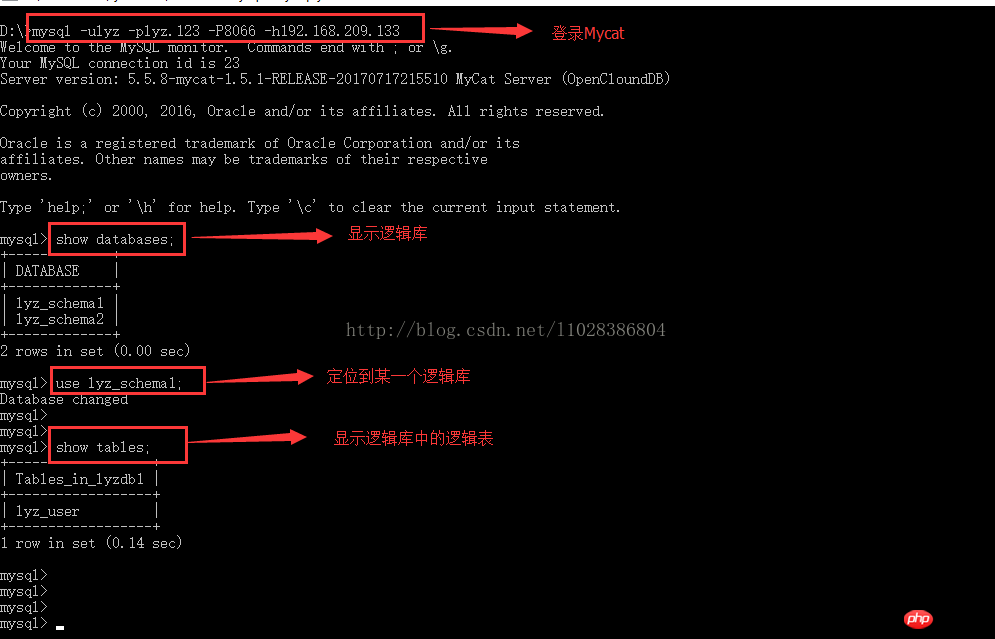

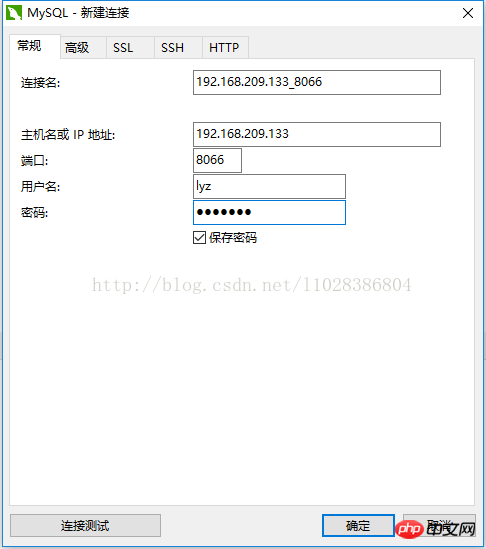

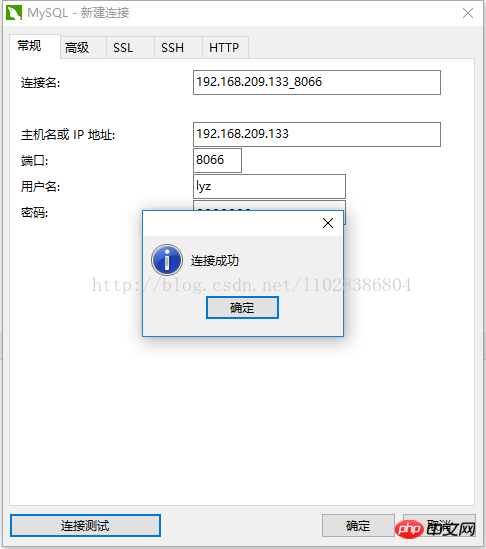

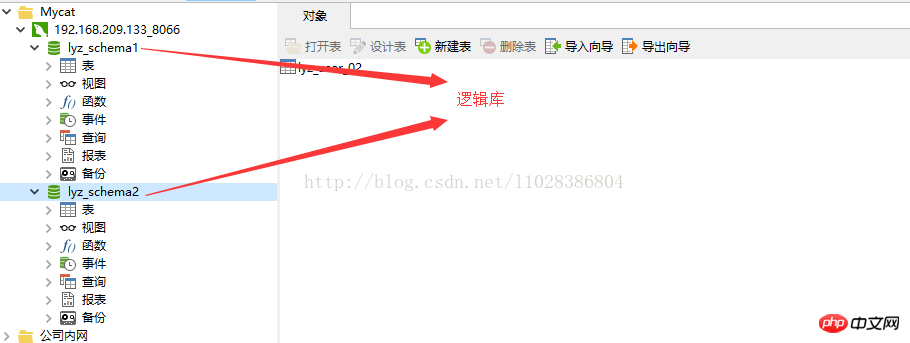

7、MyCat连接测试

(1) 如果本地Windows安装有MySQL,可以使用已有的mysql客户端远程操作Mycat

(2) Nativecat连接Mycat

8、读写分离测试

(1) 监听MyCat日志

[root@liuyazhuang133 ~]$ cd /usr/local/mycat/logs/ [root@liuyazhuang133 logs]$ tail -f mycat.log

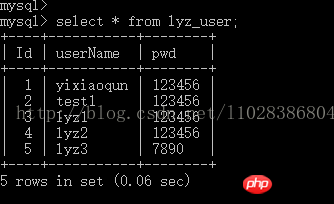

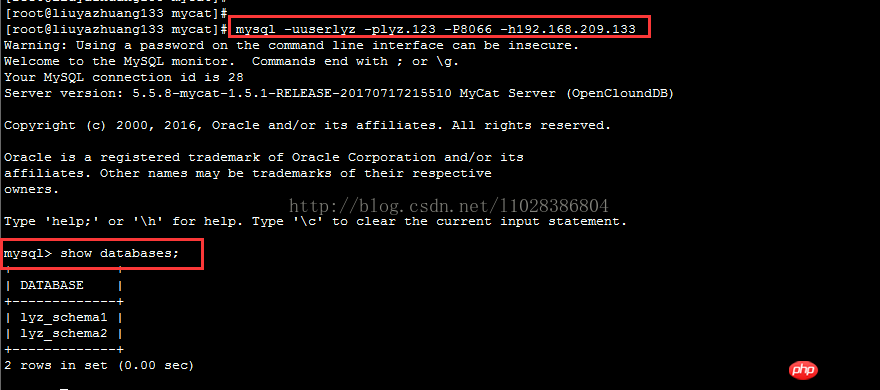

(2) 读测试

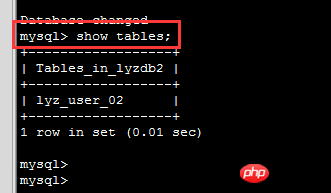

$ mysql -uuserlyz -plyz.123 -h192.168.209.233 -P8066 mysql> show databases;

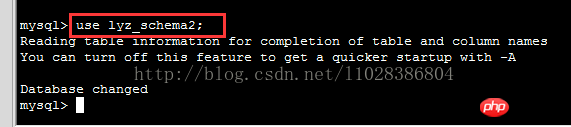

mysql> use lyz_schema2;

mysql> show tables;

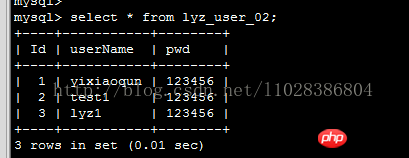

mysql> select * from lyz_user_02;

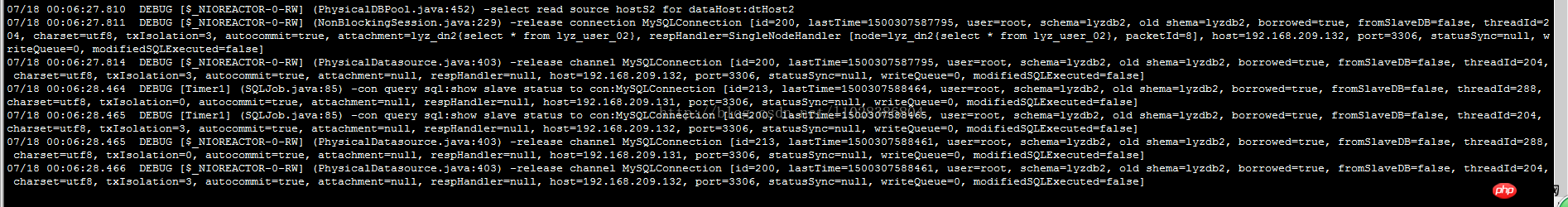

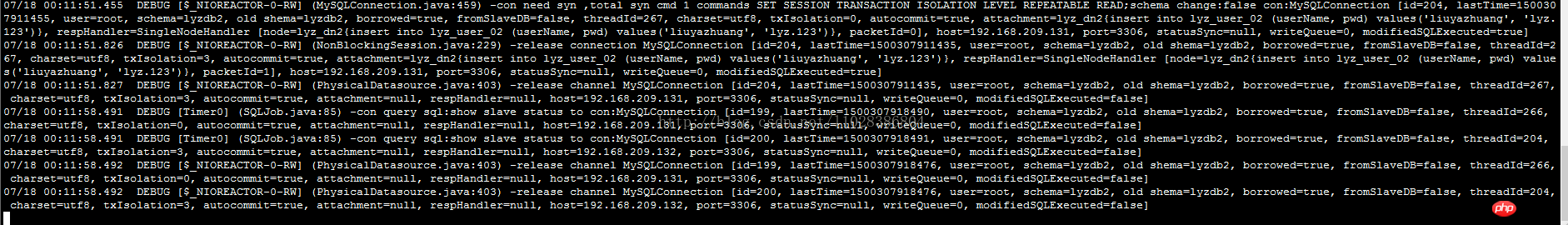

执行上面的查询语句,此时对应的MyCat日志信息如下:

多次执行 select * from lyz_user_02 语句,Mycat打印出来的日志信息显示读操作请求都是路由到Slave节点(192.168.209.132)

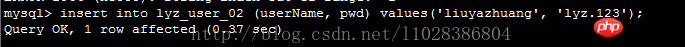

(2) 写测试

mysql> insert into lyz_user_02 (userName, pwd) values('liuyazhuang', 'lyz。123');

执行上面的新增插入语句后,此时对应的Mycat日志信息如下:

多次执行以上插入语句,发现新增数据都是从 Master节点(192.168.209.131)插进入的,并且Slave节点通过Binlog同步了Master节点中的数据。

综上,基于MyCat的读写分离集群配置成功。

위 내용은 MySQL 마스터-슬레이브 복제를 기반으로 한 Mycat 읽기 및 쓰기 분리의 예의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!