요청 모듈을 사용하여 페이지 콘텐츠를 크롤링하는 Python3의 자세한 예

- 巴扎黑원래의

- 2017-09-26 10:39:123484검색

이 글은 주로 python3을 사용하여 요청 모듈을 사용하여 페이지 콘텐츠를 크롤링하는 실제 사례를 소개합니다. 관심 있는 사람은 이에 대해 알아볼 수 있습니다.

1. 내 개인 데스크톱 시스템에 pip

linuxmint를 설치하세요. 시스템은 기본적으로 pip를 설치하지 않습니다. 나중에 요청 모듈을 설치하는 데 pip가 사용된다는 점을 고려하면 여기서 첫 번째 단계는 pip를 설치하는 것입니다.

$ sudo apt install python-pip

설치가 성공했습니다. PIP 버전을 확인하세요.

$ pip -V

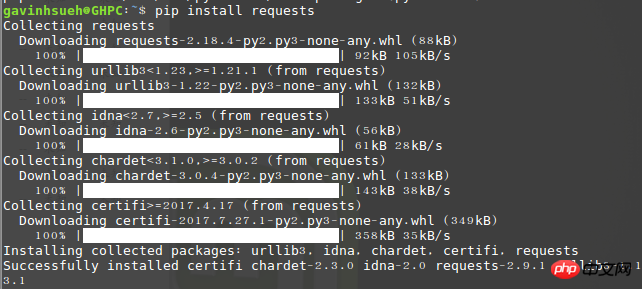

2 요청 모듈을 설치합니다.

여기에서 pip를 통해 설치했습니다.

$ pip install requests

가져오기 실행 요청, 오류가 없다면 설치가 성공한 것입니다!

설치 성공 여부 확인

3. beautifulsoup4 설치

Beautiful Soup은 HTML 또는 XML 파일에서 데이터를 추출할 수 있는 Python 라이브러리입니다. 이는 관례적인 문서 탐색을 가능하게 하며 즐겨 사용하는 변환기를 통해 문서를 찾고 수정하는 방법을 제공합니다. Beautiful Soup을 사용하면 몇 시간, 심지어 며칠의 작업 시간을 절약할 수 있습니다.

$ sudo apt-get install python3-bs4

참고: 여기서는 python3 설치 방법을 사용하고 있습니다. python2를 사용하는 경우 다음 명령을 사용하여 설치할 수 있습니다.

$ sudo pip install beautifulsoup4

4 요청 모듈에 대한 간략한 분석

1) 요청 보내기

우선 요청 모듈을 가져와야 합니다.

>>> import requests

그런 다음 get 대상 크롤링 웹페이지. 여기서는 다음을 예로 들어 보겠습니다.

>>> r = requests.get('http://www.jb51.net/article/124421.htm')

여기서 r이라는 응답 개체가 반환됩니다. 우리는 이 객체로부터 원하는 모든 정보를 얻을 수 있습니다. get here는 http의 응답 방식이므로 비유적으로 put, delete, post, head로 대체할 수도 있습니다.

2) URL 매개변수 전달

때때로 URL의 쿼리 문자열에 대한 일종의 데이터를 전달하고 싶을 때가 있습니다. URL을 직접 작성하는 경우 데이터는 키/값 쌍으로 URL에 배치되고 그 뒤에 물음표가 표시됩니다. 예를 들어 cnblogs.com/get?key=val입니다. 요청을 통해 params 키워드 인수를 사용하여 이러한 매개변수를 문자열 사전으로 제공할 수 있습니다.

예를 들어, Google에서 "python 크롤러"라는 키워드를 검색할 때 newwindow(새 창 열기), q 및 oq(검색 키워드)와 같은 매개변수를 URL에 수동으로 구성할 수 있으며 다음 코드를 사용할 수 있습니다.

>>> payload = {'newwindow': '1', 'q': 'python爬虫', 'oq': 'python爬虫'}

>>> r = requests.get("https://www.google.com/search", params=payload)3) 응답 내용

r.text 또는 r.content를 통해 페이지 응답 내용을 가져옵니다.

>>> import requests

>>> r = requests.get('https://github.com/timeline.json')

>>> r.text요청은 서버의 콘텐츠를 자동으로 디코딩합니다. 대부분의 유니코드 문자 집합은 원활하게 디코딩될 수 있습니다. r.text와 r.content의 차이점에 대해 간단히 설명하면 다음과 같습니다.

resp.text는 유니코드 데이터를 반환합니다.

resp.content는 바이너리 데이터인 바이트 유형을 반환합니다. 텍스트를 얻으려면 r.text를 사용하면 됩니다. 사진이나 파일을 얻으려면 r.content를 사용하면 됩니다.

4) 웹 페이지 인코딩 가져오기

>>> r = requests.get('http://www.cnblogs.com/') >>> r.encoding 'utf-8'

5) 응답 상태 코드 가져오기

응답 상태 코드를 감지할 수 있습니다:

>>> r = requests.get('http://www.cnblogs.com/') >>> r.status_code 200

5. 회사에서 방금 최근 OA 시스템을 도입했습니다. 여기서는 공식 문서 페이지를 예로 들어 페이지의 기사 제목 및 내용과 같은 유용한 정보만 캡처합니다.

데모 환경

운영 체제: linuxmintPython 버전: python 3.5.2사용 모듈: 요청, beautifulsoup4코드는 다음과 같습니다.#!/usr/bin/env python

# -*- coding: utf-8 -*-

_author_ = 'GavinHsueh'

import requests

import bs4

#要抓取的目标页码地址

url = 'http://www.ranzhi.org/book/ranzhi/about-ranzhi-4.html'

#抓取页码内容,返回响应对象

response = requests.get(url)

#查看响应状态码

status_code = response.status_code

#使用BeautifulSoup解析代码,并锁定页码指定标签内容

content = bs4.BeautifulSoup(response.content.decode("utf-8"), "lxml")

element = content.find_all(id='book')

print(status_code)

print(element)프로그램이 실행되고 크롤링 결과를 반환합니다.

크롤링이 성공했습니다

크롤링 결과가 왜곡되는 문제에 대해

크롤링 결과가 왜곡되는 문제에 대해

Postscript

Python에는 크롤러 관련 모듈이 많이 있고 요청 모듈 외에 urllib, pycurl, tornado 등도 있습니다. 이에 비해 저는 개인적으로 요청 모듈이 비교적 간단하고 사용하기 쉽다고 생각합니다. 텍스트를 통해 Python의 요청 모듈을 사용하여 페이지 콘텐츠를 크롤링하는 방법을 빠르게 배울 수 있습니다. 제 능력에는 한계가 있습니다. 기사에 실수가 있으면 언제든지 알려주시기 바랍니다. 둘째, Python으로 크롤링된 페이지의 내용에 대해 궁금한 점이 있으면 누구나 토론하실 수 있습니다.위 내용은 요청 모듈을 사용하여 페이지 콘텐츠를 크롤링하는 Python3의 자세한 예의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!