얼마 전에 "리눅스 커널에 대한 심층적 이해"를 읽고 메모리 관리 부분에 대해 많은 시간을 보냈지만 아직 명확하지 않은 질문이 많이 있습니다. 최근에 시간을 들여 검토해 보았습니다. 여기에는 Linux의 메모리 관리에 대한 몇 가지 견해와 이해가 기록되어 있습니다.

나는 기술 자체의 개발 역사를 간단히 이해하는 것을 선호합니다. 이 기술이 어떻게 발전했는지, 이 기술 이전에는 어떤 기술이 존재했는지, 이러한 기술이 어떤 특성을 가지고 있는지, 현재의 기술로 대체되는 이유는 무엇입니까? 기술은 이전 기술의 문제를 해결합니다. 이를 이해하면 특정 기술을 더 명확하게 이해할 수 있습니다. 어떤 소재는 개발 과정이나 그 뒤에 숨은 원리를 언급하지 않은 채 특정 개념의 의미와 원리를 직접적으로 소개하는 경우도 있는데, 마치 기술이 하늘에서 떨어진 것처럼 말입니다. 이제 메모리 관리의 발전 역사를 바탕으로 오늘의 주제에 대해 이야기해보겠습니다.

우선 이 글의 주제가 리눅스 메모리 관리의 분할과 페이징 기술이라는 점을 먼저 설명드리고 싶습니다.

역사를 되돌아보겠습니다. 초기 컴퓨터에서는 프로그램이 물리적 메모리에서 직접 실행되었습니다. 즉, 실행 중 모든 프로그램 액세스는 물리적 주소입니다. 이 시스템이 하나의 프로그램만 실행한다면 이 프로그램에 필요한 메모리가 머신의 물리적 메모리를 초과하지 않는 한 문제가 없으며 어쨌든 번거로운 메모리 관리를 고려할 필요가 없습니다. 단지 당신의 프로그램, 그게 전부입니다. 돈을 절약하십시오. 충분히 먹을지 여부는 당신에게 달려 있습니다. 그러나 오늘날의 시스템은 멀티 태스킹 및 멀티 프로세싱을 지원하므로 CPU 및 기타 하드웨어의 활용도가 높아집니다. 이때 시스템의 제한된 물리적 메모리를 적시에 여러 프로그램에 할당하는 방법을 고려해야 합니다. 효과적인 방식으로, 이 문제 자체를 메모리 관리라고 합니다.

모든 사람의 이해를 돕기 위해 초기 컴퓨터 시스템의 메모리 할당 관리에 대한 예를 소개합니다.

프로그램 1, 2, 3의 세 가지 프로그램이 있습니다. 프로그램 1은 실행 중 10M 메모리가 필요하고, 프로그램 2는 실행 중 100M 메모리가 필요하며, 프로그램 3은 실행 중 20M 메모리가 필요합니다. 시스템이 프로그램 A와 B를 동시에 실행해야 하는 경우 초기 메모리 관리 프로세스는 아마도 첫 번째 10M의 물리적 메모리를 A에 할당하고 다음 10M-110M을 B에 할당하는 것과 같습니다. 이 메모리 관리 방법은 비교적 간단합니다. 지금 프로그램 C를 실행하려고 하고 시스템의 메모리가 128M에 불과하다고 가정해 보겠습니다. 분명히 이 방법에 따르면 프로그램 C는 부족하여 실행될 수 없습니다. 메모리. 가상 메모리 기술을 사용하면 메모리 공간이 부족할 때 프로그램에서 사용하지 않는 데이터를 디스크 공간으로 스왑할 수 있어 메모리 공간 확장이라는 목적을 달성했다는 것은 누구나 아는 사실이다. 이 메모리 관리 방법의 좀 더 명백한 문제를 살펴보겠습니다. 기사 시작 부분에서 언급했듯이 기술을 깊이 이해하려면 해당 기술의 개발 역사를 이해하는 것이 가장 좋습니다.

1. 프로세스 주소 공간은 분리될 수 없습니다

프로그램이 물리적 메모리에 직접 접근하기 때문에, 이때 프로그램이 사용하는 메모리 공간은 분리되지 않습니다. 예를 들어 위에서 언급한 것처럼 A의 주소 공간은 0~10M 범위에 있지만 A에 10M~128M 주소 공간의 데이터를 연산하는 코드가 있다면 프로그램 B와 프로그램 C는 충돌 가능성이 있습니다(모든 프로그램이 시스템의 전체 주소 공간을 차지할 수 있음). 이런 식으로 많은 악성 프로그램이나 트로이 목마 프로그램은 다른 프로그램을 쉽게 손상시킬 수 있으며, 시스템의 보안도 보장할 수 없어 사용자가 견딜 수 없습니다.

2. 메모리 사용량이 비효율적입니다

위에서 언급했듯이 프로그램 A, B, C를 동시에 실행하려면 가상 메모리 기술을 사용하여 일시적으로 사용되지 않는 일부 데이터를 쓰는 것이 유일한 방법입니다. 프로그램을 디스크에 저장한 다음 필요할 때 디스크에서 메모리로 다시 읽어옵니다. 프로그램 C는 20M의 메모리를 필요로 하고 A는 10M의 공간만 갖고 있으므로 프로그램 B를 디스크로 스왑해야 하기 때문에 당연히 불가능합니다. B는 완전히 100M입니다. 프로그램 C를 실행하려면 메모리에서 디스크로 100M의 데이터를 쓴 다음 프로그램 B를 실행해야 할 때 디스크에서 메모리로 읽어야 합니다. IO 작업에는 시간이 많이 걸리므로 이 프로세스의 효율성은 매우 낮습니다.

3. 프로그램이 실행되는 주소를 결정할 수 없습니다

프로그램을 실행할 때마다 메모리에 충분히 큰 여유 공간을 할당해야 합니다. 문제는 이 여유 위치를 결정할 수 없다는 것입니다. 문제가 발생합니다. 재배치 문제는 프로그램에서 참조하는 변수 및 함수의 주소여야 합니다. 이해가 되지 않으면 컴파일 정보를 확인하면 됩니다.

메모리 관리는 위의 세 가지 문제를 해결하는 방법, 프로세스의 주소 공간을 격리하는 방법, 메모리 사용 효율성을 높이는 방법, 프로그램 실행 시 재배치 문제를 해결하는 방법에 지나지 않습니다.

검증할 수 없는 컴퓨터 업계의 명언은 다음과 같습니다. "컴퓨터 시스템의 모든 문제는 중간 계층을 도입하면 해결될 수 있습니다."

현재의 메모리 관리 방식에는 프로그램과 물리적 메모리 사이에 가상 메모리라는 개념이 도입되어 있습니다. 가상 메모리는 프로그램과 내부 메모리 사이에 위치합니다. 프로그램은 가상 메모리만 볼 수 있으며 더 이상 실제 메모리에 직접 접근할 수 없습니다. 각 프로그램은 자신만의 독립적인 프로세스 주소 공간을 갖고 있어 프로세스 격리를 달성합니다. 여기서 프로세스 주소 공간은 가상 주소를 의미합니다. 이름에서 알 수 있듯이 가상 주소이므로 실제 주소 공간이 아닌 가상 주소입니다.

프로그램과 물리적 주소 공간 사이에 가상 주소를 추가했기 때문에 프로그램은 결국 물리적 메모리에서 실행되어야 하고 주로 두 가지가 있기 때문에 가상 주소에서 물리적 주소로 매핑하는 방법을 찾아야 합니다. 유형: 분할 및 페이징 기술.

분할: 이 방법은 사람들이 사용하는 첫 번째 방법 중 하나입니다. 기본 아이디어는 프로그램에 필요한 메모리 주소 공간의 가상 공간을 특정 물리적 주소 공간에 매핑하는 것입니다.

세그먼트 매핑 메커니즘

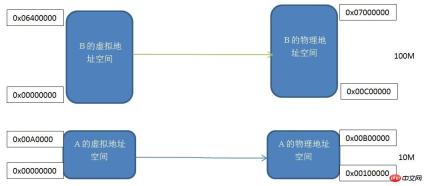

각 프로그램에는 프로그램 A와 B의 가상 주소 공간이 모두 0x00000000에서 시작하는 독립적인 가상 독립 프로세스 주소 공간이 있습니다. 동일한 크기의 두 가상 주소 공간을 실제 물리적 주소 공간에 하나씩 매핑합니다. 즉, 가상 주소 공간의 각 바이트는 실제 주소 공간의 각 바이트에 해당합니다. 이 매핑 프로세스는 소프트웨어에 의해 설정됩니다. 실제 변환은 하드웨어에 의해 수행됩니다.

이 분할된 메커니즘은 기사 시작 부분에서 언급한 프로세스 주소 공간 격리 및 프로그램 주소 재배치라는 세 가지 문제를 해결합니다. 프로그램 A와 프로그램 B는 각각 독립적인 가상 주소 공간을 가지며, 가상 주소 공간은 서로 겹치지 않는 물리적 주소 공간에 매핑됩니다. 프로그램 A가 가상 주소 공간에 접근하는 주소가 0x00000000~0x00A00000 범위에 속하지 않는 경우 커널은 이 요청을 거부하므로 주소 공간 격리 문제를 해결합니다. 우리의 애플리케이션 A는 가상 주소 공간 0x00000000-0x00A00000에만 신경 쓰면 되고 어떤 물리적 주소에 매핑되는지 신경 쓸 필요가 없으므로 프로그램은 항상 재배치 없이 이 가상 주소 공간에 따라 변수와 코드를 배치합니다.

분할 메커니즘이 위의 두 가지 문제를 어떻게 해결하더라도 대단한 진전이지만 여전히 메모리 효율성 문제를 해결하지 못하고 있습니다. 이 메모리 매핑 메커니즘은 여전히 프로그램을 기반으로 하기 때문에 메모리가 부족하면 전체 프로그램을 디스크로 교체해야 하므로 메모리 사용 효율성은 여전히 매우 낮습니다. 그렇다면 효율적인 메모리 사용이란 무엇입니까? 실제로 프로그램의 로컬 작동 원리에 따르면 프로그램 실행 중 일정 기간 동안 데이터의 극히 일부만 자주 사용됩니다. 그래서 좀 더 세분화된 메모리 분할 및 매핑 방법이 필요합니다. 이때 Linux의 Buddy 알고리즘과 슬랩 메모리 할당 메커니즘을 생각해 보시겠습니까? 가상 주소를 물리적 주소로 변환하는 또 다른 방법은 페이징 메커니즘입니다.

페이징 메커니즘:

페이징 메커니즘은 메모리 주소 공간을 여러 개의 작은 고정 크기 페이지로 나누는 것입니다. Linux의 외부 파일 시스템이 디스크를 여러 블록으로 나누는 것과 마찬가지로 각 페이지의 크기는 메모리에 의해 결정됩니다. 이는 메모리와 디스크 활용도를 각각 향상시키기 위해 수행됩니다. 다음을 상상해 보세요. 디스크 공간을 N등분하여 각 부분(블록 1개)의 크기는 1M이고, 디스크에 저장하려는 파일이 1K바이트라면 나머지 999바이트는 낭비됩니다. 따라서 보다 세분화된 디스크 파티셔닝 방법이 필요합니다. 이는 물론 저장된 파일의 크기를 기준으로 한 것입니다. 페이징이라고 말하고 싶습니다. 메모리의 메커니즘은 ext와 다릅니다. 파일 시스템의 디스크 파티셔닝 메커니즘은 매우 유사합니다.

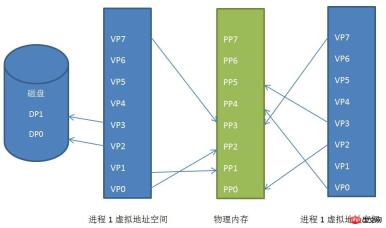

리눅스의 일반적인 페이지 크기는 4KB입니다. 프로세스의 주소 공간을 페이지별로 나누고, 자주 사용되는 데이터와 코드 페이지를 메모리에 로드하고, 덜 자주 사용되는 코드와 데이터를 디스크에 저장하는 예를 들어보겠습니다. .설명은 아래와 같습니다.

프로세스 가상 주소 공간, 물리적 주소 공간 및 디스크 간의 페이지 매핑 관계

프로세스 1과 프로세스 2의 가상 주소 공간이 불연속적인 물리적 주소로 매핑되는 것을 볼 수 있습니다. 공간(이것은 매우 중요합니다. 어느 날 연속적인 물리적 주소 공간이 충분하지 않지만 불연속적인 주소 공간이 많으면 이 기술이 없으면 프로그램을 실행할 수 없게 됩니다.) 또는 일부를 공유하는 경우에도 마찬가지입니다. 물리적 주소 공간의 공유 메모리입니다.

프로세스 1의 가상 페이지 VP2와 VP3이 디스크로 교체됩니다. 프로그램에 이 두 페이지가 필요할 때 Linux 커널은 페이지 오류 예외를 생성한 다음 예외 관리 프로그램이 이를 메모리로 읽습니다.

이것이 페이징 메커니즘의 원리입니다. 물론 Linux에서 페이징 메커니즘을 구현하는 것은 여전히 상대적으로 복잡합니다. 이는 전역 디렉터리, 상위 디렉터리, 페이지와 같은 여러 수준의 페이징 메커니즘을 통해 구현됩니다. 중간 디렉토리 및 페이지 테이블. 그러나 기본적으로 작동 원리는 변경되지 않습니다.

페이징 메커니즘을 구현하려면 하드웨어 구현이 필요합니다. 이 하드웨어의 이름은 MMU(Memory Management Unit)입니다. 특히 가상 주소를 물리적 주소로 변환하는 역할, 즉 가상 페이지에서 물리적 페이지를 찾는 역할을 합니다.

위 내용은 Linux의 메모리 관리에 대한 자세한 소개의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Linux 운영 : 시스템 관리 및 유지 보수Apr 15, 2025 am 12:10 AM

Linux 운영 : 시스템 관리 및 유지 보수Apr 15, 2025 am 12:10 AMLinux 시스템 관리 및 유지 보수의 주요 단계에는 다음이 포함됩니다. 1) 파일 시스템 구조 및 사용자 관리와 같은 기본 지식을 마스터합니다. 2) 시스템 모니터링 및 리소스 관리를 수행하고 Top, HTOP 및 기타 도구를 사용하십시오. 3) 시스템 로그를 사용하여 문제를 해결하고 JournalCTL 및 기타 도구를 사용하십시오. 4) 자동 스크립트 및 작업 스케줄링을 작성하고 CRON 도구를 사용하십시오. 5) 보안 관리 및 보호 구현, iptables를 통해 방화벽을 구성합니다. 6) 성능 최적화 및 모범 사례를 수행하고 커널 매개 변수를 조정하며 좋은 습관을 개발하십시오.

Linux의 유지 관리 모드 이해 : 필수 요소Apr 14, 2025 am 12:04 AM

Linux의 유지 관리 모드 이해 : 필수 요소Apr 14, 2025 am 12:04 AM시작시 init =/bin/bash 또는 단일 매개 변수를 추가하여 Linux 유지 관리 모드가 입력됩니다. 1. 유지 보수 모드를 입력하십시오 : 그루브 메뉴를 편집하고 시작 매개 변수를 추가하십시오. 2. 파일 시스템을 다시 마운트하여 읽고 쓰기 모드 : MOUNT-OREMOUNT, RW/. 3. 파일 시스템 수리 : FSCK/DEV/SDA1과 같은 FSCK 명령을 사용하십시오. 4. 데이터 손실을 피하기 위해 데이터를 백업하고주의해서 작동합니다.

Debian이 Hadoop 데이터 처리 속도를 향상시키는 방법Apr 13, 2025 am 11:54 AM

Debian이 Hadoop 데이터 처리 속도를 향상시키는 방법Apr 13, 2025 am 11:54 AM이 기사에서는 데비안 시스템에서 Hadoop 데이터 처리 효율성을 향상시키는 방법에 대해 설명합니다. 최적화 전략에는 하드웨어 업그레이드, 운영 체제 매개 변수 조정, Hadoop 구성 수정 및 효율적인 알고리즘 및 도구 사용이 포함됩니다. 1. 하드웨어 리소스 강화는 모든 노드에 일관된 하드웨어 구성, 특히 CPU, 메모리 및 네트워크 장비 성능에주의를 기울일 수 있도록합니다. 전반적인 처리 속도를 향상시키기 위해서는 고성능 하드웨어 구성 요소를 선택하는 것이 필수적입니다. 2. 운영 체제 조정 파일 설명 자 및 네트워크 연결 : /etc/security/limits.conf 파일을 수정하여 파일 설명자의 상한을 늘리고 동시에 시스템에 의해 열 수 있습니다. JVM 매개 변수 조정 : Hadoop-env.sh 파일에서 조정

데비안 syslog를 배우는 방법Apr 13, 2025 am 11:51 AM

데비안 syslog를 배우는 방법Apr 13, 2025 am 11:51 AM이 안내서는 데비안 시스템에서 syslog를 사용하는 방법을 배우도록 안내합니다. Syslog는 로깅 시스템 및 응용 프로그램 로그 메시지를위한 Linux 시스템의 핵심 서비스입니다. 관리자가 시스템 활동을 모니터링하고 분석하여 문제를 신속하게 식별하고 해결하는 데 도움이됩니다. 1. syslog에 대한 기본 지식 syslog의 핵심 기능에는 다음이 포함됩니다. 로그 메시지 중앙 수집 및 관리; 다중 로그 출력 형식 및 대상 위치 (예 : 파일 또는 네트워크) 지원; 실시간 로그보기 및 필터링 기능 제공. 2. Syslog 설치 및 구성 (RSYSLOG 사용) Debian 시스템은 기본적으로 RSYSLOG를 사용합니다. 다음 명령으로 설치할 수 있습니다 : sudoaptupdatesud

데비안에서 Hadoop 버전을 선택하는 방법Apr 13, 2025 am 11:48 AM

데비안에서 Hadoop 버전을 선택하는 방법Apr 13, 2025 am 11:48 AM데비안 시스템에 적합한 Hadoop 버전을 선택할 때는 다음과 같은 주요 요소를 고려해야합니다. 1. 안정성 및 장기 지원 : 안정성과 보안을 추구하는 사용자의 경우 Debian11 (Bullseye)과 같은 데비안 안정 버전을 선택하는 것이 좋습니다. 이 버전은 완전히 테스트되었으며 최대 5 년의 지원주기가있어 시스템의 안정적인 작동을 보장 할 수 있습니다. 2. 패키지 업데이트 속도 : 최신 Hadoop 기능 및 기능을 사용해야하는 경우 Debian의 불안정한 버전 (SID)을 고려할 수 있습니다. 그러나 불안정한 버전에는 호환성 문제와 안정성 위험이있을 수 있습니다. 3. 커뮤니티 지원 및 자원 : 데비안은 풍부한 문서를 제공하고

Debian의 Tigervnc 공유 파일 메소드Apr 13, 2025 am 11:45 AM

Debian의 Tigervnc 공유 파일 메소드Apr 13, 2025 am 11:45 AM이 기사에서는 Tigervnc를 사용하여 데비안 시스템에서 파일을 공유하는 방법에 대해 설명합니다. 먼저 tigervnc 서버를 설치 한 다음 구성해야합니다. 1. TigervNC 서버를 설치하고 터미널을 엽니 다. 소프트웨어 패키지 목록 업데이트 : sudoaptupdate tigervnc 서버를 설치하려면 : sudoaptinstalltigervnc-standalone-servertigervnc-common 2. VNC 서버 비밀번호를 설정하도록 tigervnc 서버 구성 : vncpasswd vnc 서버 : vncserver : 1-localhostno

데비안 메일 서버 방화벽 구성 팁Apr 13, 2025 am 11:42 AM

데비안 메일 서버 방화벽 구성 팁Apr 13, 2025 am 11:42 AM데비안 메일 서버의 방화벽 구성은 서버 보안을 보장하는 데 중요한 단계입니다. 다음은 iptables 및 방화구 사용을 포함하여 일반적으로 사용되는 여러 방화벽 구성 방법입니다. iptables를 사용하여 iptables를 설치하도록 방화벽을 구성하십시오 (아직 설치되지 않은 경우) : sudoapt-getupdatesudoapt-getinstalliptablesview 현재 iptables 규칙 : sudoiptables-l configuration

데비안 메일 서버 SSL 인증서 설치 방법Apr 13, 2025 am 11:39 AM

데비안 메일 서버 SSL 인증서 설치 방법Apr 13, 2025 am 11:39 AMDebian Mail 서버에 SSL 인증서를 설치하는 단계는 다음과 같습니다. 1. OpenSSL 툴킷을 먼저 설치하십시오. 먼저 OpenSSL 툴킷이 이미 시스템에 설치되어 있는지 확인하십시오. 설치되지 않은 경우 다음 명령을 사용하여 설치할 수 있습니다. 개인 키 및 인증서 요청 생성 다음에 다음, OpenSSL을 사용하여 2048 비트 RSA 개인 키 및 인증서 요청 (CSR)을 생성합니다.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

드림위버 CS6

시각적 웹 개발 도구

안전한 시험 브라우저

안전한 시험 브라우저는 온라인 시험을 안전하게 치르기 위한 보안 브라우저 환경입니다. 이 소프트웨어는 모든 컴퓨터를 안전한 워크스테이션으로 바꿔줍니다. 이는 모든 유틸리티에 대한 액세스를 제어하고 학생들이 승인되지 않은 리소스를 사용하는 것을 방지합니다.

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.

WebStorm Mac 버전

유용한 JavaScript 개발 도구