집 >백엔드 개발 >XML/RSS 튜토리얼 >RSS와 크롤러, 데이터 수집 방법에 대한 자세한 설명

RSS와 크롤러, 데이터 수집 방법에 대한 자세한 설명

- Y2J원래의

- 2017-04-24 16:41:003748검색

요약: 데이터의 가치를 마이닝하려면 먼저 수집, 저장, 분석, 계산 등의 과정을 거쳐야 합니다. 포괄적이고 정확한 데이터를 얻는 것이 데이터 가치 마이닝의 기초입니다. 이번 CSDN 클라우드컴퓨팅클럽 '빅데이터 스토리'는 가장 일반적인 데이터 수집 방식인 RSS와 검색엔진 크롤러부터 시작하겠습니다.

12월 30일 3W Coffee에서 CSDN Cloud Computing Club 행사가 "RSS와 크롤러: 빅 데이터 이야기 - 데이터 수집 방법에서 시작하다"라는 주제로 열렸습니다. 데이터의 가치를 마이닝하기 위해서는 먼저 수집, 저장, 분석, 계산 등의 과정을 거쳐야 합니다. 포괄적이고 정확한 데이터를 얻는 것이 데이터 가치 마이닝의 기초입니다. 아마도 현재의 데이터가 기업이나 조직에 실질적인 가치를 가져다줄 수는 없을지 모르지만, 안목이 있는 의사결정자라면 중요한 데이터를 최대한 빨리 수집하고 저장해야 한다는 점을 깨달아야 합니다. 이번 '빅데이터 스토리'는 가장 일반적인 데이터 수집 방식인 RSS와 검색엔진 크롤러부터 시작합니다.

만석으로 가득 찬 행사장

먼저, Beijing Wanfang Software Co., Ltd. 도서관 부문 총책임자 Cui Kejun, "과학 연구에서 대규모 RSS 구현 초기 응용 프로그램 및 웹 사이트 다운로드"라는 주제를 공유했습니다. Cui Kejun은 12년 동안 도서관 및 정보 산업에 종사했으며 데이터 수집 분야에서 풍부한 경험을 갖고 있으며 주로 정보 수집의 중요한 방법인 RSS와 그 구현 기술을 공유했습니다.

RSS(Really Simple Syndication)는 블로그 게시물, 뉴스, 오디오 또는 비디오 발췌문과 같이 업데이트된 데이터를 자주 게시하는 웹사이트를 집계하는 데 사용되는 소스 형식 사양입니다. RSS 파일에는 전체 텍스트 또는 발췌된 텍스트와 함께 사용자가 구독하는 네트워크에서 발췌된 데이터 및 인증 메타데이터가 포함됩니다.

특정 산업과 밀접하게 관련된 수백 또는 수천 개의 RSS 시드를 집계하면 특정 산업의 최신 개발 상황을 빠르고 포괄적으로 이해할 수 있습니다. 웹사이트에서 전체 데이터를 다운로드하고 데이터 마이닝을 수행하면 업계에서 특정 주제의 개발 과정을 전체적으로 이해할 수 있습니다.

Beijing Wanfang Software Co., Ltd. 도서관 부서 총책임자 Cui Kejun

Cui Kejun은 과학 연구소에서 RSS의 역할을 소개했습니다. 고에너지 물리학을 예로 들면 과학 연구 기관에 적용됩니다. 고에너지 물리학 정보 모니터링은 연구실, 산업계, 국제협회, 각국의 과학 연구를 담당하는 정부 기관, 주요 종합 과학 출판물, 고에너지 물리학 실험 프로젝트 및 실험 시설 등 전 세계 고에너지 물리학 동료 기관을 대상으로 합니다. . 모니터링되는 정보 유형은 뉴스, 논문, 회의 보고서, 분석 및 리뷰, 사전 인쇄, 사례 연구, 멀티미디어, 서적, 채용 정보 등입니다.

고에너지 물리학 문헌 정보는 최첨단 오픈소스 콘텐츠 관리 시스템인 Drupal, 오픈소스 검색 기술인 Apache Solr, Google 직원이 개발한 PubSubHubbub 기술을 사용하여 뉴스를 실시간으로 구독하고 Amazon의 고에너지 물리학 세트를 구축하는 OpenSearch 정보 모니터링 시스템은 기존 RSS 구독 및 푸시와 다르며 모든 키워드, 카테고리 및 복합 조건을 사용하여 거의 실시간 정보 캡처 및 활성 뉴스 푸시를 실현합니다.

다음으로 Cui Kejun은 Drupal, Apache Solr, PubSubHubbub 및 OpenSearch와 같은 기술을 사용한 경험을 공유했습니다.

다음으로 Yisou Technology 검색 부서의 설계자이자 크롤러 팀 리더인 Ye Shunping은 "웹 검색 크롤러 적시성 시스템"이라는 제목으로 주요 목표, 아키텍처 및 다양한 하위 모듈을 포함하는 공유를 제공했습니다. 적시성 디자인 계획.

Ye Shunping, 건축가 겸 Yisou Technology 검색 부서 크롤링 팀장

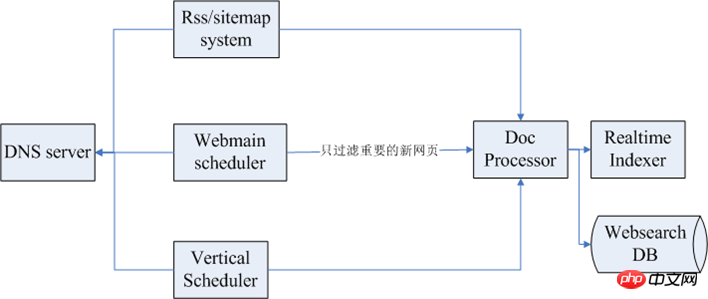

웹 크롤러의 몇 가지 목표는 높은 적용 범위입니다. 낮은 데드 링크 비율 우수한 효율성과 마찬가지로 크롤러 효율성 시스템의 목표도 유사하며 주로 새로운 웹 페이지를 신속하고 포괄적으로 포함시키는 것입니다. 다음 그림은 타임라인 시스템의 전체 아키텍처를 보여줍니다.

그 중 위의 첫 번째는 RSS/사이트맵 하위 시스템이고 다음은 웹메인 스케줄러이며, 웹 페이지 크롤링을 위한 예약 시스템, 그리고 적시 모듈 수직 스케줄러. 크롤링할 때 일반적으로 수십 또는 수백 개의 크롤링 클러스터가 있습니다. 상대적으로 크기 때문에 일반적으로 글로벌 서비스를 제공하는 DNS 서비스 모듈이 있습니다. 데이터가 캡처된 후 일반적으로 후속 데이터 처리가 수행됩니다.

효과성과 관련된 모듈은 다음과 같습니다.

RSS/사이트맵 시스템: 적시성 시스템에 의해 RSS/사이트맵을 사용하는 프로세스는 시드 채굴, 정기적인 크롤링 및 링크 해제 시간 분석입니다. 최신 웹페이지를 먼저 크롤링하고 색인을 생성하세요.

팬 크롤링 시스템: 팬 크롤링 시스템을 잘 설계하면 시간에 민감한 웹페이지의 높은 적용 범위를 개선하는 데 도움이 되지만 팬 크롤링은 일정 주기를 최대한 단축해야 합니다.

시드 스케줄링 시스템: 주로 시간에 민감한 시드 라이브러리입니다. 이 시드 라이브러리에는 몇 가지 정보가 있습니다. 스케줄링 시스템은 데이터베이스를 지속적으로 스캔한 다음 클러스터가 크롤링된 후 이를 크롤링 클러스터로 보냅니다. 일부 링크를 추출한 후 카테고리별로 전송하면 각 수직 채널이 적시에 데이터를 얻습니다.

시드 마이닝: 페이지 구문 분석 또는 기타 마이닝 방법이 포함되며, 이는 사이트 맵 및 탐색 모음을 통해 구성할 수 있으며 페이지 구조적 특성 및 페이지 변경 규칙을 기반으로 합니다.

시드 업데이트 메커니즘: 각 시드의 크롤링 기록을 기록하고, 링크 정보를 따르고, 시드의 외부 링크 특성을 기반으로 시드의 업데이트 주기를 정기적으로 업데이트하고, 시드의 업데이트 주기를 다시 계산합니다.

크롤링 시스템 및 JavaScript 구문 분석: 브라우저를 사용하여 브라우저 크롤링을 기반으로 크롤링 클러스터를 크롤링하고 구축합니다. 또는 Qtwebkit과 같은 오픈 소스 프로젝트를 채택하십시오.

위 내용은 RSS와 크롤러, 데이터 수집 방법에 대한 자세한 설명의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!