Black Forest Labs의 최근 출시 된 플럭스 모델은 인상적인 이미지 생성 기능으로 인기를 얻었습니다. 그러나 크기는 처음에 표준 소비자 하드웨어에서의 사용을 방해하지 않았습니다. 이 제한은 로컬 모델로드를 피하기 위해 API 서비스의 사용을 자극했습니다. 그러나 GPU 요구 사항으로 인해 온 프레미스 배포는 비용이 많이 들었습니다. 다행스럽게도, Hugging Face의 Diffusers Library는 이제 Bitsandbytes를 통한 양자화를 지원하므로 8GB의 GPU RAM이있는 기계에서 플럭스 추론이 가능합니다.

학습 목표 :

- Colab 환경에서 플럭스 사용에 대한 종속성을 구성하십시오.

- 메모리 효율을 위해 4 비트 양자화 된 텍스트 인코더를 사용하여 텍스트 프롬프트를 인코딩합니다.

- 혼합 정밀도로 이미지 생성 모델을로드 및 실행하기위한 메모리 절약 기술을 구현하십시오.

- Colab의 Flux 파이프 라인을 사용하여 텍스트 프롬프트에서 이미지를 생성합니다.

이 기사는 Data Science Blogathon의 일부입니다.

목차 :

- 학습 목표

- 플럭스 란 무엇입니까?

- 양자화가 중요한 이유는 무엇입니까?

- 비트 산비 테스를 사용한 양자화

- Bitsandbytes는 어떻게 작동합니까?

- 소비자 하드웨어에서 플럭스 실행

- 1 단계 : 환경 설정

- 2 단계 : GPU 메모리 관리

- 3 단계 : 4 비트 T5 텍스트 인코더로드

- 4 단계 : 텍스트 임베딩 생성

- 5 단계 : 4 비트 변압기 및 VAE 로딩

- 6 단계 : 이미지 생성

- 기기 이미지 생성의 미래

- 결론

- 주요 테이크 아웃

- 자주 묻는 질문

플럭스 란 무엇입니까?

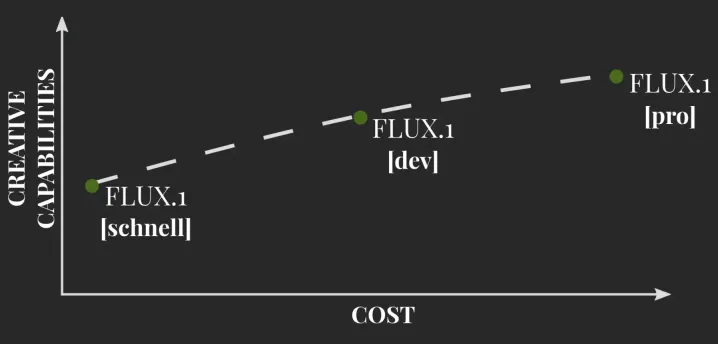

Black Forest Labs (안정적인 확산의 제작자)가 개발 한 Flux는 텍스트-이미지 모델에서 중요한 발전을 나타냅니다. 안정적인 확산을 바탕으로 성능과 출력 품질을 향상시킵니다. 처음에는 리소스 집약적 인 반면 최적화는 소비자 하드웨어에서 효율적인 실행을 허용합니다. 이 기사는 양자화가 플럭스의 접근성을 향상시키는 방법을 보여줍니다. 아래 이미지는 창의적 잠재력과 계산 비용 사이의 상충 관계를 보여줍니다.

Flux는 몇 가지 주요 아키텍처 구성 요소를 자랑합니다.

- 두 개의 미리 훈련 된 텍스트 인코더 (클립 및 T5) : 이 인코더는 텍스트 프롬프트 이해와 이미지로 변환을 향상시킵니다.

- 트랜스포머 기반 DIT 모델 : 이 비난 백본은 효율성과 정확성을 위해 변압기를 활용합니다.

- VAE (Variational Auto-Encoder) : 잠복 공간에서 처리하면 이미지 품질을 유지하면서 계산 요구를 줄입니다.

Flux는 Flux-Schnell (Open-Source), Flux-DEV (보다 제한적인 라이센스가있는 Open) 및 Flux-Pro (폐쇄 소스, API-Accessible)의 여러 버전으로 제공됩니다.

양자화가 중요한 이유는 무엇입니까?

비트가 적은 비트를 사용하여 매개 변수를 저장하여 모델 크기를 줄이는 기술인 양자화는 제한된 하드웨어에서 대형 모델을 실행하는 데 중요합니다. 이미지 생성에서는 덜 일반적이지만 실질적인 성능 손실없이 메모리 발자국을 크게 줄입니다. 신경망 매개 변수는 일반적으로 32 비트로 저장되지만 양자화는 이것을 4 비트로 줄일 수 있습니다.

비트 산비 테스를 사용한 양자화

Bitsandbytes 라이브러리는 Pytorch에 대한 효율적인 K- 비트 양자화를 가능하게합니다. 디퓨저 라이브러리에 통합하면 8GB GPU에서 플럭스가 실행 가능합니다.

Bitsandbytes는 어떻게 작동합니까?

Bitsandbytes는 8 및 4 비트 정밀도로 정량화됩니다. 8 비트 양자화는 특보를 다르게 처리하여 성능 저하를 최소화합니다. 4 비트 양자화는 추가로 미세 조정을 위해 Qlora와 함께 사용되는 모델을 추가로 압축합니다.

소비자 하드웨어에서 플럭스 실행

1 단계 : 환경 설정

GPU 지원 환경 (예 : Nvidia T4/L4 또는 Google Colab)을 확인하십시오. 필요한 패키지 설치 :

! pip install -uq git https://github.com/huggingface/diffusers@main ! pip install -uq git https://github.com/huggingface/transformers@main ! pip install -uq bitsandbytes

수입 종속성 :

디퓨저 가져 오기 수입 변압기 Bitsandbytes를 Bnb로 가져옵니다 디퓨저에서 FluxPipeline, FluxTransformer2DModel을 가져옵니다 변압기에서 t5encodermodel을 가져옵니다 토치 수입 GC 가져 오기

2 단계 : GPU 메모리 관리

모델로드간에 GPU 메모리를 지우는 기능을 정의하십시오.

def flush () :

gc.collect ()

Torch.cuda.empty_cache ()

Torch.cuda.reset_max_memory_allocated ()

Torch.cuda.reset_peak_memory_stats ()

플러시()

3 단계 : 4 비트 T5 텍스트 인코더로드

4 비트 양자화를 사용하여 T5 인코더를로드하십시오.

ckpt_id = "Black-Forest-Labs/Flux.1-dev"

CKPT_4BIT_ID = "HF-Internal-Testing/Flux.1-dev-nf4-pkg"

프롬프트 = "파리의 귀여운 개 사진 촬영"

text_encoder_2_4bit = t5encodermodel.from_pretraind (

ckpt_4bit_id,

subfolder = "text_encoder_2",

))

4 단계 : 텍스트 임베딩 생성

양자화 된 인코더를 사용하여 프롬프트를 인코딩합니다.

파이프 라인 = fluxpipeline.from_pretrained (

"블랙 포스트 랩/플럭스 .1-dev",

text_encoder_2 = text_encoder_2_4bit,

변압기 = 없음,

vae = 없음,

Torch_dtype = Torch.float16,

))

Torch.no_grad ()로 :

prompt_embeds, pooled_prompt_embeds, text_ids = pipeline.encode_prompt (

프롬프트 = 프롬프트, 프롬프트 _2 = 없음, max_Sequence_length = 256

))

델 파이프 라인

플러시()

5 단계 : 4 비트 변압기 및 VAE 로딩

4 비트 모드로 변압기와 VAE를로드하십시오.

Transformer_4bit = fluxtransformer2dmodel.from_pretrained (ckpt_4bit_id, subfolder = "Transformer")

파이프 라인 = fluxpipeline.from_pretrained (

ckpt_id,

text_encoder = 없음,

text_encoder_2 = 없음,

Tokenizer = 없음,

Tokenizer_2 = 없음,

Transformer = Transformer_4bit,

Torch_dtype = Torch.float16,

))

pipeline.enable_model_cpu_offload ()

6 단계 : 이미지 생성

이미지 생성 :

Print ( "Denoising 실행.")

높이, 너비 = 512, 768

이미지 = 파이프 라인 (

promp_embeds = prompt_embeds,

pooled_prompt_embeds = pooled_prompt_embeds,

num_inference_steps = 50,

Guidance_Scale = 5.5,

높이 = 높이,

너비 = 너비,

output_type = "pil",

). 이미지

이미지 [0]

기기 이미지 생성의 미래

양자화 및 효율적인 모델 처리는 소비자 하드웨어에 강력한 AI를 가져와 고급 이미지 생성에 대한 액세스를 민주화합니다.

결론

양자화와 결합 된 플럭스는 8GB GPU에서 고품질 이미지 생성을 가능하게합니다. 이 발전은 더 많은 청중이 정교한 AI에 접근 할 수있게합니다.

주요 테이크 아웃 :

- 플럭스는 4 비트 양자화 및 혼합 정밀도를 사용하여 Colab에서 효율적으로 실행됩니다.

-

diffusers및transformers이미지 생성을 단순화합니다. - 효과적인 메모리 관리는 제한된 리소스에서 대규모 모델 실행을 가능하게합니다.

자주 묻는 질문 (원본과 동일하지만 더 나은 가독성을 위해 재구성)

Q1. 4 비트 양자화의 목적? 4 비트 양자화는 메모리 사용량을 줄여서 플럭스와 같은 대형 모델이 제한된 자원에서 효율적으로 실행될 수 있도록합니다.

Q2. 텍스트 프롬프트 변경? prompt 변수를 원하는 텍스트 설명으로 바꾸십시오.

Q3. 이미지 품질/스타일 조정? 파이프 라인 호출에서 num_inference_steps (품질) 및 guidance_scale (프롬프트 준수)을 조정하십시오.

Q4. Colab에서 메모리 오류 처리? GPU 사용, 4 비트 양자화 및 혼합 정밀도를 보장하십시오. num_inference_steps 를 낮추거나 CPU 오프 로딩을 사용하는 것을 고려하십시오.

Q5. 로컬로 스크립트를 실행합니까? 예, 그러나 충분한 GPU 리소스와 메모리를 보장하십시오.

위 내용은 8GB GPU RAM에서 플럭스 모델을 어떻게 실행합니까? - 분석 Vidhya의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

가장 많이 사용되는 10 개의 Power BI 차트 -Axaltics VidhyaApr 16, 2025 pm 12:05 PM

가장 많이 사용되는 10 개의 Power BI 차트 -Axaltics VidhyaApr 16, 2025 pm 12:05 PMMicrosoft Power BI 차트로 데이터 시각화의 힘을 활용 오늘날의 데이터 중심 세계에서는 복잡한 정보를 비 기술적 인 청중에게 효과적으로 전달하는 것이 중요합니다. 데이터 시각화는이 차이를 연결하여 원시 데이터를 변환합니다. i

AI의 전문가 시스템Apr 16, 2025 pm 12:00 PM

AI의 전문가 시스템Apr 16, 2025 pm 12:00 PM전문가 시스템 : AI의 의사 결정 능력에 대한 깊은 다이빙 의료 진단에서 재무 계획에 이르기까지 모든 것에 대한 전문가의 조언에 접근 할 수 있다고 상상해보십시오. 그것이 인공 지능 분야의 전문가 시스템의 힘입니다. 이 시스템은 프로를 모방합니다

최고의 바이브 코더 3 명이 코드 에서이 AI 혁명을 분해합니다.Apr 16, 2025 am 11:58 AM

최고의 바이브 코더 3 명이 코드 에서이 AI 혁명을 분해합니다.Apr 16, 2025 am 11:58 AM우선, 이것이 빠르게 일어나고 있음이 분명합니다. 다양한 회사들이 현재 AI가 작성한 코드의 비율에 대해 이야기하고 있으며 빠른 클립에서 증가하고 있습니다. 이미 주변에 많은 작업 변위가 있습니다

활주로 AI의 GEN-4 : AI Montage는 어떻게 부조리를 넘어갈 수 있습니까?Apr 16, 2025 am 11:45 AM

활주로 AI의 GEN-4 : AI Montage는 어떻게 부조리를 넘어갈 수 있습니까?Apr 16, 2025 am 11:45 AM디지털 마케팅에서 소셜 미디어에 이르기까지 모든 창의적 부문과 함께 영화 산업은 기술 교차로에 있습니다. 인공 지능이 시각적 스토리 텔링의 모든 측면을 재구성하고 엔터테인먼트의 풍경을 바꾸기 시작함에 따라

ISRO AI 무료 코스 5 일 동안 등록하는 방법은 무엇입니까? - 분석 VidhyaApr 16, 2025 am 11:43 AM

ISRO AI 무료 코스 5 일 동안 등록하는 방법은 무엇입니까? - 분석 VidhyaApr 16, 2025 am 11:43 AMISRO의 무료 AI/ML 온라인 코스 : 지리 공간 기술 혁신의 관문 IIRS (Indian Institute of Remote Sensing)를 통해 Indian Space Research Organization (ISRO)은 학생과 전문가에게 환상적인 기회를 제공하고 있습니다.

AI의 로컬 검색 알고리즘Apr 16, 2025 am 11:40 AM

AI의 로컬 검색 알고리즘Apr 16, 2025 am 11:40 AM로컬 검색 알고리즘 : 포괄적 인 가이드 대규모 이벤트를 계획하려면 효율적인 작업량 배포가 필요합니다. 전통적인 접근 방식이 실패하면 로컬 검색 알고리즘은 강력한 솔루션을 제공합니다. 이 기사는 언덕 등반과 Simul을 탐구합니다

Openai는 GPT-4.1로 초점을 이동하고 코딩 및 비용 효율성을 우선시합니다.Apr 16, 2025 am 11:37 AM

Openai는 GPT-4.1로 초점을 이동하고 코딩 및 비용 효율성을 우선시합니다.Apr 16, 2025 am 11:37 AM릴리스에는 GPT-4.1, GPT-4.1 MINI 및 GPT-4.1 NANO의 세 가지 모델이 포함되어 있으며, 대형 언어 모델 환경 내에서 작업 별 최적화로 이동합니다. 이 모델은 사용자를 향한 인터페이스를 즉시 대체하지 않습니다

프롬프트 : Chatgpt는 가짜 여권을 생성합니다Apr 16, 2025 am 11:35 AM

프롬프트 : Chatgpt는 가짜 여권을 생성합니다Apr 16, 2025 am 11:35 AMChip Giant Nvidia는 월요일에 AI SuperComputers를 제조하기 시작할 것이라고 말했다. 이 발표는 트럼프 SI 대통령 이후에 나온다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

PhpStorm 맥 버전

최신(2018.2.1) 전문 PHP 통합 개발 도구

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

WebStorm Mac 버전

유용한 JavaScript 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)