gemma 2b :

20 억 파라미터, 8192 토큰 컨텍스트 길이 및 디코더 전용 변압기 아키텍처가있는 Google 개발 모델. 교육 데이터에는 웹 문서, 코드 및 수학 텍스트가 포함됩니다.

-

llama 3.2 (1B & 3B) : Meta의 다국어 모델, 각각 123 억 및 32 억 파라미터의 버전을 제공합니다. 둘 다 컨텍스트 길이가 128,000 개의 토큰이며 다국어 대화에 최적화됩니다.

-

Qwen 7B : Alibaba Cloud의 모델은 70 억 개의 매개 변수와 8,192 개의 토큰 컨텍스트 길이를 특징으로합니다. 또한 디코더 전용 변압기 아키텍처를 사용합니다

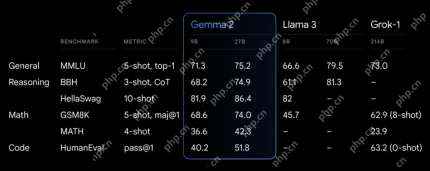

Google Colab 및 Ollama를 사용한 실제 데모는 구현 및 평가 프로세스를 보여줍니다. 이 기사에는 라이브러리 설치, Ollama 실행, 데이터 가져 오기 및 모델 호출과 관련된 단계가 자세히 설명되어 있습니다. 각 모델의 샘플 출력은 시각적으로 표시됩니다 엄격한 평가 프레임 워크가 설명되어 있으며, 다른 범주 (프로젝트, 회사, 사람)에서 엔티티 추출의 정확성에 중점을 둡니다. 비교 표는 각 모델의 성능을 요약하여 Gemma 2B를 전체적으로 가장 정확한 것으로 드러냅니다. 그러나 Llama 3.2 3B는 사람을 식별하는 데 강점을 보여줍니다. 결론은 엔티티 추출에서 SLM의 우수한 성능을 반복하여 상황에 대한 이해와 적응성의 중요성을 강조합니다. 이 기사는 SLM 및 논의 된 특정 모델에 대한 일반적인 질문을 다루는 FAQ 섹션으로 마무리됩니다. -

-

(참고 : 이미지 URL은 변경되지 않습니다. 원래의 의미와 구조를 보존하는 동안 기사의 핵심 내용은 역설되어 있습니다. 모델 성능을 요약 한 표도 유지됩니다.)

.

위 내용은 Gemma 2B vs llama 3.2 vs Qwen 7b의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Tesla의 Robovan은 2024 년 Robotaxi 티저의 숨겨진 보석이었습니다.Apr 22, 2025 am 11:48 AM

Tesla의 Robovan은 2024 년 Robotaxi 티저의 숨겨진 보석이었습니다.Apr 22, 2025 am 11:48 AM2008 년 이래로 저는 도시 교통의 미래로서 "Robotjitney"라고 불리는 공유 라이드 밴을 옹호했습니다. 나는이 차량들을 21 세기의 차세대 대중 교통 솔루션 인 Surpas로 예측합니다.

Sam 's Club은 영수증 수표를 제거하고 소매를 강화하기 위해 AI에 베팅합니다.Apr 22, 2025 am 11:29 AM

Sam 's Club은 영수증 수표를 제거하고 소매를 강화하기 위해 AI에 베팅합니다.Apr 22, 2025 am 11:29 AM체크 아웃 경험 혁명 Sam 's Club의 혁신적인 "Just Go"시스템은 기존 AI 기반 AI 기반 "Scan & Go"기술을 기반으로하여 회원이 쇼핑 중에 Sam's Club 앱을 통해 구매를 스캔 할 수 있습니다.

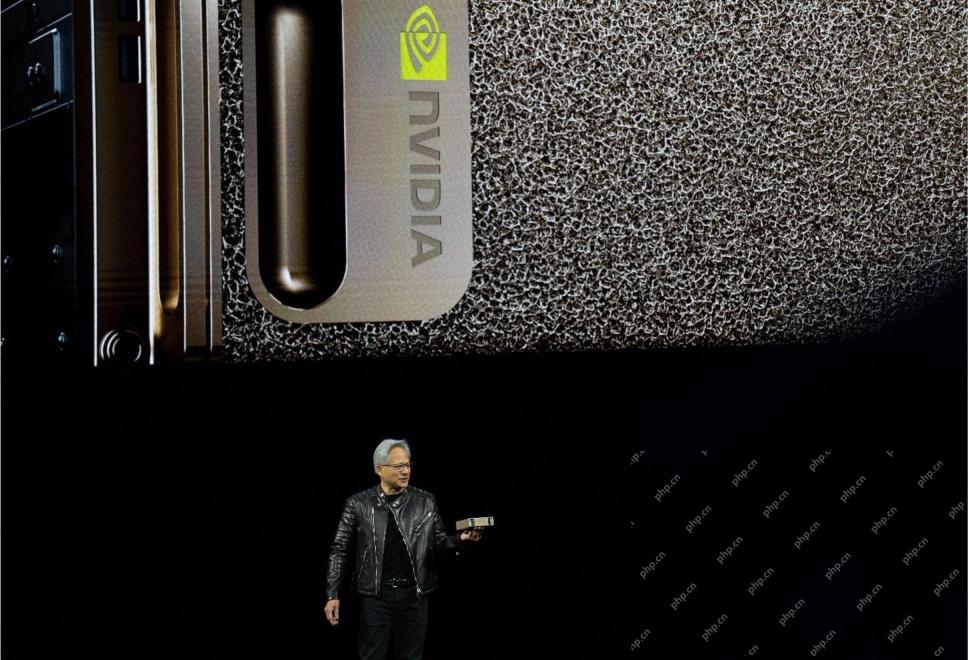

Nvidia의 AI Omniverse는 GTC 2025에서 확장됩니다Apr 22, 2025 am 11:28 AM

Nvidia의 AI Omniverse는 GTC 2025에서 확장됩니다Apr 22, 2025 am 11:28 AMGTC 2025에서 Nvidia의 향상된 예측 가능성 및 신제품 라인업 AI 인프라의 핵심 업체 인 Nvidia는 고객의 예측 가능성 증가에 중점을두고 있습니다. 여기에는 일관된 제품 제공, 성과 기대치 충족 및 충족이 포함됩니다

Google의 Gemma 2 모델의 기능을 탐색합니다Apr 22, 2025 am 11:26 AM

Google의 Gemma 2 모델의 기능을 탐색합니다Apr 22, 2025 am 11:26 AMGoogle의 Gemma 2 : 강력하고 효율적인 언어 모델 효율성과 성능으로 축하되는 Google의 Gemma Family of Language 모델은 Gemma 2의 도착으로 확장되었습니다.이 최신 릴리스는 두 가지 모델로 구성됩니다 : 27 억 매개 변수 Ver Ver

Genai의 다음 물결 : Kirk Borne 박사와의 관점 -Salystics VidhyaApr 22, 2025 am 11:21 AM

Genai의 다음 물결 : Kirk Borne 박사와의 관점 -Salystics VidhyaApr 22, 2025 am 11:21 AM이 데이터 에피소드와 함께이 선도에는 주요 데이터 과학자, 천체 물리학 자, TEDX 스피커 인 Kirk Borne 박사가 있습니다. Borne 박사는 빅 데이터, AI 및 머신 러닝 분야의 유명한 전문가 인 현재 상태와 미래의 Traje에 대한 귀중한 통찰력을 제공합니다.

주자와 운동 선수를위한 AI : 우리는 훌륭한 진전을 이루고 있습니다Apr 22, 2025 am 11:12 AM

주자와 운동 선수를위한 AI : 우리는 훌륭한 진전을 이루고 있습니다Apr 22, 2025 am 11:12 AM이 연설에는 인공 지능이 사람들의 신체 운동을 지원하는 데 왜 좋은지를 보여주는 공학에 대한 백 그라운드 정보가 매우 통찰력있는 관점이있었습니다. 스포츠에서 인공 지능 적용을 탐구하는 데 중요한 부분 인 세 가지 디자인 측면을 보여주기 위해 각 기고자의 관점에서 핵심 아이디어를 간략하게 설명 할 것입니다. 에지 장치 및 원시 개인 데이터 인공 지능에 대한이 아이디어에는 실제로 두 가지 구성 요소가 포함되어 있습니다. 하나는 우리가 큰 언어 모델을 배치하는 위치와 관련하여 하나의 구성 요소와 다른 하나는 인간 언어와 활력 징후가 실시간으로 측정 될 때“표현”하는 언어의 차이와 관련이 있습니다. Alexander Amini는 달리기와 테니스에 대해 많은 것을 알고 있지만 그는 여전히

Caterpillar의 기술, 인재 및 혁신에 관한 Jamie EngstromApr 22, 2025 am 11:10 AM

Caterpillar의 기술, 인재 및 혁신에 관한 Jamie EngstromApr 22, 2025 am 11:10 AMCaterpillar의 최고 정보 책임자이자 IT의 수석 부사장 인 Jamie Engstrom은 28 개국에서 2,200 명 이상의 IT 전문가로 구성된 글로벌 팀을 이끌고 있습니다. 현재 역할에서 4 년 반을 포함하여 Caterpillar에서 26 년 동안 Engst

새로운 Google 사진 업데이트는 Ultra HDR 품질로 모든 사진 팝을 만듭니다.Apr 22, 2025 am 11:09 AM

새로운 Google 사진 업데이트는 Ultra HDR 품질로 모든 사진 팝을 만듭니다.Apr 22, 2025 am 11:09 AMGoogle Photos의 새로운 Ultra HDR 도구 : 빠른 가이드 Google Photos의 새로운 Ultra HDR 도구로 사진을 향상시켜 표준 이미지를 활기차고 높은 동기 범위의 걸작으로 변환하십시오. 소셜 미디어에 이상적 이며이 도구는 모든 사진의 영향을 높이고

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

Dreamweaver Mac版

시각적 웹 개발 도구

PhpStorm 맥 버전

최신(2018.2.1) 전문 PHP 통합 개발 도구

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음