DeepSeek-R1의 고급 추론 능력으로 인해 생성 LLM 필드의 새로운 리더가되었습니다. 이로 인해 AI 업계에서 NVIDIA의 6 천억 달러의 손실이 시작된 보고서와 함께 AI 업계에서 저주를 받았습니다. 그러나 DeepSeek-R1이 밤새 유명한 이유는 무엇입니까? 이 기사에서는 DeepSeek-R1이 왜 그렇게 많은 관심을 끌고, 획기적인 기능을 탐구하고, 추론 권한이 실제 응용 프로그램을 어떻게 재구성하는지 분석하는 이유를 살펴 보겠습니다. 상세하고 구조화 된 분석을 통해 모델의 성능을 분류 할 때 계속 지켜봐 주시기 바랍니다.

학습 목표

DeepSeek-R1의 고급 추론 능력과 LLM 환경에 미치는 영향을 이해하십시오.

그룹 상대 정책 최적화 (GRPO)가 비평가 모델없이 강화 학습을 향상시키는 방법을 배우십시오.

훈련 및 성능 측면에서 DeepSeek-R1-Zero와 DeepSeek-R1의 차이점을 탐색하십시오.

추론 작업에서 DeepSeek-R1의 우수성을 보여주는 평가 지표 및 벤치 마크 분석.

DeepSeek-R1이 확장 가능한 고 처리량 AI 모델로 STEM 및 코딩 작업을 최적화하는 방법을 알아보십시오.

- 이 기사는 데이터 과학 블로그 톤의

- 의 일부로 출판되었습니다.

- Deepseek-R1은 무엇입니까? GRPO)의 그룹 상대 정책 최적화 (GRPO)

- DeepSeek-R1-Zero에서의 교육 프로세스 및 최적화

GRPO가 어떻게 작동합니까? 일반적인 권한을 높이는 방법은 무엇입니까? DeepSeek-r1 DeepSeek-r1의 평가 DeepSeek-R1-7B의 추론 능력 평가 고급 추론 및 문제 해결 시나리오

결론자주 묻는 질문

-

DeepSeek-R1은 무엇입니까? 간단한 말로 DeepSeek-R1은 2023 년 Liang Wenfeng이 설립 한 DeepSeek가 개발 한 최첨단 언어 모델 시리즈입니다. 강화 학습 (RL)을 통해 LLM에서 고급 추론 능력을 달성했습니다. 두 가지 변형이 있습니다 :

deepseek-r1-Zero

- .

우리는 MMLU, MMLU-PRO, GPQA DIAMOND 및 DEEPSEEK-R1과 같은 교육 지식 지식 벤치 마크가 DeepSeek-V3에 비해 더 나은 성능을 보인다는 것을 알 수 있습니다. STEM 관련 질문에서 주로 정확도가 향상되었습니다. DeepSeek-R1은 또한 형식 지침을 따르는 모델의 능력을 평가하도록 설계된 벤치 마크 데이터 인 if-Eval에 대한 훌륭한 결과를 제공합니다. 충분한 수학과 이론적 이해가 이루어졌으며, 이는 강화 학습에 대한 전반적인 지식과 DeepSeek-R1 모델 개발에 대한 최첨단 응용 프로그램을 크게 향상시키고 싶습니다. 이제 우리는 Ollama를 사용하여 Deepseek-R1에 손을 대고 새로 박하 LLM을 맛볼 것입니다. deepseek-7b 의 추론 능력 평가 DeepSeek-R1-7B의 평가는 강화 된 추론 기능, 특히 복잡한 문제 해결 시나리오에서의 성능에 중점을 둡니다. 주요 벤치 마크를 분석 함으로써이 평가는 모델이 이전 모델에 비해 복잡한 추론 작업을 얼마나 효과적으로 처리하는지에 대한 통찰력을 제공합니다. 우리가 달성하고 싶은 것 다른인지 영역에서 DeepSeek-R1의 추론 능력을 평가하십시오 특정 추론 작업에서 강점과 한계를 식별하십시오 모델의 잠재적 인 실제 응용 프로그램 를 이해하십시오 환경을 설정 ollama를 에서 설치하십시오 시스템에 설치 한 후 터미널을 열고 아래 명령을 입력하면 DeepSeek-R1 7B 모델을 다운로드하여 시작합니다. 이제 나는 ncert 에서 선형 불평등 질문을했습니다

Q.Solve 4x 3 & lt; 6x 7 및 응답은 다음과 같습니다 -

책에 따라 정확합니다. -

Amazing !!

이제 Llamaindex를 사용하여 테스트 환경을 설정하여 더욱 두드러진 방법이 될 것입니다. .

설정 테스트 환경 -

고급 추론 및 문제 해결 시나리오 이 섹션에서는 수학적 계산에서 윤리적 딜레마에 이르기까지 다양한 추론 기술에 대한 깊은 이해가 필요한 복잡한 문제 해결 작업을 탐구합니다. 이러한 시나리오에 참여함으로써 비판적으로 생각하고 데이터를 분석하며 다양한 상황에서 논리적 결론을 도출 할 수있는 능력을 향상시킬 수 있습니다. 수학적 문제 : 할인 및 로열티 카드 계산 매장은 모든 품목에 대해 20% 할인을 제공합니다. 할인을 신청 한 후 충성도 카드 회원에게는 추가로 10% 할인이 있습니다. 상품이 원래 $ 150의 경우 충성도 카드 회원의 최종 가격은 얼마입니까? 단계별 계산을 보여주고 추론을 설명하십시오.

출력 :이 프롬프트의 핵심 측면은 다음과 같습니다

순차적 계산 능력 백분율 개념 이해 단계별 추론 설명의 명확성. 논리적 추론 : 진술의 모순 식별 이 진술을 고려하십시오. 모순이있는 경우 논리적 추론을 사용하여 해결하는 방법을 설명하십시오. import numpy as np import matplotlib.pyplot as plt from scipy.stats import entropy

출력 :

이것은 논리적 일관성을 나타내고, 논리적 솔루션을 제안하고, 계급 관계를 이해하고, 음절 추론을 보여줄 것입니다. 인과 체인 분석 : 늑대에 대한 질병의 생태계 영향 산림 생태계에서 질병은 늑대 인구의 80%를 사망합니다. 향후 5 년간 생태계에 미칠 수있는 잠재적 인 영향 사슬을 설명하십시오. 최소한 세 가지 수준의 원인과 결과를 포함시키고 각 단계에 대한 추론을 설명하십시오. .

출력 :

출력 : 이 프롬프트 모델은 복잡한 시스템에 대한 이해를 보여주고 여러 캐주얼 체인을 추적하며 간접 효과를 고려하며 도메인 지식을 적용합니다. <:> 패턴 인식 : 숫자 시퀀스를 식별하고 설명 이 시퀀스를 고려하십시오 : 2, 6, 12, 20, 30, __ 다음 번호는 무엇입니까? -

패턴을 설명하십시오

-

n 번째 항에 대한 공식을 만듭니다 - 출력 :

모델은 수치 패턴을 식별하고, 수학 공식을 생성하고, 추론 과정을 설명하고, 솔루션을 확인하는 데 탁월합니다.<:> 확률 문제 : 대리석으로 확률을 계산합니다 가방에는 3 개의 빨간 구슬, 4 개의 파란색 구슬 및 5 개의 녹색 구슬이 들어 있습니다. 교체하지 않고 두 개의 대리석을 그립니다 두 개의 파란색 대리석을 그릴 확률은 얼마입니까? 다른 색상의 대리석을 그리는 확률은 얼마입니까?

출력 :모든 계산을 보여주고 접근 방식을 설명하십시오. 모델은 확률을 계산하고 조건부 문제를 처리하며 확률 적 추론을 설명 할 수 있습니다. <:> 디버깅 : 코드 및 해당 솔루션의 논리적 오류 이 코드는 올바르게 실행되는 것을 방지하는 논리적 오류가 있습니다. -

-

추천을 정당화하십시오.

출력 : -

그것은 큰 반응입니다. 나는 추론 과정을 좋아했습니다. 여러 요소를 분석하고 컨텍스트를 고려하고, 좋은 권장 사항을 만들고, 경쟁 우선 순위를 균형을 유지합니다. .

> 윤리적 딜레마 : 자율 주행 차에서의 의사 결정 -

자율 주행 차는 스플릿 초 결정을 내려야합니다

<:> swerve 왼쪽 : 두 명의 보행자를 때리십시오

<:> 오른쪽 : 벽을 때리고 승객을 심각하게 다치게하십시오 - . 시계열 분석

- 출력 :

- q 3. 이러한 평가 방법은 얼마나 신뢰할 수 있습니까? Human-> Prompt-> ai-> response-> human-> 실제 응답 이 기사에 나와있는 미디어는 Analytics Vidhya가 소유하지 않으며 저자의 재량에 따라 사용됩니다.

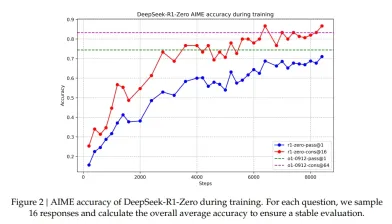

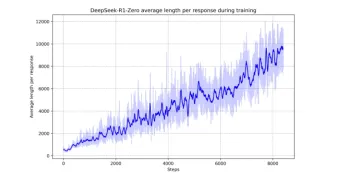

Aime DataSet 에서 DeepSeek-R1-Zero의 정확도 플롯

.

.

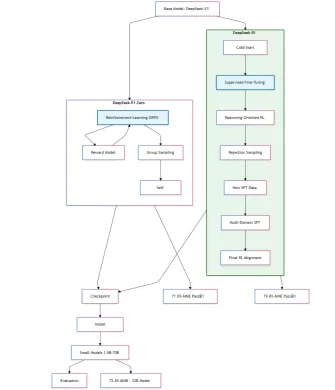

임시 Deepseek-r1-Zero 및 R1 훈련 다이어그램

가독성

출력 :

.

이 기사에서 사용 된 모든 코드가 여기에 있습니다.

.

각 질문 Q에 대해 GRPO는 이전 정책에서 출력 그룹 {O1, O2, O2 ..} 아래의 목표를 극대화하여 정책 모델을 최적화합니다.

우위 계산

우위 계산 출력에 대한 보상이 그룹의 모든 출력에 대한 보상입니다.

.

우리의 p와 q는 가우시안과 같은 가우스 분포로 각각 가우시안 유통입니다.

사용자는 질문을하고 모델이나 조수는 먼저 추론 과정에 대해 생각한 다음 사용자에게 응답함으로써이를 해결합니다.

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import entropy

: 제로 모델의 주요 제한은 내용이 읽기에 적합하지 않다는 것입니다. 응답은 많은 언어와 혼합되어 있으며 사용자를위한 답변을 강조하기 위해 잘 형식화되지 않았습니다.

: 제로 모델의 주요 제한은 내용이 읽기에 적합하지 않다는 것입니다. 응답은 많은 언어와 혼합되어 있으며 사용자를위한 답변을 강조하기 위해 잘 형식화되지 않았습니다.

<_> 여기서, P_I는 I-TH 응답의 정확성을 나타냅니다. 연구 논문에 따르면이 방법은보다 안정적인 성능 추정치를 보장합니다.

출력은 매우 길어서이 블로그의 출력이 요약되어 전체 출력을 위해 블로그의 코드 리포지토리를 여기에서 볼 수 있어야합니다.

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import entropy

전기 자동차와 전통적인 휘발유 차량을 비교 :

편의성 # Define two probability distributions P and Q

x = np.linspace(-3, 3, 100)

P = np.exp(-(x**2)) # Gaussian-like distribution

Q = np.exp(-((x - 1) ** 2)) # Shifted Gaussian

# Normalize to ensure they sum to 1

P /= P.sum()

Q /= Q.sum()

# Compute KL divergence

kl_div = entropy(P, Q)

각 요인에 대해 구체적인 예와 데이터 포인트를 제공하십시오. 그런 다음 어떤 자동차 유형의 자동차가 더 나은지 설명하십시오 :

<:> 오른쪽 : 벽을 때리고 승객을 심각하게 다치게하십시오 plt.style.use("ggplot")

plt.figure(figsize=(12, 8))

plt.plot(x, P, label="P (Original)", line, color="blue")

plt.plot(x, Q, label="Q (Shifted)", line, color="red")

plt.fill_between(x, P, Q, color="yellow", alpha=0.3, label="Difference")

plt.title(f"KL Divergence: {kl_div:.4f}")

plt.xlabel("x")

plt.ylabel("Probability Density")

plt.legend()

plt.show()

출력 :

출력 :  이러한 유형의 문제는 생성 AI 모델에 가장 문제가됩니다. 그것은 윤리적 추론, 다중 관점, 도덕적 딜레마 및 가치 판단을 테스트합니다. 전반적으로, 그것은 하나였습니다. 나는 더 윤리적 인 영역 별 미세 조정이 더 심오한 반응을 일으킬 것이라고 생각합니다.

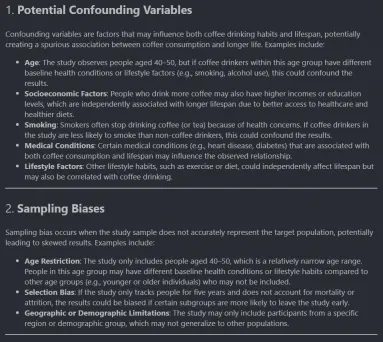

이러한 유형의 문제는 생성 AI 모델에 가장 문제가됩니다. 그것은 윤리적 추론, 다중 관점, 도덕적 딜레마 및 가치 판단을 테스트합니다. 전반적으로, 그것은 하나였습니다. 나는 더 윤리적 인 영역 별 미세 조정이 더 심오한 반응을 일으킬 것이라고 생각합니다. 연구에 따르면 커피를 마시는 사람은 비 관찰자보다 더 오래 살고 있다고 주장합니다. 이 연구는 5 년 동안 40-50 세의 1000 명을 관찰했습니다.

식별 :

출력 : import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import entropy

결론

DeepSeek-R1은 다양한 추론 작업에 걸쳐 유망한 기능을 보여 주며, 구조화 된 논리 분석, 단계별 문제 해결, 다중 컨텍스트 이해 및 다양한 주제의 지식 축적에서 고급 추론 기능을 보여줍니다. 그러나 복잡한 시간적 추론, 깊은 모호성 처리 및 창의적인 솔루션 생성과 같은 개선 영역이 있습니다. 가장 중요한 것은 GPU의 엄청난 훈련 비용의 부담없이 DeepSeek-R1과 같은 모델이 어떻게 개발 될 수 있는지 보여줍니다.

강점에도 불구하고 DeepSeek R1의 고급 추론 능력은 여전히 복잡한 시간적 추론 및 모호성 취급과 같은 영역에서 여전히 도전에 직면하여 향후 개선을위한 문을 열어줍니다.

q 1. DeepSeek-R1-7B는 추론 작업의 대형 모델과 어떻게 비교됩니까?

위 내용은 Deepseek R1 '의 고급 추론 능력 디코딩의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Let 's Dance : 인간 신경 그물을 미세 조정하기위한 구조화 된 움직임Apr 27, 2025 am 11:09 AM

Let 's Dance : 인간 신경 그물을 미세 조정하기위한 구조화 된 움직임Apr 27, 2025 am 11:09 AM과학자들은 C. el 그러나 중요한 질문이 발생합니다. 새로운 AI S와 함께 효과적으로 작동하도록 우리 자신의 신경망을 어떻게 조정합니까?

새로운 Google 유출은 Gemini AI의 구독 변경을 보여줍니다Apr 27, 2025 am 11:08 AM

새로운 Google 유출은 Gemini AI의 구독 변경을 보여줍니다Apr 27, 2025 am 11:08 AMGoogle의 Gemini Advanced : 수평선의 새로운 가입 계층 현재 Gemini Advanced에 액세스하려면 $ 19.99/월 Google One AI Premium Plan이 필요합니다. 그러나 Android Authority 보고서는 다가오는 변경 사항을 암시합니다. 최신 Google p. 내 코드

데이터 분석 가속이 AI의 숨겨진 병목 현상을 해결하는 방법Apr 27, 2025 am 11:07 AM

데이터 분석 가속이 AI의 숨겨진 병목 현상을 해결하는 방법Apr 27, 2025 am 11:07 AM고급 AI 기능을 둘러싼 과대 광고에도 불구하고 Enterprise AI 배포 내에서 상당한 도전 과제 : 데이터 처리 병목 현상. CEO는 AI 발전을 축하하는 동안 엔지니어는 느린 쿼리 시간, 과부하 파이프 라인,

Markitdown MCP는 모든 문서를 Markdowns로 변환 할 수 있습니다!Apr 27, 2025 am 09:47 AM

Markitdown MCP는 모든 문서를 Markdowns로 변환 할 수 있습니다!Apr 27, 2025 am 09:47 AM문서 처리는 더 이상 AI 프로젝트에서 파일을 여는 것이 아니라 혼돈을 명확하게 전환하는 것입니다. PDF, PowerPoint 및 Word와 같은 문서는 모든 모양과 크기로 워크 플로우를 범람합니다. 구조화 된 검색

빌딩 에이전트에 Google ADK를 사용하는 방법은 무엇입니까? - 분석 VidhyaApr 27, 2025 am 09:42 AM

빌딩 에이전트에 Google ADK를 사용하는 방법은 무엇입니까? - 분석 VidhyaApr 27, 2025 am 09:42 AMGoogle의 에이전트 개발 키트 (ADK)의 전력을 활용하여 실제 기능을 갖춘 지능형 에이전트를 만듭니다! 이 튜토리얼은 Gemini 및 GPT와 같은 다양한 언어 모델을 지원하는 ADK를 사용하여 대화 에이전트를 구축하는 것을 안내합니다. w

효과적인 문제 해결을 위해 LLM을 통해 SLM 사용 - 분석 VidhyaApr 27, 2025 am 09:27 AM

효과적인 문제 해결을 위해 LLM을 통해 SLM 사용 - 분석 VidhyaApr 27, 2025 am 09:27 AM요약: SLM (Small Language Model)은 효율성을 위해 설계되었습니다. 자원 결핍, 실시간 및 개인 정보 보호 환경에서 LLM (Large Language Model)보다 낫습니다. 초점 기반 작업, 특히 도메인 특이성, 제어 성 및 해석 성이 일반적인 지식이나 창의성보다 더 중요합니다. SLM은 LLM을 대체하지는 않지만 정밀, 속도 및 비용 효율성이 중요 할 때 이상적입니다. 기술은 더 적은 자원으로 더 많은 것을 달성하는 데 도움이됩니다. 그것은 항상 운전자가 아니라 프로모터였습니다. 증기 엔진 시대부터 인터넷 버블 시대에 이르기까지 기술의 힘은 문제를 해결하는 데 도움이되는 정도입니다. 인공 지능 (AI) 및보다 최근에 생성 AI가 예외는 아닙니다.

컴퓨터 비전 작업에 Google Gemini 모델을 사용하는 방법은 무엇입니까? - 분석 VidhyaApr 27, 2025 am 09:26 AM

컴퓨터 비전 작업에 Google Gemini 모델을 사용하는 방법은 무엇입니까? - 분석 VidhyaApr 27, 2025 am 09:26 AM컴퓨터 비전을위한 Google Gemini의 힘을 활용 : 포괄적 인 가이드 주요 AI 챗봇 인 Google Gemini는 강력한 컴퓨터 비전 기능을 포괄하기 위해 대화를 넘어서 기능을 확장합니다. 이 안내서는 사용 방법에 대해 자세히 설명합니다

Gemini 2.0 Flash vs O4-Mini : Google은 OpenAi보다 더 잘할 수 있습니까?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini : Google은 OpenAi보다 더 잘할 수 있습니까?Apr 27, 2025 am 09:20 AM2025 년의 AI 환경은 Google의 Gemini 2.0 Flash와 Openai의 O4-Mini가 도착하면서 전기가 전환됩니다. 이 최첨단 모델은 몇 주 간격으로 발사되어 비슷한 고급 기능과 인상적인 벤치 마크 점수를 자랑합니다. 이 심층적 인 비교

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

ZendStudio 13.5.1 맥

강력한 PHP 통합 개발 환경

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

DVWA

DVWA(Damn Vulnerable Web App)는 매우 취약한 PHP/MySQL 웹 애플리케이션입니다. 주요 목표는 보안 전문가가 법적 환경에서 자신의 기술과 도구를 테스트하고, 웹 개발자가 웹 응용 프로그램 보안 프로세스를 더 잘 이해할 수 있도록 돕고, 교사/학생이 교실 환경 웹 응용 프로그램에서 가르치고 배울 수 있도록 돕는 것입니다. 보안. DVWA의 목표는 다양한 난이도의 간단하고 간단한 인터페이스를 통해 가장 일반적인 웹 취약점 중 일부를 연습하는 것입니다. 이 소프트웨어는

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

출력 :

출력 :