olmo 2 : 액세스 가능한 AI

를위한 강력한 오픈 소스 LLM

- Gradio와 Langchain을 사용하여 Locally Olmo 2를 실행하는 법을 배우십시오.

Python 코드 예제와 함께 Olmo 2를 사용하여 챗봇 응용 프로그램을 구축하십시오.

- 결론

자주 묻는 질문 - 오픈 소스 llms에 대한 수요

- olmo-2 (7b 및 13b)는 이전의 OLMO 모델에 비해 현저한 개선을 보여 주어 건축, 데이터 또는 훈련 방법론의 발전을 나타냅니다. MAP-Neo-7B와 경쟁 : olmo-2, 특히 13B 버전은 완전 개방형 모델들 사이의 강력한 기준 인 MAP-Neo-7B와 비교할 수있는 점수를 달성합니다.

- Olmo 2의 훈련 방법론

-

Olmo-2는 완전히 개방형 모델이므로 모델 개방성의 다른 수준 간의 차이점을 명확히 해 보겠습니다. 오픈-가이트 모델 : 모델 가중치 만 해제됩니다

부분적으로 열린 모델 : - 는 가중치를 넘어서 몇 가지 추가 정보를 릴리스하지만 훈련 과정의 완전한 그림은 아닙니다. >. 완전히 열린 모델 : 가중치, 교육 데이터, 코드, 레시피 및 체크 포인트를 포함한 완전한 투명성을 제공합니다. 이것은 완전한 재현성을 허용합니다.

(이 기사는 데이터 과학 블로그의 일부입니다.) 목차 :

이해를 이해합니다

olmo 2는 전임자 Olmo-0424를 크게 향상시킵니다. 7b 및 13b 매개 변수 모델은 영어 학문 벤치 마크에서 LLAMA 3.1과 같은 오픈 웨이트 모델과 비슷한 완전 개방형 모델과 비슷하거나 초과하는 성능을 보여줍니다.

정제 및 전문화 : 는 Dolmino-Mix-1124 데이터 세트, 고품질 웹 데이터 및 도메인 별 데이터 (Academic Content, Q & A 포럼, 지시 데이터, 수학 워크 북)의 큐 레이트 된 혼합 인 Dolmino-Mix-1124 데이터 세트를 사용하여 모델의 지식과 기술을 정찰합니다. "모델 스프링"은 최종 체크 포인트를 더욱 향상시킵니다

olmo 2를 탐험하고 실행하는 것은 입니다

olmo 2는 쉽게 접근 할 수 있습니다. 교육 코드 및 평가 지표와 함께 모델 및 데이터 다운로드 지침을 사용할 수 있습니다. Olmo 2를 로컬로 운영하려면 Ollama를 사용하십시오. 설치 후 명령 줄에서 를 실행하십시오. 필요한 라이브러리 (Langchain 및 Gradio)는 PIP를 통해 설치할 수 있습니다.

로 챗봇 구축

자주 묻는 질문 (FAQS) (원래 기사의 FAQ는 여기에 포함되어 있습니다.)

실질적인 성능 이득 :

Olmo 2의 아키텍처는 원래 Olmo를 기반으로하며 안정성과 성능 향상을위한 개선을 통합합니다. 훈련 과정은 두 단계로 구성되어 있습니다 :  재단 교육 :

재단 교육 :

ollama run olmo2:7b

이 코드는 기본 챗봇 인터페이스를 제공합니다. 이 기초에보다 정교한 응용 프로그램을 구축 할 수 있습니다. 예제 출력 및 프롬프트는 원본 기사에 나와 있습니다. import gradio as gr

from langchain_core.prompts import ChatPromptTemplate

from langchain_ollama.llms import OllamaLLM

def generate_response(history, question):

template = """Question: {question}

Answer: Let's think step by step."""

prompt = ChatPromptTemplate.from_template(template)

model = OllamaLLM(model="olmo2")

chain = prompt | model

answer = chain.invoke({"question": question})

history.append({"role": "user", "content": question})

history.append({"role": "assistant", "content": answer})

return history

with gr.Blocks() as iface:

chatbot = gr.Chatbot(type='messages')

with gr.Row():

with gr.Column():

txt = gr.Textbox(show_label=False, placeholder="Type your question here...")

txt.submit(generate_response, [chatbot, txt], chatbot)

iface.launch()  (참고 : 이미지 URL은 변하지 않습니다.)

(참고 : 이미지 URL은 변하지 않습니다.)

위 내용은 Gradio 및 Langchain과 함께 Olmo-2를 로컬로 운영합니다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Tesla의 Robovan은 2024 년 Robotaxi 티저의 숨겨진 보석이었습니다.Apr 22, 2025 am 11:48 AM

Tesla의 Robovan은 2024 년 Robotaxi 티저의 숨겨진 보석이었습니다.Apr 22, 2025 am 11:48 AM2008 년 이래로 저는 도시 교통의 미래로서 "Robotjitney"라고 불리는 공유 라이드 밴을 옹호했습니다. 나는이 차량들을 21 세기의 차세대 대중 교통 솔루션 인 Surpas로 예측합니다.

Sam 's Club은 영수증 수표를 제거하고 소매를 강화하기 위해 AI에 베팅합니다.Apr 22, 2025 am 11:29 AM

Sam 's Club은 영수증 수표를 제거하고 소매를 강화하기 위해 AI에 베팅합니다.Apr 22, 2025 am 11:29 AM체크 아웃 경험 혁명 Sam 's Club의 혁신적인 "Just Go"시스템은 기존 AI 기반 AI 기반 "Scan & Go"기술을 기반으로하여 회원이 쇼핑 중에 Sam's Club 앱을 통해 구매를 스캔 할 수 있습니다.

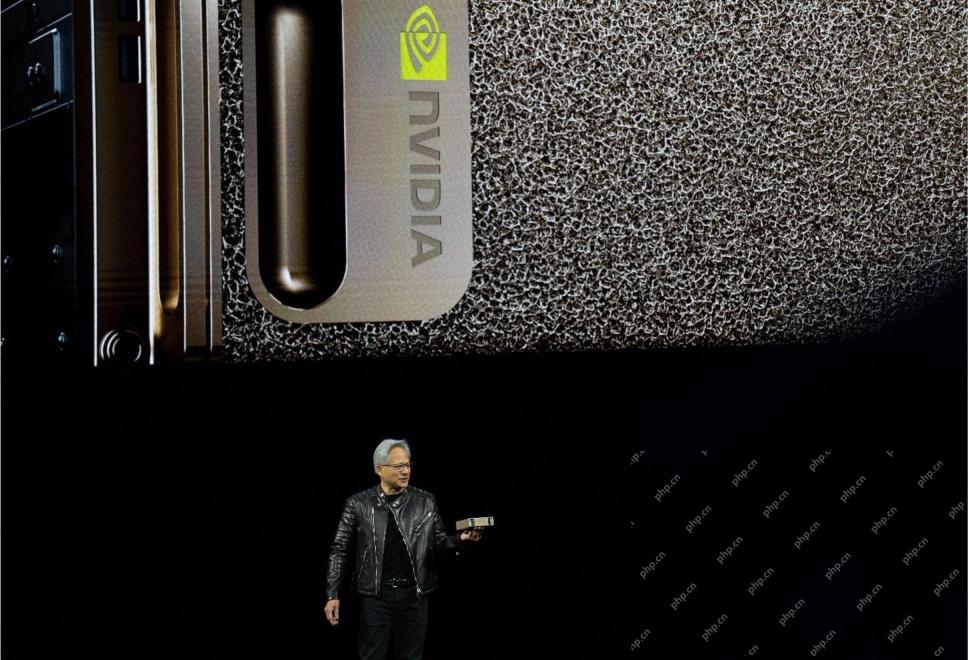

Nvidia의 AI Omniverse는 GTC 2025에서 확장됩니다Apr 22, 2025 am 11:28 AM

Nvidia의 AI Omniverse는 GTC 2025에서 확장됩니다Apr 22, 2025 am 11:28 AMGTC 2025에서 Nvidia의 향상된 예측 가능성 및 신제품 라인업 AI 인프라의 핵심 업체 인 Nvidia는 고객의 예측 가능성 증가에 중점을두고 있습니다. 여기에는 일관된 제품 제공, 성과 기대치 충족 및 충족이 포함됩니다

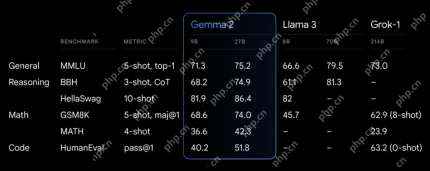

Google의 Gemma 2 모델의 기능을 탐색합니다Apr 22, 2025 am 11:26 AM

Google의 Gemma 2 모델의 기능을 탐색합니다Apr 22, 2025 am 11:26 AMGoogle의 Gemma 2 : 강력하고 효율적인 언어 모델 효율성과 성능으로 축하되는 Google의 Gemma Family of Language 모델은 Gemma 2의 도착으로 확장되었습니다.이 최신 릴리스는 두 가지 모델로 구성됩니다 : 27 억 매개 변수 Ver Ver

Genai의 다음 물결 : Kirk Borne 박사와의 관점 -Salystics VidhyaApr 22, 2025 am 11:21 AM

Genai의 다음 물결 : Kirk Borne 박사와의 관점 -Salystics VidhyaApr 22, 2025 am 11:21 AM이 데이터 에피소드와 함께이 선도에는 주요 데이터 과학자, 천체 물리학 자, TEDX 스피커 인 Kirk Borne 박사가 있습니다. Borne 박사는 빅 데이터, AI 및 머신 러닝 분야의 유명한 전문가 인 현재 상태와 미래의 Traje에 대한 귀중한 통찰력을 제공합니다.

주자와 운동 선수를위한 AI : 우리는 훌륭한 진전을 이루고 있습니다Apr 22, 2025 am 11:12 AM

주자와 운동 선수를위한 AI : 우리는 훌륭한 진전을 이루고 있습니다Apr 22, 2025 am 11:12 AM이 연설에는 인공 지능이 사람들의 신체 운동을 지원하는 데 왜 좋은지를 보여주는 공학에 대한 백 그라운드 정보가 매우 통찰력있는 관점이있었습니다. 스포츠에서 인공 지능 적용을 탐구하는 데 중요한 부분 인 세 가지 디자인 측면을 보여주기 위해 각 기고자의 관점에서 핵심 아이디어를 간략하게 설명 할 것입니다. 에지 장치 및 원시 개인 데이터 인공 지능에 대한이 아이디어에는 실제로 두 가지 구성 요소가 포함되어 있습니다. 하나는 우리가 큰 언어 모델을 배치하는 위치와 관련하여 하나의 구성 요소와 다른 하나는 인간 언어와 활력 징후가 실시간으로 측정 될 때“표현”하는 언어의 차이와 관련이 있습니다. Alexander Amini는 달리기와 테니스에 대해 많은 것을 알고 있지만 그는 여전히

Caterpillar의 기술, 인재 및 혁신에 관한 Jamie EngstromApr 22, 2025 am 11:10 AM

Caterpillar의 기술, 인재 및 혁신에 관한 Jamie EngstromApr 22, 2025 am 11:10 AMCaterpillar의 최고 정보 책임자이자 IT의 수석 부사장 인 Jamie Engstrom은 28 개국에서 2,200 명 이상의 IT 전문가로 구성된 글로벌 팀을 이끌고 있습니다. 현재 역할에서 4 년 반을 포함하여 Caterpillar에서 26 년 동안 Engst

새로운 Google 사진 업데이트는 Ultra HDR 품질로 모든 사진 팝을 만듭니다.Apr 22, 2025 am 11:09 AM

새로운 Google 사진 업데이트는 Ultra HDR 품질로 모든 사진 팝을 만듭니다.Apr 22, 2025 am 11:09 AMGoogle Photos의 새로운 Ultra HDR 도구 : 빠른 가이드 Google Photos의 새로운 Ultra HDR 도구로 사진을 향상시켜 표준 이미지를 활기차고 높은 동기 범위의 걸작으로 변환하십시오. 소셜 미디어에 이상적 이며이 도구는 모든 사진의 영향을 높이고

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.

ZendStudio 13.5.1 맥

강력한 PHP 통합 개발 환경

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전