현대적인 대형 언어 모델 (LLM)의 주요 기능인 컨텍스트 학습 (ICL)을 통해 입력 프롬프트 내 예제에 따라 변압기가 적응할 수 있습니다. 몇 가지 작업 예제를 사용하여 소수의 프롬프트는 원하는 동작을 효과적으로 보여줍니다. 그러나 변압기는 어떻게 이러한 적응을 달성합니까? 이 기사는 ICL의 잠재적 메커니즘을 탐구합니다

ICL의 핵심은 다음과 같습니다. 주어진 예제 쌍 ((x, y)),주의 메커니즘은 새로운 쿼리 (x)를 출력 (y)에 매핑하는 알고리즘을 배울 수 있습니다.

SoftMax주의 및 가장 가까운 이웃 검색

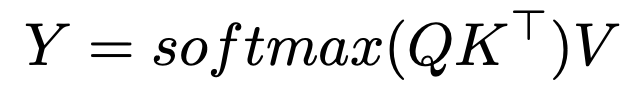

SoftMax주의 공식은 다음과 같습니다

역 온도 매개 변수 도입, c ,주의 할당을 수정합니다 :

c 가 무한대에 접근 할 때,주의는 가장 유사한 토큰에만 초점을 맞춘 한 가지 벡터가됩니다. 효과적으로 가장 가까운 이웃 검색입니다. 유한 한

c 를 사용하면주의가 가우시안 커널 스무딩과 유사합니다. 이는 ICL이 입력 출력 쌍에서 가장 가까운 이웃 알고리즘을 구현할 수 있음을 시사합니다.

시사점 및 추가 연구

트랜스포머를 이해하는 방법을 이해하면 (가장 가까운 이웃과 같은) Automl의 문이 열립니다. Hollmann et al. 합성 데이터 세트에서 변압기를 훈련시켜 전체 Automl 파이프 라인을 배우고 단일 패스의 새로운 데이터에서 최적의 모델과 하이퍼 파라미터를 예측했습니다.

Anthropic의 2022 년 연구는 메커니즘으로서 "유도 헤드"를 시사합니다. 이 쌍의주의 헤드는 복사 및 완전한 패턴을 복사합니다. 예를 들어, "... a, b ... a"가 주어지면 이전 컨텍스트에 따라 "B"를 예측합니다.

최근 연구 (Garg et al. 2022, Oswald et al. 2023) 링크 변압기의 ICL을 그라디언트 하강에 연결합니다. 선형주의, SoftMax 작동을 생략 :

는 전제 조건 구배 하강 (PGD)과 비슷합니다

하나의 선형주의 층은 하나의 PGD 단계를 수행합니다

결론

주의 메커니즘은 학습 알고리즘을 구현하여 데모 쌍에서 학습하여 ICL을 가능하게합니다. 다중주의 층과 MLP의 상호 작용은 복잡하지만 연구는 ICL의 역학에 대한 빛을 발산합니다. 이 기사는 이러한 통찰력에 대한 높은 수준의 개요를 제공합니다

추가 읽기 :

텍스트 내 학습 및 유도 헤드 -

변압기는 텍스트에서 무엇을 배울 수 있습니까? 간단한 기능 클래스의 사례 연구

변압기는 그라디언트 하강에 의해 텍스트 내에서 학습됩니다

변압기는 텍스트 내 학습을위한 전제 조건 구배 하강을 구현하는 법을 배웁니다.

-

승인

이 기사는 미시간 대학교 (University of Michigan)의 2024 년 가을 대학원 과정에서 영감을 받았습니다. 모든 오류는 전적으로 저자입니다.

위 내용은 텍스트 내 학습의 수학의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!