Terraform 및 Ansible을 사용하여 KVM에서 Flask 및 PostgreSQL 배포 자동화

- DDD원래의

- 2025-01-02 14:49:421028검색

? 소개

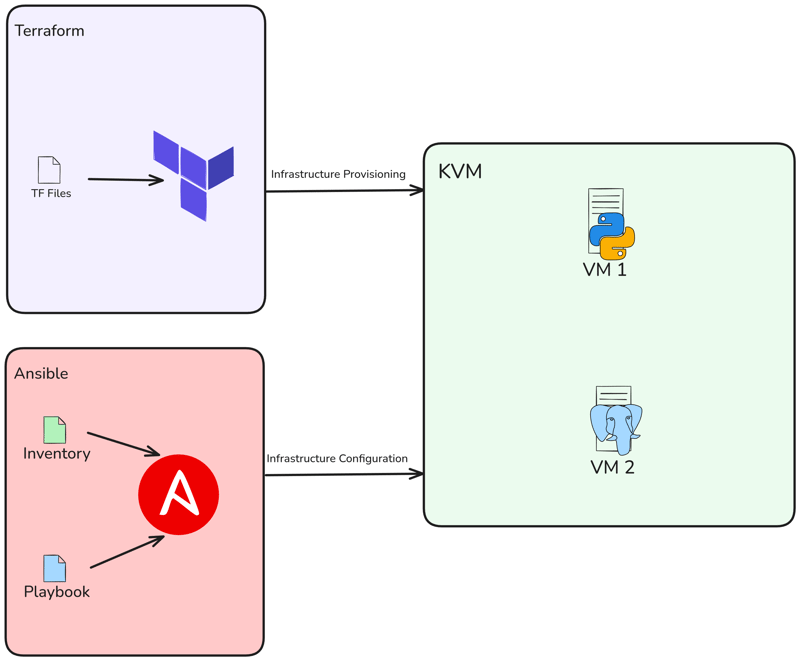

안녕하세요. 이 게시물에서는 Terraform과 함께 Libvirt를 사용하여 2개의 KVM을 로컬로 프로비저닝한 다음 Ansible을 사용하여 Flask 앱 및 PostgreSQL을 배포하겠습니다.

콘텐츠

- 프로젝트 아키텍처

- 요구사항

- KVM 생성

-

Ansible 플레이북 생성

- Docker 설치 플레이북

- postgresql 설치 및 구성을 위한 플레이북

- Flask 앱 배포를 위한 플레이북

- 플레이북 실행 및 테스트

- 결론

? 프로젝트 아키텍처

그래서 Terraform을 사용하여 2개의 VM을 생성한 다음 Ansible을 사용하여 Flask 프로젝트와 데이터베이스를 배포하겠습니다.

? 요구사항

이 프로젝트의 OS는 Ubuntu 22.04 LTS를 사용했습니다. 다른 OS를 사용하는 경우 필수 종속성을 설치할 때 필요한 조정을 하시기 바랍니다.

이 설정의 주요 전제 조건은 KVM 하이퍼바이저입니다. 따라서 시스템에 KVM을 설치해야 합니다. Ubuntu를 사용하는 경우 다음 단계를 따르세요.

sudo apt -y install bridge-utils cpu-checker libvirt-clients libvirt-daemon qemu qemu-kvm

다음 명령을 실행하여 프로세서가 가상화 기능을 지원하는지 확인하세요.

$ kvm-ok INFO: /dev/kvm exists KVM acceleration can be used

Terraform 설치

$ wget -O - https://apt.releases.hashicorp.com/gpg | sudo gpg --dearmor -o /usr/share/keyrings/hashicorp-archive-keyring.gpg $ echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/hashicorp-archive-keyring.gpg] https://apt.releases.hashicorp.com $(lsb_release -cs) main" | sudo tee /etc/apt/sources.list.d/hashicorp.list $ sudo apt update && sudo apt install terraform -y

설치 확인:

$ terraform version Terraform v1.9.8 on linux_amd64

앤서블 설치

$ sudo apt update $ sudo apt install software-properties-common $ sudo add-apt-repository --yes --update ppa:ansible/ansible $ sudo apt install ansible -y

설치 확인:

$ ansible --version ansible [core 2.15.1] ...

KVM 생성

KVM 가상 머신을 배포하기 위해 Terraform과 함께 libvirt 공급자를 사용할 것입니다.

main.tf를 생성하고 사용하려는 공급자와 버전을 지정하세요.

terraform {

required_providers {

libvirt = {

source = "dmacvicar/libvirt"

version = "0.8.1"

}

}

}

provider "libvirt" {

uri = "qemu:///system"

}

그런 다음 terraform init 명령을 실행하여 환경을 초기화합니다.

$ terraform init Initializing the backend... Initializing provider plugins... - Reusing previous version of hashicorp/template from the dependency lock file - Reusing previous version of dmacvicar/libvirt from the dependency lock file - Reusing previous version of hashicorp/null from the dependency lock file - Using previously-installed hashicorp/template v2.2.0 - Using previously-installed dmacvicar/libvirt v0.8.1 - Using previously-installed hashicorp/null v3.2.3 Terraform has been successfully initialized! You may now begin working with Terraform. Try running "terraform plan" to see any changes that are required for your infrastructure. All Terraform commands should now work. If you ever set or change modules or backend configuration for Terraform, rerun this command to reinitialize your working directory. If you forget, other commands will detect it and remind you to do so if necessary.

이제 변수.tf를 만듭니다. 이 변수.tf 파일은 libvirt 디스크 풀 경로, VM용 OS인 Ubuntu 20.04 이미지 URL 및 VM 호스트 이름 목록에 대한 입력을 정의합니다.

variable "libvirt_disk_path" {

description = "path for libvirt pool"

default = "default"

}

variable "ubuntu_20_img_url" {

description = "ubuntu 20.04 image"

default = "https://cloud-images.ubuntu.com/releases/focal/release/ubuntu-20.04-server-cloudimg-amd64.img"

}

variable "vm_hostnames" {

description = "List of VM hostnames"

default = ["vm1", "vm2"]

}

main.tf를 업데이트해 보겠습니다.

resource "null_resource" "cache_image" {

provisioner "local-exec" {

command = "wget -O /tmp/ubuntu-20.04.qcow2 ${var.ubuntu_20_img_url}"

}

}

resource "libvirt_volume" "base" {

name = "base.qcow2"

source = "/tmp/ubuntu-20.04.qcow2"

pool = var.libvirt_disk_path

format = "qcow2"

depends_on = [null_resource.cache_image]

}

# Volume for VM with size 10GB

resource "libvirt_volume" "ubuntu20-qcow2" {

count = length(var.vm_hostnames)

name = "ubuntu20-${count.index}.qcow2"

base_volume_id = libvirt_volume.base.id

pool = var.libvirt_disk_path

size = 10737418240 # 10GB

}

data "template_file" "user_data" {

count = length(var.vm_hostnames)

template = file("${path.module}/config/cloud_init.yml")

}

data "template_file" "network_config" {

count = length(var.vm_hostnames)

template = file("${path.module}/config/network_config.yml")

}

resource "libvirt_cloudinit_disk" "commoninit" {

count = length(var.vm_hostnames)

name = "commoninit-${count.index}.iso"

user_data = data.template_file.user_data[count.index].rendered

network_config = data.template_file.network_config[count.index].rendered

pool = var.libvirt_disk_path

}

resource "libvirt_domain" "domain-ubuntu" {

count = length(var.vm_hostnames)

name = var.vm_hostnames[count.index]

memory = "1024" # VM memory

vcpu = 1 # VM CPU

cloudinit = libvirt_cloudinit_disk.commoninit[count.index].id

network_interface {

network_name = "default"

wait_for_lease = true

hostname = var.vm_hostnames[count.index]

}

console {

type = "pty"

target_port = "0"

target_type = "serial"

}

console {

type = "pty"

target_type = "virtio"

target_port = "1"

}

disk {

volume_id = libvirt_volume.ubuntu20-qcow2[count.index].id

}

graphics {

type = "spice"

listen_type = "address"

autoport = true

}

}

스크립트는 Libvirt 공급자를 사용하여 여러 KVM VM을 프로비저닝합니다. Ubuntu 20.04 기본 이미지를 다운로드하고, 각 VM에 대해 이를 복제하고, 사용자 및 네트워크 설정에 맞게 cloud-init를 구성하고, 지정된 호스트 이름, 1GB 메모리 및 SPICE 그래픽을 사용하여 VM을 배포합니다. 설정은 var.vm_hostnames에 제공된 호스트 이름 수에 따라 동적으로 조정됩니다.

앞서 언급했듯이 저는 cloud-init를 사용하고 있으므로 config 디렉터리에서 네트워크 구성과 cloud init를 설정하겠습니다.

mkdir config/

그런 다음 config/cloud_init.yml을 생성하고 구성에서 SSH 액세스를 위한 공개 SSH 키를 구성했는지 확인하세요.

#cloud-config

runcmd:

- sed -i '/PermitRootLogin/d' /etc/ssh/sshd_config

- echo "PermitRootLogin yes" >> /etc/ssh/sshd_config

- systemctl restart sshd

ssh_pwauth: true

disable_root: false

chpasswd:

list: |

root:cloudy24

expire: false

users:

- name: ubuntu

gecos: ubuntu

groups:

- sudo

sudo:

- ALL=(ALL) NOPASSWD:ALL

home: /home/ubuntu

shell: /bin/bash

lock_passwd: false

ssh_authorized_keys:

- ssh-rsa AAAA...

그런 다음 config/network_config.yml의 네트워크 구성:

version: 2

ethernets:

ens3:

dhcp4: true

우리 프로젝트 구조는 다음과 같습니다.

sudo apt -y install bridge-utils cpu-checker libvirt-clients libvirt-daemon qemu qemu-kvm

이제 계획을 실행하여 어떤 작업이 수행될지 확인하세요.

$ kvm-ok INFO: /dev/kvm exists KVM acceleration can be used

그리고 Terraform Apply를 실행하여 배포를 실행합니다.

$ wget -O - https://apt.releases.hashicorp.com/gpg | sudo gpg --dearmor -o /usr/share/keyrings/hashicorp-archive-keyring.gpg $ echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/hashicorp-archive-keyring.gpg] https://apt.releases.hashicorp.com $(lsb_release -cs) main" | sudo tee /etc/apt/sources.list.d/hashicorp.list $ sudo apt update && sudo apt install terraform -y

virsh 명령을 사용하여 VM 생성을 확인합니다.

$ terraform version Terraform v1.9.8 on linux_amd64

인스턴스 IP 주소 가져오기:

$ sudo apt update $ sudo apt install software-properties-common $ sudo add-apt-repository --yes --update ppa:ansible/ansible $ sudo apt install ansible -y

Ubuntu 사용자를 사용하여 VM에 액세스해 보세요.

$ ansible --version ansible [core 2.15.1] ...

Ansible 플레이북 생성

이제 Docker에 Flask 및 Postgresql을 배포하기 위한 Ansible 플레이북을 만들어 보겠습니다. 먼저 ansible 디렉토리와 ansible.cfg 파일을 생성해야 합니다:

terraform {

required_providers {

libvirt = {

source = "dmacvicar/libvirt"

version = "0.8.1"

}

}

}

provider "libvirt" {

uri = "qemu:///system"

}

$ terraform init Initializing the backend... Initializing provider plugins... - Reusing previous version of hashicorp/template from the dependency lock file - Reusing previous version of dmacvicar/libvirt from the dependency lock file - Reusing previous version of hashicorp/null from the dependency lock file - Using previously-installed hashicorp/template v2.2.0 - Using previously-installed dmacvicar/libvirt v0.8.1 - Using previously-installed hashicorp/null v3.2.3 Terraform has been successfully initialized! You may now begin working with Terraform. Try running "terraform plan" to see any changes that are required for your infrastructure. All Terraform commands should now work. If you ever set or change modules or backend configuration for Terraform, rerun this command to reinitialize your working directory. If you forget, other commands will detect it and remind you to do so if necessary.

그런 다음 호스트라는 인벤토리 파일을 만듭니다.

variable "libvirt_disk_path" {

description = "path for libvirt pool"

default = "default"

}

variable "ubuntu_20_img_url" {

description = "ubuntu 20.04 image"

default = "https://cloud-images.ubuntu.com/releases/focal/release/ubuntu-20.04-server-cloudimg-amd64.img"

}

variable "vm_hostnames" {

description = "List of VM hostnames"

default = ["vm1", "vm2"]

}

ansible ping 명령을 사용하여 VM 확인:

resource "null_resource" "cache_image" {

provisioner "local-exec" {

command = "wget -O /tmp/ubuntu-20.04.qcow2 ${var.ubuntu_20_img_url}"

}

}

resource "libvirt_volume" "base" {

name = "base.qcow2"

source = "/tmp/ubuntu-20.04.qcow2"

pool = var.libvirt_disk_path

format = "qcow2"

depends_on = [null_resource.cache_image]

}

# Volume for VM with size 10GB

resource "libvirt_volume" "ubuntu20-qcow2" {

count = length(var.vm_hostnames)

name = "ubuntu20-${count.index}.qcow2"

base_volume_id = libvirt_volume.base.id

pool = var.libvirt_disk_path

size = 10737418240 # 10GB

}

data "template_file" "user_data" {

count = length(var.vm_hostnames)

template = file("${path.module}/config/cloud_init.yml")

}

data "template_file" "network_config" {

count = length(var.vm_hostnames)

template = file("${path.module}/config/network_config.yml")

}

resource "libvirt_cloudinit_disk" "commoninit" {

count = length(var.vm_hostnames)

name = "commoninit-${count.index}.iso"

user_data = data.template_file.user_data[count.index].rendered

network_config = data.template_file.network_config[count.index].rendered

pool = var.libvirt_disk_path

}

resource "libvirt_domain" "domain-ubuntu" {

count = length(var.vm_hostnames)

name = var.vm_hostnames[count.index]

memory = "1024" # VM memory

vcpu = 1 # VM CPU

cloudinit = libvirt_cloudinit_disk.commoninit[count.index].id

network_interface {

network_name = "default"

wait_for_lease = true

hostname = var.vm_hostnames[count.index]

}

console {

type = "pty"

target_port = "0"

target_type = "serial"

}

console {

type = "pty"

target_type = "virtio"

target_port = "1"

}

disk {

volume_id = libvirt_volume.ubuntu20-qcow2[count.index].id

}

graphics {

type = "spice"

listen_type = "address"

autoport = true

}

}

이제 playbook.yml과 역할을 생성하면 이 플레이북에서 Docker, Flask 및 PostgreSQL을 설치하고 구성합니다.

mkdir config/

Docker 설치를 위한 플레이북

이제 역할/docker라는 새 디렉터리를 만듭니다.

#cloud-config

runcmd:

- sed -i '/PermitRootLogin/d' /etc/ssh/sshd_config

- echo "PermitRootLogin yes" >> /etc/ssh/sshd_config

- systemctl restart sshd

ssh_pwauth: true

disable_root: false

chpasswd:

list: |

root:cloudy24

expire: false

users:

- name: ubuntu

gecos: ubuntu

groups:

- sudo

sudo:

- ALL=(ALL) NOPASSWD:ALL

home: /home/ubuntu

shell: /bin/bash

lock_passwd: false

ssh_authorized_keys:

- ssh-rsa AAAA...

docker에 task라는 새 디렉터리를 만든 다음 새 파일 main.yml을 만듭니다. 이 파일은 Docker 및 Docker Compose를 설치합니다:

version: 2

ethernets:

ens3:

dhcp4: true

$ tree . ├── config │ ├── cloud_init.yml │ └── network_config.yml ├── main.tf └── variables.tf

PostgreSQL 설치 및 구성을 위한 플레이북

그런 다음 psql이라는 새 디렉터리를 만들고 vars, tempalates 및 task라는 하위 디렉터리를 만듭니다.

$ terraform plan data.template_file.user_data[1]: Reading... data.template_file.user_data[0]: Reading... data.template_file.network_config[1]: Reading... data.template_file.network_config[0]: Reading... ... Plan: 8 to add, 0 to change, 0 to destroy

이후 vars에서 main.yml을 생성합니다. 사용자 이름, 비밀번호 등을 설정하는 데 사용되는 변수는 다음과 같습니다.

$ terraform apply ... null_resource.cache_image: Creation complete after 10m36s [id=4239391010009470471] libvirt_volume.base: Creating... libvirt_volume.base: Creation complete after 3s [id=/var/lib/libvirt/images/base.qcow2] libvirt_volume.ubuntu20-qcow2[1]: Creating... libvirt_volume.ubuntu20-qcow2[0]: Creating... libvirt_volume.ubuntu20-qcow2[1]: Creation complete after 0s [id=/var/lib/libvirt/images/ubuntu20-1.qcow2] libvirt_volume.ubuntu20-qcow2[0]: Creation complete after 0s [id=/var/lib/libvirt/images/ubuntu20-0.qcow2] libvirt_domain.domain-ubuntu[1]: Creating... ... libvirt_domain.domain-ubuntu[1]: Creation complete after 51s [id=6221f782-48b7-49a4-9eb9-fc92970f06a2] Apply complete! Resources: 8 added, 0 changed, 0 destroyed

다음으로 docker-compose.yml.j2라는 jinja 파일을 생성하겠습니다. 이 파일을 사용하여 postgresql 컨테이너를 생성합니다:

$ virsh list Id Name State ---------------------- 1 vm1 running 2 vm2 running

다음으로 작업에 대한 main.yml을 만듭니다. 따라서 docker-compose.yml.j2를 복사하고 docker compose를 사용하여 실행하겠습니다.

$ virsh net-dhcp-leases --network default Expiry Time MAC address Protocol IP address Hostname Client ID or DUID ----------------------------------------------------------------------------------------------------------------------------------------------- 2024-12-09 19:50:00 52:54:00:2e:0e:86 ipv4 192.168.122.19/24 vm1 ff:b5:5e:67:ff:00:02:00:00:ab:11:b0:43:6a:d8:bc:16:30:0d 2024-12-09 19:50:00 52:54:00:86:d4:ca ipv4 192.168.122.15/24 vm2 ff:b5:5e:67:ff:00:02:00:00:ab:11:39:24:8c:4a:7e:6a:dd:78

Flask 앱 배포를 위한 플레이북

먼저 Flask라는 디렉토리를 생성한 후 하위 디렉토리를 다시 생성해야 합니다.

$ ssh ubuntu@192.168.122.15 The authenticity of host '192.168.122.15 (192.168.122.15)' can't be established. ED25519 key fingerprint is SHA256:Y20zaCcrlOZvPTP+/qLLHc7vJIOca7QjTinsz9Bj6sk. This key is not known by any other names Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added '192.168.122.15' (ED25519) to the list of known hosts. Welcome to Ubuntu 20.04.6 LTS (GNU/Linux 5.4.0-200-generic x86_64) ... ubuntu@ubuntu:~$

다음으로 vars에 main.yml을 추가합니다. 이 파일은 VM2(데이터베이스 VM)의 IP 주소를 추가하여 이전에 posgtresql 변수를 참조합니다.

$ mkdir ansible && cd ansible

다음으로 템플릿에 config.py.j2를 만듭니다. 이 파일은 Flask 프로젝트의 이전 구성 파일을 대체합니다:

[defaults] inventory = hosts host_key_checking = True deprecation_warnings = False collections = ansible.posix, community.general, community.postgresql

다음으로 템플릿에 docker-compose.yml.j2를 만듭니다. 이 파일을 사용하여 docker compose를 사용하여 컨테이너를 생성합니다.

[vm1] 192.168.122.19 ansible_user=ubuntu [vm2] 192.168.122.15 ansible_user=ubuntu

다음으로 작업에서 main.yml을 만듭니다. 이 파일을 사용하여 플라스크 프로젝트를 복제하고, compose 파일을 추가하고, config.py를 바꾸고, docker compose를 사용하여 새 컨테이너를 만듭니다.

$ ansible -m ping all

192.168.122.15 | SUCCESS => {

"ansible_facts": {

"discovered_interpreter_python": "/usr/bin/python3"

},

"changed": false,

"ping": "pong"

}

192.168.122.19 | SUCCESS => {

"ansible_facts": {

"discovered_interpreter_python": "/usr/bin/python3"

},

"changed": false,

"ping": "pong"

}

우리 프로젝트 구조는 다음과 같습니다.

---

- name: Deploy Flask

hosts: vm1

become: true

remote_user: ubuntu

roles:

- flask

- config

- name: Deploy Postgresql

hosts: vm2

become: true

remote_user: ubuntu

roles:

- psql

- config

플레이북 실행 및 테스트

마지막으로 Ansible-playbook을 실행하여 PostgreSQL과 Flask를 배포해 보겠습니다.

$ mkdir roles $ mkdir docker

완료 후 오류가 없는지 확인해주세요. 그러면 두 개가 생성된 것을 볼 수 있습니다. VM1은 Flask이고 VM2는 Postgresql입니다.

sudo apt -y install bridge-utils cpu-checker libvirt-clients libvirt-daemon qemu qemu-kvm

브라우저를 사용하여 앱에 액세스하려면 http://

새 작업을 추가하면 데이터가 데이터베이스에 추가됩니다.

결론

마지막으로 이 글을 읽어주셔서 감사합니다. 질문, 제안, 피드백이 있으시면 언제든지 댓글을 남겨주세요.

참고: 프로젝트 저장소: danielcristho/that-i-write

위 내용은 Terraform 및 Ansible을 사용하여 KVM에서 Flask 및 PostgreSQL 배포 자동화의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!