Hugging Face AI 모델을 API로 사용하는 방법

- DDD원래의

- 2024-11-16 05:21:031060검색

이 가이드에서는 Meta LLaMA-3.2-3B-Instruct를 예로 들어 Hugging Face 모델을 API로 사용하는 방법을 보여 드리겠습니다. 이 모델은 채팅 기반 자동 완성을 위해 설계되었으며 대화형 AI 작업을 효과적으로 처리할 수 있습니다. API를 설정하고 시작해보세요!

1단계: 포옹 얼굴 모델 선택

- Hugging Face Models로 이동하여 Meta LLaMA-3.2-3B-Instruct 또는 실험해보고 싶은 다른 모델을 검색하세요.

- 모델 페이지에서 Inference API를 지원하는지 확인하세요. 이를 통해 API 엔드포인트로 사용할 수 있습니다.

2단계: API 토큰 생성

Hugging Face의 모델 API에 접근하려면 API 토큰이 필요합니다.

- Hugging Face 계정에 로그인하고 설정 > 액세스 토큰.

새 토큰을 선택하여 읽기 토큰을 만듭니다. 이를 통해 리소스를 수정하거나 관리할 수 있는 권한 없이 추론을 위한 API를 호출할 수 있습니다.

API 인증에 필요하므로 토큰을 안전하게 저장하세요.

3단계: 모델에 추론 API 사용

Hugging Face는 사전 훈련된 모델에 액세스할 수 있는 서버리스 추론 API를 제공합니다. 이 서비스는 무료 사용자에 대한 비율 제한과 Pro 계정에 대한 향상된 할당량으로 제공됩니다.

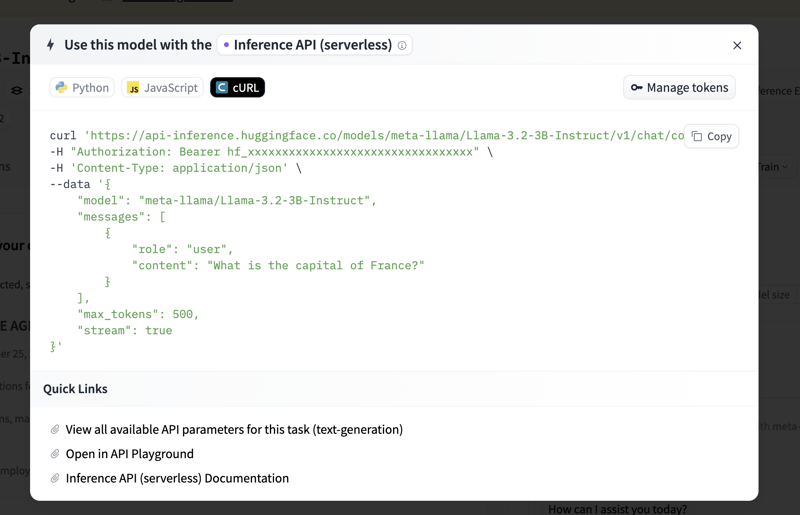

Meta LLaMA-3.2-3B-Instruct 모델 페이지에서 Inference API 탭을 클릭하세요. 이 탭에서는 코드 예제와 추가 API 사용 정보를 제공합니다.

시작하려면 샘플 코드를 찾을 수 있습니다. 모델의 API를 호출하기 위한 기본 Python 스크립트를 설정하는 방법은 다음과 같습니다.

4단계: 요율 제한 처리 및 Pro 계정 이점

무료 계정의 경우 API 속도 제한이 적용되며 이를 초과하면 요청이 제한될 수 있습니다. API를 광범위하게 사용할 계획이거나 더 빠른 응답이 필요한 경우 Pro 계정을 고려해 보세요. 자세한 내용은 Hugging Face 가격 페이지에서 확인할 수 있습니다.

요약

다음 단계를 따르면 Meta LLaMA-3.2-3B-Instruct 또는 API를 통해 기타 Hugging Face 모델을 사용하여 채팅 자동 완성, 대화형 AI 등과 같은 작업을 수행할 수 있습니다. 이 설정은 매우 유연하며 실험 목적이든 생산 목적이든 AI 기능을 애플리케이션에 직접 통합할 수 있습니다.

이제 Hugging Face의 강력한 모델을 탐색하고 구축할 준비가 되었습니다!

위 내용은 Hugging Face AI 모델을 API로 사용하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!