이번 주에는 사용자가 소스 코드 파일을 입력하고 프로그래밍 언어를 선택한 후 선택한 언어로 번역할 수 있는 codeshift라는 명령줄 도구 작업을 진행했습니다.

내부적으로는 화려한 작업이 진행되지 않습니다. Groq이라는 AI 제공업체를 사용하여 번역을 처리할 뿐입니다. 하지만 개발 프로세스, 사용 방법, 제공하는 기능에 대해 알아보고 싶었습니다.

우데이-라나

/

코드시프트

우데이-라나

/

코드시프트

코드시프트

소스 코드 파일을 원하는 언어로 변환하는 명령줄 도구입니다.

특징

- 여러 입력 파일 허용

- stdout으로 출력 스트리밍

- 출력 언어 선택 가능

- 파일에 출력을 쓸 파일 경로를 지정할 수 있습니다

- .env에서 사용자 정의 API 키를 사용할 수 있습니다.

설치

- Node.js 설치

- Groq API 키 받기

- Git로 저장소를 복제하거나 .zip으로 다운로드하세요

- package.json이 포함된 repo 디렉터리 내에서 npm install을 실행합니다.

- (선택 사항) npm install -g 를 실행하세요. 패키지를 전체적으로 설치하려면(노드 접두사 없이 실행할 수 있도록)

- .env라는 파일을 생성하고 Groq API 키를 추가하세요: GROQ_API_KEY=API_KEY_HERE

사용방법

codeshift [-o ]

예

codeshift -o index.go 예시/index.js로 이동

옵션

- -o, --output: 출력을 쓸 파일 이름을 지정합니다

- -h, --help: 명령에 대한 도움말 표시

- -v, --version: 버전 번호 출력

인수

-

: 소스 파일을 변환하려는 언어 - : 경로…

특징

- 여러 입력 파일 허용

- 출력 언어 선택 가능

- stdout으로 출력 스트리밍

- 파일에 출력을 쓸 파일 경로를 지정할 수 있습니다

- .env에서 사용자 정의 API 키를 사용할 수 있습니다.

용법

codeshift [-o ]

예를 들어, example/index.js 파일을 Go로 변환하고 출력을 index.go에 저장하려면:

codeshift -o index.go 예시/index.js로 이동

옵션

- -o, --output: 출력을 쓸 파일 이름을 지정합니다

- -h, --help: 명령에 대한 도움말 표시

- -v, --version: 버전 번호 출력

인수

-

: 소스 파일을 변환하려는 언어 -

: 공백으로 구분된 소스 파일의 경로

개발

저는 온타리오 주 토론토에 있는 Seneca Polytechnic에서 오픈 소스 개발 주제 과정의 일환으로 이 프로젝트를 진행해 왔습니다. 처음에는 내가 편한 기술을 계속 사용하고 싶었지만 프로젝트 지침을 통해 새로운 프로그래밍 언어나 새로운 런타임과 같은 새로운 것을 배울 수 있었습니다.

Java를 배우고 싶었지만 온라인에서 검색해 본 결과 CLI 도구를 개발하거나 AI 모델과 인터페이스하는 데는 좋은 선택이 아닌 것 같았습니다. OpenAI에서는 공식적으로 지원되지 않으며 해당 문서에 포함된 커뮤니티 라이브러리는 더 이상 사용되지 않습니다.

저는 항상 인기 있는 기술을 고수해 왔습니다. 이러한 기술은 신뢰할 수 있고 온라인에서 완전한 문서와 수많은 정보를 제공하는 경향이 있습니다. 하지만 이번에는 다르게 행동하기로 결정했습니다. 저는 Node를 대체할 새로운 JavaScript용 런타임인 Bun을 사용하기로 결정했습니다.

알고 보니 직감에 충실했어야 했어요. 프로젝트를 컴파일하는 중에 문제가 발생했고 제가 할 수 있는 일은 개발자가 문제를 해결해주기를 바라는 것뿐이었습니다.

Sentry Node 에이전트와 함께 OpenAI SDK를 사용할 수 없습니다: TypeError: getDefaultAgent는 함수가 아닙니다.

#1010

Sentry Node 에이전트와 함께 OpenAI SDK를 사용할 수 없습니다: TypeError: getDefaultAgent는 함수가 아닙니다.

#1010

이것이 기본 OpenAI API 문제가 아니라 노드 라이브러리 문제인지 확인하세요

- [X] Node 라이브러리 문제입니다

버그 설명

이전에 여기에서 참조했지만 해결 없이 종료되었습니다: https://github.com/openai/openai-node/issues/903

최신 Sentry 모니터링 패키지를 사용하면서 SDK 사용을 방해하기 때문에 이는 꽤 큰 문제입니다.

재현

- npm i @sentry/node --save를 통해 Sentry Node SDK 설치

- 다음 코드를 입력하세요

import * as Sentry from '@sentry/node';

// Start Sentry

Sentry.init({

dsn: "https://your-sentry-url",

environment: "your-env",

tracesSampleRate: 1.0, // Capture 100% of the transactions

});

- Try to create a completion somewhere in the process after Sentry has been initialized:

const params = {

model: model,

stream: true,

stream_options: {

include_usage: true

},

messages

};

const completion = await openai.chat.completions.create(params);

Results in error:

TypeError: getDefaultAgent is not a function

at OpenAI.buildRequest (file:///my-project/node_modules/openai/core.mjs:208:66)

at OpenAI.makeRequest (file:///my-project/node_modules/openai/core.mjs:279:44)

Code snippets

(Included)

OS

All operating systems (macOS, Linux)

Node version

v20.10.0

Library version

v4.56.0

This turned me away from Bun. I'd found out from our professor we were going to compile an executable later in the course, and I did not want to deal with Bun's problems down the line.

So, I switched to Node. It was painful going from Bun's easy-to-use built-in APIs to having to learn how to use commander for Node. But at least it wouldn't crash.

I had previous experience working with AI models through code thanks to my co-op, but I was unfamiliar with creating a command-line tool. Configuring the options and arguments turned out to be the most time-consuming aspect of the project.

Apart from the core feature we chose for each of our projects - mine being code translation - we were asked to implement any two additional features. One of the features I chose to implement was to save output to a specified file. Currently, I'm not sure this feature is that useful, since you could just redirect the output to a file, but in the future I want to use it to extract the code from the response to the file, and include the AI's rationale behind the translation in the full response to stdout. Writing this feature also helped me learn about global and command-based options using commander.js. Since there was only one command (run) and it was the default, I wanted the option to show up in the default help menu, not when you specifically typed codeshift help run, so I had to learn to implement it as a global option.

I also ended up "accidentally" implementing the feature for streaming the response to stdout. I was at first scared away from streaming, because it sounded too difficult. But later, when I was trying to read the input files, I figured reading large files in chunks would be more efficient. I realized I'd already implemented streaming in my previous C++ courses, and figuring it wouldn't be too bad, I got to work.

Then, halfway through my implementation I realized I'd have to send the whole file at once to the AI regardless.

But this encouraged me to try streaming the output from the AI. So I hopped on MDN and started reading about ReadableStreams and messing around with ReadableStreamDefaultReader.read() for what felt like an hour - only to scroll down the AI provider's documentation and realize all I had to do was add stream: true to my request.

Either way, I may have taken the scenic route but I ended up implementing streaming.

Planned Features

Right now, the program parses each source file individually, with no shared context. So if a file references another, it wouldn't be reflected in the output. I'd like to enable it to have that context eventually. Like I mentioned, another feature I want to add is writing the AI's reasoning behind the translation to stdout but leaving it out of the output file. I'd also like to add some of the other optional features, like options to specify the AI model to use, the API key to use, and reading that data from a .env file in the same directory.

That's about it for this post. I'll be writing more in the coming weeks.

위 내용은 건물 코드시프트의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

JavaScript로 문자열 문자를 교체하십시오Mar 11, 2025 am 12:07 AM

JavaScript로 문자열 문자를 교체하십시오Mar 11, 2025 am 12:07 AMJavaScript 문자열 교체 방법 및 FAQ에 대한 자세한 설명 이 기사는 JavaScript에서 문자열 문자를 대체하는 두 가지 방법 인 내부 JavaScript 코드와 웹 페이지의 내부 HTML을 탐색합니다. JavaScript 코드 내부의 문자열을 교체하십시오 가장 직접적인 방법은 대체 () 메소드를 사용하는 것입니다. str = str.replace ( "find", "replace"); 이 메소드는 첫 번째 일치 만 대체합니다. 모든 경기를 교체하려면 정규 표현식을 사용하고 전역 플래그 g를 추가하십시오. str = str.replace (/fi

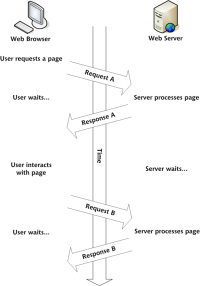

자신의 Ajax 웹 응용 프로그램을 구축하십시오Mar 09, 2025 am 12:11 AM

자신의 Ajax 웹 응용 프로그램을 구축하십시오Mar 09, 2025 am 12:11 AM그래서 여기 당신은 Ajax라는이 일에 대해 배울 준비가되어 있습니다. 그러나 정확히 무엇입니까? Ajax라는 용어는 역동적이고 대화식 웹 컨텐츠를 만드는 데 사용되는 느슨한 기술 그룹을 나타냅니다. 원래 Jesse J에 의해 만들어진 Ajax라는 용어

내 자신의 JavaScript 라이브러리를 어떻게 작성하고 게시합니까?Mar 18, 2025 pm 03:12 PM

내 자신의 JavaScript 라이브러리를 어떻게 작성하고 게시합니까?Mar 18, 2025 pm 03:12 PM기사는 JavaScript 라이브러리 작성, 게시 및 유지 관리, 계획, 개발, 테스트, 문서 및 홍보 전략에 중점을 둡니다.

브라우저에서 성능을 위해 JavaScript 코드를 최적화하려면 어떻게해야합니까?Mar 18, 2025 pm 03:14 PM

브라우저에서 성능을 위해 JavaScript 코드를 최적화하려면 어떻게해야합니까?Mar 18, 2025 pm 03:14 PM이 기사는 브라우저에서 JavaScript 성능을 최적화하기위한 전략에 대해 설명하고 실행 시간을 줄이고 페이지로드 속도에 미치는 영향을 최소화하는 데 중점을 둡니다.

jQuery 매트릭스 효과Mar 10, 2025 am 12:52 AM

jQuery 매트릭스 효과Mar 10, 2025 am 12:52 AM매트릭스 영화 효과를 페이지에 가져 오십시오! 이것은 유명한 영화 "The Matrix"를 기반으로 한 멋진 jQuery 플러그인입니다. 플러그인은 영화에서 클래식 그린 캐릭터 효과를 시뮬레이션하고 사진을 선택하면 플러그인이 숫자로 채워진 매트릭스 스타일 사진으로 변환합니다. 와서 시도해보세요. 매우 흥미 롭습니다! 작동 방식 플러그인은 이미지를 캔버스에로드하고 픽셀 및 색상 값을 읽습니다. data = ctx.getImageData (x, y, settings.grainsize, settings.grainsize) .data 플러그인은 그림의 직사각형 영역을 영리하게 읽고 jQuery를 사용하여 각 영역의 평균 색상을 계산합니다. 그런 다음 사용하십시오

브라우저 개발자 도구를 사용하여 JavaScript 코드를 효과적으로 디버그하려면 어떻게해야합니까?Mar 18, 2025 pm 03:16 PM

브라우저 개발자 도구를 사용하여 JavaScript 코드를 효과적으로 디버그하려면 어떻게해야합니까?Mar 18, 2025 pm 03:16 PM이 기사는 브라우저 개발자 도구를 사용하여 효과적인 JavaScript 디버깅, 중단 점 설정, 콘솔 사용 및 성능 분석에 중점을 둡니다.

간단한 jQuery 슬라이더를 만드는 방법Mar 11, 2025 am 12:19 AM

간단한 jQuery 슬라이더를 만드는 방법Mar 11, 2025 am 12:19 AM이 기사에서는 jQuery 라이브러리를 사용하여 간단한 사진 회전 목마를 만들도록 안내합니다. jQuery를 기반으로 구축 된 BXSLIDER 라이브러리를 사용하고 회전 목마를 설정하기위한 많은 구성 옵션을 제공합니다. 요즘 그림 회전 목마는 웹 사이트에서 필수 기능이되었습니다. 한 사진은 천 단어보다 낫습니다! 그림 회전 목마를 사용하기로 결정한 후 다음 질문은 그것을 만드는 방법입니다. 먼저 고품질 고해상도 사진을 수집해야합니다. 다음으로 HTML과 일부 JavaScript 코드를 사용하여 사진 회전 목마를 만들어야합니다. 웹에는 다양한 방식으로 회전 목마를 만드는 데 도움이되는 라이브러리가 많이 있습니다. 오픈 소스 BXSLIDER 라이브러리를 사용할 것입니다. BXSLIDER 라이브러리는 반응 형 디자인을 지원 하므로이 라이브러리로 제작 된 회전 목마는

Angular로 CSV 파일을 업로드하고 다운로드하는 방법Mar 10, 2025 am 01:01 AM

Angular로 CSV 파일을 업로드하고 다운로드하는 방법Mar 10, 2025 am 01:01 AM데이터 세트는 API 모델 및 다양한 비즈니스 프로세스를 구축하는 데 매우 필수적입니다. 그렇기 때문에 CSV 가져 오기 및 내보내기가 자주 필요한 기능인 이유입니다.이 자습서에서는 각도 내에서 CSV 파일을 다운로드하고 가져 오는 방법을 배웁니다.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.

SecList

SecLists는 최고의 보안 테스터의 동반자입니다. 보안 평가 시 자주 사용되는 다양한 유형의 목록을 한 곳에 모아 놓은 것입니다. SecLists는 보안 테스터에게 필요할 수 있는 모든 목록을 편리하게 제공하여 보안 테스트를 더욱 효율적이고 생산적으로 만드는 데 도움이 됩니다. 목록 유형에는 사용자 이름, 비밀번호, URL, 퍼징 페이로드, 민감한 데이터 패턴, 웹 셸 등이 포함됩니다. 테스터는 이 저장소를 새로운 테스트 시스템으로 간단히 가져올 수 있으며 필요한 모든 유형의 목록에 액세스할 수 있습니다.

PhpStorm 맥 버전

최신(2018.2.1) 전문 PHP 통합 개발 도구

드림위버 CS6

시각적 웹 개발 도구

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

뜨거운 주제

1371

1371 52

52 36

36 19

19

우데이-라나

/

코드시프트

우데이-라나

/

코드시프트

Sentry Node 에이전트와 함께 OpenAI SDK를 사용할 수 없습니다: TypeError: getDefaultAgent는 함수가 아닙니다.

#1010

Sentry Node 에이전트와 함께 OpenAI SDK를 사용할 수 없습니다: TypeError: getDefaultAgent는 함수가 아닙니다.

#1010