스파이더맨이 매혹적으로 춤을 추고 있습니다. 차세대 ControlNet이 여기에 있습니다! Jiajiaya 팀이 출시한 이 제품은 플러그 앤 플레이 방식이며 비디오 생성도 제어할 수 있습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB원래의

- 2024-08-17 15:49:41803검색

10% 미만의 훈련 매개변수를 사용하면 ControlNet과 동일한 제어 가능한 생성을 달성할 수 있습니다!

또한 SDXL 및 SD1.5와 같은 Stable Diffusion 제품군의 일반 모델을 조정할 수 있으며 여전히 플러그 앤 플레이 방식입니다.

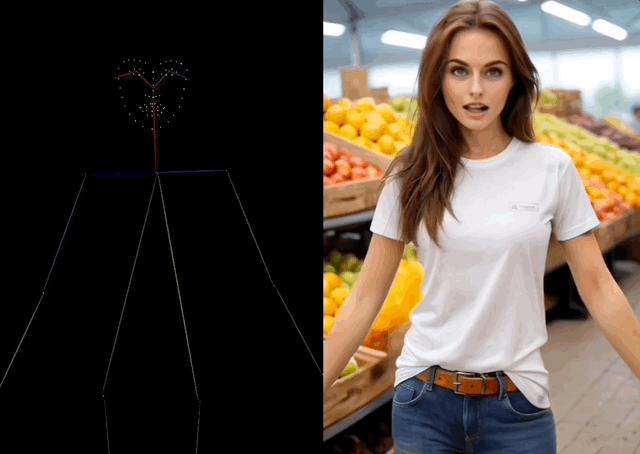

동시에 SVD와 함께 사용하여 영상 생성을 제어할 수도 있으며, 동작 디테일을 손가락까지 정확하게 제어할 수 있습니다.

이 이미지와 비디오 뒤에는 홍콩 중국 Jiajiaya 팀이 출시한 오픈 소스 이미지/비디오 생성 안내 도구인 ControlNeXt가 있습니다.

R&D팀이 차세대 ControlNet으로 포지셔닝한 것은 이름에서 알 수 있습니다.

예를 들어 위대한 신 He Kaiming과 Xie Saining의 고전 작품 ResNeXt(ResNet의 확장)도 이 방법을 사용하여 이름을 지정했습니다.

일부 네티즌들은 이 이름이 합당하며 ControlNet을 한 단계 더 끌어올린 차세대 제품이라고 생각합니다.

어떤 사람들은 ControlNeXt가 제어 가능한 발전의 효율성을 크게 향상시키는 게임 체인저라고 말합니다. 그들은 그것을 사용하는 사람들이 만든 작품을 기대합니다.

미인 댄스를 추는 스파이더맨

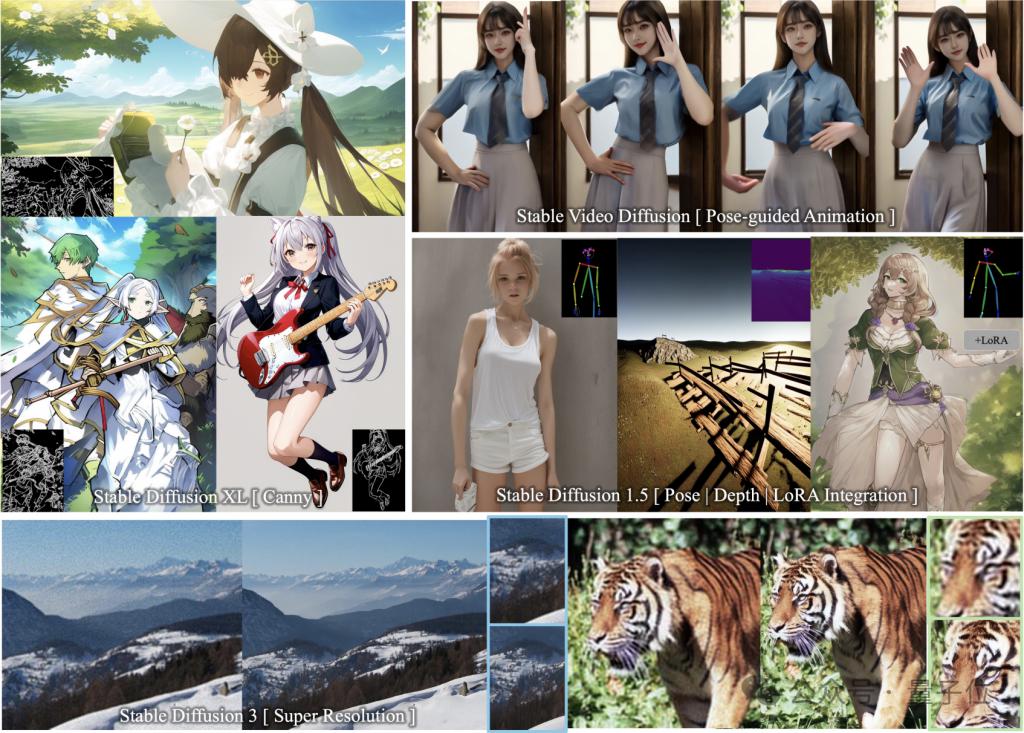

ControlNeXt는 다양한 SD 시리즈 모델을 지원하며 플러그 앤 플레이 방식입니다.

이미지 생성 모델 SD1.5, SDXL, SD3(초해상도 지원) 및 비디오 생성 모델 SVD가 포함됩니다.

더 이상 고민하지 말고 결과를 살펴보겠습니다.

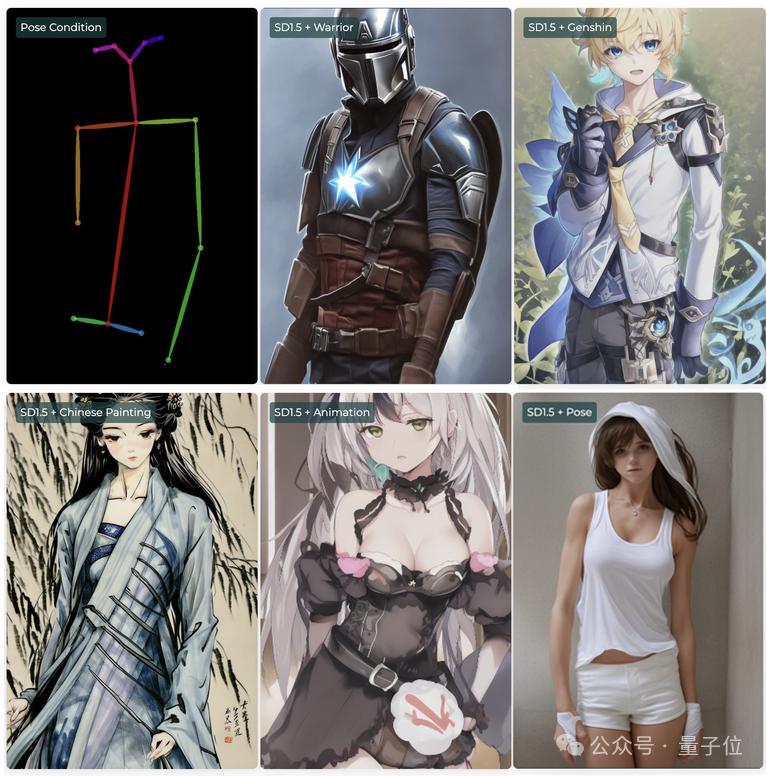

보시다시피 SDXL에 엣지(캐니) 가이던스를 추가하여 그려진 2차원 소녀와 컨트롤 라인이 거의 완벽하게 들어맞았습니다.

제어 윤곽선이 많고 단편화되어 있어도 모델은 요구 사항을 충족하는 그림을 그릴 수 있습니다.

추가 교육 없이도 다른 LoRA 가중치와 원활하게 통합됩니다.

예를 들어 SD1.5에서는 다양한 LoRA와 함께 자세(포즈) 제어 조건을 사용하여 스타일이 다르거나 차원을 넘어도 동작은 동일한 캐릭터를 형성할 수 있습니다.

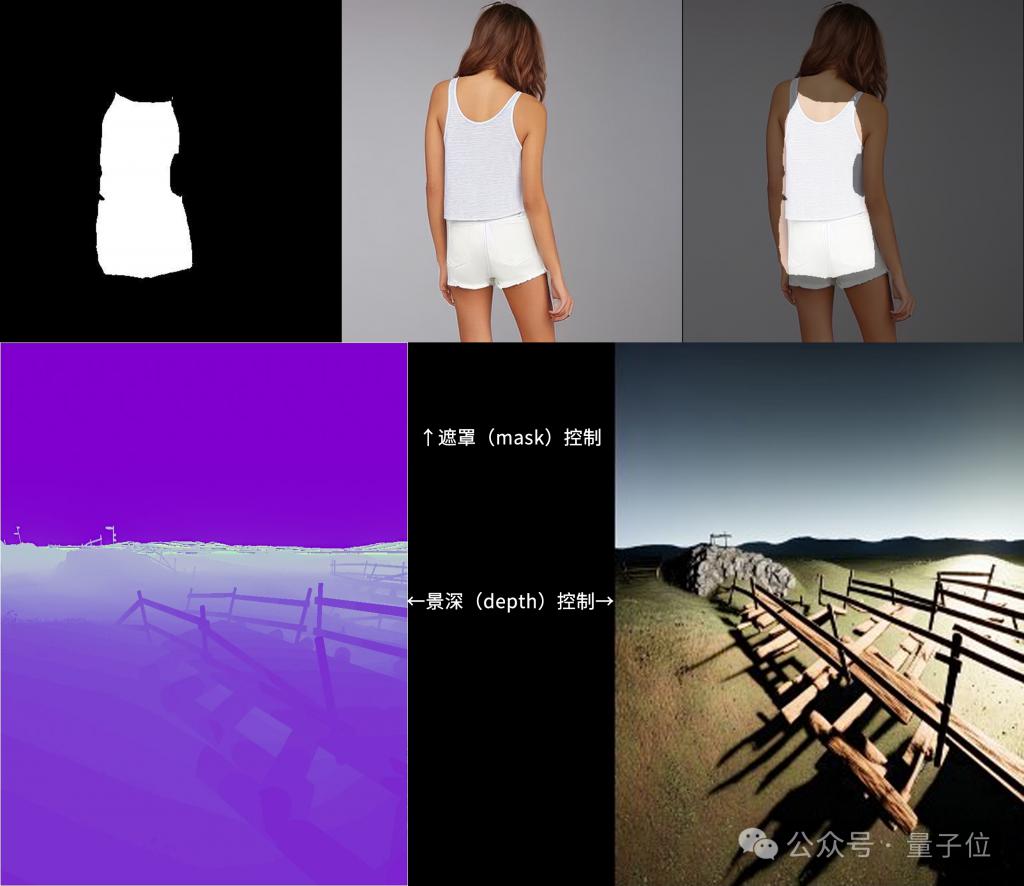

또한 ControlNeXt는 마스크 및 깊이 제어 모드도 지원합니다.

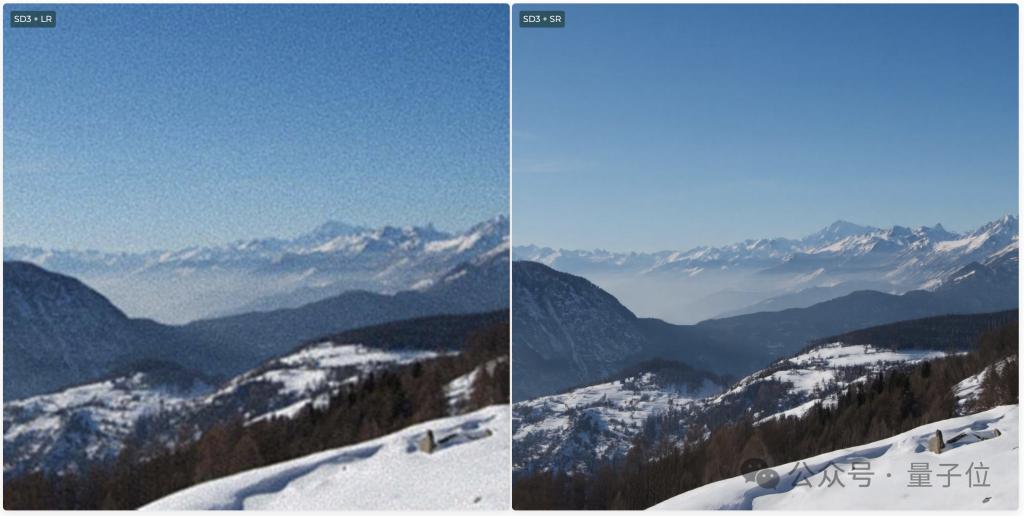

SD3는 초고화질 이미지를 생성할 수 있는 Super Resolution도 지원합니다.

동영상 생성 중에 ControlNeXt는 캐릭터의 움직임을 제어할 수 있습니다.

예를 들어 스파이더맨이 틱톡에서 아름다운 춤을 추게 하면 손가락 움직임까지 꽤 정확하게 모방됩니다.

의자도 손을 키우고 똑같은 춤을 추게 만들었지만 좀 추상적이긴 하지만 액션 재현이 꽤 좋습니다.

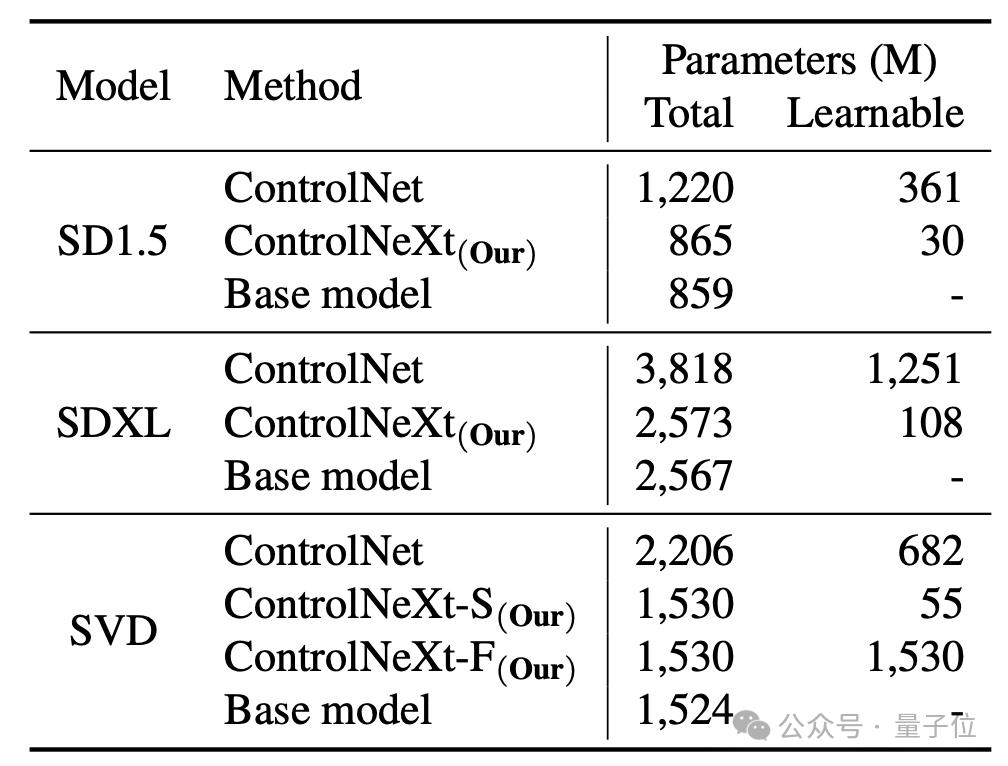

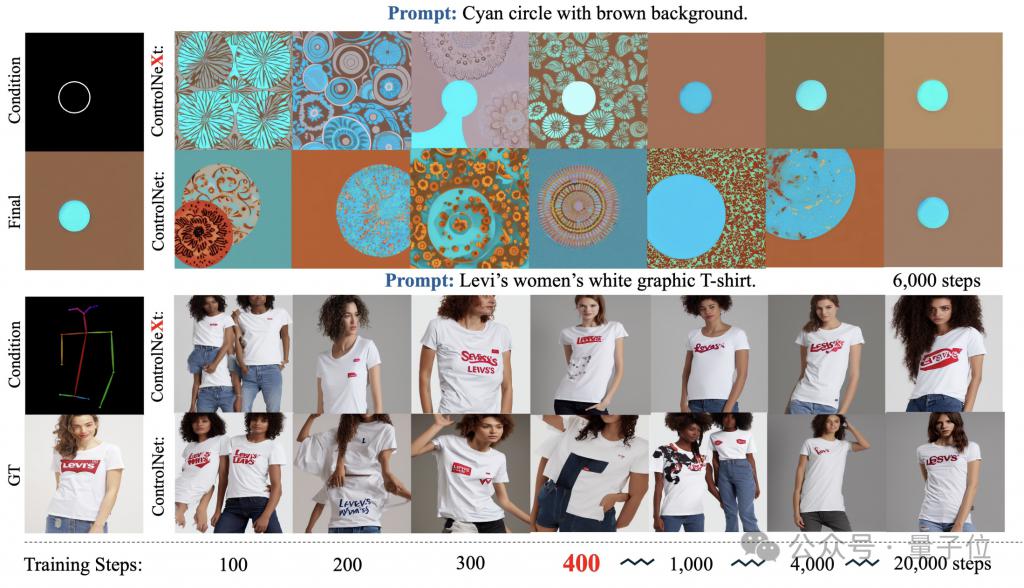

그리고 원래 ControlNet에 비해 ControlNeXt는 훈련 매개변수가 더 적고 더 빠르게 수렴합니다.

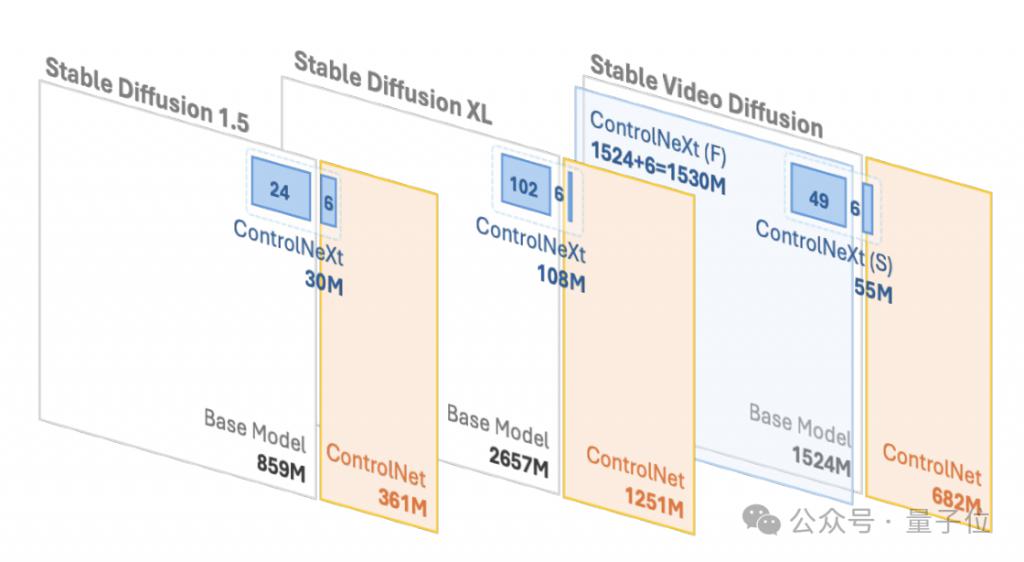

예를 들어 SD1.5와 SDXL에서 ControlNet에는 각각 3억 6,100만 개와 12억 5,100만 개의 학습 가능한 매개변수가 필요하지만 ControlNeXt는 각각 3,000만 개와 1억 8,000만 개만 필요하며 이는 ControlNet의 10% 미만입니다.

훈련 과정에서 ControlNeXt는 약 400단계에서 수렴에 가까워지지만 ControlNet은 10배, 심지어 수십 배의 단계가 필요합니다.

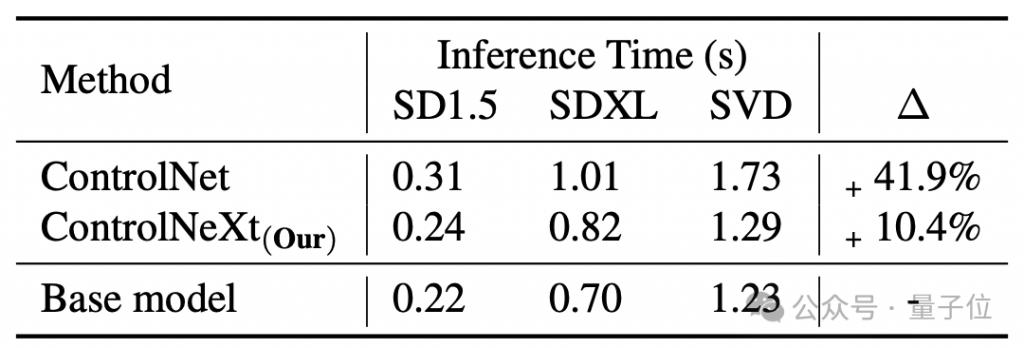

평균적으로 ControlNet은 기본 모델과 동일하여 41.9%의 지연이 발생하지만 ControlNeXt는 10.4%에 불과합니다.

그럼 ControlNeXt는 어떻게 구현되고, ControlNet에는 어떤 개선이 이루어졌나요?

더욱 경량화된 조건부 제어 모듈

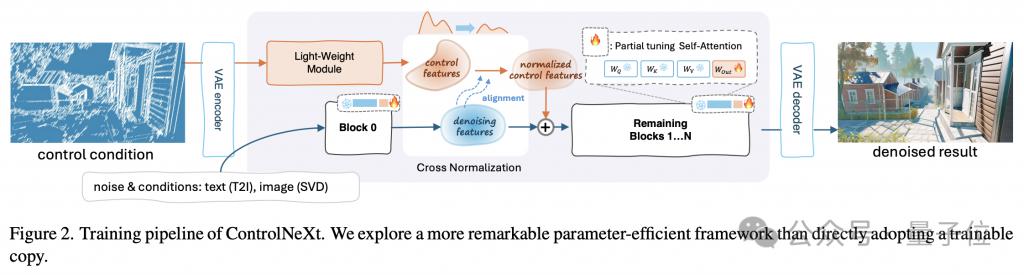

먼저 그림을 통해 ControlNeXt의 전체 작업흐름을 이해해 보세요.

경량화의 핵심은 ControlNeXt가 ControlNet의 거대한 제어 분기를 제거하고 대신 소수의 ResNet 블록으로 구성된 경량 컨볼루션 모듈을 도입한다는 것입니다.

이 모듈은 제어 조건(의미론적 분할 마스크, 핵심 포인트 사전 등)의 특징 표현을 추출하는 역할을 담당합니다.

훈련 매개변수의 양은 일반적으로 ControlNet에서 사전 훈련된 모델의 10% 미만이지만 여전히 입력 조건부 제어 정보를 잘 학습할 수 있습니다. 이 설계는 계산 오버헤드와 메모리 사용량을 크게 줄입니다.

구체적으로, 사전 훈련된 모델의 다양한 네트워크 계층에서 동일한 간격의 샘플을 샘플링하여 훈련에 사용되는 매개변수의 하위 집합을 형성하고 나머지 매개변수는 고정됩니다.

또한 연구팀은 ControlNeXt의 아키텍처를 설계할 때 모델 구조와 원래 아키텍처의 일관성을 유지하여 플러그 앤 플레이를 구현했습니다.

ControlNet이든 ControlNeXt이든 조건부 제어 정보의 주입은 중요한 링크입니다.

이 과정에서 ControlNeXt 연구팀은 주입 위치 선택과 주입 방법 설계라는 두 가지 핵심 문제에 대해 심층적인 연구를 수행했습니다.

연구팀은 대부분의 제어 가능한 생성 작업에서 생성을 안내하는 조건부 정보의 형태가 상대적으로 단순하고 잡음 제거 과정의 특징과 높은 상관관계가 있음을 관찰했습니다.

그래서 팀은 잡음 제거 네트워크의 모든 계층에 제어 정보를 주입할 필요가 없다고 판단하여 네트워크의 중간 계층에서만 조건부 기능과 잡음 제거 기능을 집계하기로 결정했습니다.

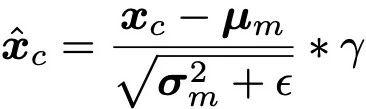

집계 방법도 최대한 간단합니다. 교차 정규화를 사용하여 두 특성 세트의 분포를 정렬한 후 직접 추가하세요.

이는 제어 신호가 잡음 제거 프로세스에 영향을 미치도록 보장할 뿐만 아니라 어텐션 메커니즘과 같은 복잡한 작업으로 인한 추가 학습 매개변수 도입 및 불안정성을 방지합니다.

교차 정규화는 ControlNeXt의 또 다른 핵심 기술로, 이전에 일반적으로 사용되는 제로 컨볼루션과 같은 점진적 초기화 전략을 대체합니다.

기존 방법은 새로운 모듈의 영향력을 처음부터 점진적으로 풀어줌으로써 붕괴 문제를 완화하지만, 그 결과 수렴이 느린 경우가 많습니다.

교차 정규화는 백본 네트워크 노이즈 제거 기능의 평균 μ 및 분산 σ를 직접 사용하여 제어 모듈에서 출력되는 기능을 정규화하여 둘의 데이터 분포가 최대한 정렬되도록 합니다.

(참고: 는 수치 안정성을 위해 추가된 작은 상수이고 γ는 스케일링 매개변수입니다.)

그런 다음 정규화된 제어 기능이 통과됩니다. 오프셋 매개변수는 진폭과 기준선을 조정한 다음 이를 잡음 제거 기능에 추가합니다. 이렇게 하면 매개변수 초기화의 민감도를 피할 수 있을 뿐만 아니라 훈련 초기 단계에 제어 조건이 적용되어 수렴 프로세스 속도를 높일 수 있습니다.

또한 ControlNeXt는 제어 모듈을 사용하여 조건 정보를 잠재 공간 기능에 매핑하는 방법을 학습하여 더욱 추상적이고 의미론적이며 보이지 않는 제어 조건에 대한 일반화에 더욱 도움이 됩니다.

프로젝트 홈페이지:

https://pbihao.github.io/projects/controlnext/index.html

문서 주소:

https:/ /arxiv.org/abs/2408.06070

GitHub:

https://github.com/dvlab-research/ControlNeXt

위 내용은 스파이더맨이 매혹적으로 춤을 추고 있습니다. 차세대 ControlNet이 여기에 있습니다! Jiajiaya 팀이 출시한 이 제품은 플러그 앤 플레이 방식이며 비디오 생성도 제어할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!