ACL 2024 시상식 발표: HuaTech의 Oracle 해독에 관한 최고의 논문 중 하나, GloVe Time Test Award

- 王林원래의

- 2024-08-15 16:37:02636검색

이 ACL 컨퍼런스에서 기여자들은 많은 것을 얻었습니다.

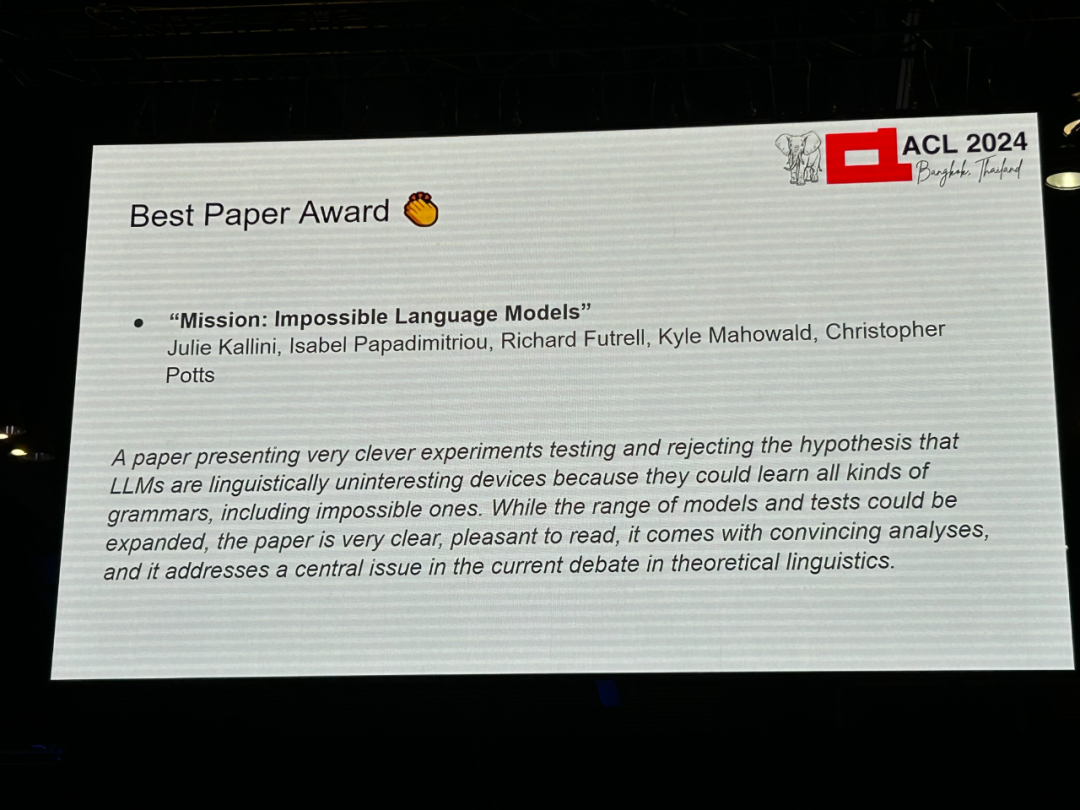

저자: Julie Kallini, Isabel Papadimitriou, Richard Futrell, Ky 르 마호왈드, 크리스토퍼 포츠 -

기관: Stanford University, University of California, Irvine, University of Texas at Austin 논문 링크: https://arxiv.org/abs/2401.06416

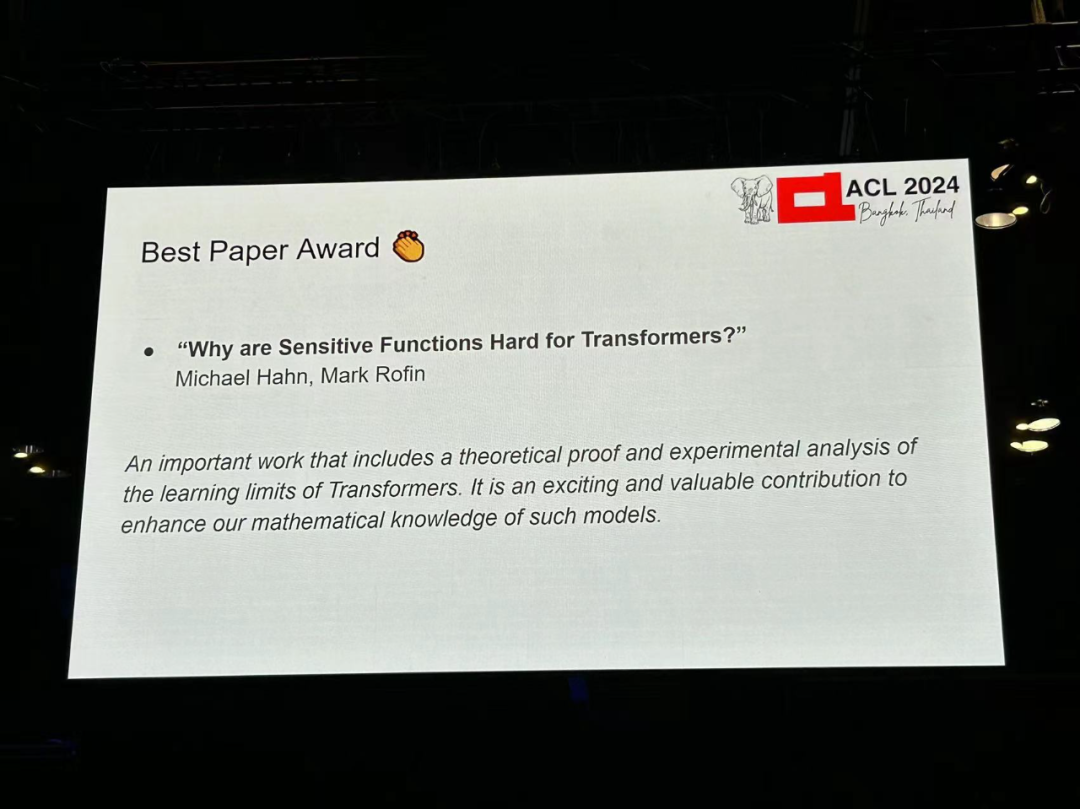

저자: Michael Hahn, Mark Rofin 기관: 자를란트 대학교 논문 링크: https://arxiv.org /abs/2402.09963

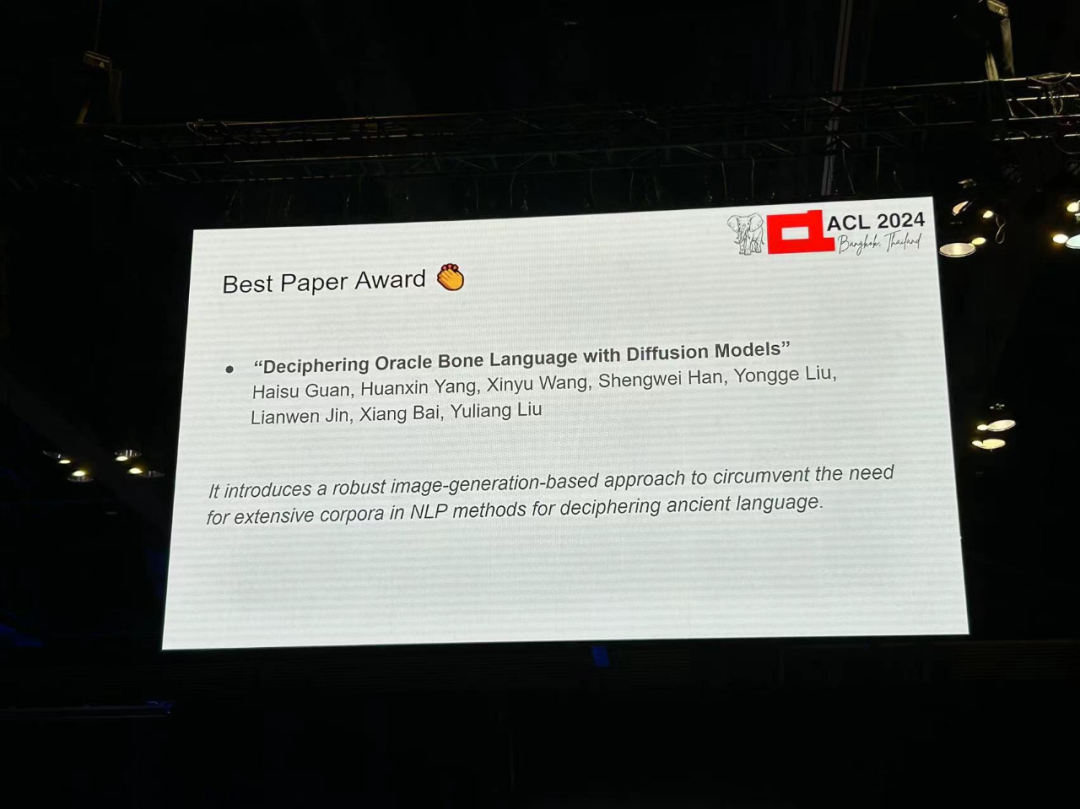

저자: Haisu Guan, Huanxin Yang, Xinyu Wang, Shengwei Han 등 -

기관: 화중대학교 Science and Technology , A Adelaide University, Anyang Normal College, South China University of Technology 논문 링크: https://arxiv.org/pdf/2406.00684

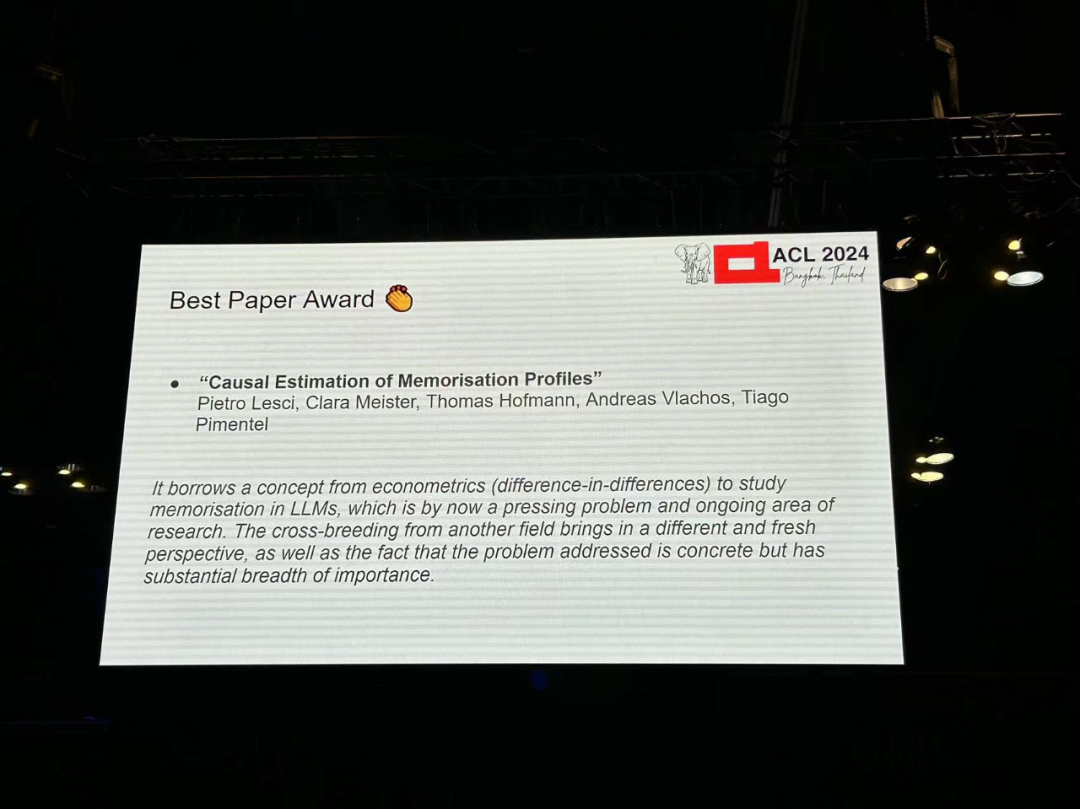

저자: Pietro Lesci, Clara Meister, Thomas Hofmann, Andreas Vlachos, Tiago Pimentel 기관: 캠브리지 대학교, ETH 취리히 Academy 논문 링크: https://arxiv.org/pdf/2406.04327

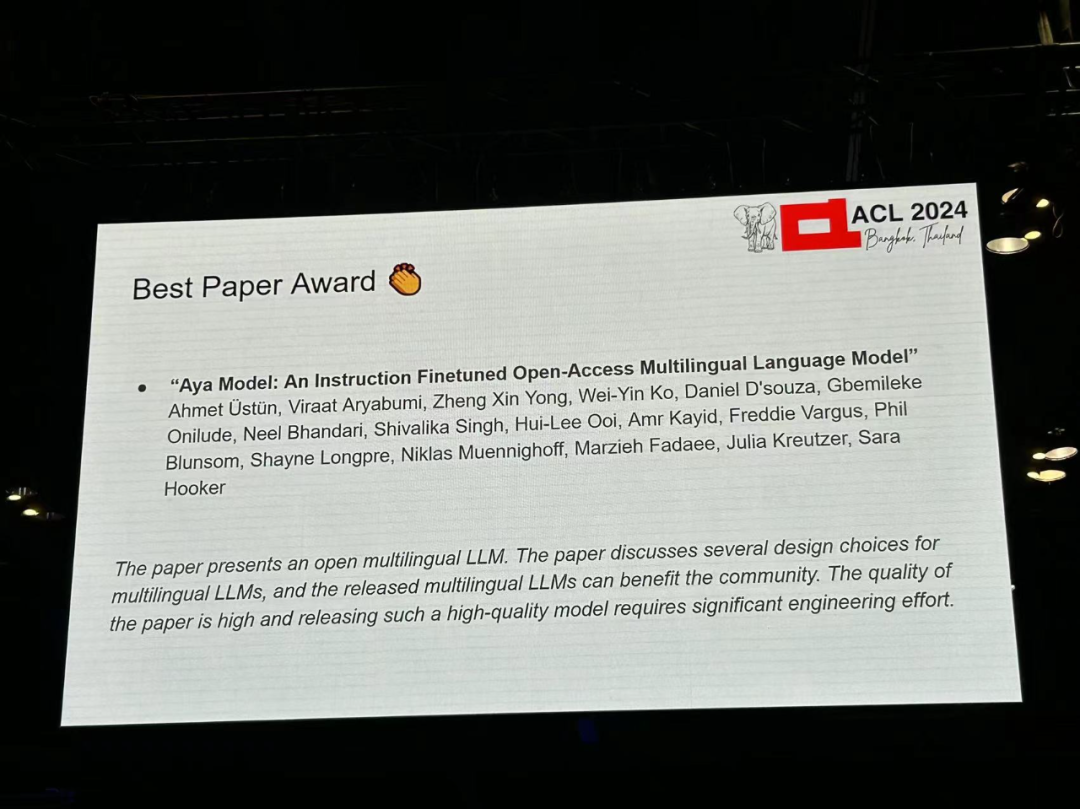

저자: Ahmet Üstün, Viraat Aryabumi, Zheng Xin Yong, Wei-Yin Ko 등 기관: Cohere, Brown University et al 논문 링크: https://arxiv.org/pdf/2402.07827

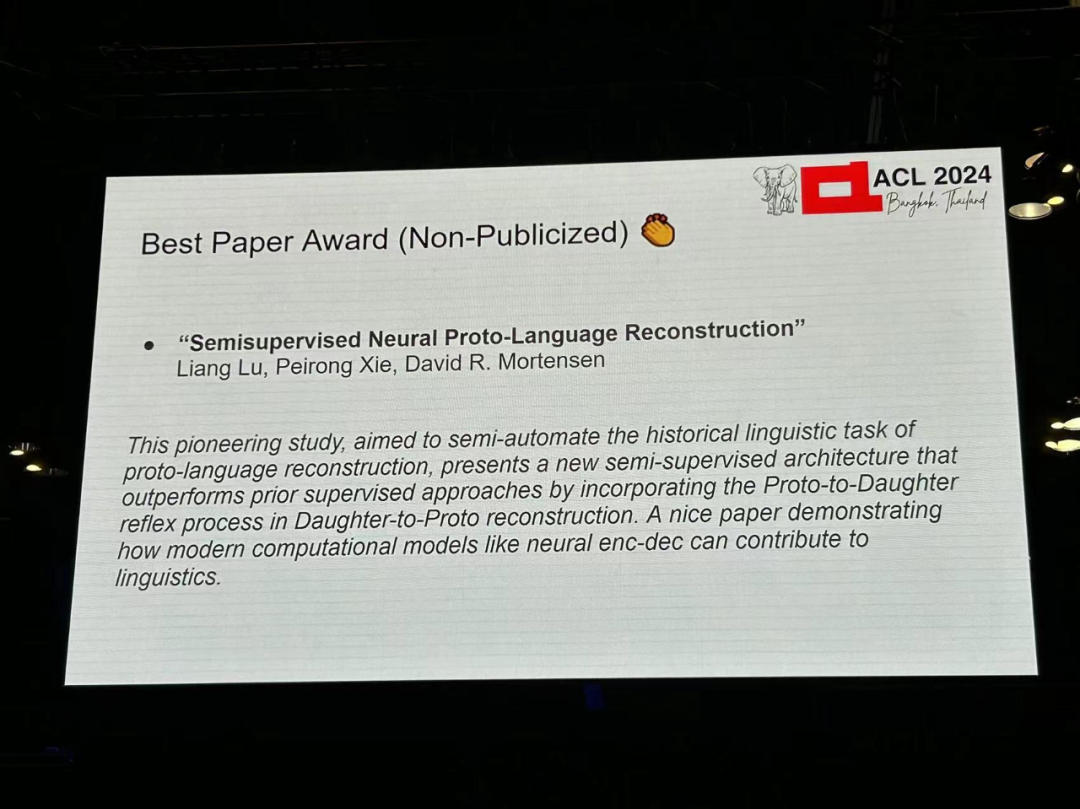

저자: Liang Lu, Peirong Xie, David R. Mortensen -

기관: CMU, Southern California -

논문 링크: https://arxiv.org/pdf/2406.05930

-

저자: Tharindu Madusanka, Ian Pratt-Hartmann, Riza Batista-Navarro

기관: Stanford University :https://aclanthology.org/D14-1162.pdf

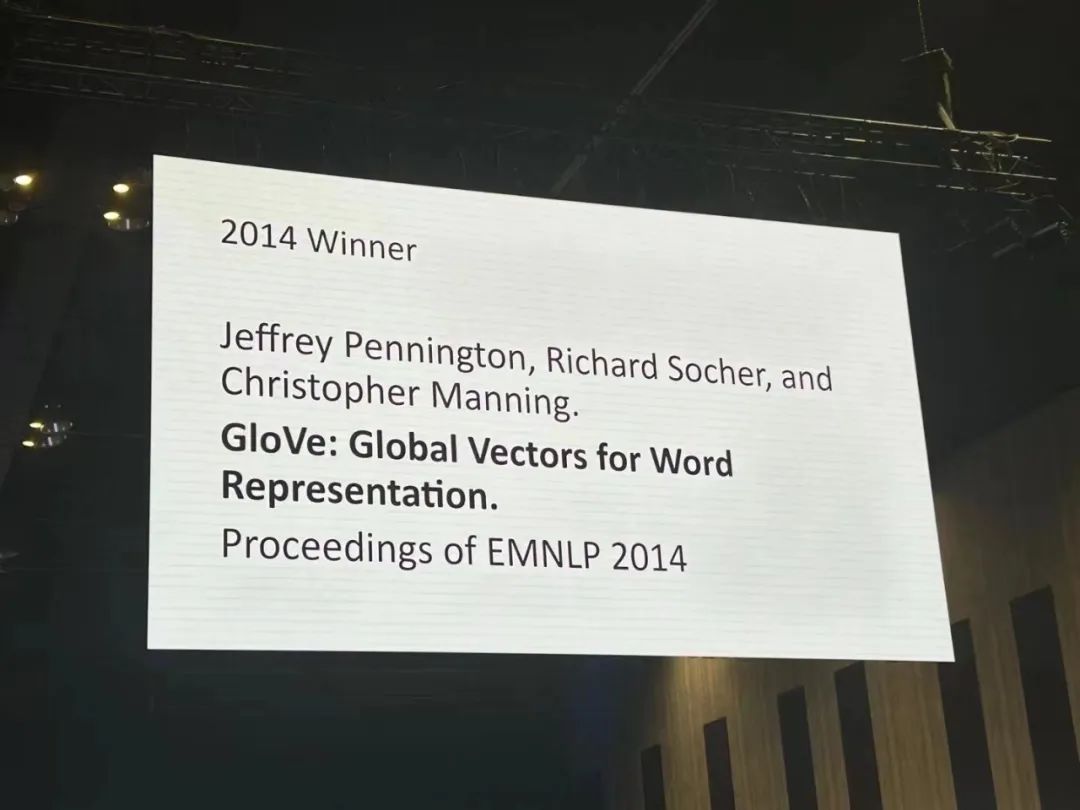

- 논문 소개: 벡터 학습 단어 공간 표현적 접근 방식은 벡터 산술을 사용하여 세밀한 의미 및 구문 규칙을 포착하는 데 성공했지만 구문 규칙은 여전히 불투명합니다. 본 연구에서는 단어 벡터에 구문 규칙이 나타나기 위해 모델이 어떤 속성을 가져야 하는지 분석하고 명확히 합니다.

이 연구는 단어의 벡터 표현을 학습하도록 설계된 새로운 전역 로그 선형 회귀 모델인 GloVe를 제안합니다. 이 모델은 전역 행렬 분해와 로컬 컨텍스트 창 방법의 장점을 결합합니다.

GloVe는 단어 유추 작업에서 75%의 최고 성능을 달성하고 단어 유사성 작업 및 명명된 엔터티 인식에서 관련 모델을 능가합니다.

인용: 단어 임베딩은 2013년부터 2018년까지 자연어 처리(NLP)를 위한 딥 러닝 방법의 초석이었으며 계속해서 중요한 영향을 미치고 있습니다. NLP 작업의 성능을 향상시킬 뿐만 아니라 단어 유사성 및 유추와 같은 계산 의미론에도 중요한 영향을 미칩니다. 가장 영향력 있는 두 가지 단어 임베딩 방법은 아마도 Skip-gram/CBOW와 GloVe일 것입니다. 스킵그램과 비교하여 GloVe는 나중에 제안되었다. 상대적인 장점은 개념적 단순성에 있으며, 단순화된 언어 모델링 관점에서 매개변수 집합으로 간접적으로 사용하는 것이 아니라 단어 간의 분포 특성을 직접 기반으로 벡터 공간 유사성을 최적화합니다. #🎜🎜 ##### 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#논문 2: 분배 유사성의 측정#🎜🎜 ## 🎜🎜 ##🎜 🎜#

저자: Lillian Lee

#🎜 🎜#

논문 소개: 저자는 보이지 않는 동시 발생 사건의 확률 추정치를 향상시키기 위한 목적으로 분포 유사성 측정을 연구합니다. 이들의 기여는 세 가지입니다: 광범위한 측정값의 경험적 비교, 포함된 정보를 기반으로 한 유사성 기능 분류, 기본 에이전트 분포를 평가하는 데 탁월한 새로운 기능 도입.

논문 소개: 저자는 보이지 않는 동시 발생 사건의 확률 추정치를 향상시키기 위한 목적으로 분포 유사성 측정을 연구합니다. 이들의 기여는 세 가지입니다: 광범위한 측정값의 경험적 비교, 포함된 정보를 기반으로 한 유사성 기능 분류, 기본 에이전트 분포를 평가하는 데 탁월한 새로운 기능 도입.

#🎜 🎜 #ACL 평생 공로상은 Ralph Grishman에게 돌아갑니다. Ralph Grishman은 뉴욕대학교 컴퓨터공학과 교수로 자연어 처리(NLP) 분야 연구에 주력하고 있습니다. 그는 정보 추출(IE)에 지대한 공헌을 하고 해당 분야를 발전시킨 프로테우스 프로젝트(Proteus Project)의 창립자입니다. 또한 그는 문장 분할, 명명된 엔터티 주석, 시간 표현 주석 및 정규화, 품사 태깅, 부분 구문 분석 및 상호 참조와 같은 다중 언어 분석 구성 요소를 제공하는 널리 사용되는 정보 추출 도구인 JET(Java Extraction Toolkit)를 개발했습니다. 분석. 이러한 구성 요소는 다양한 애플리케이션에 따라 파이프라인으로 결합될 수 있으며, 단일 문장의 대화형 분석이나 전체 문서의 일괄 분석에 사용할 수 있습니다. 또한 JET는 문서 주석 및 표시를 위한 간단한 도구를 제공하고 ACE(자동 콘텐츠 추출) 사양에 따라 엔터티, 관계 및 이벤트를 추출하기 위한 전체 프로세스를 포함합니다. Grishman 교수의 연구는 NLP의 여러 핵심 문제를 다루며 현대 언어 처리 기술에 지대한 영향을 미쳤습니다. 35개의 뛰어난 논문 논문 1: 양자화 측면 튜닝: 양자화 대형 언어 모델의 빠르고 메모리 효율적인 튜닝 저자: Zhengxin Zhang, Dan Zhao, X 우펭 미아오, Gabriele Oliaro, Zhihao Zhang, Qing Li, Yong Jiang, Zhihao Jia 기관: CMU, Tsinghua University, Pengcheng Laboratory 등 -

논문 링크: https://arxiv.org/pdf/2401.07159

문서 2: L-Eval: 장기 컨텍스트 언어 모델에 대한 표준화된 평가 실시 저자: Chenxin An, Shansan Gong, Ming Zhong, Xingjian Zhao, Mukai Li, Jun Zhang, Lingpeng Kong, Xipeng Qiu 기관: 푸단대학교, 홍콩대학교, 일리노이대학교 어바나 샴페인, 상하이 AI 연구소 논문 링크: https://arxiv.org/abs/2307.11088

논문 3: 대규모 언어 모델 편향 제거를 위한 인과 기반 능동적 학습 논문 링크: https://openreview.net/forum?id=idp_1Q6F-lC

논문 4: CausalGym: 언어 작업에 대한 인과 해석 방법 벤치마킹 저자: Aryaman Arora, Dan Jurafsky, Christopher Potts 기관: Stanford University -

논문 링크: https://arxiv.org/abs/2402.12560

문서 5: 환각하지 말고 기권하세요: 다중 LLM 협업을 통해 LLM 지식 격차 식별 저자: Shangbin Feng, Weijia Shi, Yike Wang, Wenxuan Ding, Vidhisha Balachandran, Yulia Tsvetkov 기관: 워싱턴 대학교, 캘리포니아 대학교, 버클리, 홍콩 과학 기술 대학교, CMU 논문 링크: https://arxiv.org/abs/2402.00367

논문 6: 음성 기초 모델 및 대규모 언어 모델을 사용한 음성 번역: 무엇이 있고 무엇이 빠졌나요? 저자: Marco Gaido, Sara Papi, Matteo Negri, Luisa Bentivogli -

기관: Bruno Kessler Foundation , Italy 논문 링크: https://arxiv.org/abs/2402.12025

논문 7: NLP는 추출적이어야 합니까? 저자: Steven Bird : Charles Darwin University 문서 링크: https://drive.google.com/file/d/1hvF7_WQrou6CWZydhymYFTYHnd3ZIljV/view

문서 8: IRCoder: 중간 표현으로 Robus 만들기 t 다국어 코드 생성 erators 저자: Indraneil Paul, Goran Glavaš, Iryna Gurevych 기관: TU Darmstadt 등 -

논문 링크: https://arxiv.org/abs/2403.03894 -

논문 9: MultiLegalPile: 689GB 다국어 법률 자료 저자: Matthias Stürmer, Veton Matoshi 등 기관: 베른 대학교, 스탠포드 대학교 등 논문 링크: https:/ /arxiv.org/pdf/2306.02069

문서 10: PsySafe: 다중 에이전트 시스템 안전의 심리적 기반 공격, 방어 및 평가를 위한 포괄적인 프레임워크 저자: Zaibin Zhang, Yongting Zhang , Lijun Li , Hongzhi Gao, Lijun Wang, Huchuan Lu, Feng Zhao, Yu Qiao, Jing Shao 기관: 중국 대련 공과대학, 중국 과학 기술 대학 상하이 인공 지능 연구소 논문 링크: https://arxiv .org/pdf/2401.11880

논문 11: 감정적 지지 대화에 대한 선호 편향 완화 저자: 강동진 , 김성환 외 기관 : 연세대 등 논문 링크 : https://arxiv.org/pdf/2402.13211

논문 12 : 정치컴 합격하거나 Spinning Arrow? 대형 언어 모델의 가치와 의견에 대한 보다 의미 있는 평가를 향하여 저자: Paul Röttger, Valentin Hofmann 등 기관: Bocconi University, Allen Institute for Artificial Intelligence 등 논문 링크: https://arxiv.org/pdf/ 2402.16786

문서 13: 동일한 작업, 더 많은 토큰: 입력 길이가 대규모 언어 모델의 추론 성능에 미치는 영향 저자: Mosh Levy, Alon Jacoby, Yoav Goldberg 기관: 파키스탄 Elan University, Allen Institute for Artificial Intelligence 논문 링크: https://arxiv.org/pdf/2402.14848

논문 14: 라마가 다국어의 잠재 언어에서 작동합니까? Transformers 저자: Chris Wendler, Veniamin Veselovsky 등 -

기관: EPFL - 문서 15: 유머에 대해 진지하게 생각하기: 재미없는 대형 언어 모델로 유머 데이터세트 만들기

- 기관: Columbia University, EPFL

- 논문 링크: https://arxiv.org/pdf/2403.00794

- 논문 16: 방언 다방어 아랍어 데이터 세트의 주석 간 일치 예측

- 기관: University of Edinburgh

- 문서 링크: https://arxiv.org/pdf /2405.11282

- 논문 17: G-DlG: 그라데이션 기반 Dlverse 및 기계 번역을 위한 고품질 명령어 데이터 선택을 향하여

- 기관: ByteDance Research

- 논문 링크: https://arxiv.org/pdf/2405.12915

-

- 논문 19: SPZ: 알츠하이머병 탐지를 위한 구역 혼합을 사용한 의미론적 교란 기반 데이터 증강 방법

- 페이퍼 20: 탐욕만 있으면 됩니다: 토크나이저 추론 방법 평가

- 기관: Ben Guri, Negev Ann University, MIT

- 논문 링크: https://arxiv.org/abs/2403.01289

- 기관: University of Notre Dame(미국)

- 저자: Chihiro Taquchi, David Chiang

- 논문 링크: https://arxiv.org/abs/2406.09202

- 기관: Anthropic, Harvard University, University of Göttingen(독일), Center for Human-Compatible AI

- 저자: Nina Rimsky, Nick Gabrieli, Julian Schulz, Meg Tong, Evan J Hubinger, Alexander Matt Turner

- 논문 링크: https://arxiv.org/abs/2312.06681

- 기관: Tsinghua University - Shenzhen International Graduate School, Tsinghua University

- 저자: Nian Li, Chen Gao , Mingyu Li, Yong Li, Qingmin Liao

- 논문 링크: https: //arxiv.org/abs/2310.10436

- 기관 : 홍콩 중문 대학교, 화웨이 노아의 방주 연구소, 홍콩 과학 기술 대학교

- 저자: Wai-Chung Kwan, Xingshan Zeng, Yufei Wang, Yusen Sun, Liangyou Li, Lifeng Shang, Qun Liu, Kam- Fai Wong

- 논문 링크: https://arxiv.org/abs/2310.19240

- 저자 : Jiasheng Si, Yibo Zhao, Yingjie Zhu, Haiyang Zhu, Wenpeng Lu, Deyu Zhou

- 논문 26: U darmstadt, Apple Inc.

- 논문 27: 에뮬레이션된 불일치: 안전 정렬 대규모 언어 모델의 경우 역효과가 발생할 수 있습니다!

- 저자: Zhanhui Zhou, Jie Liu, Zhichen Dong, Jiaheng Liu, Chao Yang, Wanli Ouyang, Yu Qiao

- 기관: Shanghai Artificial Intelligence Laboratory

- 문서 28: IndicLLMSuite: 인도어용 사전 훈련 및 미세 조정 데이터 세트 생성을 위한 청사진

- 저자: Mohammed Safi Ur Rahman Khan, Priyam Mehta, Ananth Sankar 등

- 기관: AI4Bharat의 Nilekani Center, Indian Institute of Technology(Madras), Microsoft 등

- 논문 29: MultiPICo: 다국어 관점주의자 lrony Corpus

- 저자: Silvia Casola, Simona Frenda, Soda Marem Lo, Erhan Sezerer 등

- 논문 30: MMToM-QA: 다중 모드 이론 질문 응답

- 저자: Chuanyang Jin, Yutong Wu, Jing Cao, jiannan Xiang 등

- 기관: New York University, Harvard University, MIT, University of California, San Diego, University of Virginia, Johns Hopkins University

- 논문 31: MAP는 그렇지 않습니다 아직 죽었습니다: 타락을 조건화하여 진정한 언어 모델 모드 발견

- 저자: Davis Yoshida, Kartik Goyal, Kevin Gimpel

- 기관: Toyota Institute of Technology Chicago, Georgia Institute of Technology

- Paper 32 : Nounatlas : 공칭 의미 론적 역할 라벨링에서 간격을 채우는 사람 : Roberto Navigli, Marco Lo Pinto, Pasquale Silvestri 등

- 저자: Rongwu Xu, Brian S. Lin, Shujian Yang, Tiangi Zhang 등

- 기관: 칭화 대학교, 상하이 자오퉁 대학교, 스탠포드 대학교, 난양 기술 대학교

- 논문 링크: https://arxiv.org/pdf/2312.09085

- Paper 34: Let's Go Real Talk: 대면 대화를 위한 음성 대화 모델

- 저자: 박세진, 김채원, 나형섭, 김민수 등

- 기관: 한국과학기술원 (KAIST)

- 논문 링크: https://arxiv.org/pdf/2406.07867

- 논문 35 :Word Embeddings Are Steers for Language Models

- 저자: Chi Han, 자량 Xu, Manling Li, Yi Fung, Chenkai Sun, Nan Jiang, Tarek F. Abdelzaher, Heng Ji

- 기관: University of Illinois at Urbana - Champaign

- 논문 링크: https://arxiv.org/pdf /2305.12798

- 베스트테마논문상

저자: Dirk Groeneveld, Iz Beltagy 등 기관: Allen Institute for Artificial Intelligence, University of Washington 등 논문 링크: https://arxiv.org/pdf/2402.00838 저자: Julen Etxaniz, Oscar Sainz, Naiara Perez, Itziar Aldabe, German Rigau, Eneko Agirre, Aitor Ormazabal, Mikel Artetxe, Aitor Soroa 링크: https://arxiv.org/pdf/2403.20266 기관: Allen Institute for Artificial Intelligence, University of California, Berkeley 등 -

저자 : Luca Soldaini, Rodney Kinney 등 링크 : https://arxiv.org/abs/2402.00159 기관: 뉴욕 주립대학교 Stony Brook, Allen 인공 지능 연구소 등 -

저자: Harsh Trivedi, Tushar Khot 등 링크: https://arxiv.org/abs/2407.18901 -

저자: Yi Zeng, Hongpeng Lin, Jingwen Zhang, Diyi Yang 등 . 기관: 버지니아 공대, 중국 인민 대학교, 캘리포니아 대학교, 데이비스, 스탠포드 대학교 논문 링크: https://arxiv.org/pdf/2401.06373 -

저자: Fahim Faisal, Orevaoghene Ahia, Aarohi Srivastava, Kabir Ahuja 등 기관: 조지 메이슨 대학교, 워싱턴 대학교, 노트르담 대학교, RC Athena 논문 링크: https://arxiv.org/pdf/2403.11009 저자: Tarek Naous, Michael J. Ryan, Alan Ritter, Wei Xu 기관: Georgia Institute of Technology 논문 링크: https://arxiv.org/pdf/2305.14456

논문: OLMo: Accelerated the Science of Language Models 인용: 이 작업은 대규모 언어 모델 훈련의 투명성과 재현성을 향한 중요한 단계이며, 이는 커뮤니티가 달성하고 있는 것입니다. 발전을 위해 많이 필요합니다. (또는 적어도 업계 거대 기업이 아닌 다른 연구자가 기여할 수 있도록). 자원논문상 3편의 논문이 자원논문상을 수상했습니다. 논문 1: Latxa: 바스크어를 위한 개방형 언어 모델 및 평가 제품군 기관: 스페인 바스크 지방 대학교 수상 사례: 이 논문은 다음과 같이 설명합니다. 코퍼스 컬렉션 세부정보, 데이터세트 평가 세부정보. 바스크어 연구와 관련이 있지만 이 방법론은 자원이 적은 다른 언어에 대한 대규모 모델 구축으로 확장될 수 있습니다. 논문 2: Dolma: 언어 모델 사전 훈련 연구를 위한 3조 토큰의 공개 코퍼스 수상 이유 : 이 논문은 준비 시 데이터 관리의 중요성을 보여줍니다. 대규모 언어 모델 훈련을 위한 데이터 세트. 이는 커뮤니티 내의 다양한 사람들에게 매우 귀중한 통찰력을 제공합니다. 문서 3: AppWorld: 대화형 코딩 에이전트 벤치마킹을 위한 제어 가능한 앱 및 사람의 세계 수상 이유: 이 연구는 매우 중요하고 놀랍습니다. 대화형 환경 시뮬레이션 및 평가 작업을 구축합니다. 이는 모든 사람이 커뮤니티를 위한 보다 하드코어한 동적 벤치마크를 생성하도록 장려할 것입니다. Social Impact Award 3편의 논문이 Social Impact Award를 수상했습니다. 문서 1: Johnny가 LLM을 설득하여 탈옥하는 방법: LLM을 인간화하여 AI 안전에 도전하는 설득에 대한 재고 이유 수상: 이 기사에서는 AI 보안(탈옥)이라는 주제를 탐구하고 사회 과학 연구 분야에서 개발된 방법을 검토합니다. 이 연구는 매우 흥미롭고 지역사회에 중대한 영향을 미칠 가능성이 있습니다. 문서 2: DIALECTBENCH: 방언, 종류 및 밀접하게 관련된 언어에 대한 NLP 벤치마크 수상 인용: 방언 변형 NLP와 인공지능의 중요한 영역입니다. 아직 연구가 덜 된 현상입니다. 그러나 언어와 사회의 관점에서 볼 때 그 연구는 매우 높은 가치를 가지며 응용에 있어 중요한 의미를 갖는다. 본 논문은 LLM 시대에 이러한 문제를 연구하기 위한 매우 새로운 벤치마크를 제안합니다. 문서 3: 기도 후 맥주를 마시나요? 대규모 언어 모델에서 문화적 편견 측정 수상 이유: 이 기사는 LLM 시대의 중요한 문제인 문화적 편견을 보여줍니다.본 논문에서는 아랍 문화와 지역을 조사했으며 그 결과 LLM을 설계할 때 문화적 차이를 고려해야 함을 보여줍니다. 따라서 동일한 연구를 다른 문화권에서도 재현하여 다른 문화권도 이 문제의 영향을 받는지 일반화하고 평가할 수 있습니다.

위 내용은 ACL 2024 시상식 발표: HuaTech의 Oracle 해독에 관한 최고의 논문 중 하나, GloVe Time Test Award의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Java 架构 Resource for Length map 事件 input li 线性回归 oracle 人工智能 transformer nlp https proteus 重构 自动化 kong gpt llama Access word Foundation

성명:

본 글의 내용은 네티즌들의 자발적인 기여로 작성되었으며, 저작권은 원저작자에게 있습니다. 본 사이트는 이에 상응하는 법적 책임을 지지 않습니다. 표절이나 침해가 의심되는 콘텐츠를 발견한 경우 admin@php.cn으로 문의하세요.