AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com zhaoyunfeng@jiqizhixin.com

이 기사의 저자는 Zhang Junpeng, Ren Qihan 및 Zhang Quanshi입니다. 그중 Zhang Junpeng은 Zhang Quanshi의 박사 과정 학생이고 Ren Qihan은 Zhang Quanshi의 박사 과정 학생입니다. 이 기사에서는 먼저 "Equivalent Interaction Interpretability Theoretical System"(CCF-A 및 ICLR 논문 20편)을 간략하게 검토하고, 이를 바탕으로 동적 신경망의 성능을 엄격하게 추론하고 예측합니다. 훈련 과정 중 개념적 표현과 일반화의 변화, 즉 훈련 과정 중 어느 시점에서든 신경망의 일반화와 내부 근본 원인을 어느 정도 설명할 수 있습니다. 우리 팀은 오랫동안 해석성 분야의 궁극적인 질문, 즉 해석성 분야의 첫 번째 원칙은 무엇인가를 고민해 왔습니다 ? 소위 첫 번째 원칙은 현재 널리 받아들여지는 틀이 없습니다. 우리는 그러한 방식을 점진적으로 정의할 필요가 있습니다. 우리는 새로운 이론 시스템에서 수많은 공리적 요구 사항을 제시하고 신경망의 내부 메커니즘을 다양한 각도에서 정확하고 엄격하게 설명할 수 있는 이론을 제시해야 합니다. 신경망의 모든 측면을 엄격하게 설명할 수 있는 이론적 시스템을 "제1원리"라고 합니다. 정말로 "과학"을 엄격하게 수행하고 있다면 첫 번째 원칙은 상상만큼 단순하지 않고 딥 러닝의 모든 측면에 대한 연구와 고려가 필요한 복잡한 시스템이어야 합니다. 물론, 주관적으로 거부하거나 이론이 충분히 엄격해야 한다고 믿지 않는다면 연구가 수백만 배 더 쉬워질 것입니다. 물리학의 표준 모델이 어떤 경로를 선택하느냐에 따라 뉴턴의 법칙보다 더 복잡해져야 하는 것처럼 말입니다. 이 방향에 따라 우리 팀은 "등가 상호 작용 해석 가능성 이론 시스템"을 처음부터 독립적으로 구축했으며, 이 이론을 기반으로 신경망의 본질적인 메커니즘을 세 가지 관점에서 설명했습니다. 1. 의미론적 설명의 이론적 기초: 신경망의 의사결정 논리가 소량의 기호 논리로 완전히 포괄(완전히 설명)될 수 있는지 수학적으로 증명합니다. "신경망의 의사결정 논리가 제한된 기호 논리로 명확하게 설명될 수 있는지 증명"이 명제는 신경망을 설명하는 기본 명제입니다. 이 명제가 위조되면 근본적으로 신경망의 해석 가능성은 절망적일 것이며 모든 해석 알고리즘은 대략적인 해석만 제공할 수 있을 뿐 모든 의사 결정 논리를 정확하게 다룰 수는 없습니다. 다행스럽게도 우리는 신경망이 대부분의 응용에서 만족할 수 있는 폐색 지향 강인성에 대한 세 가지 공통 조건을 찾았고, 이 세 가지 조건을 만족하는 신경망의 결정 논리가 상징적으로 상호 작용 개념으로 작성될 수 있음을 수학적으로 증명했습니다.

https://zhuanlan.zhihu.com/p/6937479462 참조: 신경망 일반화와 견고성 결합 궁극적인 성과 지표의 근본 원인. 성능 등은 몇 가지 세부 로직으로 분류됩니다

. 신경망 성능(강건성, 일반화)의 해석은 신경망 해석 분야에서 또 다른 중요한 문제입니다. 그러나 현재 일반적으로 신경망 성능은 신경망 전체에 대한 설명이며 신경망은 분류 판단을 인간처럼 구체적이고 작은 양의 의사 결정 논리로 분해할 수 없습니다. 이와 관련하여 우리는 성과 지표와 구체적인 상호 작용 사이의 수학적 관계를 설정하는 다른 관점을 제시합니다. 우리는 1. 등가 상호작용의 복잡성이 신경망의 적대적 견고성/전이성을 직접 결정할 수 있고, 2. 상호작용의 복잡성이 신경망의 표현 능력을 결정하며, 3. 신경망의 일반화 능력을 설명한다는 것을 증명했습니다[1]. 4. 신경망의 표현 병목 현상을 설명합니다. 참조 1: https://zhuanlan.zhihu.com/p/369883667참조 2: https://zhuanlan.zhihu.com/p/361686461참조 3: https://zhuanlan.zhihu.com/p/7047603634 참조: https://zhuanlan.zhihu.com/p/468569001

3. 기본적인 이론적 지원이 부족하기 때문에 대부분의 최신 딥러닝 알고리즘은 경험적이며 공학적입니다. 설명 가능성 분야의 첫 번째 원리는 이전 세대의 방대한 공학 경험을 과학 법칙으로 요약하는 작업을 수행할 수 있어야 합니다. 등가 상호 작용 해석 가능성 이론 시스템 하에서 우리 팀은 14가지 서로 다른 입력 중요도 귀인 알고리즘의 계산 특성이 상호 작용 재분배의 형태로 수학적으로 통합될 수 있음을 입증했습니다. 또한, 우리는 적대적 전달성을 향상시키기 위한 12개의 알고리즘을 통합하고 적대적 전달성을 향상시키기 위한 모든 알고리즘의 공통 메커니즘이 적대적 섭동 간의 상호 작용 효과를 줄이는 것임을 입증하여 이론적으로 신경망 해석성 방향으로 엔지니어링 기능의 대부분을 달성했습니다. 알고리즘의 압축.

- 1번 보기: https://zhuanlan.zhihu.com/p/610774894

- 2번 보기: https://zhuanlan.zhihu.com/p/546433296

동등한 대화형 해석 가능성 이론 시스템 하에서 우리 팀은 이전 연구에서 20개의 CCF-A 및 기계 학습 최고 컨퍼런스 ICLR 논문을 성공적으로 출판했습니다. 이론적으로나 실험적으로 위의 질문에 완전히 답했습니다. 위의 이론적 틀을 따라 이 Zhihu 기사에서는 신경망 훈련 과정에서 일반화의 변화하는 규칙을 구체적으로 설명하기를 희망합니다. 두 개의 논문이 관련되어 있습니다.

- 1.Junpeng Zhang, Qing Li, Liang Lin, Quanshi Zhang, "상호작용의 2단계 역학은 DNN의 과잉 맞춤 기능 학습의 시작점을 설명합니다", arXiv: 2405.10262

- 2.Qihan Ren, Yang Xu, Junpeng Zhang, Yue Xin, Dongrui Liu, Quanshi Zhang, arXiv의 "DNN 학습 상징적 상호 작용의 역학을 향하여":2407.19198

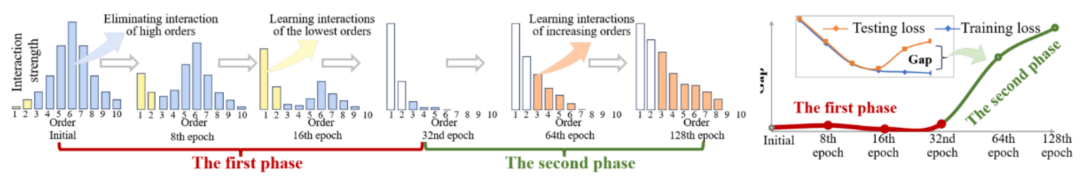

그림 1: 2단계 현상의 개략도. 첫 번째 단계에서 신경망은 점차적으로 중간 및 고차 상호작용을 제거하고, 두 번째 단계에서 신경망은 점차적으로 증가하는 차수의 상호작용을 모델링합니다. 신경망 훈련 과정에서 테스트 손실과 훈련 손실 사이의 손실 격차가 커지기 시작하면 신경망은 우연히 훈련의 두 번째 단계에 진입하게 됩니다. 각 시점에서 신경망이 학습한 상호 작용 개념의 수, 복잡성 및 일반화 변화를 정확하게 예측하기 위해 등가 상호 작용 프레임워크에서 새로운 이론을 제안하고자 합니다. (그림 1에 표시). 구체적으로 우리는 두 가지 결론을 증명하기를 희망합니다. 먼저, 이전 증명(신경망의 의사 결정 논리는 엄격하게 해체되어 수십 가지 대화형 개념의 유용성의 합으로 표현될 수 있음)을 기반으로 전체 훈련 과정에서 이를 더욱 엄격하게 추론했습니다. , 신경망 모델링된 상호 작용 유틸리티의 동적 변화 과정 -

즉, 이론은 다양한 훈련 단계에서 신경망에 의해 모델링된 상호 작용 개념의 분포 변화를 정확하게 예측해야 하며 어떤 상호 작용이 발생할지 추론해야 합니다. 배운 시점에 사용됨 . 두 번째로, 파생된 상호 작용 복잡성의 변화하는 규칙이

학습 주기 전반에 걸쳐 신경망 일반화의 변화하는 규칙을 객관적으로 반영한다는 것을 증명할 수 있는 충분한 증거를 찾으세요. 위의 두 가지 사항을 요약하면 신경망의 일반화 변화에 대한 내부 근본 원인을 철저하게 설명할 수 있기를 바랍니다.

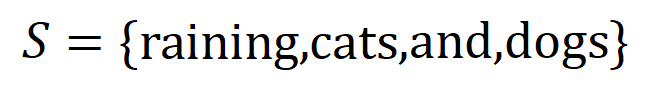

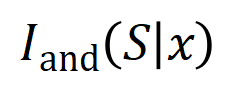

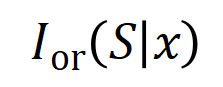

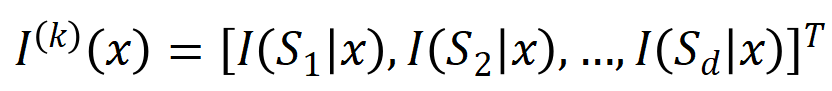

전임자와의 관계: 물론 누구나 처음에는 신경 접선 커널(NTK)[2]을 생각할 수 있지만 신경 접선 커널은 매개변수 변경 곡선만 풀 뿐 더 이상 설명할 수 없습니다. 의사결정 논리 수준에서는 신경망 모델링의 개념적 표현과 일반화 간의 관계를 확립하지 못하며, 일반화 분석은 여전히 특징 공간 분석 수준에 머물고 있으며, [기호화된 개념 논리]와 [ 기호화 된 개념 논리]. 일반화 가능성 사이에는 엄격한 관계가 설정됩니다. 오해 1: 신경망의 일차적 표현은 신경망의 매개변수와 구조가 아닌 "등가 상호작용"입니다. 신경망을 구조적 수준에서만 분석하는 것은 신경망 일반화의 기본 표현을 오해하는 것입니다. 현재 대부분의 신경망 일반화 연구는 주로 신경망의 구조, 특성, 데이터에 초점을 맞추고 있습니다. 서로 다른 신경망 구조는 자연스럽게 서로 다른 기능에 대응하고 자연스럽게 서로 다른 성능을 발휘한다고 믿어집니다. 그러나 실제로 그림 2에서 볼 수 있듯이 구조의 차이는 신경망 표현의 피상적인 형태일 뿐입니다. 성능에 중대한 영향을 미치는 명백한 결함이 있는 신경망을 제외하고, SOTA 성능을 달성할 수 있는 다른 구조를 가진 다른 모든 신경망은 종종 유사한 등가 상호 작용 표현을 모델링합니다. 즉, 다른 구조를 가진 고성능 신경망은 대화형 표현과 동일합니다. 종종 다른 접근 방식을 통해 동일한 목표로 이어집니다 [3, 4]. 신경망의 내부 특징은 복잡하고 혼란스러울지라도, 서로 다른 신경망에 의해 모델링된 특징 벡터는 매우 다르고, 신경망의 개별 뉴런은 상대적으로 혼란스러운 의미론(엄격히 명확한 의미론은 아님)을 모델링하는 경우가 많지만, 신경망의 경우 네트워크 전체로서 우리는 신경망에 의해 모델링된 상호 작용 관계가 희박하고 상징적이며(자세한 내용은 "4. 상호 작용의 정의" 장 참조) 동일한 작업을 지향한다는 것을 이론적으로 증명합니다. 서로 다른 신경망은 종종 유사한 상호 작용을 모델링합니다. 그림 2: 서로 다른 구조를 가진 신경망으로 모델링된 등가 상호 작용은 종종 동일한 목표로 이어집니다. 동일한 입력 문장의 경우 동일한 작업을 대상으로 하는 완전히 다른 두 개의 신경망이 유사한 상호 작용을 모델링하는 경우가 많습니다. 다양한 신경망의 다양한 매개변수와 훈련 샘플로 인해 두 신경망의 어떤 뉴런도 표현에서 엄격한 일대일 대응을 갖지 않으며 각 뉴런은 종종 서로 다른 의미 혼합 패턴을 모델링합니다. 대조적으로, 이전 단락에서 분석한 바와 같이, 신경망에 의해 모델링된 대화형 표현은 실제로 다양한 신경망 표현에서 불변입니다. 따라서 우리는 신경망의 기본 표현이 캐리어(매개변수 및 훈련 샘플)가 아닌 등가 상호작용이라고 믿을 만한 이유가 있습니다. 서로 다른 경로를 통해 동일한 목적지에 도달하는 현상은 "4. 상호 작용의 정의" 장에서 제공됩니다. 자세한 연구는 아래 Zhihu 기사를 참조하세요. 참조: https://zhuanlan.zhihu.com /p/633531725 오해 2: 신경망의 일반화 문제는 혼합 모델 문제이지 고차원 공간의 벡터가 아닙니다 그림 3에서 볼 수 있듯이 전통적인 일반화 분석에서는 항상 단일 모델을 가정합니다. 샘플은 전체입니다. 실제로 신경망에 의한 단일 샘플의 표현은 혼합 모델의 형태입니다. 실제로는 다양한 상호 작용을 통해 표현됩니다. 단순 상호작용의 일반화 능력은 복잡한 상호작용의 일반화 능력보다 강력하므로, 서로 다른 샘플에 대한 전체 신경망의 일반화 능력을 일반적으로 표현하기 위해 단순 스칼라를 사용하는 것은 더 이상 적합하지 않습니다. 서로 다른 샘플의 서로 다른 복잡성의 상호 작용 관계는 종종 서로 다른 일반화 기능에 해당합니다. 일반적으로 신경망으로 모델링된 고차(복잡한) 상호 작용은 테스트 샘플로 일반화하기 어려운 경우가 많습니다(동일한 상호 작용은 테스트 샘플에서 트리거되지 않습니다). 과적합 표현을 나타내는 , 신경망으로 모델링된 저차(단순) 상호 작용은 종종 강력한 일반화 표현을 나타냅니다.그림 3: (a) 전통적인 일반화 분석에서는 항상 단일 샘플 전체가 고차원 공간의 한 점이라고 가정합니다. (b) 실제로 신경망은 단일 표본을 혼합 모델 형태로 표현하는데, 신경망은 단일 표본에 대한 단순한 상호 작용(일반화 가능한 상호 작용)과 복잡한 상호 작용(비일반화 가능한 상호 작용)을 모델링합니다. 4. 상호작용의 정의 에 대한 DNN의 스칼라 출력을 나타냅니다. 분류 작업을 지향하는 신경망의 경우 다양한 관점에서 스칼라 출력을 정의할 수 있습니다. 예를 들어, 다중 카테고리 분류 문제의 경우 는 로 정의되거나 소프트맥스 레이어 이전 샘플의 실제 레이블에 해당하는 스칼라 출력으로 정의될 수 있습니다. 여기서 는 실제 레이블의 분류 확률을 나타냅니다. 이러한 방식으로 각 하위 집합 에 대해 다음 공식을 사용하여 의 모든 입력 변수 간의 "동등성 및 상호 작용"과 "동등성 또는 상호 작용"을 정의할 수 있습니다.

그림 4(a)에서 볼 수 있듯이 위의 AND 또는 상호 작용은 다음과 같이 이해할 수 있습니다. AND 등가 상호 작용은 신경망에 의해 인코딩된

그림 4(a)에서 볼 수 있듯이 위의 AND 또는 상호 작용은 다음과 같이 이해할 수 있습니다. AND 등가 상호 작용은 신경망에 의해 인코딩된  의 입력 변수 간의 "AND 관계"를 나타낸다고 생각할 수 있습니다. 예를 들어, 입력 문장

의 입력 변수 간의 "AND 관계"를 나타낸다고 생각할 수 있습니다. 예를 들어, 입력 문장  이 주어지면 신경망은

이 주어지면 신경망은  간의 상호 작용을 모델링하여

간의 상호 작용을 모델링하여  이 신경망의 출력 "폭우"를 유도하는 수치 유틸리티를 생성할 수 있습니다.

이 신경망의 출력 "폭우"를 유도하는 수치 유틸리티를 생성할 수 있습니다.  의 입력 변수가 가려지면 해당 수치 유틸리티가 신경망의 출력에서 제거됩니다. 마찬가지로 동등성 또는 상호 작용

의 입력 변수가 가려지면 해당 수치 유틸리티가 신경망의 출력에서 제거됩니다. 마찬가지로 동등성 또는 상호 작용  은 신경망으로 모델링된

은 신경망으로 모델링된  내의 입력 변수 간의 "OR 관계"를 나타냅니다. 예를 들어 입력 문장

내의 입력 변수 간의 "OR 관계"를 나타냅니다. 예를 들어 입력 문장  이 있을 때

이 있을 때  에 있는 단어가 나타나면 신경망의 출력을 구동하여 부정적인 감정을 분류합니다. 신경망으로 모델링한 등가 상호작용은 "이상적 개념"의 세 가지 공리적 기준, 즉 무한 피팅, 희소성 및 샘플 간의 전달 가능성을 충족합니다.

에 있는 단어가 나타나면 신경망의 출력을 구동하여 부정적인 감정을 분류합니다. 신경망으로 모델링한 등가 상호작용은 "이상적 개념"의 세 가지 공리적 기준, 즉 무한 피팅, 희소성 및 샘플 간의 전달 가능성을 충족합니다.

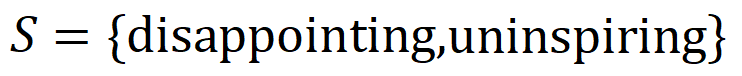

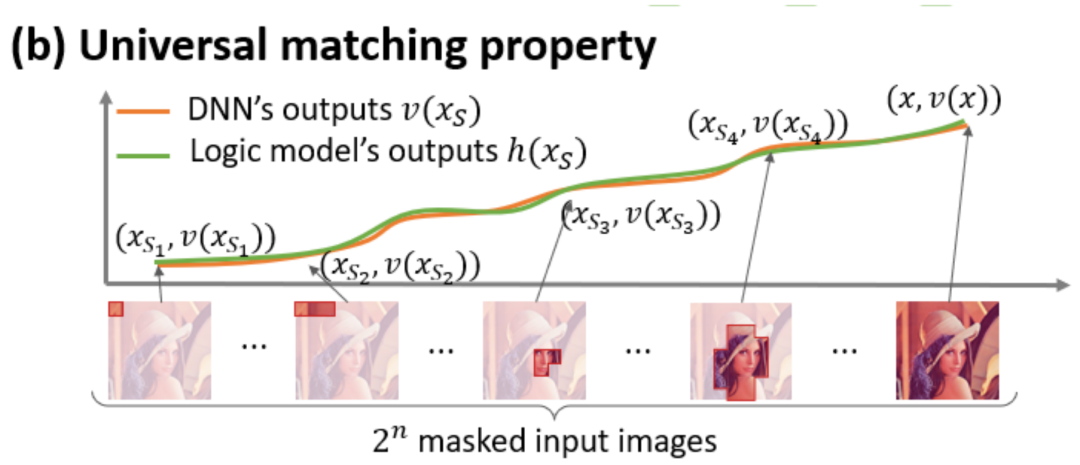

- 무한 피팅: 그림 4와 5에 표시된 것처럼 모든 폐색 샘플에 대해 샘플의 신경망 출력은 다양한 상호 작용 개념의 유틸리티 합계로 맞춰질 수 있습니다. 즉, 입력 샘플을 어떻게 차단하더라도 이 논리 모델은 입력 샘플의 모든 차단 상태에서 모델의 출력 값을 정확하게 맞출 수 있습니다.

- Sparsity: 분류 작업을 위한 신경망은 소수의 중요한 대화형 개념만 모델링하는 경우가 많으며 대부분의 대화형 개념은 수치적 유용성이 0에 가까운 노이즈입니다.

- 샘플 간 전송 가능성: 상호 작용은 서로 다른 샘플 간에 전송 가능합니다. 즉, (동일 카테고리의) 서로 다른 샘플의 신경망을 통해 모델링된 중요한 상호 작용 개념은 종종 크게 중복됩니다.

그림 4: 신경망의 복잡한 추론 논리는 소수의 상호 작용  을 기반으로 하는 논리 모델을 통해 정확하게 맞출 수 있습니다. 각 상호 작용은 특정 입력 변수 세트(

을 기반으로 하는 논리 모델을 통해 정확하게 맞출 수 있습니다. 각 상호 작용은 특정 입력 변수 세트( )를 모델링하는 신경망 간의 비선형 관계를 측정한 것입니다. 세트의 변수가 동시에 나타날 때만 트리거되고 상호 작용하며 출력

)를 모델링하는 신경망 간의 비선형 관계를 측정한 것입니다. 세트의 변수가 동시에 나타날 때만 트리거되고 상호 작용하며 출력  에 숫자 점수를 제공합니다. 세트의 변수

에 숫자 점수를 제공합니다. 세트의 변수  가 나타나면 트리거되거나 상호 작용합니다.

가 나타나면 트리거되거나 상호 작용합니다.

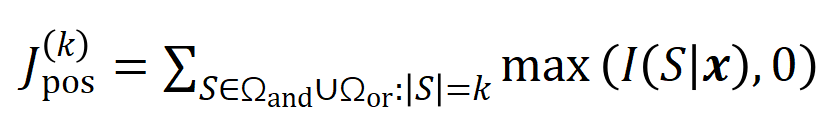

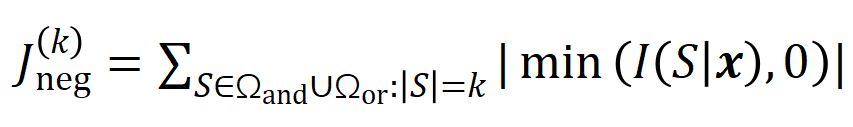

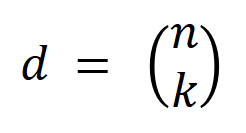

그림 5: 모든 폐색 샘플에 대한 신경망의 출력은 다양한 상호 작용 개념의 유틸리티 합계로 맞춰질 수 있습니다. 즉, 입력을 어떻게 폐색하더라도 상호 작용을 기반으로 논리 모델을 구성할 수 있습니다. 예를 들어, 입력 장치에 완전히 다른 폐색 방법이 주어지면 이 논리 모델은 어떤 폐색 상태에서도 모델 입력 샘플의 출력 값을 여전히 정확하게 맞출 수 있습니다. 5.1 훈련 중 신경망의 대화식 변화의 2 단계 현상을 발견했습니다.이 Zhihu 기사에서 우리는 신경망 해석 가능성 분야의 근본적인 문제, 즉 훈련 과정에서 신경망의 일반화 능력의 변화를 분석적 분석 관점에서 어떻게 엄격하게 예측하고, 신경망의 과소적합에서 과적합으로의 전환을 정확하게 분석할 것인가 하는 문제입니다. 피팅의 전체 동적 변화 과정과 그 이면의 근본 원인 . 먼저 상호작용의 순서(복잡성)를 상호작용의 입력 변수 수 로 정의합니다. 우리 팀의 이전 연구에서는 특정 샘플의 신경망에 의해 모델링된 “또는 상호 작용”의 복잡성이 이 샘플[1]의 신경망의 일반화 능력, 즉 신경망의 고차 수준을 결정하는 것으로 나타났습니다. 네트워크 모델링 "AND-OR 상호 작용"(다수 입력 단위 간)은 일반화 기능이 떨어지는 경향이 있는 반면, 하위 "AND-OR 상호 작용"(소수 입력 단위 간)은 일반화 기능이 강력합니다. 따라서 이 연구의 첫 번째 단계는 훈련 과정 중 서로 다른 시점에서 신경망에 의해 모델링된 "AND-OR 상호 작용"의 다양한 순서의 복잡성에 대한 분석 솔루션을 예측하는 것입니다. 서로 다른 단계에서 신경망의 일반화 능력은 서로 다른 시점에서 신경망에 의해 모델링된 "AND 또는 상호 작용"의 서로 다른 순서의 분포를 통해 설명됩니다. 상호 작용의 일반화 능력에 대한 정의와 신경망의 전반적인 일반화 능력에 대한 정의는 "5.2 신경망이 모델링한 상호 작용 순서와 일반화 능력의 관계" 장을 참조하세요.  우리는 서로 다른 순서(복잡성)의 상호 작용 강도 분포를 나타내는 두 가지 지표를 제안합니다. 구체적으로, 우리는 를 사용하여 모든 긍정적인 순서의 중요한 상호 작용의 강도를 측정하고 모든 부정적인 중요한 순서의 상호 작용의 강도를 측정합니다. 여기서 및 는 중요한 상호 작용 집합을 나타내고

우리는 서로 다른 순서(복잡성)의 상호 작용 강도 분포를 나타내는 두 가지 지표를 제안합니다. 구체적으로, 우리는 를 사용하여 모든 긍정적인 순서의 중요한 상호 작용의 강도를 측정하고 모든 부정적인 중요한 순서의 상호 작용의 강도를 측정합니다. 여기서 및 는 중요한 상호 작용 집합을 나타내고

는 중요한 순서의 임계값을 나타냅니다. 상호 작용.

그림 6: 다양한 라운드에 대해 훈련된 신경망에서 추출된 다양한 주문 상호 작용 강도

그림 6: 다양한 라운드에 대해 훈련된 신경망에서 추출된 다양한 주문 상호 작용 강도  및

및  . 다양한 데이터 세트와 다양한 작업에 대해 훈련된 다양한 신경망의 훈련 프로세스에는 2단계 현상이 있습니다. 처음 두 개의 선택된 시점은 첫 번째 단계에 속하고 마지막 두 개의 시점은 두 번째 단계에 속합니다. 신경망 훈련 과정의 두 번째 단계에 들어간 직후, 테스트 손실과 신경망 훈련 손실 사이의 손실 격차가 크게 증가하기 시작합니다(마지막 열 참조). 이는 신경망 훈련의 2단계 현상이 모델 손실 격차의 변화에 맞춰 "정렬"된다는 것을 보여줍니다. 더 많은 실험 결과를 보려면 논문을 참조하세요. 그림 6에서 볼 수 있듯이 신경망의 2단계 현상은 구체적으로 다음과 같이 나타납니다.

. 다양한 데이터 세트와 다양한 작업에 대해 훈련된 다양한 신경망의 훈련 프로세스에는 2단계 현상이 있습니다. 처음 두 개의 선택된 시점은 첫 번째 단계에 속하고 마지막 두 개의 시점은 두 번째 단계에 속합니다. 신경망 훈련 과정의 두 번째 단계에 들어간 직후, 테스트 손실과 신경망 훈련 손실 사이의 손실 격차가 크게 증가하기 시작합니다(마지막 열 참조). 이는 신경망 훈련의 2단계 현상이 모델 손실 격차의 변화에 맞춰 "정렬"된다는 것을 보여줍니다. 더 많은 실험 결과를 보려면 논문을 참조하세요. 그림 6에서 볼 수 있듯이 신경망의 2단계 현상은 구체적으로 다음과 같이 나타납니다.

- 초기화된 신경망은 주로 mid- 수준 상호작용, 고차 및 저차 상호작용은 거의 코딩되지 않으며, 다차 상호작용의 분포는 "스핀들 모양"으로 나타납니다. 무작위 초기화 매개변수를 갖는 신경망이 순수한 잡음을 모델링한다고 가정할 때, 우리는 "5.4 2단계 현상의 이론적 증명"에서 무작위 초기화 매개변수를 갖는 신경망에 의해 모델링된 서로 다른 차수의 상호작용 분포가 "스핀들 모양"을 나타낸다는 것을 입증했습니다. ", 즉, 소수의 저차 및 고차 상호작용만 모델링하고, 다수의 중차 상호작용을 모델링하는 것이다.

- 신경망 훈련의 첫 번째 단계에서는 신경망에 의해 인코딩된 고차 및 중차 상호 작용의 강도가 점차 약해지는 반면, 저차 상호 작용의 강도는 점차 증가합니다. 결국, 고차 및 중차 상호작용은 점차적으로 제거되고, 신경망은 저차 상호작용만 인코딩합니다.

- 신경망 훈련의 두 번째 단계에서는 훈련 과정에서 신경망에 의해 인코딩된 상호 작용 순서(복잡성)가 점차 증가합니다. 점점 더 복잡한 상호작용을 학습하는 과정에서 신경망 과적합의 위험도 점차 증가합니다.

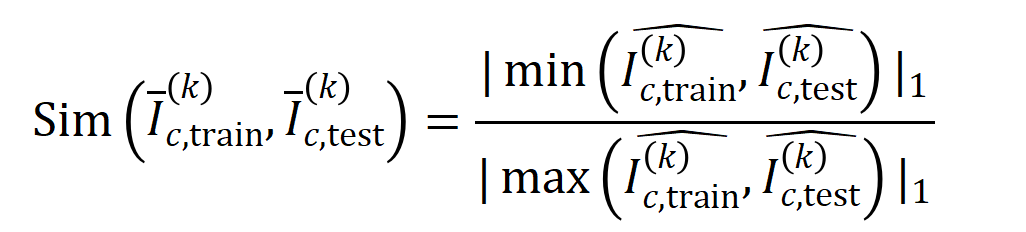

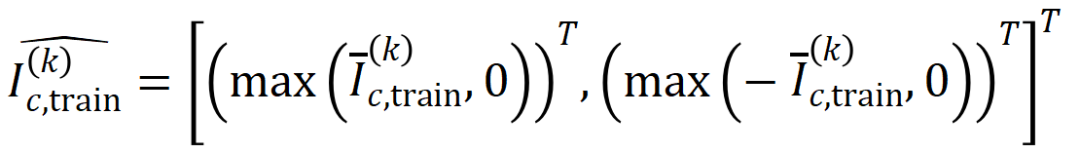

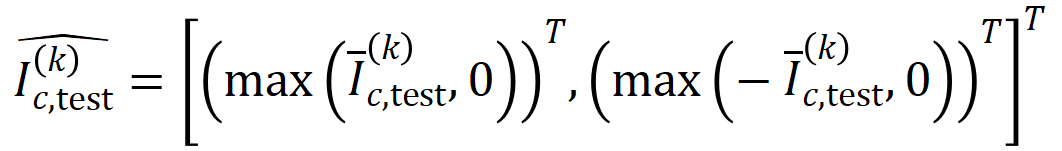

위의 2단계 현상은 다양한 작업에 대한 다양한 데이터 세트에 다양한 구조를 갖는 신경망의 훈련 과정에 널리 존재합니다. 우리는 이미지 데이터 세트(CIFAR-10 데이터 세트, MNIST 데이터 세트, CUB200-2011 데이터 세트(사진에서 자른 새 이미지 사용) 및 Tiny-ImageNet 데이터 세트)와 AlexNet에 대해 VGG-11/13/16을 교육했습니다. 우리는 SST-2 데이터세트의 감정 의미 분류를 위해 Bert-Medium/Tiny 모델을 훈련시켰고, 3D 포인트 클라우드 데이터를 분류하기 위해 ShapeNet 데이터세트에서 DGCNN을 훈련시켰습니다. 위 그림은 다양한 훈련 에포크에서 다양한 신경망에 의해 추출된 다양한 차수의 중요한 상호작용 분포를 보여줍니다. 우리는 이러한 신경망의 훈련 과정에서 2단계 현상을 발견했습니다. 더 많은 실험 결과와 자세한 내용은 논문을 참조하세요. 5.2 신경망으로 모델링한 상호작용 순서와 일반화 능력의 관계 우리 팀의 이전 연구에서는 신경망으로 모델링한 상호작용 순서와 일반화 능력 관계, 즉 , 고차 상호 작용은 저차 상호 작용보다 일반화 능력이 떨어집니다 [1]. 특정 상호 작용의 일반화 가능성은 명확하게 정의됩니다. 훈련 샘플과 테스트 샘플 모두에서 신경망에 의해 상호 작용이 자주 모델링되는 경우 이 상호 작용은 일반화 능력이 좋습니다. 이 Zhihu 기사에서는 고차 상호 작용의 일반화 기능이 좋지 않고 저차 상호 작용의 일반화 기능이 강력하다는 것을 증명하기 위해 두 가지 실험이 소개되었습니다. 실험 1: 다양한 데이터 세트에 대해 훈련된 다양한 신경망으로 모델링된 상호 작용의 일반화를 관찰합니다. 여기서는 테스트 세트에 의해 트리거된 상호 작용 분포와 훈련 세트에 의해 트리거된 상호 작용 분포 간의 Jaccard 유사성을 사용하여 상호 작용의 일반화를 측정합니다.구체적으로,  입력 변수를 포함하는 입력 샘플

입력 변수를 포함하는 입력 샘플  이 주어지면 입력 샘플

이 주어지면 입력 샘플  에서 추출된

에서 추출된  순 상호 작용을 벡터화

순 상호 작용을 벡터화  합니다. 여기서

합니다. 여기서  는

는

순 상호 작용을 나타냅니다. 그런 다음 분류 작업에서 카테고리

순 상호 작용을 나타냅니다. 그런 다음 분류 작업에서 카테고리  가 있는 모든 샘플에서 추출된 순서

가 있는 모든 샘플에서 추출된 순서  의 평균 상호 작용 벡터를 계산합니다. 여기서

의 평균 상호 작용 벡터를 계산합니다. 여기서  는 카테고리

는 카테고리  가 있는 샘플 집합을 나타냅니다.다음으로, 분류 작업에서 카테고리

가 있는 샘플 집합을 나타냅니다.다음으로, 분류 작업에서 카테고리  를 갖는 샘플의

를 갖는 샘플의  를 측정하기 위해 훈련 샘플에서 추출된 순서

를 측정하기 위해 훈련 샘플에서 추출된 순서  의 평균 상호 작용 벡터

의 평균 상호 작용 벡터  와 테스트 샘플에서 추출된 순서

와 테스트 샘플에서 추출된 순서  의 평균 상호 작용 벡터 간의 Jaccard 유사성을 계산합니다. 순서 상호 작용의 일반화 능력, 즉

의 평균 상호 작용 벡터 간의 Jaccard 유사성을 계산합니다. 순서 상호 작용의 일반화 능력, 즉

where,

where,  및

및  는 Jaccard 유사성을 계산하기 위해 두 개의

는 Jaccard 유사성을 계산하기 위해 두 개의  차원 상호 작용 벡터를 두 개의 차원 비음수 벡터에 투영합니다. 특정 순서의 상호작용에 대해 일반적으로 이 상호작용 순서가 큰 Jaccard 유사성을 보인다면 이는 이 상호작용 순서가 강력한 일반화 능력을 가지고 있음을 의미합니다.

차원 상호 작용 벡터를 두 개의 차원 비음수 벡터에 투영합니다. 특정 순서의 상호작용에 대해 일반적으로 이 상호작용 순서가 큰 Jaccard 유사성을 보인다면 이는 이 상호작용 순서가 강력한 일반화 능력을 가지고 있음을 의미합니다.  다양한 상호작용 순서를 계산하는 실험을 진행했습니다

다양한 상호작용 순서를 계산하는 실험을 진행했습니다 . 우리는 MNIST 데이터세트로 훈련된 LeNet, CIFAR-10 데이터세트로 훈련된 VGG-11, CUB200-2011 데이터세트로 훈련된 VGG-13, Tiny-ImageNet 데이터세트로 훈련된 AlexNet을 테스트했습니다. 계산 비용을 줄이기 위해 상위 10개 카테고리의 평균 Jaccard 유사성만 계산했습니다. 그림 7에서 볼 수 있듯이 상호작용 순서가 증가할수록 상호작용의 Jaccard 유사성은 계속해서 감소합니다. 따라서 이는 고차 상호 작용이 저차 상호 작용보다 일반화 기능이 더 나쁘다는 것을 확인합니다. 그림 7: 훈련 샘플과 테스트 샘플에서 추출된 상호 작용 간의 Jaccard 유사성. 저차 상호작용의 상대적으로 높은 Jaccard 유사성은 저차 상호작용이 강력한 일반화 능력을 가지고 있음을 나타냅니다.

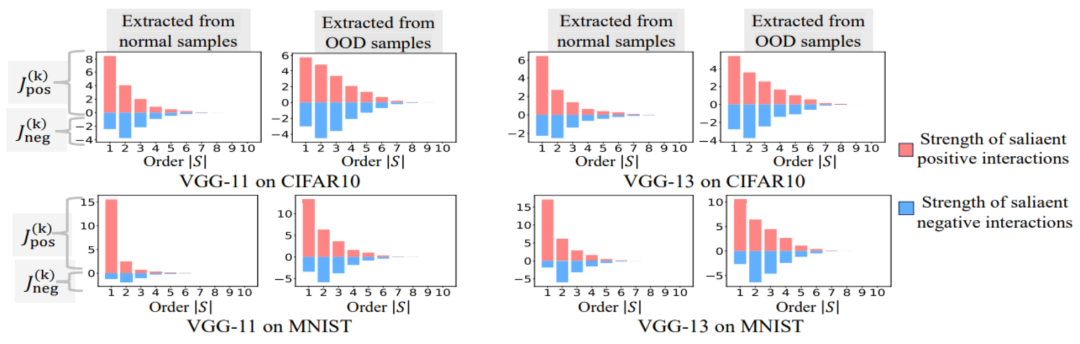

. 우리는 MNIST 데이터세트로 훈련된 LeNet, CIFAR-10 데이터세트로 훈련된 VGG-11, CUB200-2011 데이터세트로 훈련된 VGG-13, Tiny-ImageNet 데이터세트로 훈련된 AlexNet을 테스트했습니다. 계산 비용을 줄이기 위해 상위 10개 카테고리의 평균 Jaccard 유사성만 계산했습니다. 그림 7에서 볼 수 있듯이 상호작용 순서가 증가할수록 상호작용의 Jaccard 유사성은 계속해서 감소합니다. 따라서 이는 고차 상호 작용이 저차 상호 작용보다 일반화 기능이 더 나쁘다는 것을 확인합니다. 그림 7: 훈련 샘플과 테스트 샘플에서 추출된 상호 작용 간의 Jaccard 유사성. 저차 상호작용의 상대적으로 높은 Jaccard 유사성은 저차 상호작용이 강력한 일반화 능력을 가지고 있음을 나타냅니다.  实验二:比较神经网络在正常样本和 OOD 样本建模的交互的分布。我们比较了从正常样本中提取的交互与从分布外 (OOD) 样本中提取的交互,以检查神经网络在 OOD 样本上是否建模更多的高阶交互。我们将少量训练样本的分类标签设置为错误标签。这样,数据集中的原始样本可以视为正常样本,而一些带有错误标签的样本则对应于 OOD 样本,这些 OOD 样本可能会导致神经网络的过拟合。我们在 MNIST 数据集和 CIFAR-10 数据集上分别训练了 VGG-11 和 VGG-13。图 8 比较了从正常样本中提取的交互的分布和从 OOD 样本中提取的交互的分布。我们发现,VGG-11 和 VGG-13 在分类 OOD 样本时建模了更多复杂的交互(高阶交互),而在分类正常样本时则使用了较低阶的交互。这验证了高阶交互的泛化能力通常弱于低阶交互。

实验二:比较神经网络在正常样本和 OOD 样本建模的交互的分布。我们比较了从正常样本中提取的交互与从分布外 (OOD) 样本中提取的交互,以检查神经网络在 OOD 样本上是否建模更多的高阶交互。我们将少量训练样本的分类标签设置为错误标签。这样,数据集中的原始样本可以视为正常样本,而一些带有错误标签的样本则对应于 OOD 样本,这些 OOD 样本可能会导致神经网络的过拟合。我们在 MNIST 数据集和 CIFAR-10 数据集上分别训练了 VGG-11 和 VGG-13。图 8 比较了从正常样本中提取的交互的分布和从 OOD 样本中提取的交互的分布。我们发现,VGG-11 和 VGG-13 在分类 OOD 样本时建模了更多复杂的交互(高阶交互),而在分类正常样本时则使用了较低阶的交互。这验证了高阶交互的泛化能力通常弱于低阶交互。

图 8:比较从正常样本中提取的交互与从分布外 (OOD) 样本中提取的交互。神经网络通常在 OOD 样本上建模的更高阶的交互。5.3 两阶段现象和神经网络训练过程 loss gap 的变化相对齐我们发现上述两阶段现象可以充分表示神经网络泛化性动力学。一个很有趣的现象是神经网络训练过程中的两阶段现象和神经网络在测试集和训练集的 loss gap 的变化在时间上是对齐的。训练损失和测试损失之间的 loss gap 是衡量模型过拟合程度的最广泛使用的指标。图 6 显示了不同的神经网络在训练工程的测试损失和训练损失之间的 loss gap 的曲线,还显示了从不同训练时期的神经网络中提取的交互分布。我们发现当神经网络训练过程中测试损失和训练损失之间的 loss gap 开始增大时,神经网络恰好也进入训练的第二阶段。这表明神经网络训练的两阶段现象与模型 loss gap 的变化在时间上是 “对齐” 的。我们可以这样理解上述现象:在训练过程开始前,初始化的神经网络所建模的交互全部表示随机噪声,并且不同阶交互的分布看起来像 “纺锤形”。在神经网络训练的第一阶段,神经网络逐渐消除中阶和高阶的交互,并学习最简单的(最低阶的)交互。然后,在神经网络训练的第二阶段,神经网络建模了阶数逐渐增大的交互。由于我们在 “5.2 神经网络所建模交互的阶数和其泛化能力的关系” 章节中的两个实验验证了高阶交互通常比低阶交互具有更差的泛化能力,因此我们可以认为在神经网络训练的第二阶段,DNN 首先学习了泛化能力最强的交互,然后逐渐转向更复杂但泛化能力较弱的交互。最终一些神经网络逐渐过拟合,并编码了大量中阶和高阶交互。理论证明神经网络训练过程的两阶段现象共分为三个部分,第一部分我们需要证明随机初始化的神经网络在训练过程开始之前建模的交互的分布呈现 “纺锤形”,即很少建模高阶和低阶交互,主要建模中阶交互。第二部分证明神经网络在训练的第二阶段在建模阶数逐渐增大的交互。第三部分证明神经网络在训练的第一阶段逐渐消除中阶和高阶交互,学习最低价的交互。1. 证明初始化神经网络建模的 “纺锤形” 交互分布。由于随机初始化的随机网络在训练过程开始之前建模的都是噪声,所以我们假设随机初始化的神经网络建模的交互的服从均值为 ,方差为

,方差为 的正态分布。在上述假设下,我们能够证明初始化的神经网络建模的交互的强度和的分布呈现 “纺锤形”,即很少建模高阶和低阶交互,主要建模中阶交互。

的正态分布。在上述假设下,我们能够证明初始化的神经网络建模的交互的强度和的分布呈现 “纺锤形”,即很少建模高阶和低阶交互,主要建模中阶交互。

2. 证明神经网络训练的第二阶段的交互变化动态过程。在进入正式的证明之前,我们需要做以下的预备工作。首先,我们参照 [5, 6] 的做法,将神经网络 在特定样本上的 inference 改写为不同交互触发函数的加权和:

在特定样本上的 inference 改写为不同交互触发函数的加权和: 其中,

其中, 为标量权重,满足

为标量权重,满足 。而函数

。而函数 为交互触发函数,在任意一个遮挡样本

为交互触发函数,在任意一个遮挡样本 上都满足

上都满足 。函数

。函数 的具体形式可以由泰勒展开推导得到,可参考论文,这里不做赘述。

的具体形式可以由泰勒展开推导得到,可参考论文,这里不做赘述。

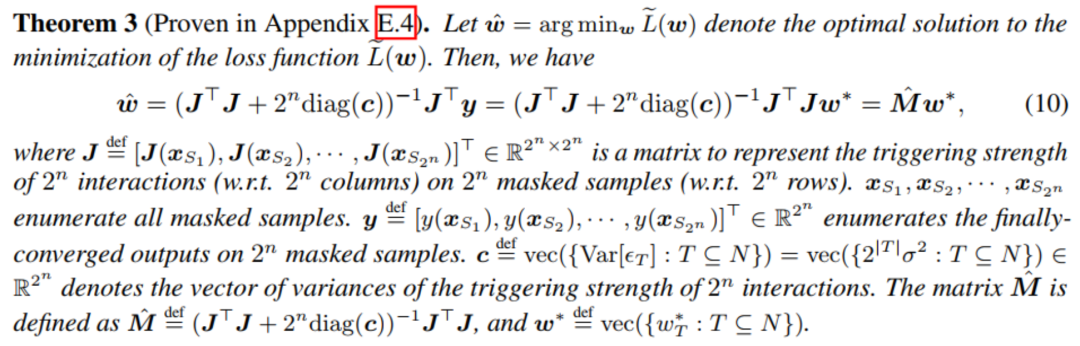

根据上述改写形式,神经网络在特定样本上的学习可近似看成是对交互触发函数的权重 的学习。进一步地,实验室的前期工作 [3] 发现在同一任务上充分训练的不同的神经网络往往会建模相似的交互,所以我们可以将神经网络的学习看成是对一系列潜在的 ground truth 交互的拟合。由此,神经网络在训练到收敛时建模的交互可以看成是最小化下面的目标函数时得到的解:

的学习。进一步地,实验室的前期工作 [3] 发现在同一任务上充分训练的不同的神经网络往往会建模相似的交互,所以我们可以将神经网络的学习看成是对一系列潜在的 ground truth 交互的拟合。由此,神经网络在训练到收敛时建模的交互可以看成是最小化下面的目标函数时得到的解: 其中

其中 表示神经网络需要拟合的一系列潜在的 ground truth 交互。

表示神经网络需要拟合的一系列潜在的 ground truth 交互。 和

和 则分别表示将所有权重拼起来得到的向量和将所有交互触发函数的值拼起来得到的向量。

则分别表示将所有权重拼起来得到的向量和将所有交互触发函数的值拼起来得到的向量。

可惜的是,上述建模虽然能得到神经网络训练到收敛时的交互,但是无法很好地刻画神经网络训练过程中学习交互的动态过程。这里引入我们的核心假设:我们假设初始化神经网络的参数上包含了大量噪声,而这些噪声的量级在训练过程中逐步变小。而进一步地,参数上的噪声会导致交互触发函数 上的噪声,且该噪声随着交互阶数指数级增长 (在 [5] 中已有实验上的观察和验证) 。我们将有噪声下的神经网络的学习建模如下:

上的噪声,且该噪声随着交互阶数指数级增长 (在 [5] 中已有实验上的观察和验证) 。我们将有噪声下的神经网络的学习建模如下:

其中噪声 满足

满足 。且随着训练进行,噪声的方差

。且随着训练进行,噪声的方差 逐渐变小。在给定的噪声量级

逐渐变小。在给定的噪声量级 的情况下最小化上述损失函数,可得到最优交互权重

的情况下最小化上述损失函数,可得到最优交互权重 的解析解,如下图中的定理所示。

的解析解,如下图中的定理所示。

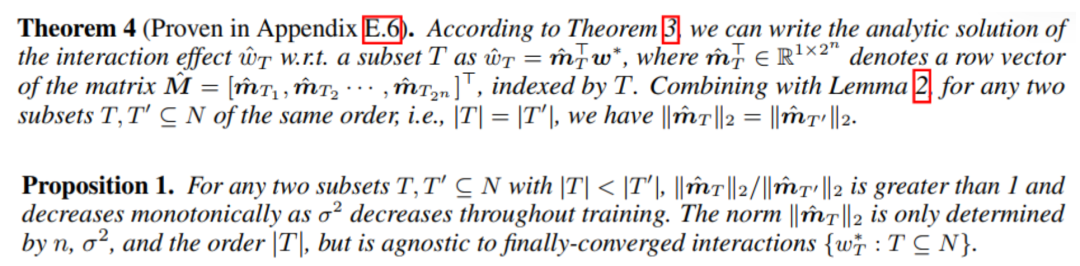

我们发现,随着训练进行(即噪声量级 变小),中低阶交互强度和高阶交互强度的比值逐渐减小(如下面的定理所示)。这解释了训练的第二阶段中神经网络逐渐学到更加高阶的交互的现象。

变小),中低阶交互强度和高阶交互强度的比值逐渐减小(如下面的定理所示)。这解释了训练的第二阶段中神经网络逐渐学到更加高阶的交互的现象。

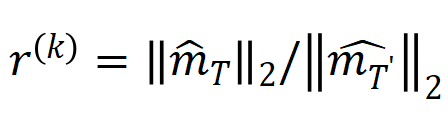

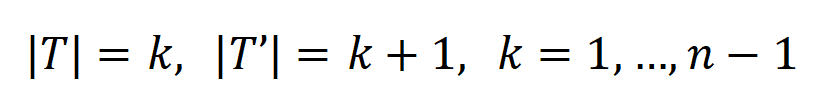

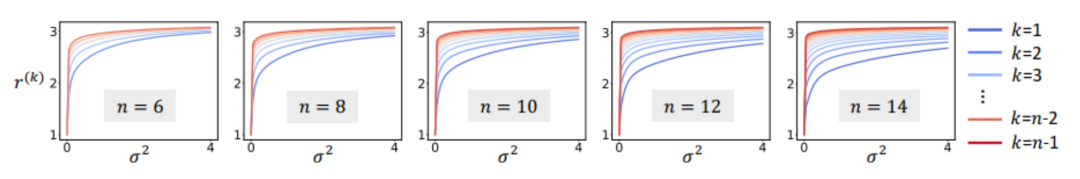

另外,我们对上述结论进一步做了实验验证。给定一个具有 n 个输入单元的样本,指标 ,其中

,其中 , 可以用来近似测量第 k 阶交互和第 k+1 阶交互强度的比值。在下图中,我们可以发现,在不同的输入单元个数 n 和不同的阶数 k 下,该比值都会随着

, 可以用来近似测量第 k 阶交互和第 k+1 阶交互强度的比值。在下图中,我们可以发现,在不同的输入单元个数 n 和不同的阶数 k 下,该比值都会随着 的减小而逐渐减小。

的减小而逐渐减小。

图 9:在不同的输入单元个数 n 和不同的阶数 k 下,第 k 阶交互和第 k+1 阶交互强度的比值都会随着噪声量级 的减小而逐渐减小。这说明随着训练进行(即

的减小而逐渐减小。这说明随着训练进行(即 逐渐变小),低阶交互强度与高阶交互强度的比值逐渐变小,神经网络逐渐学到更加高阶的交互。最后,我们对比了在不同噪声量级

逐渐变小),低阶交互强度与高阶交互强度的比值逐渐变小,神经网络逐渐学到更加高阶的交互。最后,我们对比了在不同噪声量级 下的理论交互值

下的理论交互值 在各个阶数上的分布

在各个阶数上的分布 和实际训练过程中各阶交互的分布

和实际训练过程中各阶交互的分布 ,发现理论交互分布可以很好地预测实际训练中各时间点的交互强度分布。

,发现理论交互分布可以很好地预测实际训练中各时间点的交互强度分布。

图 10:比较理论交互分布 (蓝色直方图)和实际交互分布

(蓝色直方图)和实际交互分布 (橙色直方图)。在训练第二阶段的不同时间点,理论交互分布都可以很好地预测和匹配实际交互的分布。更多结果请参见论文。3. 证明神经网络训练的第一阶段的交互变化动态过程。如果说训练的第二阶段中交互的动态变化可以解释为权重

(橙色直方图)。在训练第二阶段的不同时间点,理论交互分布都可以很好地预测和匹配实际交互的分布。更多结果请参见论文。3. 证明神经网络训练的第一阶段的交互变化动态过程。如果说训练的第二阶段中交互的动态变化可以解释为权重 的最优解在噪声

的最优解在噪声 逐渐减小时的变化,那么第一阶段就可认为是交互从初始化的随机交互逐渐收敛到最优解的过程。路漫漫其修远兮,我们团队是做神经网络可解释性的第一性原理,我们希望在更多的方面把这个理论做扎实,能够严格证明等效交互是符号化的解释,并且能够解释神经网络的泛化性、鲁棒性,同时证明神经网络表征瓶颈,统一 12 种提升神经网络对抗迁移性的方法和解释 14 种重要性估计方法。我们后面会做出更扎实的工作,进一步完善理论体系。[1] Huilin Zhou, Hao Zhang, Huiqi Deng, Dongrui Liu, Wen Shen, Shih-Han Chan, and Quanshi Zhang. Explaining generalization power of a dnn using interactive concepts. AAAI, 2024[2] Arthur Jacot, Franck Gabriel, Clement Hongler. Neural tangent kernel: Convergence and generalization in neural networks. NeurIPS, 2018[3] Mingjie Li, and Quanshi Zhang. Does a Neural Network Really Encode Symbolic Concept? ICML, 2023[4] Wen Shen, Lei Cheng, Yuxiao Yang, Mingjie Li, and Quanshi Zhang. Can the Inference Logic of Large Language Models be Disentangled into Symbolic Concepts?[5] Qihan Ren, Huiqi Deng, Yunuo Chen, Siyu Lou, and Quanshi Zhang. Bayesian Neural Networks Tend to Ignore Complex and Sensitive Concepts. ICML, 2023[6] Dongrui Liu, Huiqi Deng, Xu Cheng, Qihan Ren, Kangrui Wang, and Quanshi Zhang. Towards the Difficulty for a Deep Neural Network to Learn Concepts of Different Complexities. NeurIPS, 2023

逐渐减小时的变化,那么第一阶段就可认为是交互从初始化的随机交互逐渐收敛到最优解的过程。路漫漫其修远兮,我们团队是做神经网络可解释性的第一性原理,我们希望在更多的方面把这个理论做扎实,能够严格证明等效交互是符号化的解释,并且能够解释神经网络的泛化性、鲁棒性,同时证明神经网络表征瓶颈,统一 12 种提升神经网络对抗迁移性的方法和解释 14 种重要性估计方法。我们后面会做出更扎实的工作,进一步完善理论体系。[1] Huilin Zhou, Hao Zhang, Huiqi Deng, Dongrui Liu, Wen Shen, Shih-Han Chan, and Quanshi Zhang. Explaining generalization power of a dnn using interactive concepts. AAAI, 2024[2] Arthur Jacot, Franck Gabriel, Clement Hongler. Neural tangent kernel: Convergence and generalization in neural networks. NeurIPS, 2018[3] Mingjie Li, and Quanshi Zhang. Does a Neural Network Really Encode Symbolic Concept? ICML, 2023[4] Wen Shen, Lei Cheng, Yuxiao Yang, Mingjie Li, and Quanshi Zhang. Can the Inference Logic of Large Language Models be Disentangled into Symbolic Concepts?[5] Qihan Ren, Huiqi Deng, Yunuo Chen, Siyu Lou, and Quanshi Zhang. Bayesian Neural Networks Tend to Ignore Complex and Sensitive Concepts. ICML, 2023[6] Dongrui Liu, Huiqi Deng, Xu Cheng, Qihan Ren, Kangrui Wang, and Quanshi Zhang. Towards the Difficulty for a Deep Neural Network to Learn Concepts of Different Complexities. NeurIPS, 2023等效交互理论体系

[1] Huiqi Deng, Na Zou, Mengnan Du, Weifu Chen, Guocan Feng, Ziwei Yang, Zheyang Li, and Quanshi Zhang. Unifying Fourteen Post-Hoc Attribution Methods With Taylor Interactions. IEEE Transactions on Pattern Analysis and Machine Intelligence (IEEE T-PAMI), 2024.

[2] Xu Cheng, Lei Cheng, Zhaoran Peng, Yang Xu, Tian Han, and Quanshi Zhang. Layerwise Change of Knowledge in Neural Networks. ICML, 2024.

[3] Qihan Ren, Jiayang Gao, Wen Shen, and Quanshi Zhang. Where We Have Arrived in Proving the Emergence of Sparse Interaction Primitives in AI Models. ICLR, 2024.

[4] Lu Chen, Siyu Lou, Benhao Huang, and Quanshi Zhang. Defining and Extracting Generalizable Interaction Primitives from DNNs. ICLR, 2024.

[5] Huilin Zhou, Hao Zhang, Huiqi Deng, Dongrui Liu, Wen Shen, Shih-Han Chan, and Quanshi Zhang. Explaining Generalization Power of a DNN Using Interactive Concepts. AAAI, 2024.

[6] Dongrui Liu, Huiqi Deng, Xu Cheng, Qihan Ren, Kangrui Wang, and Quanshi Zhang. Towards the Difficulty for a Deep Neural Network to Learn Concepts of Different Complexities. NeurIPS, 2023.

[7] Quanshi Zhang, Jie Ren, Ge Huang, Ruiming Cao, Ying Nian Wu, and Song-Chun Zhu. Mining Interpretable AOG Representations from Convolutional Networks via Active Question Answering. IEEE Transactions on Pattern Analysis and Machine Intelligence (IEEE T-PAMI), 2020.

[8] Xin Wang, Jie Ren, Shuyun Lin, Xiangming Zhu, Yisen Wang, and Quanshi Zhang. A Unified Approach to Interpreting and Boosting Adversarial Transferability. ICLR, 2021.

[9] Hao Zhang, Sen Li, Yinchao Ma, Mingjie Li, Yichen Xie, and Quanshi Zhang. Interpreting and Boosting Dropout from a Game-Theoretic View. ICLR, 2021.

[10] Mingjie Li, and Quanshi Zhang. Does a Neural Network Really Encode Symbolic Concept? ICML, 2023.

[11] Lu Chen, Siyu Lou, Keyan Zhang, Jin Huang, and Quanshi Zhang. HarsanyiNet: Computing Accurate Shapley Values in a Single Forward Propagation. ICML, 2023.

[12] Qihan Ren, Huiqi Deng, Yunuo Chen, Siyu Lou, and Quanshi Zhang. Bayesian Neural Networks Avoid Encoding Perturbation-Sensitive and Complex Concepts. ICML, 2023.

[13] Jie Ren, Mingjie Li, Qirui Chen, Huiqi Deng, and Quanshi Zhang. Defining and Quantifying the Emergence of Sparse Concepts in DNNs. CVPR, 2023.

[14] Jie Ren, Mingjie Li, Meng Zhou, Shih-Han Chan, and Quanshi Zhang. Towards Theoretical Analysis of Transformation Complexity of ReLU DNNs. ICML, 2022.

[15] Jie Ren, Die Zhang, Yisen Wang, Lu Chen, Zhanpeng Zhou, Yiting Chen, Xu Cheng, Xin Wang, Meng Zhou, Jie Shi, and Quanshi Zhang. A Unified Game-Theoretic Interpretation of Adversarial Robustness. NeurIPS, 2021.

[16] Wen Shen, Qihan Ren, Dongrui Liu, and Quanshi Zhang. Interpreting Representation Quality of DNNs for 3D Point Cloud Processing. NeurIPS, 2021.

[17] Xin Wang, Shuyun Lin, Hao Zhang, Yufei Zhu, and Quanshi Zhang. Interpreting Attributions and Interactions of Adversarial Attacks. ICCV, 2021.

[18] Wen Shen, Zhihua Wei, Shikun Huang, Binbin Zhang, Panyue Chen, Ping Zhao, and Quanshi Zhang. Verifiability and Predictability: Interpreting Utilities of Network Architectures for 3D Point Cloud Processing. CVPR, 2021.

[19] Hao Zhang, Yichen Xie, Longjie Zheng, Die Zhang, and Quanshi Zhang. Interpreting Multivariate Shapley Interactions in DNNs. AAAI, 2021.

[20] Die Zhang, Huilin Zhou, Hao Zhang, Xiaoyi Bao, Da Huo, Ruizhao Chen, Xu Cheng, Mengyue Wu, and Quanshi Zhang. Building Interpretable Interaction Trees for Deep NLP Models. AAAI, 2021.

위 내용은 설명 가능성의 궁극적인 질문은 첫 번째 설명이 무엇인가입니다. 20개의 CCF-A+ICLR 논문이 답변을 제공합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

의 입력 변수 간의 "AND 관계"를 나타낸다고 생각할 수 있습니다. 예를 들어, 입력 문장

의 입력 변수 간의 "AND 관계"를 나타낸다고 생각할 수 있습니다. 예를 들어, 입력 문장  이 주어지면 신경망은

이 주어지면 신경망은  간의 상호 작용을 모델링하여

간의 상호 작용을 모델링하여  이 신경망의 출력 "폭우"를 유도하는 수치 유틸리티를 생성할 수 있습니다.

이 신경망의 출력 "폭우"를 유도하는 수치 유틸리티를 생성할 수 있습니다.  의 입력 변수가 가려지면 해당 수치 유틸리티가 신경망의 출력에서 제거됩니다. 마찬가지로 동등성 또는 상호 작용

의 입력 변수가 가려지면 해당 수치 유틸리티가 신경망의 출력에서 제거됩니다. 마찬가지로 동등성 또는 상호 작용  은 신경망으로 모델링된

은 신경망으로 모델링된  내의 입력 변수 간의 "OR 관계"를 나타냅니다. 예를 들어 입력 문장

내의 입력 변수 간의 "OR 관계"를 나타냅니다. 예를 들어 입력 문장  이 있을 때

이 있을 때  에 있는 단어가 나타나면 신경망의 출력을 구동하여 부정적인 감정을 분류합니다.

에 있는 단어가 나타나면 신경망의 출력을 구동하여 부정적인 감정을 분류합니다.

을 기반으로 하는 논리 모델을 통해 정확하게 맞출 수 있습니다. 각 상호 작용은 특정 입력 변수 세트(

을 기반으로 하는 논리 모델을 통해 정확하게 맞출 수 있습니다. 각 상호 작용은 특정 입력 변수 세트( )를 모델링하는 신경망 간의 비선형 관계를 측정한 것입니다. 세트의 변수가 동시에 나타날 때만 트리거되고 상호 작용하며 출력

)를 모델링하는 신경망 간의 비선형 관계를 측정한 것입니다. 세트의 변수가 동시에 나타날 때만 트리거되고 상호 작용하며 출력  에 숫자 점수를 제공합니다. 세트의 변수

에 숫자 점수를 제공합니다. 세트의 변수  가 나타나면 트리거되거나 상호 작용합니다.

가 나타나면 트리거되거나 상호 작용합니다.

및

및  . 다양한 데이터 세트와 다양한 작업에 대해 훈련된 다양한 신경망의 훈련 프로세스에는 2단계 현상이 있습니다. 처음 두 개의 선택된 시점은 첫 번째 단계에 속하고 마지막 두 개의 시점은 두 번째 단계에 속합니다. 신경망 훈련 과정의 두 번째 단계에 들어간 직후, 테스트 손실과 신경망 훈련 손실 사이의 손실 격차가 크게 증가하기 시작합니다(마지막 열 참조). 이는 신경망 훈련의 2단계 현상이 모델 손실 격차의 변화에 맞춰 "정렬"된다는 것을 보여줍니다. 더 많은 실험 결과를 보려면 논문을 참조하세요.

. 다양한 데이터 세트와 다양한 작업에 대해 훈련된 다양한 신경망의 훈련 프로세스에는 2단계 현상이 있습니다. 처음 두 개의 선택된 시점은 첫 번째 단계에 속하고 마지막 두 개의 시점은 두 번째 단계에 속합니다. 신경망 훈련 과정의 두 번째 단계에 들어간 직후, 테스트 손실과 신경망 훈련 손실 사이의 손실 격차가 크게 증가하기 시작합니다(마지막 열 참조). 이는 신경망 훈련의 2단계 현상이 모델 손실 격차의 변화에 맞춰 "정렬"된다는 것을 보여줍니다. 더 많은 실험 결과를 보려면 논문을 참조하세요.  입력 변수를 포함하는 입력 샘플

입력 변수를 포함하는 입력 샘플  이 주어지면 입력 샘플

이 주어지면 입력 샘플  에서 추출된

에서 추출된  순 상호 작용을 벡터화

순 상호 작용을 벡터화  합니다. 여기서

합니다. 여기서  는

는

순 상호 작용을 나타냅니다. 그런 다음 분류 작업에서 카테고리

순 상호 작용을 나타냅니다. 그런 다음 분류 작업에서 카테고리  가 있는 모든 샘플에서 추출된 순서

가 있는 모든 샘플에서 추출된 순서  의 평균 상호 작용 벡터를 계산합니다. 여기서

의 평균 상호 작용 벡터를 계산합니다. 여기서  는 카테고리

는 카테고리  가 있는 샘플 집합을 나타냅니다.다음으로, 분류 작업에서 카테고리

가 있는 샘플 집합을 나타냅니다.다음으로, 분류 작업에서 카테고리  를 갖는 샘플의

를 갖는 샘플의  를 측정하기 위해 훈련 샘플에서 추출된 순서

를 측정하기 위해 훈련 샘플에서 추출된 순서  의 평균 상호 작용 벡터

의 평균 상호 작용 벡터  와 테스트 샘플에서 추출된 순서

와 테스트 샘플에서 추출된 순서  의 평균 상호 작용 벡터

의 평균 상호 작용 벡터

where,

where,  및

및  는 Jaccard 유사성을 계산하기 위해 두 개의

는 Jaccard 유사성을 계산하기 위해 두 개의  차원 상호 작용 벡터를 두 개의

차원 상호 작용 벡터를 두 개의  다양한 상호작용 순서를 계산하는 실험을 진행했습니다

다양한 상호작용 순서를 계산하는 실험을 진행했습니다 . 우리는 MNIST 데이터세트로 훈련된 LeNet, CIFAR-10 데이터세트로 훈련된 VGG-11, CUB200-2011 데이터세트로 훈련된 VGG-13, Tiny-ImageNet 데이터세트로 훈련된 AlexNet을 테스트했습니다. 계산 비용을 줄이기 위해 상위 10개 카테고리

. 우리는 MNIST 데이터세트로 훈련된 LeNet, CIFAR-10 데이터세트로 훈련된 VGG-11, CUB200-2011 데이터세트로 훈련된 VGG-13, Tiny-ImageNet 데이터세트로 훈련된 AlexNet을 테스트했습니다. 계산 비용을 줄이기 위해 상위 10개 카테고리

,方差为

,方差为 的正态分布。在上述假设下,我们能够证明初始化的神经网络建模的交互的强度和的分布呈现 “纺锤形”,即很少建模高阶和低阶交互,主要建模中阶交互。

的正态分布。在上述假设下,我们能够证明初始化的神经网络建模的交互的强度和的分布呈现 “纺锤形”,即很少建模高阶和低阶交互,主要建模中阶交互。

在特定样本上的 inference 改写为不同交互触发函数的加权和:

在特定样本上的 inference 改写为不同交互触发函数的加权和: 其中,

其中, 为标量权重,满足

为标量权重,满足 。而函数

。而函数 为交互触发函数,在任意一个遮挡样本

为交互触发函数,在任意一个遮挡样本 上都满足

上都满足 。函数

。函数 的具体形式可以由泰勒展开推导得到,可参考论文,这里不做赘述。

的具体形式可以由泰勒展开推导得到,可参考论文,这里不做赘述。 的学习。进一步地,实验室的前期工作 [3] 发现在同一任务上充分训练的不同的神经网络往往会建模相似的交互,所以我们可以将神经网络的学习看成是对一系列潜在的 ground truth 交互的拟合。由此,神经网络在训练到收敛时建模的交互可以看成是最小化下面的目标函数时得到的解:

的学习。进一步地,实验室的前期工作 [3] 发现在同一任务上充分训练的不同的神经网络往往会建模相似的交互,所以我们可以将神经网络的学习看成是对一系列潜在的 ground truth 交互的拟合。由此,神经网络在训练到收敛时建模的交互可以看成是最小化下面的目标函数时得到的解: 其中

其中 表示神经网络需要拟合的一系列潜在的 ground truth 交互。

表示神经网络需要拟合的一系列潜在的 ground truth 交互。 和

和 则分别表示将所有权重拼起来得到的向量和将所有交互触发函数的值拼起来得到的向量。

则分别表示将所有权重拼起来得到的向量和将所有交互触发函数的值拼起来得到的向量。 上的噪声,且该噪声随着交互阶数指数级增长 (在 [5] 中已有实验上的观察和验证) 。我们将有噪声下的神经网络的学习建模如下:

上的噪声,且该噪声随着交互阶数指数级增长 (在 [5] 中已有实验上的观察和验证) 。我们将有噪声下的神经网络的学习建模如下:

满足

满足 。且随着训练进行,噪声的方差

。且随着训练进行,噪声的方差 逐渐变小。

逐渐变小。 的情况下最小化上述损失函数,可得到最优交互权重

的情况下最小化上述损失函数,可得到最优交互权重 的解析解,如下图中的定理所示。

的解析解,如下图中的定理所示。

变小),中低阶交互强度和高阶交互强度的比值逐渐减小(如下面的定理所示)。这解释了训练的第二阶段中神经网络逐渐学到更加高阶的交互的现象。

变小),中低阶交互强度和高阶交互强度的比值逐渐减小(如下面的定理所示)。这解释了训练的第二阶段中神经网络逐渐学到更加高阶的交互的现象。

,其中

,其中 , 可以用来近似测量第 k 阶交互和第 k+1 阶交互强度的比值。在下图中,我们可以发现,在不同的输入单元个数 n 和不同的阶数 k 下,该比值都会随着

, 可以用来近似测量第 k 阶交互和第 k+1 阶交互强度的比值。在下图中,我们可以发现,在不同的输入单元个数 n 和不同的阶数 k 下,该比值都会随着 的减小而逐渐减小。

的减小而逐渐减小。

的减小而逐渐减小。这说明随着训练进行(即

的减小而逐渐减小。这说明随着训练进行(即 逐渐变小),低阶交互强度与高阶交互强度的比值逐渐变小,神经网络逐渐学到更加高阶的交互。

逐渐变小),低阶交互强度与高阶交互强度的比值逐渐变小,神经网络逐渐学到更加高阶的交互。 下的理论交互值

下的理论交互值 在各个阶数上的分布

在各个阶数上的分布 和实际训练过程中各阶交互的分布

和实际训练过程中各阶交互的分布 ,发现理论交互分布可以很好地预测实际训练中各时间点的交互强度分布。

,发现理论交互分布可以很好地预测实际训练中各时间点的交互强度分布。

(蓝色直方图)和实际交互分布

(蓝色直方图)和实际交互分布 (橙色直方图)。在训练第二阶段的不同时间点,理论交互分布都可以很好地预测和匹配实际交互的分布。更多结果请参见论文。

(橙色直方图)。在训练第二阶段的不同时间点,理论交互分布都可以很好地预测和匹配实际交互的分布。更多结果请参见论文。 的最优解在噪声

的最优解在噪声 逐渐减小时的变化,那么第一阶段就可认为是交互从初始化的随机交互逐渐收敛到最优解的过程。

逐渐减小时的变化,那么第一阶段就可认为是交互从初始化的随机交互逐渐收敛到最优解的过程。