Xiaohongshu의 대규모 모델 논문 공유 세션에는 4개 주요 국제 회의의 저자들이 모였습니다.

- 王林원래의

- 2024-08-05 14:33:02747검색

대형 모델이 산업계와 학계 모두에서 수많은 혁신적인 결과를 내놓으며 새로운 연구 붐을 주도하고 있습니다.

Xiaohongshu 기술팀도 이러한 흐름 속에서 끊임없이 탐구하고 있으며, 많은 논문의 연구 결과가 ICLR, ACL, CVPR, AAAI, SIGIR 및 WWW와 같은 최고의 국제 회의에서 자주 발표되었습니다.

대형 모델과 자연어 처리의 교차점에서 우리는 어떤 새로운 기회와 도전을 발견하고 있나요?

대형 모델에 대한 효과적인 평가 방법은 무엇인가요? 애플리케이션 시나리오에 어떻게 더 잘 통합될 수 있습니까?

6월 27일 19시~21시 30분, [REDtech가 온다] "리틀 레드북 2024 대형모델 프론티어 종이나눔" 11호가 온라인으로 방송됩니다!

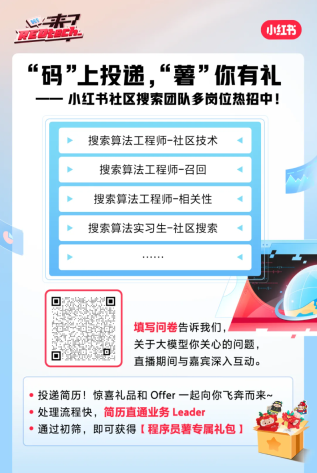

REDtech에서는 Xiaohongshu 커뮤니티 검색팀을 생방송실에 특별히 초대하여 2024년 Xiaohongshu에서 출판한 6개의 대규모 모델 연구 논문을 공유할 예정입니다. Xiaohongshu Jingpai LTR 책임자 Feng Shaoxiong은 Li Yiwei, Wang Xinglin, Yuan Peiwen, Zhang Chao 등과 손을 잡고 최신 대형 모델 디코딩 및 증류 기술, 대형 모델 평가 방법 및 대형 모델 사용에 대해 논의했습니다. Xiaohongshu 플랫폼의 실제 응용 프로그램 모델입니다.

Activity Agenda

01 Escape Sky-high Cost: 다단계 추론을 위한 조기 중지 Self-Consistency / ICLR 2024에 선정됨

Escape Sky-high Cost: Early-stopping Self-Consistency for 다단계 추론 다단계 추론 성적 방법 | 공유자: Li Yiwei

자기 일관성(SC)은 사고 연쇄 추론에서 항상 널리 사용되는 해독 전략이었습니다. 이는 다중 사고 체인을 생성하고 최종 답을 개선합니다. 모델 성능. 그러나 미리 설정된 크기의 여러 샘플이 필요한 비용이 많이 드는 방법입니다. ICLR 2024에서 Xiaohongshu는 SC 비용을 크게 줄일 수 있는 간단하고 확장 가능한 샘플링 프로세스인 ESC(Early-Stopping Self-Consistency)를 제안했습니다. 이를 바탕으로 팀은 다양한 작업과 모델에 대한 성능-비용 균형을 동적으로 선택하기 위한 ESC 제어 체계를 추가로 도출했습니다. 세 가지 주류 추론 작업(수학, 상식, 기호 추론)에 대한 실험 결과에 따르면 ESC는 원래 성능을 거의 유지하면서 6개 벤치마크에서 평균 샘플 수를 크게 줄였습니다.

논문 주소: https://arxiv.org/abs/2401.10480

02 본질을 통합하고 불순물 제거: 자유 형식 언어 생성을 위한 세분화된 자체 일관성 / ACL 2024에 선정됨

Select 세부 사항: 자유 형식 생성 작업을 위한 Fine-grained self-consistency 방법| Sharer: Wang Xinglin

Xiaohongshu는 ACL 2024에서 FSC(Fine-Grained Self-Consistency) 방법을 제안했는데, 이는 자체 성능을 크게 향상시킬 수 있습니다. -자유 형식 생성 작업 성능의 일관성 방법. 연구팀은 먼저 자유 형식 생성 작업에 대한 기존 자기 일관성 방식의 단점이 서로 다른 샘플의 세밀한 조각 간의 공통 지식을 효과적으로 활용할 수 없는 거친 공통 샘플 선택에서 비롯된다는 점을 실험을 통해 분석했습니다. 이를 기반으로 연구팀은 대형 모델 자가 융합 기반의 FSC 방법을 제안했고, 실험을 통해 상당한 소비를 유지하면서도 코드 생성, 요약 생성, 수학적 추론 작업에서 훨씬 더 나은 성능을 달성했음을 확인했습니다.

논문 주소: https://github.com/WangXinglin/FSC

03 BatchEval: Towards Human-like Text Evaluation / ACL 2024에 선정, 현장 의장이 만점을 주고 최고의 논문을 추천

Mai 인간 수준의 텍스트 평가를 향하여 │ Shareer: Yuan Peiwen

Xiaohongshu는 ACL 2024에서 BatchEval 방법을 제안했습니다. 이 방법은 더 낮은 오버헤드로 인간과 유사한 텍스트 평가 효과를 얻을 수 있습니다. 연구팀은 먼저 기존 텍스트 평가 방식의 평가 견고성 단점은 평가 점수의 불균등한 분포에서 비롯되고, 점수 통합의 차선 성능은 평가 관점의 다양성 부족에서 비롯된다는 점을 이론적 차원에서 분석했다. 이를 바탕으로 인간의 평가 과정에서 샘플 간 비교를 통해 보다 입체적이고 종합적인 평가 벤치마크를 다양한 관점으로 구축하고자 BatchEval을 유추적으로 제안하였습니다. 현재의 여러 최첨단 방법과 비교할 때 BatchEval은 평가 오버헤드와 평가 효과 모두에서 훨씬 더 나은 성능을 달성합니다.

논문 주소: https://arxiv.org/abs/2401.00437

04 상호 일관성을 통한 SuperLLM에 대한 Poor-Supervised Evaluation / ACL 2024에 선정

상호를 통한 정확한 감독 신호가 부족한 상황에서 초인적 수준 달성 일관성 대형 언어 모델 평가| Sharer: Yuan Peiwen

Xiaohongshu는 ACL 2024에서 모델 간의 상호 일관성을 통해 인간 수준을 넘어선 대규모 언어 모델의 정확한 평가를 달성할 수 있는 PEEM 방법을 제안했습니다. 연구팀은 먼저 대규모 언어 모델의 급속한 발전 추세가 여러 측면에서 점진적인 도달을 가속화하거나 심지어 인간 수준을 능가할 것이라고 분석했습니다. 이러한 상황에서 인간은 더 이상 정확한 평가 신호를 제공할 수 없게 됩니다. 본 시나리오에서 능력 평가를 실현하기 위해, 팀은 모델 간 상호 일관성을 평가 신호로 활용하는 아이디어를 제안하고, 평가 샘플이 무한할 때 참조 모델 간에 독립적인 예측 분포가 있는 경우 이를 도출했습니다. 참조 모델 간의 이러한 일관성은 모델 기능을 정확하게 측정하는 데 사용될 수 있습니다. 이를 기반으로 연구팀은 EM 알고리즘을 기반으로 한 PEEM 방법을 제안했고, 실험을 통해 현실에서는 위 조건의 부족함을 효과적으로 완화할 수 있음을 확인하고, 이를 통해 인간 수준을 뛰어넘는 대규모 언어 모델의 정확한 평가를 달성했다.

논문 주소: https://github.com/ypw0102/PEEM

05 먼지를 금으로 만들기: 부정적 데이터를 활용하여 LLM의 복잡한 추론 능력 추출 / AAAI 2024 Oral

음성 샘플을 사용하여 홍보 대형 모델 추론 기능의 정제 | Sharer: Li Yiwei

대형 언어 모델(LLM)은 다양한 추론 작업에서 뛰어난 성능을 발휘하지만 블랙박스 속성과 엄청난 수의 매개변수가 실제로 널리 적용되는 데 방해가 됩니다. 특히 복잡한 수학적 문제를 다룰 때 LLM은 때때로 잘못된 추론 체인을 생성합니다. 전통적인 연구 방법은 긍정적인 샘플의 지식만 전달하고 잘못된 답이 있는 합성 데이터를 무시합니다. AAAI 2024에서 Xiaohongshu 검색 알고리즘 팀은 혁신적인 프레임워크를 제안하고, 모델 증류 프로세스에서 최초로 네거티브 샘플의 가치를 제안 및 검증했으며, 포지티브 샘플을 사용하는 것 외에도 완전한 모델 전문화 프레임워크를 구축했습니다. 부정적인 샘플을 사용하여 LLM 지식을 개선합니다. 프레임워크에는 NAT(Negative Assisted Training), NCE(Negative Calibration Enhancement) 및 ASC(Dynamic Self-Consistency)를 포함한 세 가지 직렬화 단계가 포함되어 있으며 훈련부터 추론까지 전체 프로세스를 포괄합니다. 광범위한 일련의 실험은 LLM 지식 증류에서 부정적인 데이터의 중요한 역할을 보여줍니다.

논문 주소: https://arxiv.org/abs/2312.12832

06 NoteLLM: A Retrievable Large Language Model for Note Recommendation / WWW 2024에 선정

대형 언어 모델 기반 노트 콘텐츠 표현 추천 시스템| 공유자: Zhang Chao

Xiaohongshu 앱은 매일 수많은 새로운 노트를 생성합니다. 관심 있는 사용자에게 이러한 새로운 콘텐츠를 효과적으로 추천하는 방법은 무엇일까요? 노트 내용을 기반으로 한 추천 표현은 노트의 콜드 스타트 문제를 완화하는 방법이자 많은 다운스트림 애플리케이션의 기초이기도 합니다. 최근에는 강력한 일반화 및 텍스트 이해 기능으로 인해 대규모 언어 모델이 많은 주목을 받았습니다. 따라서 우리는 노트 내용에 대한 이해를 높이기 위해 대규모 언어 모델을 사용하여 노트 내용 표현 추천 시스템을 구축하고자 합니다. 향상된 표현 생성과 다중 모드 콘텐츠 표현 생성이라는 두 가지 관점에서 최근 작업을 소개합니다. 현재 이 시스템은 Xiaohongshu의 여러 비즈니스 시나리오에 적용되어 상당한 이점을 얻었습니다. 논문주소 : https://arxiv.org/abs/2403.01744

라이브 시청방법

-

생방송 시간 : 2024년 6월 27일 19:00~21:30

라이브 방송 플랫폼: WeChat 비디오 계정 [REDtech], 동일한 이름의 Bilibili, Douyin 및 Xiaohongshu 계정에서 라이브 방송됩니다.

친구를 초대하여 라이브 방송 선물 약속을 잡으세요

위 내용은 Xiaohongshu의 대규모 모델 논문 공유 세션에는 4개 주요 국제 회의의 저자들이 모였습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!