TPAMI 2024 | ProCo: 무한 대조 쌍의 롱테일 대조 학습

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB원래의

- 2024-07-25 20:52:33571검색

AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

이 논문의 첫 번째 저자인 Du Chaoqun은 2020년 칭화대학교 자동화학과 박사 과정 학생입니다. 지도교수는 황가오(Huang Gao) 부교수이다. 그는 이전에 칭화대학교 물리학과에서 이학사 학위를 받았습니다. 그의 연구 관심분야는 롱테일 학습, 준지도 학습, 전이 학습 등과 같은 다양한 데이터 분포에 대한 모델 일반화 및 견고성 연구입니다. TPAMI, ICML 등 일류 국제 저널 및 컨퍼런스에 많은 논문을 게재했습니다.

개인 홈페이지: https://andy-du20.github.io

이 글은 칭화대학교의 롱테일 시각 인식에 관한 논문인 Probabilistic Contrastive Learning for Long-Tailed Visual Recognition을 소개합니다. TPAMI 2024가 승인되었으며 코드는 오픈 소스였습니다.

이 연구는 주로 롱테일 시각적 인식 작업에 대조 학습을 적용하는 데 중점을 두고 있으며, 대조 손실을 개선하여 무제한의 대조 쌍에 대한 대조 학습을 달성하는 새로운 롱테일 대조 학습 방법을 제안합니다. 문제를 효과적으로 해결하기 지도 대조 학습[1]은 배치(메모리 뱅크) 크기에 본질적으로 의존합니다. 롱테일 시각적 분류 작업 외에도 이 방법은 롱테일 준지도 학습, 롱테일 객체 감지 및 균형 잡힌 데이터 세트에서도 실험되어 상당한 성능 향상을 달성했습니다.

- 논문 링크: https://arxiv.org/pdf/2403.06726

- 프로젝트 링크: https://github.com/LeapLabTHU/ProCo

비교 자기 지도 학습의 학습 성공은 시각적 특징 표현 학습의 효율성을 보여줍니다. 대조 학습 성능에 영향을 미치는 핵심 요소는

대조 쌍의 수로, 이는 모델이 더 많은 부정적인 샘플로부터 학습할 수 있게 하며, 이는 가장 대표적인 두 가지 방법인 SimCLR [2] 및 MoCo [3]에 각각 반영됩니다. 메모리 뱅크 크기. 그러나 롱테일 시각적 인식 작업에서는 범주 불균형으로 인해 대조 쌍의 수를 늘려서 얻는 이득이 심각한 한계 감소 효과를 생성합니다. 이는 대부분의 대조 쌍이 머리 범주로 구성되어 있기 때문입니다. .샘플로 구성되어 있어 꼬리 카테고리를 다 커버하기 어렵습니다. 예를 들어 롱테일 Imagenet 데이터 세트에서 배치 크기(메모리 뱅크)가 공통 4096 및 8192로 설정되면 각 배치(메모리 뱅크)에는 평균 212

및89 범주가 있습니다. 은행) 표본 크기는 1보다 작습니다. 따라서 ProCo 방법의 핵심 아이디어는 롱테일 데이터 세트에서 각 데이터 유형의 분포를 모델링하고 매개변수를 추정하고 샘플링하여 대조 쌍을 구축하여 모든 범주가 덮여있다. 또한, 샘플 수가 무한대에 가까워지는 경우 대조 손실의 예상 분석 솔루션을 이론적으로 엄격하게 도출할 수 있으므로 대조 쌍의 비효율적인 샘플링을 피하고 무한한 대비 손실 수를 달성하기 위한 최적화 대상으로 직접 사용할 수 있습니다. 쌍 비교 학습.

그러나 위의 아이디어를 실현하는 데에는 몇 가지 주요 어려움이 있습니다. 각 데이터 유형의 분포를 모델링하는 방법.

- 특히 표본 수가 적은 꼬리 범주의 경우 분포 모수를 효율적으로 추정하는 방법입니다.

- 예상되는 대비 손실 분석 솔루션이 존재하고 계산될 수 있는지 확인하는 방법입니다.

- 실제로 위의 문제는 통합 확률 모델로 해결할 수 있습니다. 즉, 특성 분포를 모델링하기 위해 간단하고 효과적인 확률 분포를 선택하므로 최대 우도 추정을 사용하여 의 모수를 효율적으로 추정할 수 있습니다. 분포 및 계산 대조 손실에 대한 분석적 솔루션을 기대합니다.

대조 학습의 특징은 단위 초구체에 분포하므로 가능한 해결책은 구의 vMF(von Mises-Fisher) 분포를 특징 분포로 선택하는 것입니다(이 분포는 구의 정규 분포와 유사합니다). . vMF 분포 매개변수의 최대우도 추정은 대략적인 분석적 해법을 갖고 있으며 특징의 1차 모멘트 통계에만 의존하므로 분포의 매개변수를 효율적으로 추정할 수 있으며 대비 손실에 대한 기대치를 엄격하게 도출할 수 있습니다. 무제한의 대조 쌍 비교를 달성합니다.

Rajah 1 Algoritma ProCo menganggarkan pengedaran sampel berdasarkan ciri-ciri kumpulan yang berbeza Dengan mengambil sampel bilangan sampel yang tidak terhad, penyelesaian analitik bagi kerugian kontrastif yang dijangkakan boleh diperolehi, dengan berkesan menghapuskan pergantungan yang wujud pada pembelajaran kontrastif yang diselia. saiz kumpulan (bank memori) saiz .

Butiran kaedah

Berikut akan memperkenalkan kaedah ProCo secara terperinci dari empat aspek: andaian pengedaran, anggaran parameter, objektif pengoptimuman dan analisis teori.

Andaian Agihan

Seperti yang dinyatakan sebelum ini, ciri-ciri dalam pembelajaran kontras adalah terhad kepada hipersfera unit. Oleh itu, boleh diandaikan bahawa taburan yang dipatuhi oleh ciri-ciri ini ialah taburan von Mises-Fisher (vMF), dan fungsi ketumpatan kebarangkaliannya ialah:

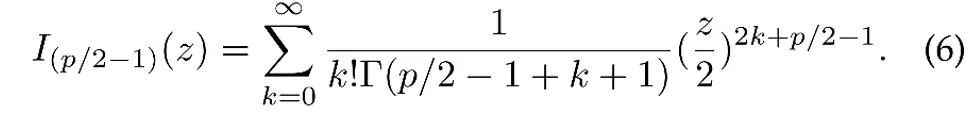

di mana z ialah vektor unit ciri p-dimensi, I ialah diubah suai. Fungsi Bessel jenis pertama,

μ ialah arah min taburan, κ ialah parameter kepekatan, yang mengawal tahap kepekatan taburan Apabila κ lebih besar, tahap pengelompokan sampel berhampiran min adalah lebih tinggi; apabila κ =0, taburan vMF merosot menjadi sfera.

Anggaran parameter

Berdasarkan andaian pengedaran di atas, pengedaran keseluruhan ciri data ialah pengedaran vMF bercampur, di mana setiap kategori sepadan dengan pengedaran vMF.

di mana parameter  mewakili kebarangkalian terdahulu bagi setiap kategori, sepadan dengan kekerapan kategori y dalam set latihan. Purata vektor

mewakili kebarangkalian terdahulu bagi setiap kategori, sepadan dengan kekerapan kategori y dalam set latihan. Purata vektor  dan parameter terkumpul

dan parameter terkumpul  taburan ciri dianggarkan mengikut anggaran kemungkinan maksimum.

taburan ciri dianggarkan mengikut anggaran kemungkinan maksimum.

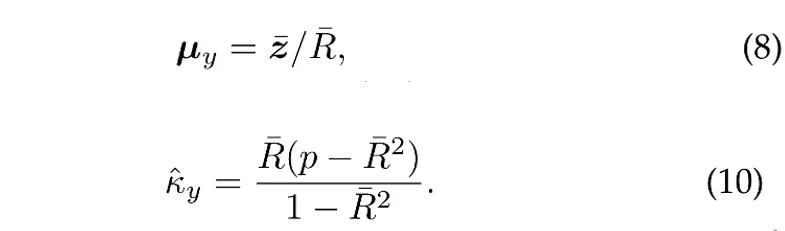

Dengan mengandaikan bahawa N vektor unit bebas dijadikan sampel daripada taburan vMF kategori y, anggaran kemungkinan maksimum (anggaran) [4] bagi arah min dan parameter kepekatan memenuhi persamaan berikut:

di mana  ialah sampel min,

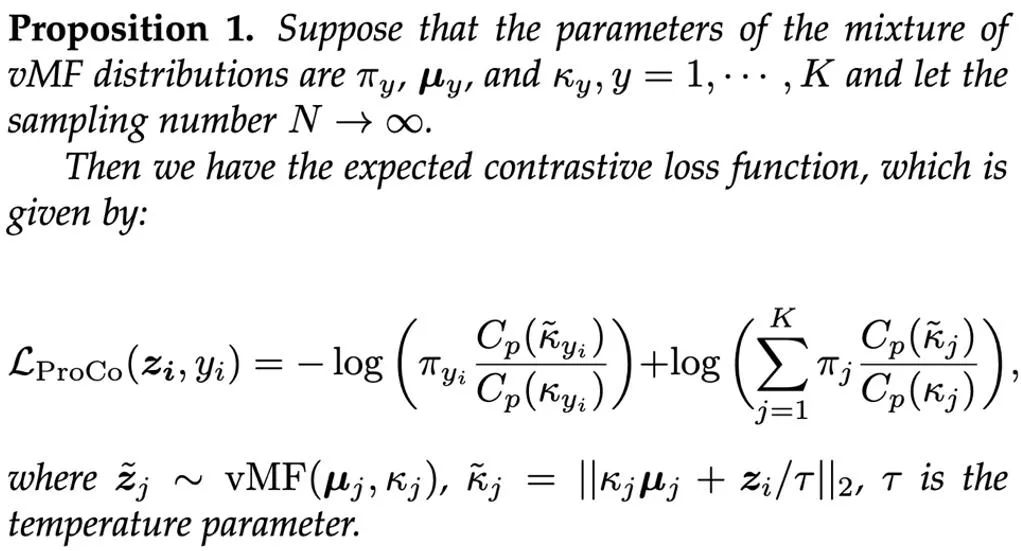

ialah sampel min,  ialah panjang modulus bagi min sampel. Di samping itu, untuk menggunakan sampel sejarah, ProCo menggunakan kaedah anggaran dalam talian, yang boleh menganggarkan parameter kategori ekor dengan berkesan. . Oleh itu, kajian ini secara teorinya memanjangkan bilangan sampel kepada infiniti dan dengan tegas memperoleh penyelesaian analisis bagi fungsi kehilangan kontras yang dijangkakan secara langsung sebagai sasaran pengoptimuman.

ialah panjang modulus bagi min sampel. Di samping itu, untuk menggunakan sampel sejarah, ProCo menggunakan kaedah anggaran dalam talian, yang boleh menganggarkan parameter kategori ekor dengan berkesan. . Oleh itu, kajian ini secara teorinya memanjangkan bilangan sampel kepada infiniti dan dengan tegas memperoleh penyelesaian analisis bagi fungsi kehilangan kontras yang dijangkakan secara langsung sebagai sasaran pengoptimuman.

Dengan memperkenalkan cawangan ciri tambahan (pembelajaran perwakilan berdasarkan matlamat pengoptimuman ini) semasa proses latihan, cawangan ini boleh dilatih bersama-sama dengan cawangan klasifikasi dan tidak akan meningkat kerana hanya cawangan klasifikasi diperlukan semasa inferens Pengiraan tambahan kos. Jumlah wajaran kerugian kedua-dua cabang digunakan sebagai matlamat pengoptimuman akhir, dan α=1 ditetapkan dalam eksperimen Akhirnya, proses keseluruhan algoritma ProCo adalah seperti berikut: Analisis teori

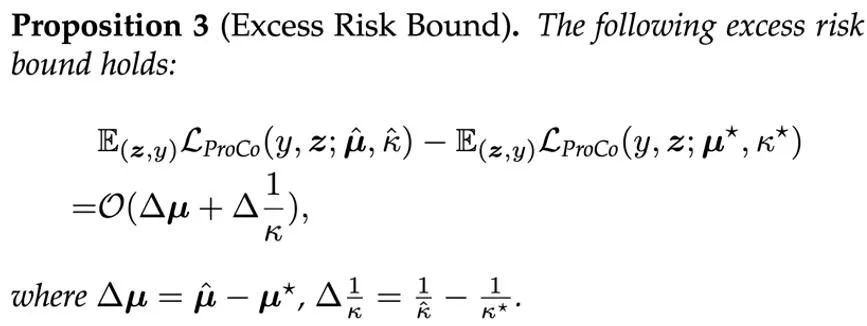

Untuk meneruskan. menganalisis Untuk mengesahkan keberkesanan kaedah ProCo secara teori, para penyelidik menganalisis terikat ralat generalisasi dan terikat risiko yang berlebihan. Untuk memudahkan analisis, diandaikan di sini hanya terdapat dua kategori, iaitu y∈{-1+1}. Analisis menunjukkan bahawa terikat ralat generalisasi dikawal terutamanya oleh bilangan sampel latihan dan varians data Pengedaran. Dapatan ini konsisten dengan Analisis teori kerja berkaitan [6][7] adalah konsisten, memastikan bahawa kehilangan ProCo tidak memperkenalkan faktor tambahan dan tidak meningkatkan terikat ralat generalisasi, yang secara teorinya menjamin keberkesanan kaedah ini.

Selain itu, kaedah ini bergantung pada andaian tertentu tentang pengagihan ciri dan anggaran parameter. Untuk menilai kesan parameter ini pada prestasi model, penyelidik juga menganalisis lebihan risiko kerugian ProCo, yang mengukur sisihan antara risiko yang dijangka menggunakan parameter anggaran dan risiko optimum Bayes, yang berada dalam pengedaran sebenar risiko Dijangka parameter.

Ini menunjukkan bahawa lebihan risiko kerugian ProCo dikawal terutamanya oleh terma urutan pertama ralat anggaran parameter.

Hasil eksperimen

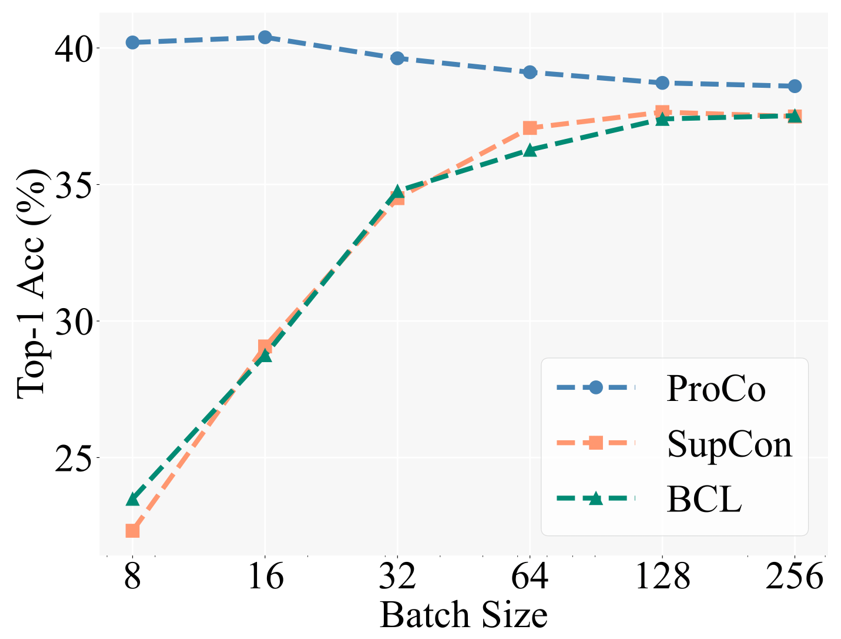

Sebagai pengesahan motivasi teras, penyelidik terlebih dahulu membandingkan prestasi kaedah pembelajaran kontrastif yang berbeza di bawah saiz kelompok yang berbeza. Baseline termasuk Pembelajaran Kontrastif Seimbang [5] (BCL), kaedah yang dipertingkatkan juga berdasarkan SCL pada tugas pengecaman ekor panjang. Tetapan percubaan khusus mengikut strategi latihan dua peringkat Pembelajaran Kontrastif Terselia (SCL), iaitu, pertama sekali hanya menggunakan kehilangan kontrastif untuk latihan pembelajaran perwakilan, dan kemudian melatih pengelas linear untuk ujian dengan tulang belakang beku.

Angka di bawah menunjukkan keputusan percubaan pada set data CIFAR100-LT (IF100) Prestasi BCL dan SupCon jelas terhad oleh saiz kelompok, tetapi ProCo secara berkesan menghapuskan kesan SupCon pada saiz kelompok dengan memperkenalkan ciri tersebut. pengedaran setiap kategori pergantungan, dengan itu mencapai prestasi terbaik di bawah saiz kelompok yang berbeza.

Selain itu, para penyelidik juga menjalankan eksperimen tentang tugas pengecaman ekor panjang, pembelajaran separa penyeliaan ekor panjang, pengesanan objek ekor panjang dan set data seimbang. Di sini kami terutamanya menunjukkan hasil percubaan pada set data ekor panjang berskala besar Imagenet-LT dan iNaturalist2018. Pertama, di bawah jadual latihan selama 90 zaman, berbanding kaedah serupa untuk meningkatkan pembelajaran kontrastif, ProCo mempunyai sekurang-kurangnya 1% peningkatan prestasi pada dua set data dan dua tulang belakang.

Keputusan berikut seterusnya menunjukkan bahawa ProCo juga boleh mendapat manfaat daripada jadual latihan yang lebih panjang Di bawah jadual 400 zaman, ProCo mencapai prestasi SOTA pada set data iNaturalist2018, dan juga mengesahkan bahawa ia boleh bersaing dengan kombinasi bukan A yang lain. kaedah pembelajaran kontrastif, termasuk penyulingan (NCL) dan kaedah lain. "Rangka kerja ringkas untuk pembelajaran kontras perwakilan visual." mengenai penglihatan komputer dan pengecaman corak 2020.

-

J. Zhu, et al. "Pembelajaran kontrastif seimbang untuk pengecaman visual ekor panjang," dalam CVPR, 2022. - W. Jitkrittum, et al. "ELM: Membenamkan dan margin logit untuk pembelajaran ekor panjang," pracetak arXiv, 2022.

- A K. Menon, et al.

위 내용은 TPAMI 2024 | ProCo: 무한 대조 쌍의 롱테일 대조 학습의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!