ICML 2024 Oral | Tsinghua Wuyi 팀의 최신 계시는 DPO가 LLM에 더 적합합니까?

- 王林원래의

- 2024-07-22 18:41:23435검색

AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

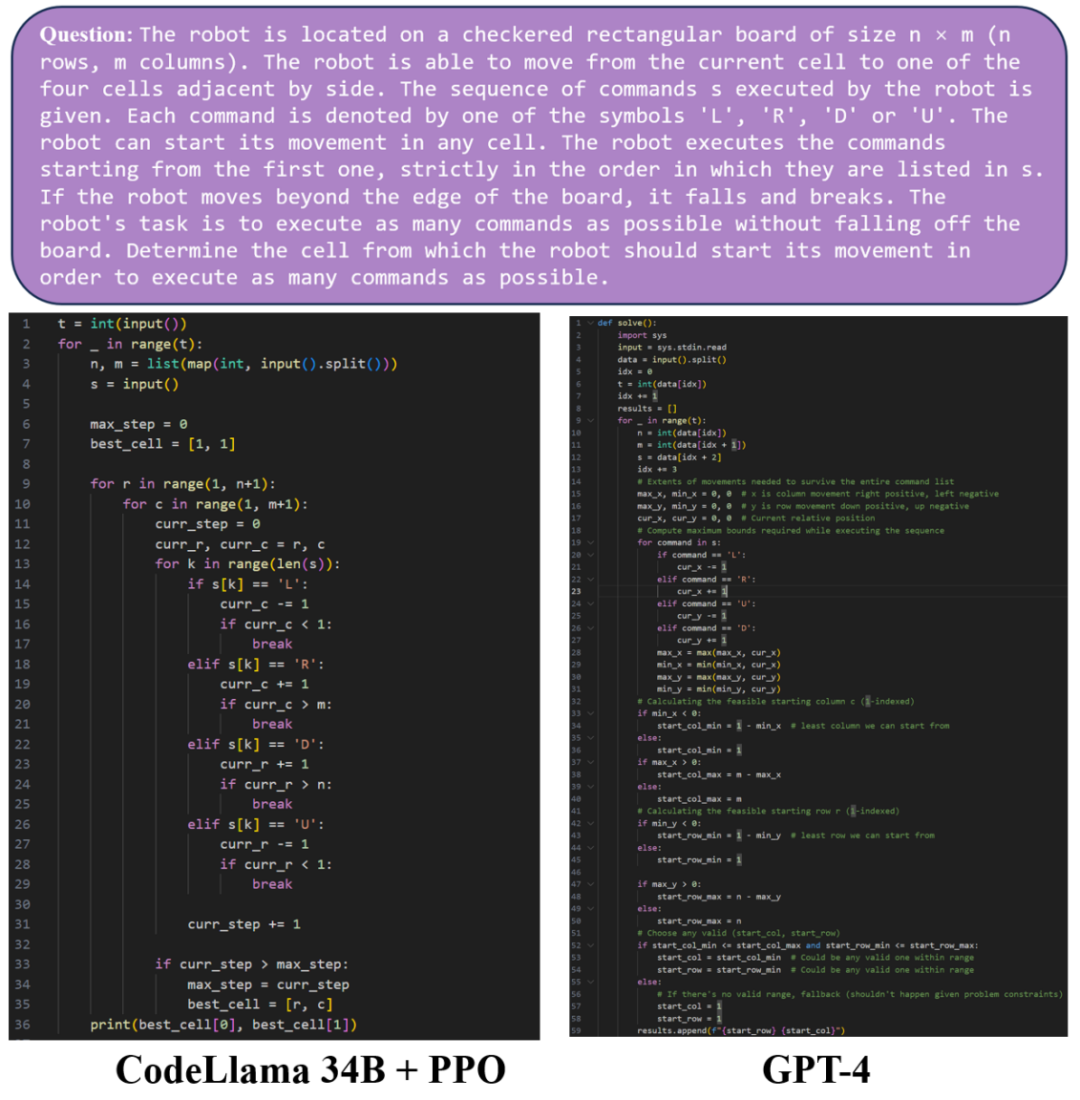

논문 제목: LLM 정렬을 위한 DPO가 PPO보다 우수합니까? 종합 연구 논문 주소: https://arxiv.org/pdf/2404.10719

대형 배치 크기(대형)를 사용 배치 크기) 이점 정규화 및 지수 이동 평균(참조 모델의 지수 이동 평균)을 사용하여 참조 모델을 업데이트합니다.

NeurIPS 2022 협동 다중 에이전트 게임에서 PPO의 놀라운 효과 [1]: 협동 시나리오에서 다중 에이전트 훈련을 지원하기 위해 다중 에이전트용 강화 학습 병렬 훈련 프레임워크 MAPPO를 제안하고 오픈 소스화했습니다. Multi-agent 분야에서 다수의 연구에 활용되었으며, 현재 논문 인용 횟수는 1,000회를 넘어섰습니다. ICLR 2024 분산 강화 학습을 10,000개 이상의 코어로 확장 [2]: 수만 개의 코어로 쉽게 확장할 수 있고 가속 비율이 OpenAI의 대규모 강화를 초과하는 강화 학습을 위한 분산 학습 프레임워크를 제안했습니다. 학습 시스템 Rapid . ReaLHF: 매개변수 재할당을 통해 대규모 언어 모델에 대한 최적화된 RLHF 훈련 [3]: 최근 Wu Yi 팀은 분산 RLHF 훈련 프레임워크 ReaLHF를 추가로 구현했습니다. Wu Yi 팀의 ICML 구두 논문은 ReaLHF 시스템을 기반으로 제작되었습니다. ReaLHF 시스템은 오랫동안 개발되었으며 최적의 성능을 달성하기 위해 많은 세부 사항 연마를 거쳤습니다. 이전 오픈 소스 작업과 비교하여 ReaLHF는 사전 훈련보다 더 복잡한 시나리오인 RLHF에서 거의 선형 확장성을 달성할 수 있으며 리소스 활용도도 높고 128 A100 GPU 훈련 관련 작업에서 RLHF를 안정적이고 빠르게 수행할 수 있습니다. 오픈소스화되었습니다: https://github.com/openpsi-project/ReaLHF

위 내용은 ICML 2024 Oral | Tsinghua Wuyi 팀의 최신 계시는 DPO가 LLM에 더 적합합니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

성명:

본 글의 내용은 네티즌들의 자발적인 기여로 작성되었으며, 저작권은 원저작자에게 있습니다. 본 사이트는 이에 상응하는 법적 책임을 지지 않습니다. 표절이나 침해가 의심되는 콘텐츠를 발견한 경우 admin@php.cn으로 문의하세요.