AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

이 기사의 저자는 절강대학교, 상하이 인공지능연구소, 홍콩중문대학교, 시드니대학교 및 옥스퍼드대학교 출신입니다. 저자 목록: Wu Yixuan, Wang Yizhou, Tang Shixiang, Wu Wenhao, He Tong, Wanli Ouyang, Philip Torr, Jian Wu. 그 중 공동 제1저자인 우이쉬안(Wu Yixuan)은 저장대학교 박사과정 학생이고, 왕이저우(Wang Yizhou)는 상하이 인공지능연구소(Shanghai Artificial Intelligence Laboratory)의 과학연구 조교이다. 교신저자인 Tang Shixiang은 홍콩 중문대학교의 박사후 연구원입니다.

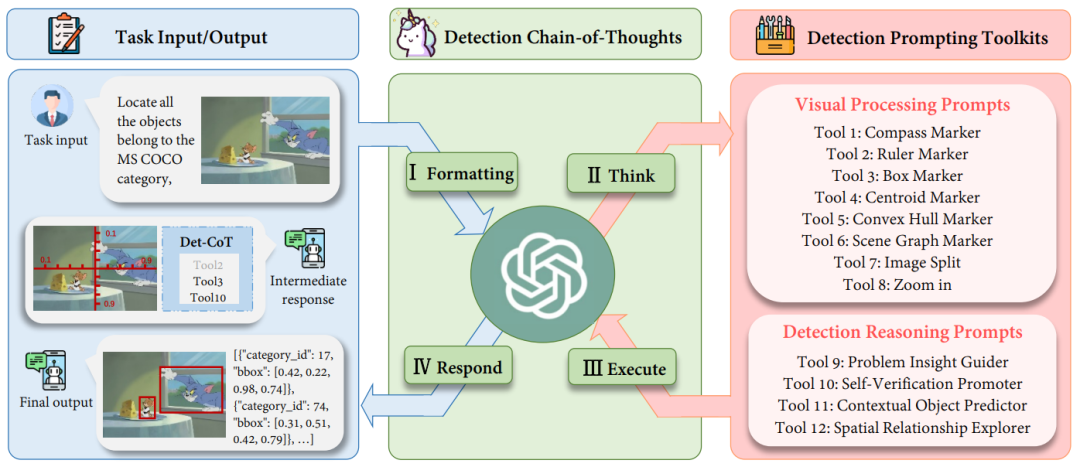

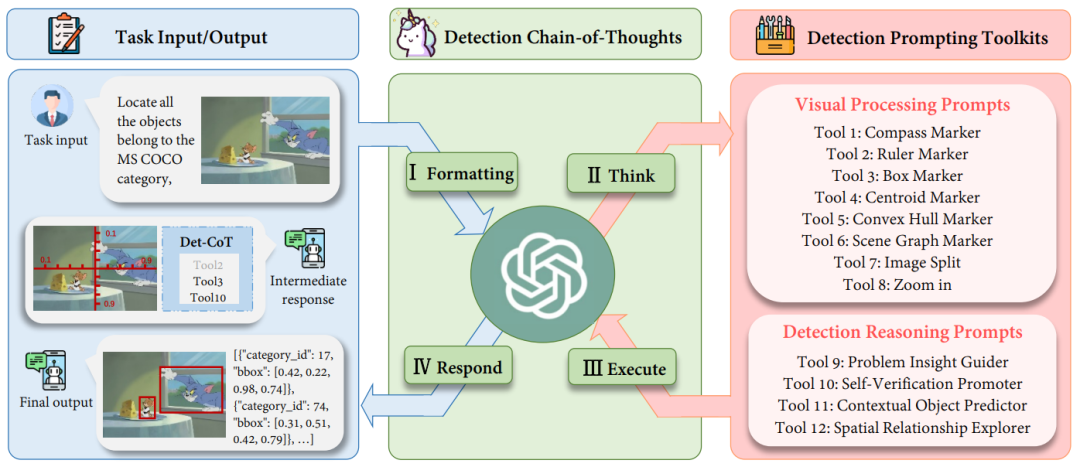

MLLM(Multimodal Large Language Model)은 다양한 작업에서 인상적인 기능을 보여줬지만, 탐지 작업에서 이러한 모델의 잠재력은 여전히 과소평가되어 있습니다. 복잡한 객체 감지 작업에 정확한 좌표가 필요한 경우 MLLM의 환각으로 인해 대상 객체를 놓치거나 부정확한 경계 상자를 제공하는 경우가 많습니다. 탐지를 위해 MLLM을 활성화하려면 기존 작업에서 대량의 고품질 명령 데이터 세트를 수집해야 할 뿐만 아니라 오픈 소스 모델을 미세 조정해야 합니다. 시간이 많이 걸리고 힘들지만 비공개 소스 모델의 보다 강력한 시각적 이해 기능을 활용하지 못합니다. 이를 위해 절강대학교는 상하이 인공지능연구소 및 옥스퍼드대학교와 함께 다중 모드 대형 언어 모델의 감지 기능을 제공하는 새로운 프롬프트 패러다임인 DetToolChain을 제안했습니다. 대규모 다중 모드 모델은 훈련 없이도 정확하게 감지하는 방법을 학습할 수 있습니다. 관련 연구가 ECCV 2024에 포함되었습니다. 탐지 작업에서 MLLM의 문제를 해결하기 위해 DetToolChain은 세 가지 지점에서 시작합니다. (1) 기존 텍스트 프롬프트보다 MLLM에 더 직접적이고 효과적인 감지를 위한 시각적 프롬프트를 디자인합니다. 2) 세부적인 탐지 작업을 작고 간단한 작업으로 나누고, (3) 일련의 사고 방식을 사용하여 탐지 결과를 점진적으로 최적화하고, 대규모 다중 모드 모델의 환상을 최대한 피합니다. 위의 통찰에 따라 DetToolChain에는 두 가지 핵심 디자인이 포함되어 있습니다. (1) 이미지에 직접 그려지고 시각적 정보와 시각적 정보 사이의 격차를 상당히 줄일 수 있는 포괄적인 시각적 처리 프롬프트(시각적 처리 프롬프트) 세트 텍스트 정보 차이. (2) 포괄적인 감지 추론 세트는 감지 대상의 공간적 이해를 향상시키고 샘플 적응형 감지 도구 체인을 통해 최종 정확한 대상 위치를 점진적으로 결정하도록 유도합니다. DetToolChain을 GPT-4V, Gemini 등의 MLLM과 결합하면 명령어 튜닝 없이 개방형 어휘 탐지, 설명 대상 탐지, 참조 표현 이해, 지향적 대상 탐지 등 다양한 탐지 작업을 지원할 수 있습니다.

- 논문 제목: DetToolChain: MLLM

- 논문 링크: https://arxiv.org/abs/2403.12488

무엇인가요? DetToolChain? ㅋㅋㅋ ~ I. 형식화: 작업의 원래 입력 형식을 MLLM에 대한 입력으로 적절한 명령 템플릿으로 변환합니다. 생각: 특정 복잡한 감지를 분석합니다. 작업을 더 간단한 하위 작업으로 분류하고 탐지 팁 툴킷( 프롬프트)에서 효과적인 팁을 선택합니다. 실행: 특정 프롬프트(프롬프트)를 순차적으로 반복적으로 실행합니다. IV 응답: MLLM의 자체 추론 기능을 사용하여 전체 탐지 프로세스를 감독합니다. 최종 응답(최종 답변)을 반환합니다.

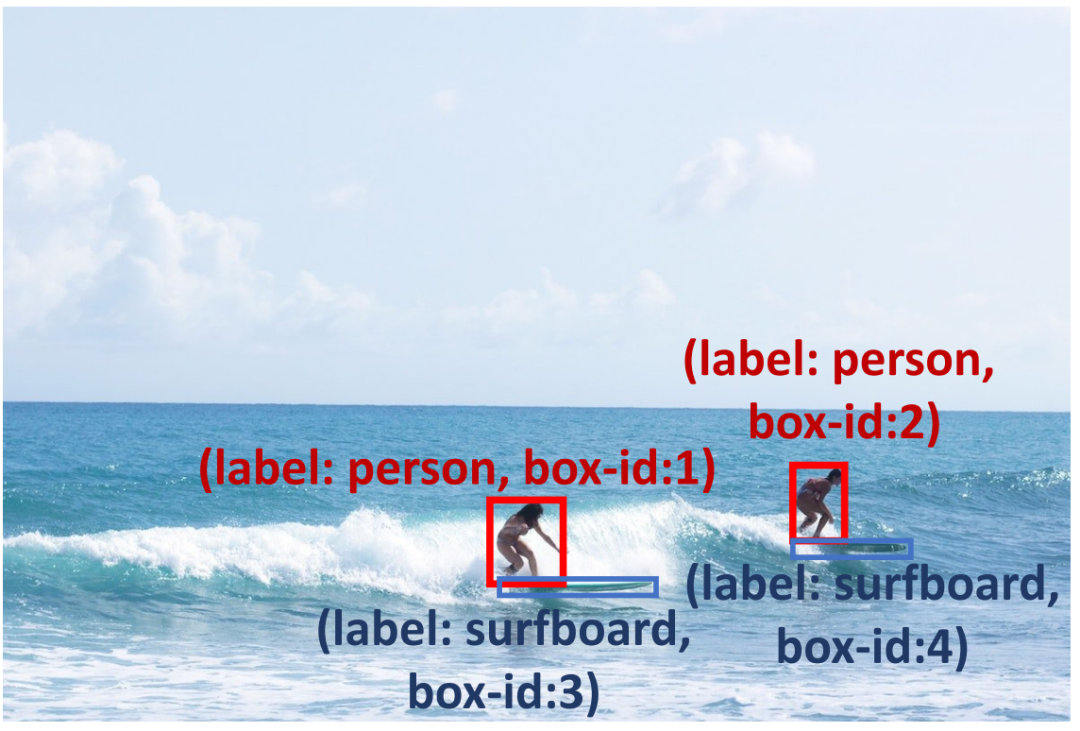

탐지 프롬프트 도구 키트: 시각적 처리 프롬프트그림 2: 시각적 처리 프롬프트의 도식적 다이어그램. 우리는 다양한 관점에서 MLLM의 감지 기능을 향상시키기 위해 (1) 지역 증폭기, (2) 공간 측정 표준, (3) 장면 이미지 파서를 설계했습니다. 그림 2에 표시된 것처럼 (1) 지역 증폭기는 원본 이미지를 다른 하위 지역으로 자르고 하위 지역에 초점을 맞추는 것을 포함하여 관심 지역(ROI)에 대한 MLLM의 가시성을 향상시키는 것을 목표로 합니다. 또한, 줌 기능을 사용하면 이미지의 특정 하위 영역을 세밀하게 관찰할 수 있습니다. (2) 공간 측정 표준은 그림 2(2)와 같이 원본 이미지에 선형 눈금으로 눈금자와 나침반을 겹쳐서 대상 탐지를 위한 보다 명확한 기준을 제공합니다. 보조 눈금자와 나침반을 사용하면 MLLM이 이미지에 겹쳐진 변환 및 회전 참조를 사용하여 정확한 좌표와 각도를 출력할 수 있습니다. 기본적으로 이 보조선은 감지 작업을 단순화하여 MLLM이 물체를 직접 예측하는 대신 물체의 좌표를 읽을 수 있도록 합니다. (3) 장면 이미지 파서는 예측된 개체 위치 또는 관계를 표시하고 공간 및 상황 정보를 사용하여 이미지의 공간 관계 이해를 달성합니다. 장면 이미지 파서는 두 가지 범주로 나눌 수 있습니다. 첫 번째, 단일 대상 개체의 경우 예측 개체에 중심, 볼록 껍질 및 레이블 이름과 상자 인덱스가 있는 경계 상자 레이블을 지정합니다. 이러한 마커는 다양한 형식으로 개체 위치 정보를 나타내므로 MLLM은 다양한 모양과 배경의 다양한 개체, 특히 모양이 불규칙하거나 심하게 가려진 개체를 감지할 수 있습니다. 예를 들어, 볼록 껍질 마커는 물체의 경계점을 표시하고 이를 볼록 껍질로 연결하여 모양이 매우 불규칙한 물체의 감지 성능을 향상시킵니다. 두 번째로, 다중 목표를 위해 장면 그래프 마커를 통해 다양한 개체의 중심을 연결하여 이미지 속 개체 간의 관계를 강조합니다. MLLM은 장면 그래프를 기반으로 상황별 추론 기능을 활용하여 예측 경계 상자를 최적화하고 환각을 피할 수 있습니다. 예를 들어 그림 2(3)에 표시된 것처럼 Jerry는 치즈를 먹고 싶어하므로 경계 상자가 매우 가까워야 합니다. 탐지 추론 프롬프트 툴킷: 감지 추론 프롬프트

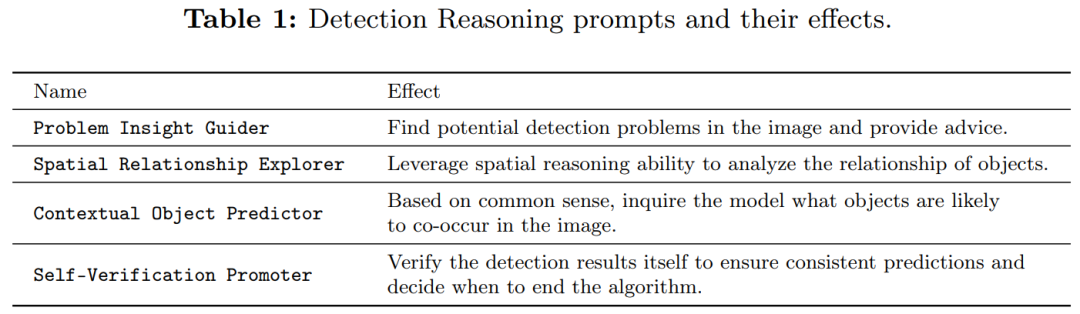

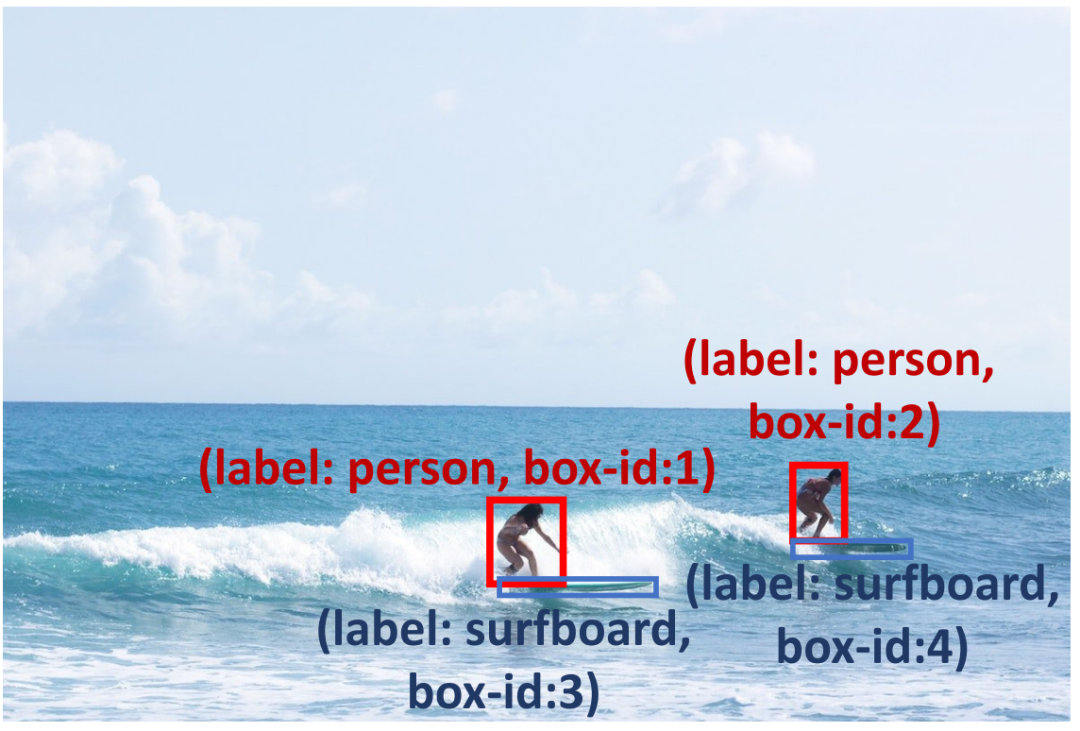

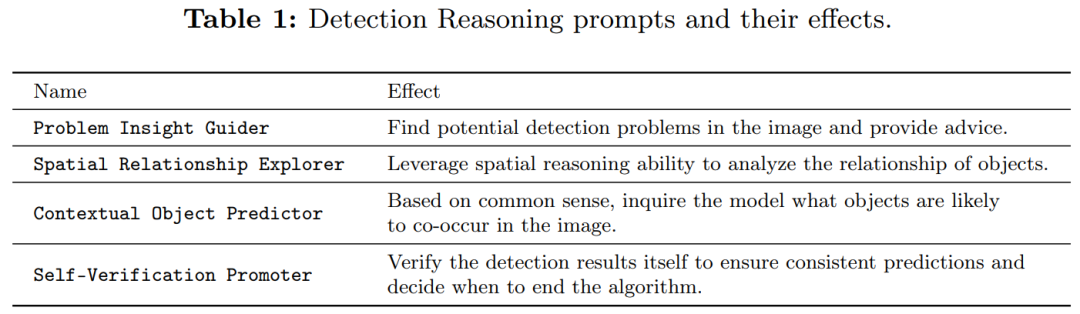

예측 상자의 신뢰성을 높이기 위해 감지 추론 프롬프트(표 1 참조)를 수행하여 예측 결과를 확인하고 잠재적인 문제를 진단했습니다. . 먼저, 어려운 문제를 강조하고 쿼리 이미지에 대한 효과적인 탐지 제안 및 유사한 예를 제공하는 Problem Insight Guider를 제안합니다. 예를 들어 그림 3의 경우 Problem Insight Guider는 쿼리를 작은 물체 감지 문제로 정의하고 서핑보드 영역을 확대하여 해결하도록 제안합니다. 둘째, MLLM의 고유한 공간 및 상황별 기능을 활용하기 위해 공간 관계 탐색기 및 상황별 개체 예측기를 설계하여 탐지 결과가 상식과 일치하도록 합니다. 그림 3에서 볼 수 있듯이 서핑보드는 바다와 함께 발생할 수 있으며(맥락적 지식), 서핑하는 사람의 발 근처에 서핑보드가 있어야 합니다(공간적 지식). 또한, 자체 검증 프로모터(Self-Verification Promoter)를 적용하여 여러 라운드에 걸쳐 응답의 일관성을 향상합니다. MLLM의 추론 능력을 더욱 향상시키기 위해 토론 및 자체 디버깅과 같이 널리 사용되는 프롬프트 방법을 채택합니다. 자세한 설명은 원문을 참조하시기 바랍니다. ㅋㅋ 감지 추론 힌트는 MLLM이 작은 개체 감지 문제를 해결하는 데 도움이 될 수 있습니다. 예를 들어 상식을 사용하여 사람의 발 아래에 있는 서핑 보드를 찾고 모델이 바다에서 서핑 보드를 감지하도록 장려할 수 있습니다. pexperiment : 2에 표시된 것처럼 테이블에 표시된 것처럼 훈련없이 미세 조정 방법을 능가 할 수 있습니다. OVD (Open Vocabulary Detection)에 대한 방법을 평가했습니다. , 17개의 새로운 클래스, 48개의 기본 클래스 및 COCO OVD 벤치마크의 모든 클래스에 대한 AP50 결과를 테스트했습니다. 결과는 DetToolChain을 사용하여 GPT-4V와 Gemini의 성능이 크게 향상되었음을 보여줍니다.

為了展示我們的方法在指稱表達理解上的有效性,我們將我們的方法與其他零樣本方法在 RefCOCO、RefCOCO + 和 RefCOCOg 資料集上進行了比較(表 5)。在RefCOCO 上,DetToolChain 使得GPT-4V 基線在val、test-A 和test-B 上的性能分別提升了44.53%、46.11% 和24.85%,展示了DetToolChain 在zero-shot 條件下優越的指稱表達理解和定位性能。 위 내용은 ECCV 2024 | GPT-4V 및 Gemini 탐지 작업의 성능을 향상하려면 이 프롬프트 패러다임이 필요합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!