Ollama Cloud 구축 - 로컬 추론을 클라우드로 확장

- WBOY원래의

- 2024-07-18 00:38:11790검색

Ollama는 주로 로컬 추론 작업을 위해 설계된 llama.cpp의 래퍼입니다. 최첨단 성능이나 기능을 찾는 경우 일반적으로 첫 번째 선택은 아니지만, 특히 외부 종속성이 문제가 되는 환경에서 유용하게 사용할 수 있습니다.

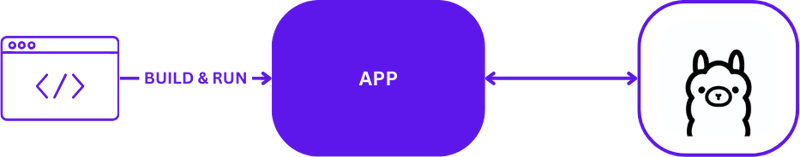

로컬 AI 개발

로컬 AI 개발을 위해 Ollama를 사용할 때 설정은 간단하면서도 효과적입니다. 개발자는 일반적으로 Ollama를 활용하여 로컬 컴퓨터에서 직접 추론 작업을 실행합니다. 다음은 Ollama를 사용한 일반적인 로컬 개발 설정을 시각적으로 나타낸 것입니다.

이 구성을 사용하면 개발자는 원격 서버 통신의 복잡성 없이 빠르게 테스트하고 반복할 수 있습니다. 빠른 처리가 중요한 초기 프로토타입 제작 및 개발 단계에 이상적입니다.

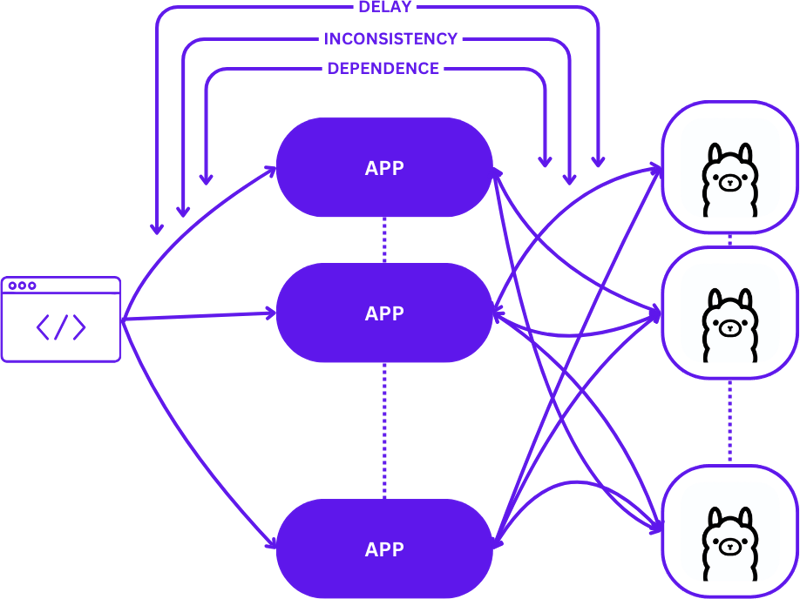

로컬에서 클라우드로

로컬 설정에서 확장 가능한 클라우드 환경으로 전환하려면 단순한 1:1 설정(한 사용자 요청에서 하나의 추론 호스트로)에서 보다 복잡한 다대다(여러 사용자 요청에서 여러 추론 호스트로) 구성으로 발전해야 합니다. . 수요가 증가함에 따라 효율성과 대응성을 유지하려면 이러한 변화가 필요합니다.

로컬 개발에서 프로덕션으로 이동할 때 이러한 확장이 어떻게 나타나는지는 다음과 같습니다.

이 전환 중에 간단한 접근 방식을 채택하면 특히 세션이 다양한 상태에서 일관성을 유지해야 하기 때문에 애플리케이션의 복잡성이 크게 증가할 수 있습니다. 요청이 사용 가능한 최상의 추론 호스트로 최적으로 라우팅되지 않으면 지연과 비효율성이 발생할 수 있습니다.

게다가 분산 애플리케이션의 복잡한 특성으로 인해 로컬에서 테스트하기가 어려워 개발 프로세스 속도가 느려지고 프로덕션 환경에서 오류가 발생할 위험이 높아질 수 있습니다.

서버리스

서버리스 컴퓨팅은 서버 관리 및 인프라 세부 정보를 추상화하므로 개발자는 코드 및 비즈니스 로직에만 집중할 수 있습니다. 요청 처리 및 일관성 유지 관리를 애플리케이션에서 분리함으로써 서버리스 아키텍처는 확장을 단순화합니다.

이 접근 방식을 사용하면 개발자에게 인프라 복잡성으로 인한 부담을 주지 않으면서 애플리케이션이 가치 제공에 계속 집중하여 여러 가지 일반적인 확장 문제를 해결할 수 있습니다.

웹어셈블리

WebAssembly(Wasm)는 애플리케이션을 독립형 모듈로 컴파일할 수 있도록 하여 종속성 관리 문제를 해결합니다. 이를 통해 로컬과 클라우드 모두에서 앱을 더 쉽게 조정하고 테스트할 수 있으므로 다양한 환경에서 일관성이 보장됩니다.

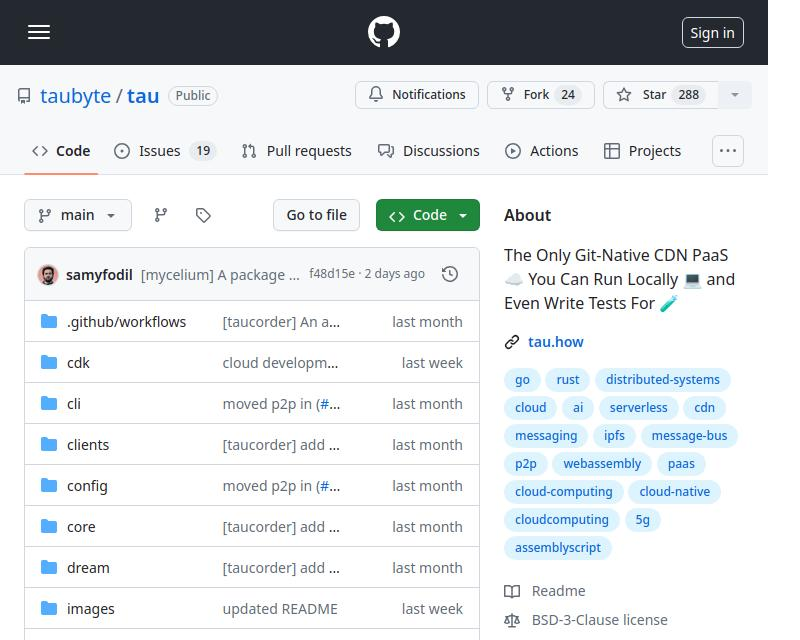

타우

Tau는 유지 관리가 적고 확장성이 뛰어난 클라우드 컴퓨팅 플랫폼을 구축하기 위한 프레임워크입니다. 단순성과 확장성이 뛰어납니다. Tau는 배포를 단순화하고 개발을 위한 로컬 클라우드 실행을 지원하므로 클라우드 인프라와 여기에서 실행되는 애플리케이션 모두에 대한 엔드투엔드(E2E) 테스트가 가능합니다.

Taubyte에서 '로컬 코딩은 글로벌 생산과 동일'이라고 부르는 이 접근 방식은 로컬에서 작동하는 것이 전 세계적으로 작동하도록 보장하여 개발 및 배포 프로세스를 크게 단순화합니다.

Orbit 플러그인 시스템을 사용하여 Ollama를 Tau에 통합

Orbit로 알려진 Tau의 플러그인 시스템은 서비스를 WebAssembly 호스트 모듈로 래핑하여 서비스를 관리 가능한 구성 요소로 전환하는 것을 크게 단순화합니다. 이러한 접근 방식을 통해 Tau는 조정 업무를 맡아 배포 및 관리 프로세스를 간소화할 수 있습니다.

Ollama에서 함수 내보내기

Tau 생태계 내에서 Ollama 기능에 액세스할 수 있도록 하기 위해 Orbit 시스템을 활용하여 Ollama의 기능을 호출 가능한 엔드포인트로 내보냅니다. Go에서 엔드포인트를 내보내는 방법은 다음과 같습니다.

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

함수 내보내기에 대한 간단한 예를 보려면 hello_world 예를 참조하세요.

한 번 정의되면 이제 Satellite.Export를 통해 호출되는 이러한 기능을 통해 Ollama를 Tau 환경에 원활하게 통합할 수 있습니다.

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

Ollama 플러그인에 대한 테스트 작성

플러그인 테스트가 간소화되고 간단해졌습니다. Go에서 서버리스 기능 테스트를 작성하는 방법은 다음과 같습니다.

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

Tau의 테스트 제품군과 Go 빌더 도구를 사용하면 플러그인을 빌드하고, 테스트 환경에 배포하고, 서버리스 기능을 실행하여 기능을 확인할 수 있습니다.

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

Code

You can find the complete code here https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/Ollama Cloud 구축 - 로컬 추론을 클라우드로 확장

What's Next?

You can now build LLM applications with ease. Here are the steps to get started:

- Start locally using dream: Set up your local environment to develop and test your application.

- Create a project: Begin a new project with Tau to harness its full potential.

- Create your production cloud: Deploy your project in a production cloud environment.

- Drop the plugin binary in the /tb/plugins folder.

- Import your project into production

- Show off!

위 내용은 Ollama Cloud 구축 - 로컬 추론을 클라우드로 확장의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!