1분짜리 고화질 비디오 합성을 지원합니다. Huake 등은 인간 춤 비디오 생성을 위한 새로운 프레임워크인 UniAnimate를 제안했습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB원래의

- 2024-06-09 11:10:581088검색

AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

논문주소 : https://arxiv.org/abs/2406.01188 프로젝트 홈페이지 : https://unianimate.github.io/

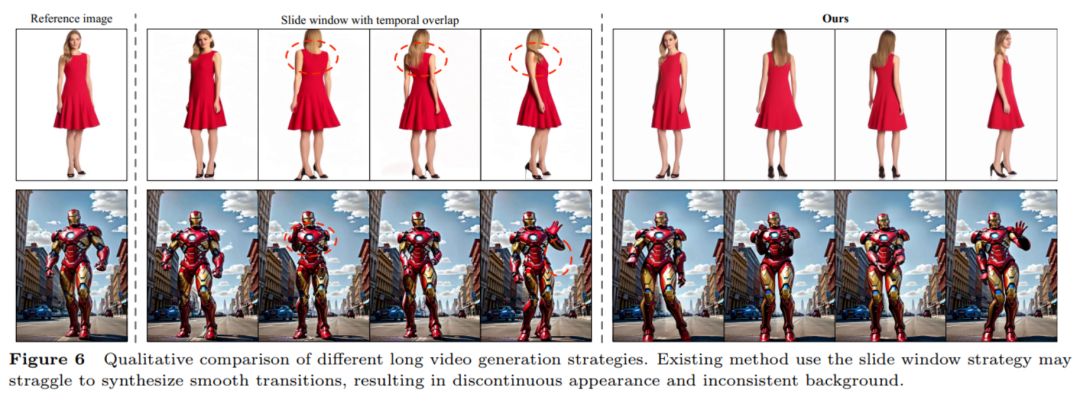

추가 참조 네트워크가 필요하지 않습니다: UniAnimate 프레임워크는 통합 비디오 확산 모델을 통해 추가 참조 네트워크에 대한 의존성을 제거하여 훈련 난이도와 모델 수를 줄입니다. 매개변수. 추가 참조 조건으로 참조 이미지의 포즈 맵을 도입합니다. 이는 네트워크가 참조 포즈와 대상 포즈 사이의 대응 관계를 학습하고 양호한 겉보기 정렬을 달성하도록 촉진합니다. 통합 프레임워크 내에서 긴 시퀀스 비디오 생성: 통합 노이즈 입력을 추가함으로써 UniAnimate는 더 이상 기존 방법의 시간 제약을 받지 않고 프레임 내에서 장기 비디오를 생성할 수 있습니다. 매우 일관성: UniAnimate 프레임워크는 후속 프레임을 생성하기 위한 조건으로 첫 번째 프레임을 반복적으로 사용하여 생성된 비디오의 원활한 전환 효과를 보장하여 비디오의 모양이 더욱 일관되고 일관되게 만듭니다. 또한 이 전략을 통해 사용자는 여러 비디오 클립을 생성하고 좋은 결과를 얻은 클립의 마지막 프레임을 다음 생성된 클립의 첫 번째 프레임으로 선택할 수 있으므로 사용자가 더 쉽게 모델과 상호 작용하고 필요에 따라 생성 결과를 조정할 수 있습니다. 그러나 이전 시계열 중첩의 슬라이딩 윈도우 전략을 사용하여 긴 비디오를 생성하는 경우 확산 과정의 각 단계에서 각 비디오가 서로 결합되므로 세그먼트 선택을 수행할 수 없습니다.

위 내용은 1분짜리 고화질 비디오 합성을 지원합니다. Huake 등은 인간 춤 비디오 생성을 위한 새로운 프레임워크인 UniAnimate를 제안했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

성명:

본 글의 내용은 네티즌들의 자발적인 기여로 작성되었으며, 저작권은 원저작자에게 있습니다. 본 사이트는 이에 상응하는 법적 책임을 지지 않습니다. 표절이나 침해가 의심되는 콘텐츠를 발견한 경우 admin@php.cn으로 문의하세요.