百度贴吧的爬虫制作和糗百的爬虫制作原理基本相同,都是通过查看源码扣出关键数据,然后将其存储到本地txt文件。

项目内容:

用Python写的百度贴吧的网络爬虫。

使用方法:

新建一个BugBaidu.py文件,然后将代码复制到里面后,双击运行。

程序功能:

将贴吧中楼主发布的内容打包txt存储到本地。

原理解释:

首先,先浏览一下某一条贴吧,点击只看楼主并点击第二页之后url发生了一点变化,变成了:

http://tieba.baidu.com/p/2296712428?see_lz=1&pn=1

可以看出来,see_lz=1是只看楼主,pn=1是对应的页码,记住这一点为以后的编写做准备。

这就是我们需要利用的url。

接下来就是查看页面源码。

首先把题目抠出来存储文件的时候会用到。

可以看到百度使用gbk编码,标题使用h1标记:

【原创】时尚首席(关于时尚,名利,事业,爱情,励志)

同样,正文部分用div和class综合标记,接下来要做的只是用正则表达式来匹配即可。

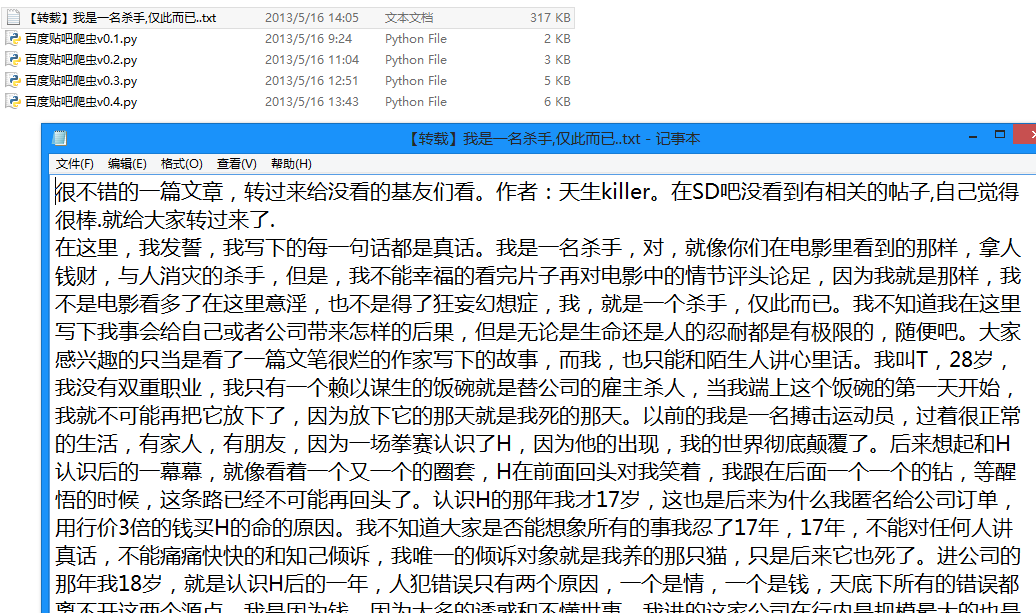

运行截图:

生成的txt文件:

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:百度贴吧爬虫

# 版本:0.5

# 作者:why

# 日期:2013-05-16

# 语言:Python 2.7

# 操作:输入网址后自动只看楼主并保存到本地文件

# 功能:将楼主发布的内容打包txt存储到本地。

#---------------------------------------

import string

import urllib2

import re

#----------- 处理页面上的各种标签 -----------

class HTML_Tool:

# 用非 贪婪模式 匹配 \t 或者 \n 或者 空格 或者 超链接 或者 图片

BgnCharToNoneRex = re.compile("(\t|\n| |

# 用非 贪婪模式 匹配 任意标签

EndCharToNoneRex = re.compile("<.>")

# 用非 贪婪模式 匹配 任意

标签

BgnPartRex = re.compile("

CharToNewLineRex = re.compile("(

||

CharToNextTabRex = re.compile("

# 将一些html的符号实体转变为原始符号

replaceTab = [("",">"),("&","&"),("&","\""),(" "," ")]

def Replace_Char(self,x):

x = self.BgnCharToNoneRex.sub("",x)

x = self.BgnPartRex.sub("\n ",x)

x = self.CharToNewLineRex.sub("\n",x)

x = self.CharToNextTabRex.sub("\t",x)

x = self.EndCharToNoneRex.sub("",x)

for t in self.replaceTab:

x = x.replace(t[0],t[1])

return x

class Baidu_Spider:

# 申明相关的属性

def __init__(self,url):

self.myUrl = url + '?see_lz=1'

self.datas = []

self.myTool = HTML_Tool()

print u'已经启动百度贴吧爬虫,咔嚓咔嚓'

# 初始化加载页面并将其转码储存

def baidu_tieba(self):

# 读取页面的原始信息并将其从gbk转码

myPage = urllib2.urlopen(self.myUrl).read().decode("gbk")

# 计算楼主发布内容一共有多少页

endPage = self.page_counter(myPage)

# 获取该帖的标题

title = self.find_title(myPage)

print u'文章名称:' + title

# 获取最终的数据

self.save_data(self.myUrl,title,endPage)

#用来计算一共有多少页

def page_counter(self,myPage):

# 匹配 "共有12页" 来获取一共有多少页

myMatch = re.search(r'class="red">(\d+?)', myPage, re.S)

if myMatch:

endPage = int(myMatch.group(1))

print u'爬虫报告:发现楼主共有%d页的原创内容' % endPage

else:

endPage = 0

print u'爬虫报告:无法计算楼主发布内容有多少页!'

return endPage

# 用来寻找该帖的标题

def find_title(self,myPage):

# 匹配

xxxxxxxxxx

找出标题myMatch = re.search(r'

title = u'暂无标题'

if myMatch:

title = myMatch.group(1)

else:

print u'爬虫报告:无法加载文章标题!'

# 文件名不能包含以下字符: \ / : * ? " |

title = title.replace('\\','').replace('/','').replace(':','').replace('*','').replace('?','').replace('"','').replace('>','').replace(' return title

# 用来存储楼主发布的内容

def save_data(self,url,title,endPage):

# 加载页面数据到数组中

self.get_data(url,endPage)

# 打开本地文件

f = open(title+'.txt','w+')

f.writelines(self.datas)

f.close()

print u'爬虫报告:文件已下载到本地并打包成txt文件'

print u'请按任意键退出...'

raw_input();

# 获取页面源码并将其存储到数组中

def get_data(self,url,endPage):

url = url + '&pn='

for i in range(1,endPage+1):

print u'爬虫报告:爬虫%d号正在加载中...' % i

myPage = urllib2.urlopen(url + str(i)).read()

# 将myPage中的html代码处理并存储到datas里面

self.deal_data(myPage.decode('gbk'))

# 将内容从页面代码中抠出来

def deal_data(self,myPage):

myItems = re.findall('id="post_content.*?>(.*?)',myPage,re.S)

for item in myItems:

data = self.myTool.Replace_Char(item.replace("\n","").encode('gbk'))

self.datas.append(data+'\n')

#-------- 程序入口处 ------------------

print u"""#---------------------------------------

# 程序:百度贴吧爬虫

# 版本:0.5

# 作者:why

# 日期:2013-05-16

# 语言:Python 2.7

# 操作:输入网址后自动只看楼主并保存到本地文件

# 功能:将楼主发布的内容打包txt存储到本地。

#---------------------------------------

"""

# 以某小说贴吧为例子

# bdurl = 'http://tieba.baidu.com/p/2296712428?see_lz=1&pn=1'

print u'请输入贴吧的地址最后的数字串:'

bdurl = 'http://tieba.baidu.com/p/' + str(raw_input(u'http://tieba.baidu.com/p/'))

#调用

mySpider = Baidu_Spider(bdurl)

mySpider.baidu_tieba()

以上就是改进之后的抓取百度贴吧的全部代码了,非常的简单实用吧,希望能对大家有所帮助

파이썬 어레이를 어떻게 슬라이스합니까?May 01, 2025 am 12:18 AM

파이썬 어레이를 어떻게 슬라이스합니까?May 01, 2025 am 12:18 AMPython List 슬라이싱의 기본 구문은 목록 [start : stop : step]입니다. 1. Start는 첫 번째 요소 인덱스, 2.Stop은 첫 번째 요소 인덱스가 제외되고 3. Step은 요소 사이의 단계 크기를 결정합니다. 슬라이스는 데이터를 추출하는 데 사용될뿐만 아니라 목록을 수정하고 반전시키는 데 사용됩니다.

어떤 상황에서 목록이 배열보다 더 잘 수행 될 수 있습니까?May 01, 2025 am 12:06 AM

어떤 상황에서 목록이 배열보다 더 잘 수행 될 수 있습니까?May 01, 2025 am 12:06 AMListSoutPerformArraysin : 1) DynamicsizingandFrequentInsertions/Deletions, 2) StoringHeterogeneousData 및 3) MemoryEfficiencyForsParsEdata, butMayHavesLightPerformanceCosceperationOperations.

파이썬 어레이를 파이썬 목록으로 어떻게 변환 할 수 있습니까?May 01, 2025 am 12:05 AM

파이썬 어레이를 파이썬 목록으로 어떻게 변환 할 수 있습니까?May 01, 2025 am 12:05 AMTOCONVERTAPYTHONARRAYTOALIST, USETHELIST () CONSTUCTORORAGENERATERATOREXPRESSION.1) importTheArrayModuleAndCreateAnarray.2) USELIST (ARR) 또는 [XFORXINARR] TOCONVERTITTOALIST.

Python에 목록이있을 때 배열을 사용하는 목적은 무엇입니까?May 01, 2025 am 12:04 AM

Python에 목록이있을 때 배열을 사용하는 목적은 무엇입니까?May 01, 2025 am 12:04 AMchooSearRaysOverListSinpyTonforBetTerferformanceAndMemoryEfficiencyInspecificscenarios.1) arrgenumericalDatasets : arraysreducememoryUsage.2) Performance-CriticalOperations : ArraysofferspeedboostsfortaskslikeApenorsearching.3) TypeSenforc

목록과 배열의 요소를 반복하는 방법을 설명하십시오.May 01, 2025 am 12:01 AM

목록과 배열의 요소를 반복하는 방법을 설명하십시오.May 01, 2025 am 12:01 AM파이썬에서는 루프에 사용하여 열거 및 추적 목록에 대한 이해를 나열 할 수 있습니다. Java에서는 루프를 위해 전통적인 사용 및 루프가 트래버스 어레이를 향해 향상시킬 수 있습니다. 1. Python 목록 트래버스 방법에는 다음이 포함됩니다. 루프, 열거 및 목록 이해력. 2. Java 어레이 트래버스 방법에는 다음이 포함됩니다. 루프 용 전통 및 루프를위한 향상.

Python Switch 문은 무엇입니까?Apr 30, 2025 pm 02:08 PM

Python Switch 문은 무엇입니까?Apr 30, 2025 pm 02:08 PM이 기사는 버전 3.10에 도입 된 Python의 새로운 "매치"진술에 대해 논의하며, 이는 다른 언어로 된 문장과 동등한 역할을합니다. 코드 가독성을 향상시키고 기존 IF-ELIF-EL보다 성능 이점을 제공합니다.

파이썬의 예외 그룹은 무엇입니까?Apr 30, 2025 pm 02:07 PM

파이썬의 예외 그룹은 무엇입니까?Apr 30, 2025 pm 02:07 PMPython 3.11의 예외 그룹은 여러 예외를 동시에 처리하여 동시 시나리오 및 복잡한 작업에서 오류 관리를 향상시킵니다.

파이썬의 기능 주석이란 무엇입니까?Apr 30, 2025 pm 02:06 PM

파이썬의 기능 주석이란 무엇입니까?Apr 30, 2025 pm 02:06 PMPython의 기능 주석은 유형 확인, 문서 및 IDE 지원에 대한 기능에 메타 데이터를 추가합니다. 코드 가독성, 유지 보수를 향상 시키며 API 개발, 데이터 과학 및 라이브러리 생성에 중요합니다.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

WebStorm Mac 버전

유용한 JavaScript 개발 도구

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

안전한 시험 브라우저

안전한 시험 브라우저는 온라인 시험을 안전하게 치르기 위한 보안 브라우저 환경입니다. 이 소프트웨어는 모든 컴퓨터를 안전한 워크스테이션으로 바꿔줍니다. 이는 모든 유틸리티에 대한 액세스를 제어하고 학생들이 승인되지 않은 리소스를 사용하는 것을 방지합니다.