ホームページ >テクノロジー周辺機器 >AI >パラメータが 10 億未満の OctopusV3 は、GPT-4V や GPT-4 とどのように比較できるのでしょうか?

パラメータが 10 億未満の OctopusV3 は、GPT-4V や GPT-4 とどのように比較できるのでしょうか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-05-02 16:01:01942ブラウズ

マルチモーダル AI システムは、自然言語、視覚、音声などのさまざまなタイプのデータを処理および学習して、行動決定を導く機能を特徴としています。最近、視覚データを大規模な言語モデル (GPT-4V など) に組み込む研究が重要な進歩を遂げていますが、画像情報を AI システムの実行可能な操作に効果的に変換する方法は依然として課題に直面しています。 画像情報の変換を実現する一般的な方法は、画像データを対応するテキスト記述に変換し、AI システムがその記述に基づいて動作することです。これは、既存の画像データセットに対して教師あり学習を実行することで実現でき、AI システムが画像とテキストのマッピング関係を自動的に学習できるようになります。さらに、強化学習手法を使用して、環境と対話することで画像情報に基づいて意思決定を行う方法を学習することもできます。 もう 1 つの方法は、画像情報と言語モデルを直接組み合わせて構築することです。

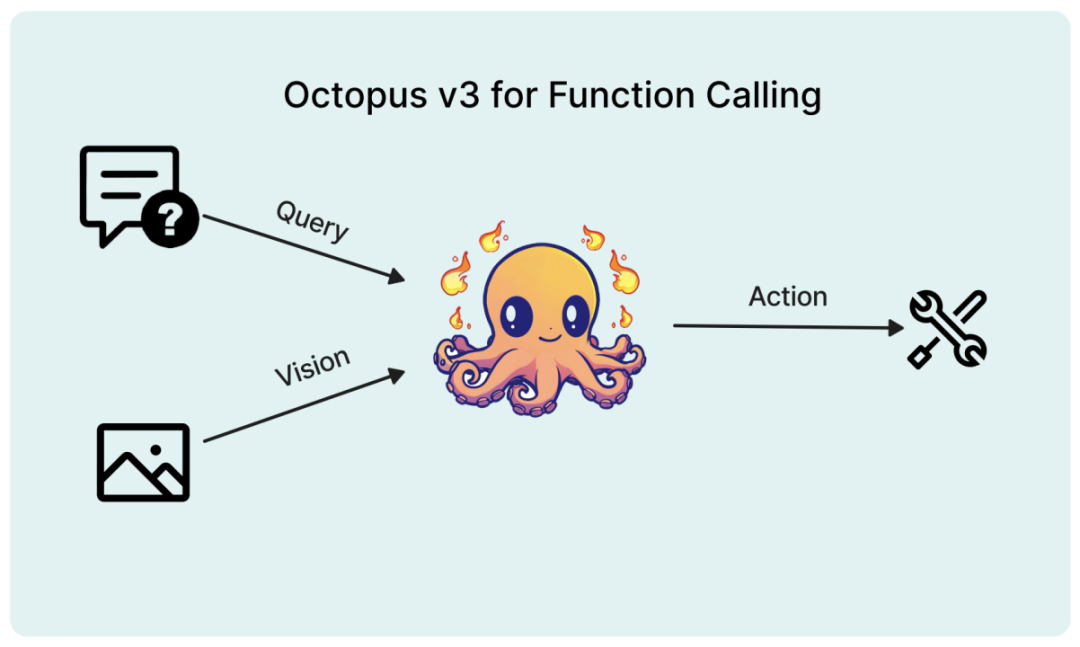

最近の論文では、研究者らは AI アプリケーション向けに特別に設計されたマルチモーダル モデルを提案し、「機能的「トークン」」概念を導入しました。

論文タイトル: Octopus v3: オンデバイス サブビリオン マルチモーダル AI エージェントのテクニカル レポート

論文リンク: https://arxiv .org/pdf/2404.11459.pdf

モデルの重みと推論コード: https://www.nexa4ai.com/apply

##研究の背景

##研究の背景人工知能テクノロジーの急速な発展により、人間とコンピューターの対話方法が完全に変わり、複雑なタスクを実行し、自然言語、視覚、その他の形式の入力に基づいて意思決定を行うことができる、多くのインテリジェント AI システムが誕生しました。これらのシステムは、画像認識や言語翻訳などの単純なタスクから、医療診断や自動運転などの複雑なアプリケーションに至るまで、あらゆるものを自動化することが期待されています。マルチモーダル言語モデルはこれらのインテリジェント システムの中核であり、テキスト、画像、さらにはオーディオやビデオなどのマルチモーダル データを処理および統合することにより、人間に近い応答を理解して生成できるようになります。主にテキストの処理と生成に焦点を当てた従来の言語モデルと比較して、マルチモーダル言語モデルは大きな進歩です。視覚的な情報を組み込むことで、これらのモデルは入力データのコンテキストとセマンティクスをより深く理解できるようになり、より正確で関連性の高い出力が得られます。マルチモーダル データを処理および統合する機能は、マルチモーダル AI システムの開発にとって重要であり、視覚的な質問応答、画像ナビゲーション、マルチモーダル感情分析など、言語と視覚情報などのタスクを同時に理解できるようになります。

マルチモーダル言語モデルの開発における課題の 1 つは、視覚情報をモデルが処理できる形式に効果的にエンコードする方法です。これは通常、ビジュアル トランスフォーマー (ViT) や畳み込みニューラル ネットワーク (CNN) などのニューラル ネットワーク アーキテクチャを利用して行われます。画像から階層的特徴を抽出する機能は、コンピューター ビジョン タスクで広く使用されています。これらのアーキテクチャをモデルとして使用すると、入力データからより複雑な表現を抽出する方法を学ぶことができます。さらに、トランスフォーマーベースのアーキテクチャは、長距離の依存関係を捉えることができるだけでなく、画像内のオブジェクト間の関係を理解することにも優れています。近年非常に人気があります。これらのアーキテクチャにより、モデルは入力画像から意味のある特徴を抽出し、テキスト入力と組み合わせることができるベクトル表現に変換できます。

視覚情報をエンコードするもう 1 つの方法は、画像の記号化 (トークン化) です。これは、画像をより小さな個別の単位またはトークンに分割します。このアプローチにより、モデルはテキストと同様の方法で画像を処理できるようになり、2 つのモダリティをよりシームレスに統合できるようになります。画像トークン情報をテキスト入力とともにモデルに入力できるため、モデルは両方のモダリティに焦点を当て、より正確で状況に応じた出力を生成できます。たとえば、OpenAI によって開発された DALL-E モデルは、VQ-VAE (ベクトル量子化変分オートエンコーダー) のバリアントを使用して画像をシンボル化し、モデルがテキストの説明に基づいて新しい画像を生成できるようにします。ユーザーが指定したクエリや画像に基づいて動作できる、小さく効率的なモデルを開発することは、将来の AI システムの開発に大きな影響を与えるでしょう。これらのモデルは、スマートフォンや IoT デバイスなどのリソースに制約のあるデバイスに展開でき、アプリケーションの範囲とシナリオが拡張されます。マルチモーダル言語モデルの力を活用することで、これらの小規模システムは、ユーザーが提供する視覚的なコンテキストを考慮しながら、より自然かつ直観的な方法でユーザーのクエリを理解し、応答することができます。これにより、ユーザーの好みに基づいて視覚的な推奨事項を提供する仮想アシスタントや、ユーザーの顔の表情に基づいて設定を調整するスマート ホーム デバイスなど、より魅力的でパーソナライズされたヒューマン マシン インタラクションの可能性が開かれます。

さらに、マルチモーダル AI システムの開発により、人工知能テクノロジーが民主化され、より広範囲のユーザーと業界に利益がもたらされることが期待されています。より小型で効率的なモデルは、コンピューティング能力が低いハードウェアでトレーニングできるため、展開に必要なコンピューティング リソースとエネルギー消費が削減されます。これにより、医療、教育、エンターテインメント、電子商取引などのさまざまな分野でAIシステムが広範に適用され、最終的には人々の生活や働き方が変わる可能性があります。

関連作品

マルチモーダル モデルは、テキスト、画像、音声などの複数のデータ タイプを処理および学習できるため、多くの注目を集めています。このタイプのモデルは、さまざまなモダリティ間の複雑な相互作用をキャプチャし、それらの補完的な情報を使用してさまざまなタスクのパフォーマンスを向上させることができます。 ViLBERT、LXMERT、VisualBERT などの Vision-Language Pre-trained (VLP) モデルは、クロスモーダルな注意を通じて視覚的特徴とテキスト特徴の位置合わせを学習し、豊かなマルチモーダル表現を生成します。 MMT、ViLT などのマルチモーダル変換器アーキテクチャでは、複数のモダリティを効率的に処理できるように変換器が改良されています。研究者らは、音声や顔の表情などの他のモダリティを、マルチモーダル感情分析 (MSA) モデルやマルチモーダル感情認識 (MER) モデルなどのモデルに組み込むことも試みています。さまざまなモダリティの補完的な情報を利用することにより、マルチモーダル モデルは、単一モーダルの方法よりも優れたパフォーマンスと汎化機能を実現します。

端末言語モデルは、70 億未満のパラメータを持つモデルとして定義されています。これは、量子化を行っても、エッジ デバイス上で 130 億のパラメータ モデルを実行するのは非常に難しいことが研究者によって判明したためです。この分野における最近の進歩には、Google の Gemma 2B および 7B、Stable Diffusion の Stable Code 3B、Meta の Llama 7B などがあります。興味深いことに、Meta の研究では、大規模な言語モデルとは異なり、小規模な言語モデルは深くて狭いアーキテクチャでより優れたパフォーマンスを発揮することを示しています。端末モデルに有益な他の技術には、MobileLLM で提案されている埋め込み共有、グループ化されたクエリ アテンション、インスタント ブロック重み共有などがあります。これらの調査結果は、エンド アプリケーション向けの小規模な言語モデルを開発する場合、大規模なモデルの場合とは異なる最適化方法と設計戦略を考慮する必要があることを浮き彫りにしています。

Octopus メソッド

Octopus v3 モデルの開発で使用される主なテクニック。マルチモーダル モデル開発の 2 つの重要な側面は、画像情報とテキスト入力を統合することと、アクションを予測するモデルの機能を最適化することです。

視覚情報のエンコーディング

画像処理における視覚情報の符号化手法は数多くあり、隠れ層の埋め込みがよく使われます。たとえば、VGG-16 モデルの隠れ層埋め込みは、スタイル転送タスクに使用されます。 OpenAI の CLIP モデルは、画像エンコーダーを利用して画像を埋め込み、テキストと画像の埋め込みを調整する機能を示しています。 ViT などの方法では、画像のトークン化などのより高度なテクノロジーが使用されます。研究者らはさまざまな画像コーディング手法を評価し、CLIP モデル手法が最も効果的であることを発見しました。したがって、この論文では画像コーディングに CLIP ベースのモデルを使用します。

関数トークン

自然言語や画像に適用されるトークン化と同様に、特定の関数を関数トークンとしてカプセル化することもできます。研究者らは、目に見えない単語を処理する自然言語モデルのテクノロジーを活用した、これらのトークンのトレーニング戦略を導入しました。このメソッドは word2vec に似ており、コンテキストを通じてトークンのセマンティクスを強化します。たとえば、高級言語モデルは最初、PEG化やエンドソームエスケープなどの複雑な化学用語に苦労するかもしれません。しかし、因果言語モデリングを通じて、特にこれらの用語を含むデータセットでトレーニングすることによって、モデルはこれらの用語を学習できます。同様に、機能トークンも並行戦略を通じて学習でき、Octopus v2 モデルはそのような学習プロセスに強力なプラットフォームを提供します。研究によると、関数トークンの定義空間は無限であり、あらゆる特定の関数をトークンとして表現できることがわかっています。

マルチステージトレーニング

高性能マルチモーダル AI システムを開発するために、研究者らは因果言語モデルと画像エンコーダーを統合するモデル アーキテクチャを採用しました。 。このモデルのトレーニング プロセスは複数の段階に分かれています。まず、因果言語モデルと画像エンコーダーを個別にトレーニングして、基本モデルを確立します。その後、2 つのコンポーネントがマージされ、調整され、画像とテキストの処理機能を同期するようにトレーニングされます。これに基づいて、Octopus v2 の手法を使用して機能トークンの学習を促進します。最後のトレーニング段階では、環境と対話するこれらの機能トークンが、モデルをさらに最適化するためのフィードバックを提供します。したがって、最終段階で研究者らは強化学習を採用し、報酬モデルとして別の大規模な言語モデルを選択しました。この反復トレーニング方法により、マルチモーダル情報を処理および統合するモデルの能力が強化されます。

モデルの評価

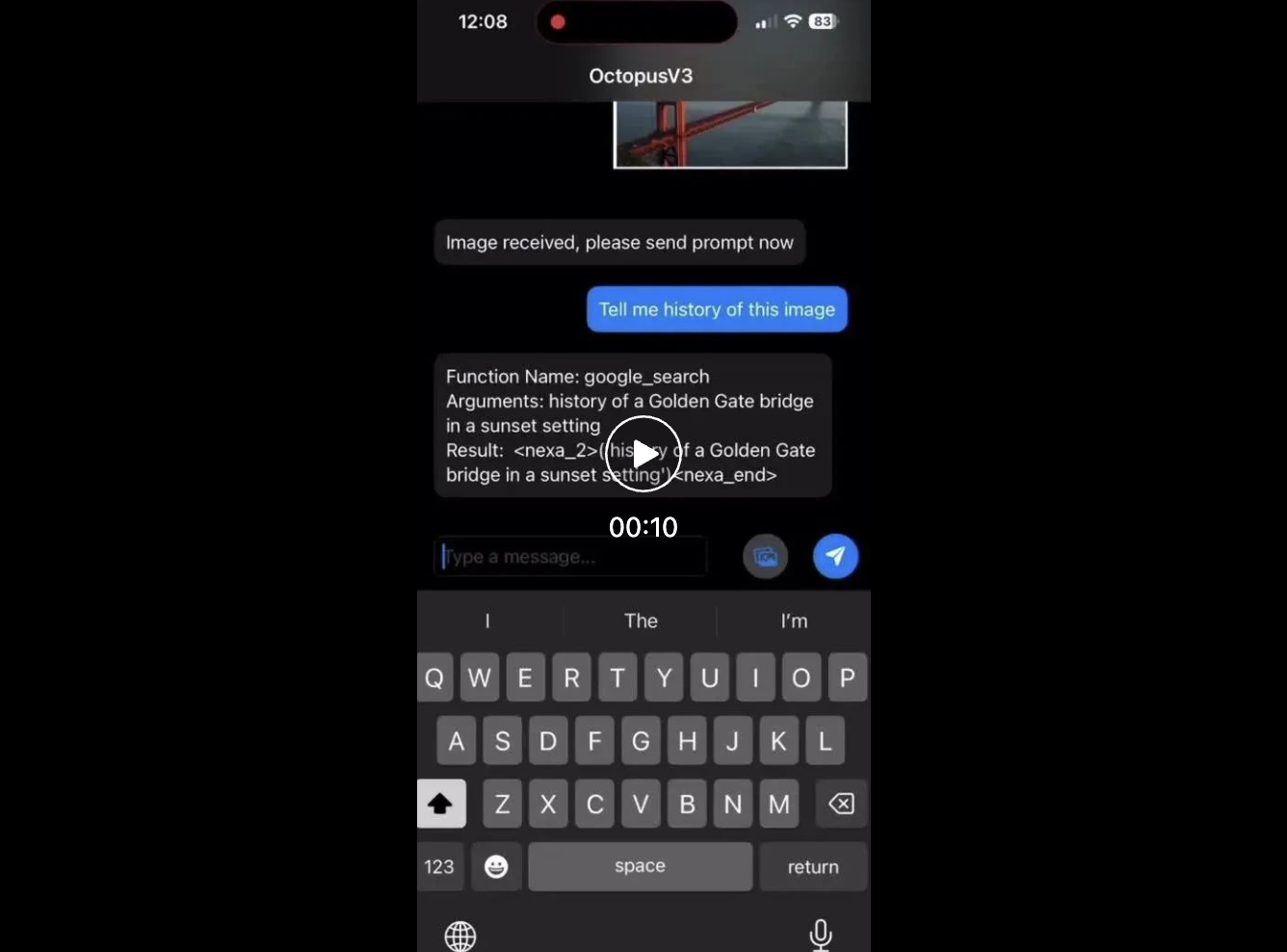

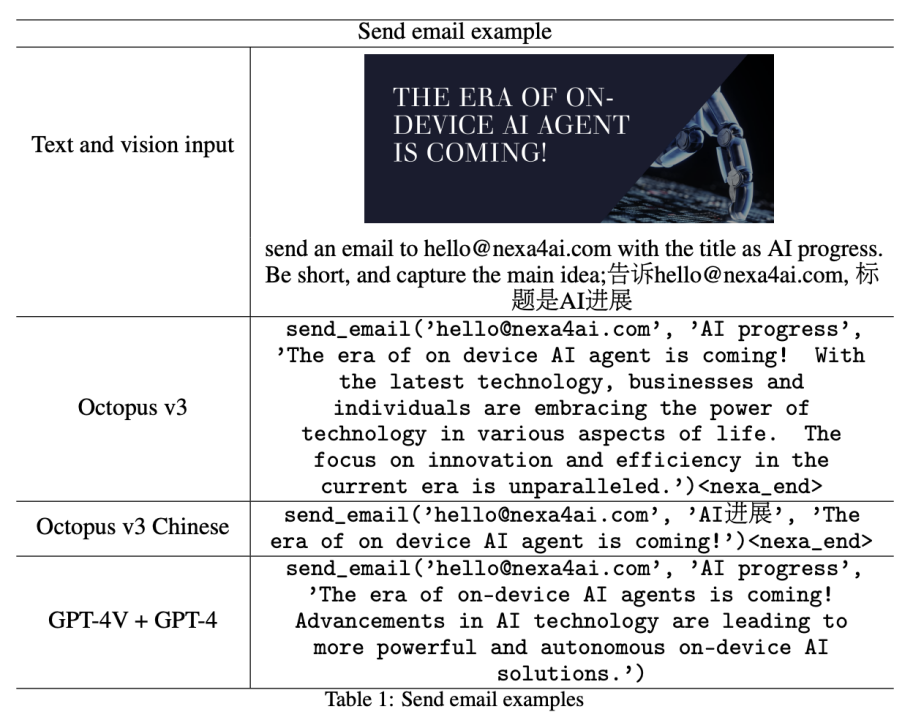

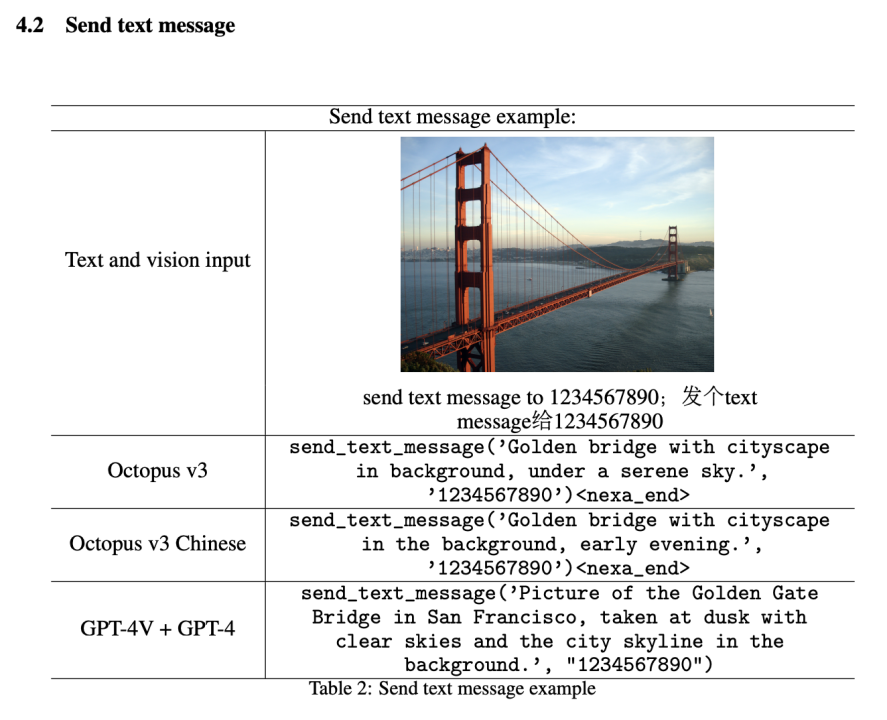

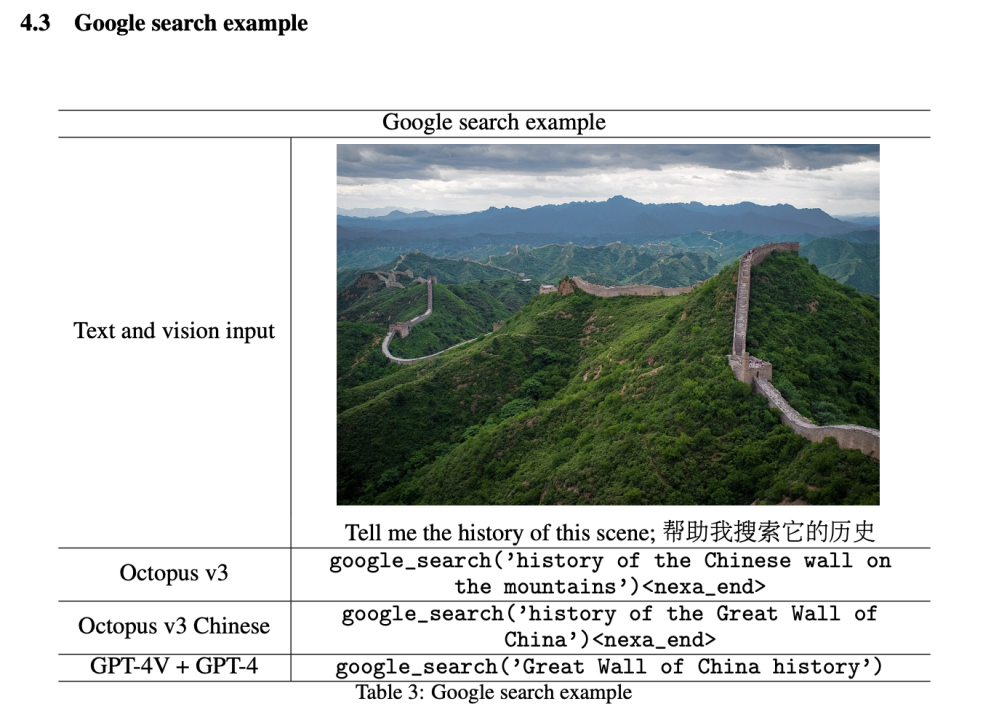

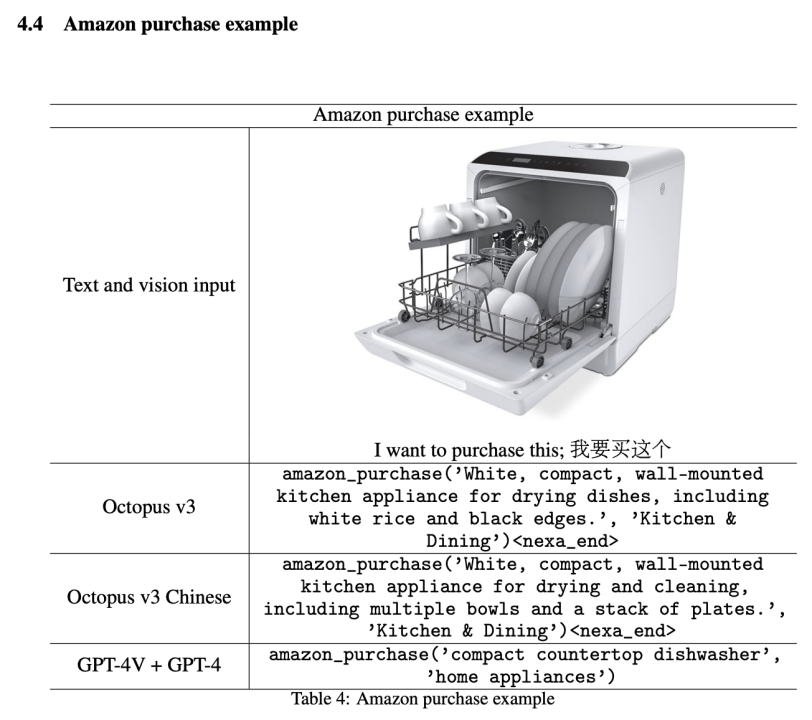

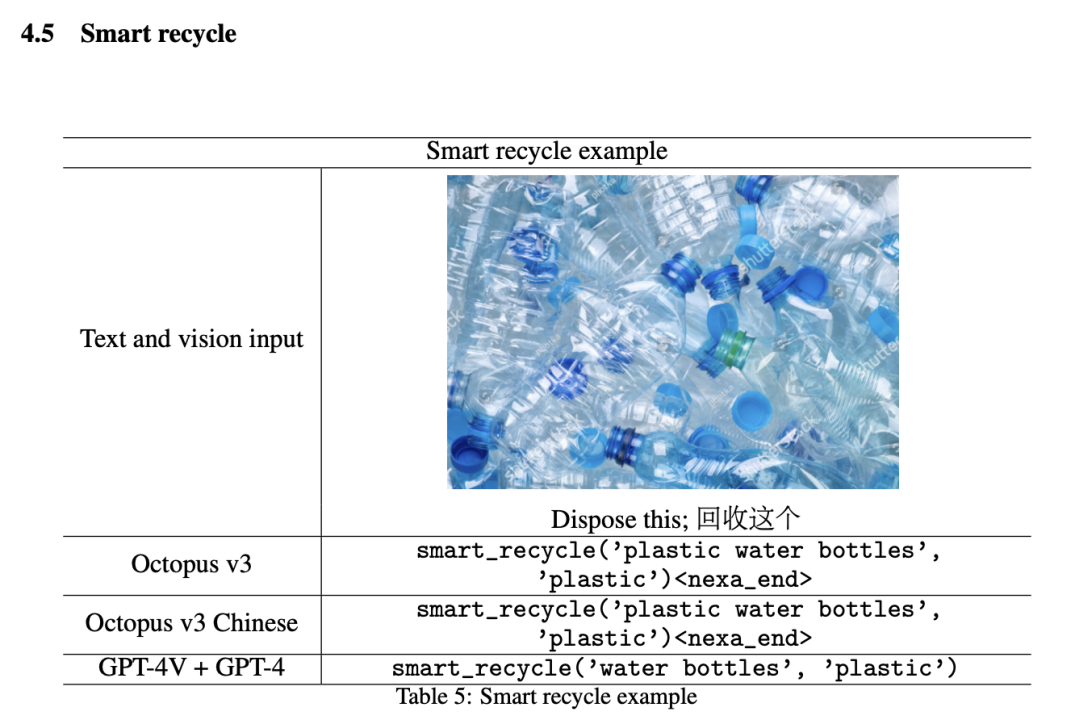

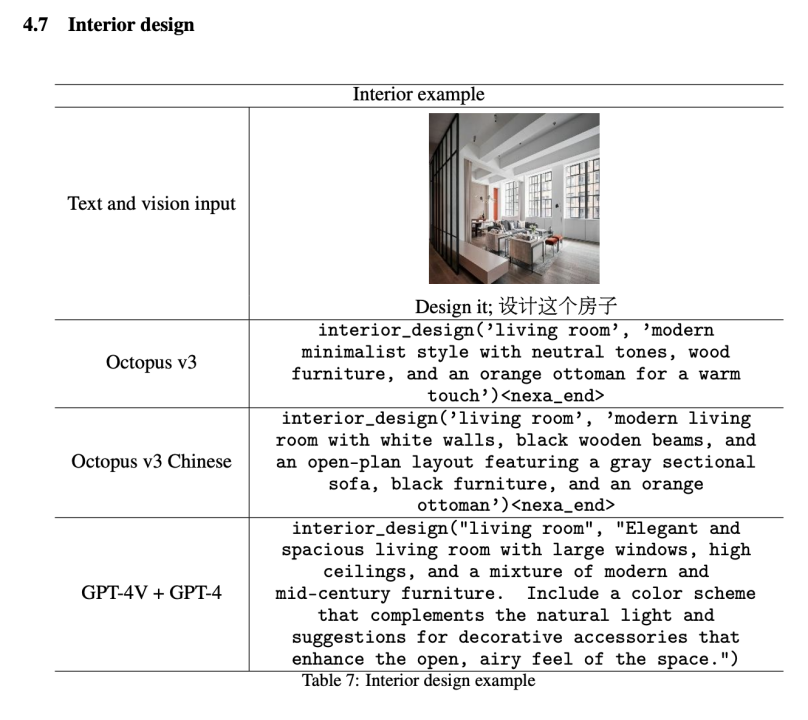

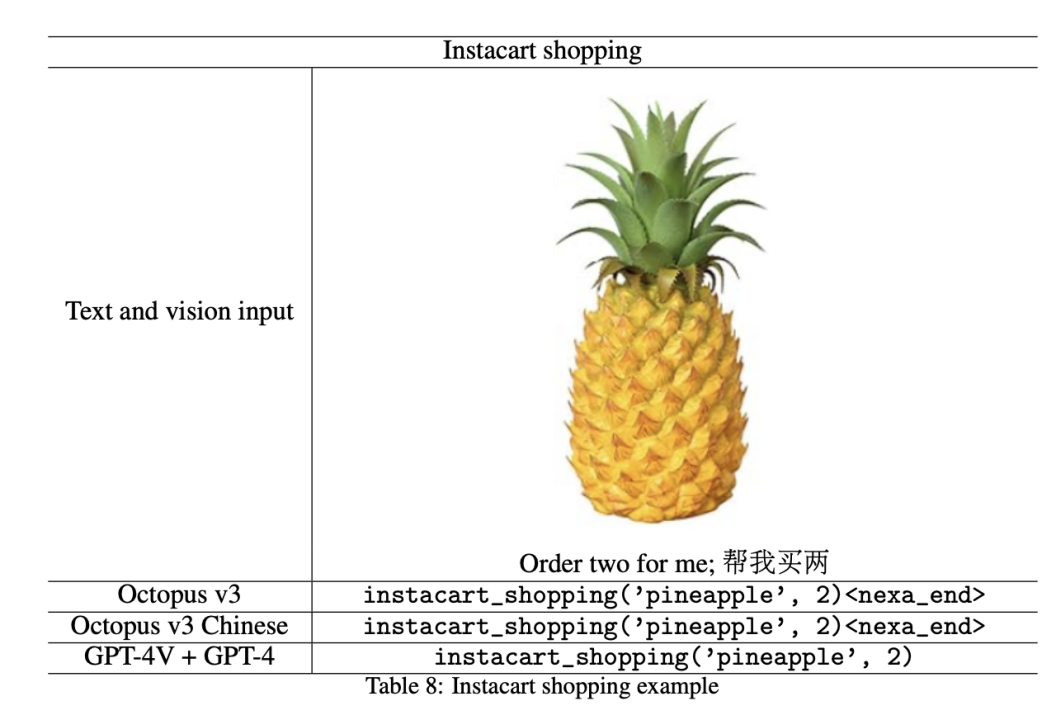

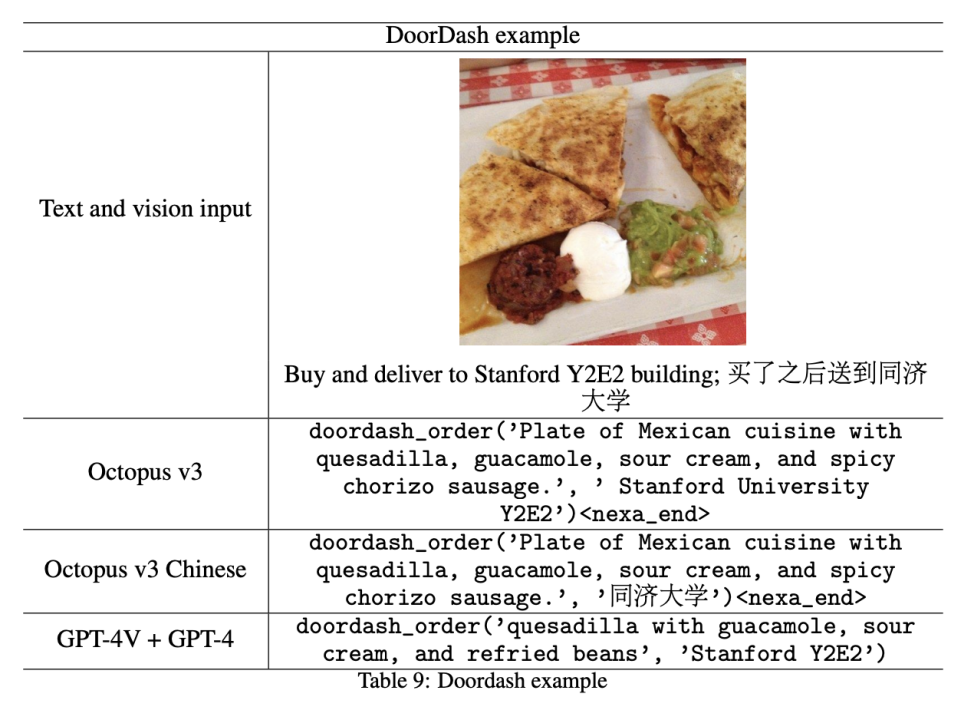

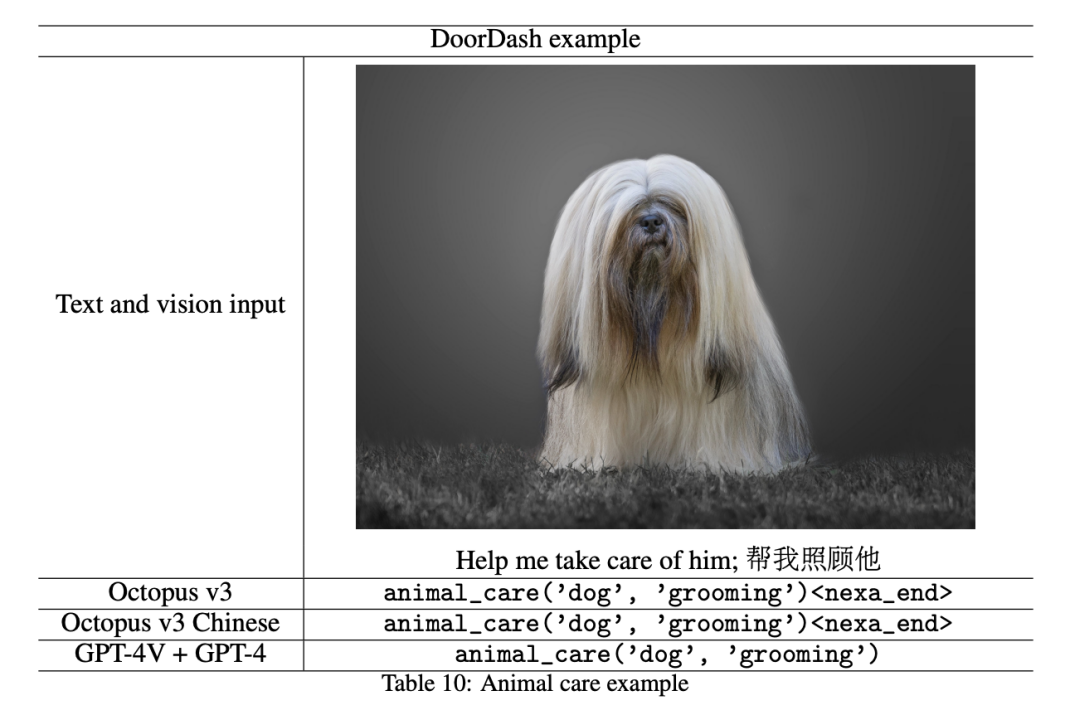

このセクションでは、モデルの実験結果を紹介し、GPT-4V および GPT-4 モデルを統合した効果と比較します。比較実験では、研究者らはまず GPT-4V (gpt-4-turbo) を使用して画像情報を処理しました。抽出されたデータは GPT-4 フレームワーク (gpt-4-turbo-preview) に供給され、すべての関数の説明が文脈化され、少数ショット学習が適用されてパフォーマンスが向上します。デモンストレーションでは、次のセクションで詳しく説明するように、研究者らは一般的に使用される 10 個のスマートフォン API を機能トークンに変換し、そのパフォーマンスを評価しました。

この記事では 10 個の機能トークンのみを示していますが、モデルではより多くのトークンをトレーニングして、より一般的な AI システムを作成できることは注目に値します。研究者らは、選択した API について、パラメーターが 10 億未満のモデルが GPT-4V と GPT-4 の組み合わせに匹敵するマルチモーダル AI として機能することを発見しました。

さらに、この記事のモデルのスケーラビリティにより、幅広い機能トークンを含めることができ、特定の分野やシナリオに適した高度に専門化された AI システムの作成が可能になります。この適応性により、AI 主導のソリューションが効率とユーザー エクスペリエンスを大幅に向上できるヘルスケア、金融、顧客サービスなどの業界において、当社のアプローチは特に価値があります。

以下のすべての関数名のうち、Octopus は

#メールを送信

#Google 検索

#Google 検索

Amazon ショッピング

Amazon ショッピング

インテリジェント リサイクル

インテリジェント リサイクル

##遺失物発見

インテリア・デザイン# #####

#Instacart ショッピング

DoorDash Delivery

ペットケア

社会的影響

上記の Octopus v2 に基づく、更新されたモデルにはテキスト情報と視覚情報の両方が組み込まれており、以前のテキストのみのアプローチから大きく前進しています。この大幅な進歩により、視覚データと自然言語データの同時処理が可能になり、より幅広いアプリケーションへの道が開かれます。 Octopus v2 で導入された機能トークンは、医療業界や自動車業界などの複数の分野に適応できます。ビジュアルデータが加わることで、自動運転やロボティクスなどの分野にも機能トークンの可能性がさらに広がります。さらに、この記事のマルチモーダル モデルでは、クラウドベースのソリューションではなくエンドポイント モデルを使用して、Raspberry Pi などのデバイスを Rabbit R1 や Humane AI Pin などのインテリジェント ハードウェアに実際に変換することができます。 現在、機能トークンは認可されていますが、研究者は、開発者がこの記事のフレームワークに参加し、ライセンス契約に従うことを前提に自由に革新することを推奨しています。今後の研究では、研究者らは、オーディオやビデオなどの追加のデータ モダリティに対応できるトレーニング フレームワークを開発することを目指しています。さらに、研究者らは視覚入力によってかなりの遅延が発生する可能性があることを発見しており、現在推論速度の最適化を行っています。以上がパラメータが 10 億未満の OctopusV3 は、GPT-4V や GPT-4 とどのように比較できるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。