Llama 3 の低ビット量子化パフォーマンスは大幅に低下します。総合的な評価結果はこちら | HKU & Beihang University & ETH

大規模モデルの力により、LLaMA3 は新たな高みに到達します:

超大規模な事前トレーニングを経た 15T トークン データで、素晴らしいパフォーマンスの向上が達成されました。 Chinchilla の推奨をはるかに超えていたため、オープンソース コミュニティでの議論が行われませんでした。

同時に、実用的なアプリケーション レベルでは、別のホットなトピックも浮上しています。

リソースが限られたシナリオでは、LLaMA3 の定量的なパフォーマンス改善されましたどうなるでしょうか?

香港大学、北杭大学、チューリッヒ連邦工科大学は共同で、LLaMA3 の低ビット量子化機能を包括的に明らかにする実証研究を開始しました。

研究者らは、既存の 10 種類のトレーニング後の量子化 LoRA 微調整手法を使用して、1 ~ 8 ビットの LLaMA3 の結果とさまざまな評価データセットを評価しました。彼らは次のことを発見しました:

LLaMA3 は、優れたパフォーマンスにもかかわらず、低ビット量子化、特に超低ビット幅で依然として無視できない劣化に悩まされています。

このプロジェクトは GitHub でオープンソース化されており、定量モデルも HuggingFace で公開されています。

具体的に実証結果を見てみましょう。

トラック 1: トレーニング後の量子化

表 1 と表 2 は、1 からの広ビット幅をカバーする、8 つの異なる PTQ メソッドにおける LLaMA3-8B と LLaMA3-70B の低ビット パフォーマンスを示しています。ビットから 8 ビットまで。

1. 低ビット特権の重み

このうち、Round-To-Nearest (RTN) は基本的な丸め量子化手法です。

GPTQ は、現在利用可能な最も効率的かつ効果的な重みのみの量子化手法の 1 つであり、量子化における誤差補償を利用します。しかし、2 ~ 3 ビットでは、GPTQ は LLaMA3 を量子化するときに深刻な精度の低下を引き起こします。

AWQ は異常チャネル抑制手法を使用して重みの定量化の困難さを軽減しますが、QuIP は行列計算を最適化することで重みとヘシアン間の不一致を保証します。これらはすべて、LLaMA3 の機能を 3 ビットで維持し、2 ビット量子化を有望なレベルまで押し上げます。

2. 超低ビット幅 LLM 重み圧縮

最近登場したバイナリ LLM 量子化方式は、超低ビット幅 LLM 重み圧縮を実現します。

PB-LLM は混合精度量子化戦略を採用し、重要な重みの一部の完全な精度を維持しながら、重みの大部分を 1 ビットに量子化します。

DB-LLM は、デュアル 2 値化重み分割を通じて効率的な LLM 圧縮を実現し、2 ビット LLM のパフォーマンスをさらに強化するためのバイアスを意識した蒸留戦略を提案します。

BiLLM は、有意な重みの残差近似と非有意な重みのグループ量子化を通じて、LLM 量子化境界を 1.1 ビットまでさらに押し下げます。超低ビット幅向けに特別に設計されたこれらの LLM 量子化方式は、GPTQ、AWQ、QuIP などの 2 ビット (場合によっては 3 ビット) の方式をはるかに上回る ⩽2 ビットで、より高精度の量子化 LLaMA3-8B を実現できます。

3. 低ビット量子化アクティベーション

は、量子化難易度をアクティベーションから重み、スムーズ アクティベーション外れ値に変換する SmoothQuant を介して量子化アクティベーションに対して LLaMA3 評価も実行しました。評価の結果、SmoothQuant は 8 ビットおよび 6 ビットの重みとアクティベーションで LLaMA3 の精度を維持できるが、4 ビットでは面が崩壊することがわかりました。

トラック 2: LoRA の微調整された量子化

MMLU データセット上で、LoRA-FT 量子化下の LLaMA3-8B では、最も印象的な観察は、Alpaca データセットに対する低ランクの微調整では、量子化によって生じた誤差を補償できないだけでなく、パフォーマンスの低下をより深刻にしていることです。

具体的には、4 ビットでのさまざまな LoRA-FT 量子化方法によって得られる量子化 LLaMA3 のパフォーマンスは、LoRA-FT を使用しない対応する 4 ビットのバージョンよりも劣ります。これは、LLaMA1 および LLaMA2 での同様の現象とは大きく対照的です。LLaMA1 および LLaMA2 では、4 ビットの低ランク微調整量子化バージョンが、MMLU 上の元の FP16 対応バージョンよりも簡単に性能を上回ります。

直観的な分析によると、この現象の主な理由は、LLaMA3 の強力なパフォーマンスが大規模な事前トレーニングの恩恵を受けていることです。つまり、元のモデルの量子化後のパフォーマンス損失を引き継ぐことができないことです。低ランクの微調整の一部がパラメーター データに対して実行され、補正されます (これは元のモデルのサブセットと考えることができます)。

量子化によって引き起こされる大幅な劣化は微調整によって補償することはできませんが、4 ビット LoRA-FT 量子化 LLaMA3-8B は、さまざまな量子化方法の下で LLaMA1-7B および LLaMA2-7B を大幅に上回ります。たとえば、QLoRA メソッドを使用すると、4 ビット LLaMA3-8B の平均精度は 57.0 (FP16: 64.8) となり、4 ビット LLaMA1-7B (FP16: 34.6) の 38.4 を 18.6 上回り、4 ビット LLaMA1-7B の 43.9 を上回ります。 4 ビット LLaMA2-7B (FP16: 45.5) 13.1。これは、LLaMA3 時代における新しい LoRA-FT 量子化パラダイムの必要性を示しています。

同様の現象が CommonSenseQA ベンチマークでも発生しました。 QLoRA および IR-QLoRA で微調整されたモデルのパフォーマンスも、LoRA-FT を使用しない 4 ビットのモデルと比較して低下しました (例: QLoRA では平均 2.8% の低下、IR-QLoRA では平均 2.4% の低下)。これは、LLaMA3 で高品質のデータセットを使用する利点と、汎用データセット Alpaca が他のタスクのモデルのパフォーマンスに寄与しないことをさらに示しています。

結論

この論文では、さまざまな低ビット量子化技術 (トレーニング後の量子化と LoRA 微調整量子化を含む) における LLaMA3 のパフォーマンスを包括的に評価します。

この調査結果は、LLaMA3 が量子化後も依然として優れたパフォーマンスを示しているものの、量子化に伴うパフォーマンスの低下が著しく、多くの場合さらに大きなパフォーマンスの低下につながる可能性があることを示しています。

この発見は、リソースに制約のある環境で LLaMA3 を導入する際に直面する可能性のある潜在的な課題を浮き彫りにし、低ビット量子化のコンテキストにおいて成長と改善の余地が十分にあることを浮き彫りにしています。低ビット量子化によって引き起こされるパフォーマンス低下を解決することで、その後の量子化パラダイムにより、LLM がより低い計算コストでより強力な機能を達成できるようになり、最終的には代表的な生成人工知能を新たな高みに押し上げることが期待されています。

論文リンク: https://arxiv.org/abs/2404.14047。

プロジェクト リンク: https://github.com/Macaronlin/LLaMA3-Quantizationhttps://huggingface.co/LLMQ。

以上がLlama 3 の低ビット量子化パフォーマンスは大幅に低下します。総合的な評価結果はこちら | HKU & Beihang University & ETHの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

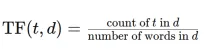

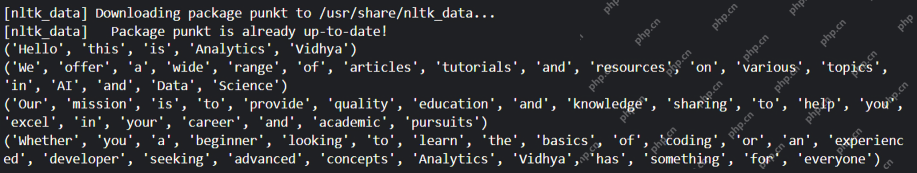

TFIDFVectorizerを使用して、テキストドキュメントをTF-IDFマトリックスに変換しますApr 18, 2025 am 10:26 AM

TFIDFVectorizerを使用して、テキストドキュメントをTF-IDFマトリックスに変換しますApr 18, 2025 am 10:26 AMこの記事では、テキストデータを分析するための自然言語処理(NLP)の重要なツールである周波数逆文書頻度(TF-IDF)手法について説明します。 TF-IDFは、TEを重み付けすることにより、基本的なワードバッグアプローチの限界を上回ります

Langchainを使用したスマートAIエージェントの構築:実用的なガイドApr 18, 2025 am 10:18 AM

Langchainを使用したスマートAIエージェントの構築:実用的なガイドApr 18, 2025 am 10:18 AMLangchainでAIエージェントの力を解き放つ:初心者向けガイド 祖母にchatgptとチャットすることで人工知能の不思議を示すことを想像してみてください。 th

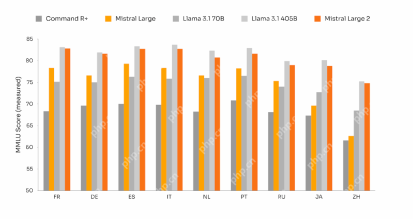

Mistral Large 2:Llama 3.1 405bに挑戦するのに十分強力ですか?Apr 18, 2025 am 10:16 AM

Mistral Large 2:Llama 3.1 405bに挑戦するのに十分強力ですか?Apr 18, 2025 am 10:16 AMミストラル大規模2:ミストラルAIの強力なオープンソースLLMに深く飛び込む メタAIの最近のラマ3.1ファミリーのモデルのリリースに続いて、これまでの最大のモデルのミストラルAIの発表がすぐに続きました。

安定した拡散のノイズスケジュールとは何ですか? - 分析VidhyaApr 18, 2025 am 10:15 AM

安定した拡散のノイズスケジュールとは何ですか? - 分析VidhyaApr 18, 2025 am 10:15 AM拡散モデルのノイズスケジュールの理解:包括的なガイド AIによって生み出されたデジタルアートの見事なビジュアルに魅了されたことがあり、基礎となるメカニズムについて疑問に思ったことはありますか? 重要な要素は、「ノイズスケジュール、&Quo

GPT-4Oで会話のチャットボットを構築する方法は? - 分析VidhyaApr 18, 2025 am 10:06 AM

GPT-4Oで会話のチャットボットを構築する方法は? - 分析VidhyaApr 18, 2025 am 10:06 AMGPT-4Oでコンテキストチャットボットを構築する:包括的なガイド AIとNLPの急速に進化する風景では、チャットボットは開発者と組織にとって不可欠なツールになりました。 本当に魅力的でインテリジェントなチャットを作成する重要な側面

2025年にAIエージェントを構築するためのトップ7フレームワークApr 18, 2025 am 10:00 AM

2025年にAIエージェントを構築するためのトップ7フレームワークApr 18, 2025 am 10:00 AMこの記事では、AIエージェントを構築するための7つの主要なフレームワーク、つまり目標を達成するために知覚、決定、行動する自律的なソフトウェアエンティティについて説明します。 これらのエージェントは、従来の補強学習を上回り、高度な計画と理想を活用します

タイプIとタイプIIエラーの違いは何ですか? - 分析VidhyaApr 18, 2025 am 09:48 AM

タイプIとタイプIIエラーの違いは何ですか? - 分析VidhyaApr 18, 2025 am 09:48 AM統計的仮説検定におけるタイプIおよびタイプIIエラーの理解 新しい血圧薬をテストする臨床試験を想像してください。 この試験では、この薬は血圧を大幅に低下させると結論付けていますが、実際にはそうではありません。これはタイプです

Sumy Libraryによる自動テキスト要約Apr 18, 2025 am 09:37 AM

Sumy Libraryによる自動テキスト要約Apr 18, 2025 am 09:37 AMSumy:AIを搭載した要約アシスタント 無限の文書をふるいにかけるのにうんざりしていませんか? 強力なPythonライブラリであるSumyは、自動テキストの要約のための合理化されたソリューションを提供します。 この記事では、Sumyの能力を調べて、あなたを導きます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SublimeText3 中国語版

中国語版、とても使いやすい

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール