ホームページ >テクノロジー周辺機器 >AI >Docker が LLama3 オープンソース大規模モデルのローカル展開を 3 分で完了

Docker が LLama3 オープンソース大規模モデルのローカル展開を 3 分で完了

- 王林転載

- 2024-04-26 10:19:211620ブラウズ

概要

LLaMA-3 (Large Language Model Meta AI 3) は、Meta Company によって開発された大規模なオープンソースの生成人工知能モデルです。前世代のLLaMA-2と比べてモデル構造に大きな変更はありません。

LLaMA-3 モデルは、さまざまなアプリケーション要件やコンピューティング リソースに適応するために、小規模、中規模、大規模などのさまざまな規模のバージョンに分割されています。小型モデルのパラメータ サイズは 8B、中型モデルのパラメータ サイズは 70B、大型モデルのパラメータ サイズは 400B に達します。ただし、トレーニング中の目標は、マルチモーダルおよび複数言語の機能を達成することであり、その結果は GPT 4/GPT 4V に匹敵することが期待されます。

Ollama をインストールする

Ollama は、ユーザーがローカル マシン上で大規模言語モデルを実行およびデプロイできるようにするオープン ソースの大規模言語モデル (LLM) サービス ツールです。 Ollama は、Docker コンテナーで大規模な言語モデルをデプロイおよび管理するプロセスを簡素化し、プロセスを迅速かつ簡単にするフレームワークとして設計されています。ユーザーは、簡単なコマンドライン操作を通じて、Llama 3 などのオープンソースの大規模言語モデルをローカルですばやく実行できます。

公式 Web サイトのアドレス: https://ollama.com/download

Pictures

Pictures

Ollama は、Mac や Linux を含む複数のプラットフォームをサポートし、インストール プロセスを簡素化する Docker イメージを提供するツールです。ユーザーは、Dockerfile の役割に似た Modelfile を作成することで、より多くのモデルをインポートおよびカスタマイズできます。 Ollama には、モデルを実行および管理するための REST API と、モデルと対話するためのコマンドライン ツールセットも備えています。

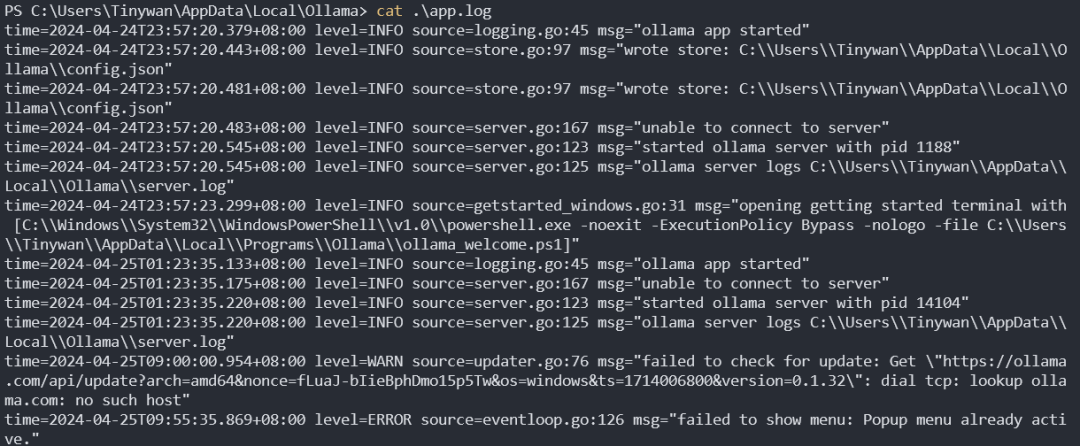

Ollamaサービス起動ログ

写真

写真

モデル管理

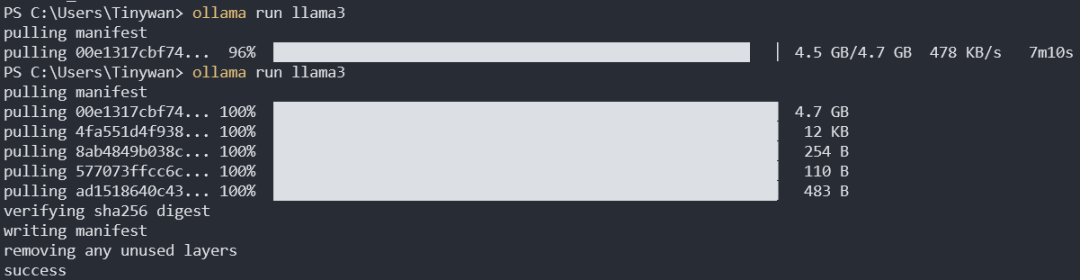

モデルをダウンロード

ollama pull llama3:8b

デフォルトのダウンロードはllama3:8bです。ここのコロンの前のコロンはモデル名を表し、タグの後のコロンはタグを表します。 ここから llama3 のすべてのタグを表示できます

写真

写真

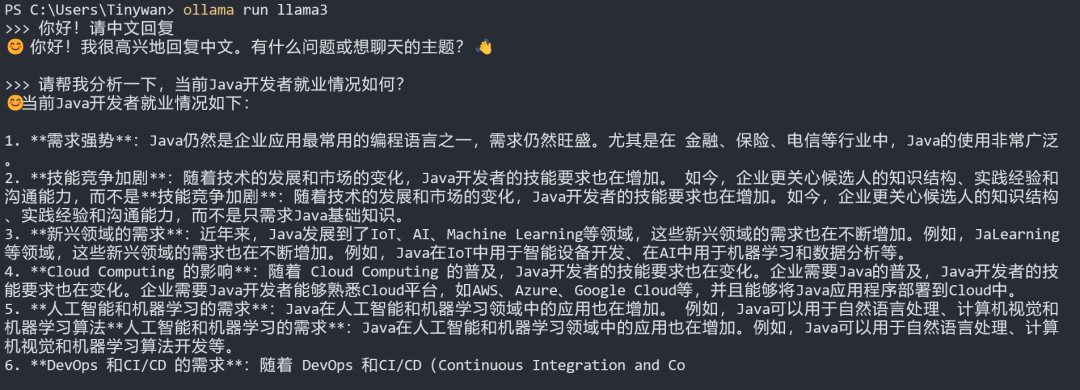

モデルテスト

注: モデルを中国語で返信します。最初に入力してください: こんにちは!中国語で返信してください

画像

画像

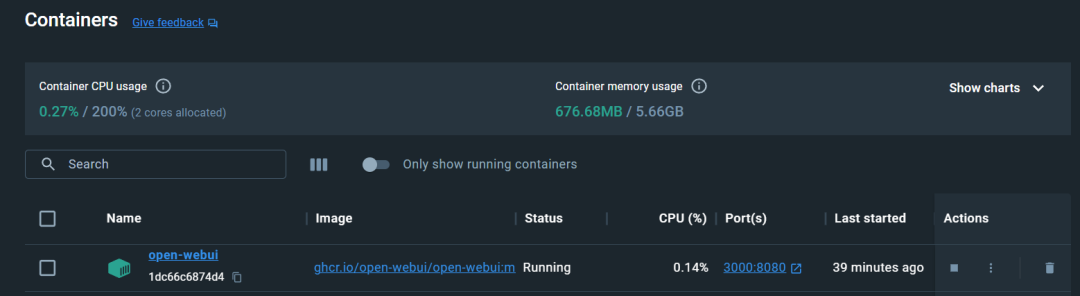

Open-WebUIを設定します

CPUで実行します

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

画像

画像

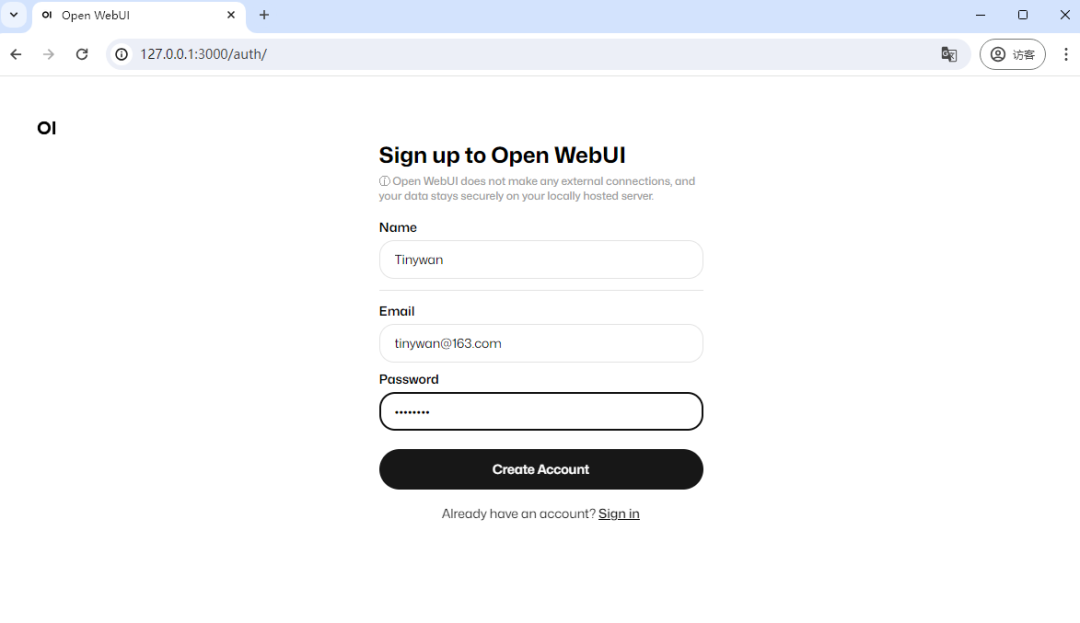

アクセスしてください

アドレスを入力してください http://127.0.0.1:300 0 アクセス

写真

写真

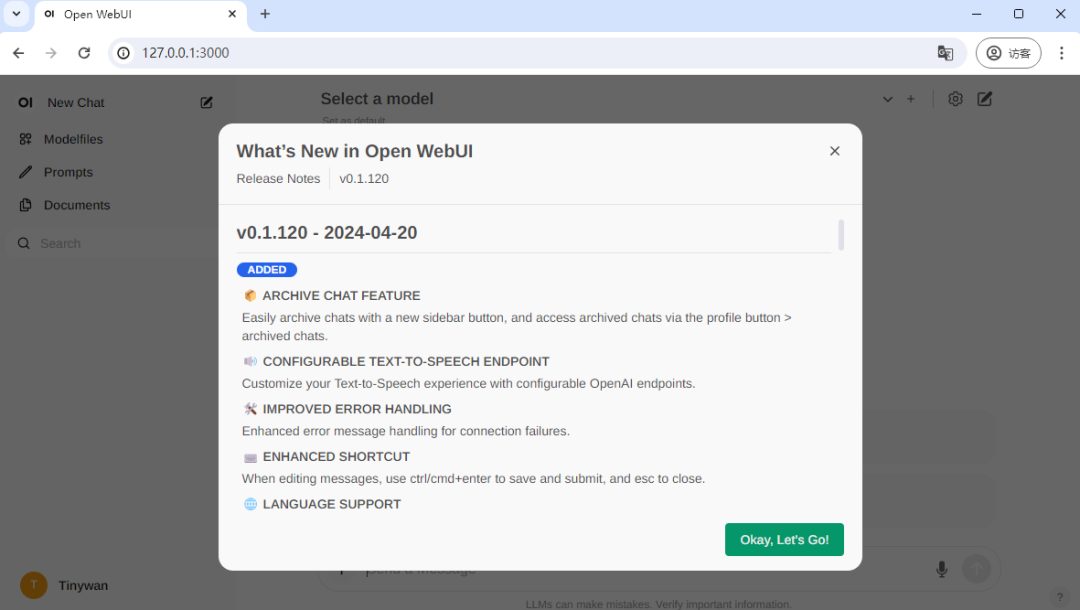

初回訪問には登録が必要です。ここでアカウントを登録します。登録が完了し、ログインが成功しました

写真

写真

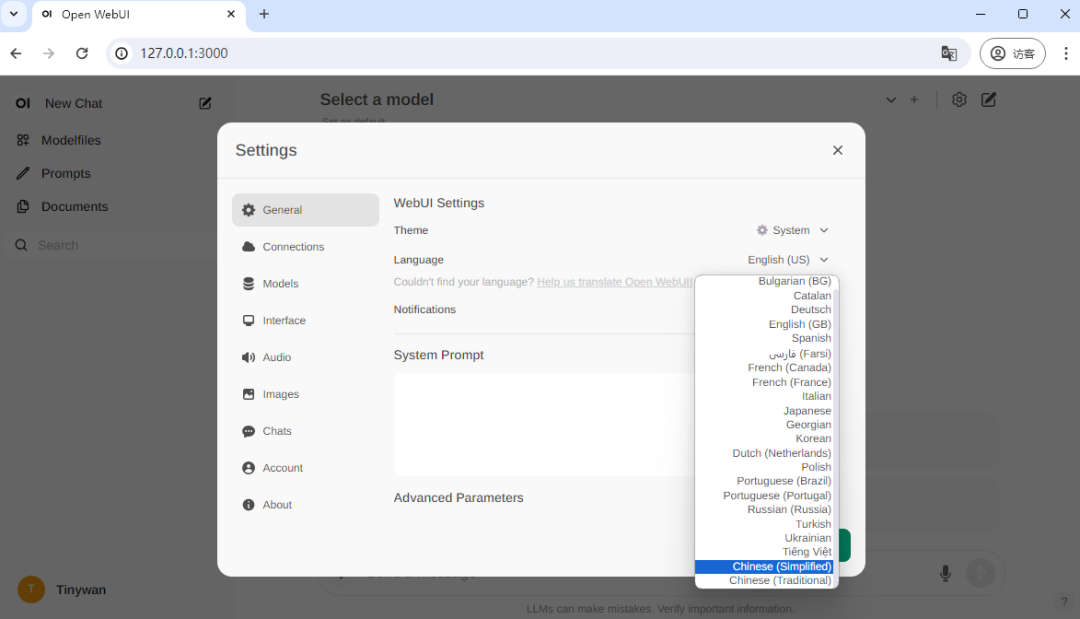

中国語を切り替える

写真

写真

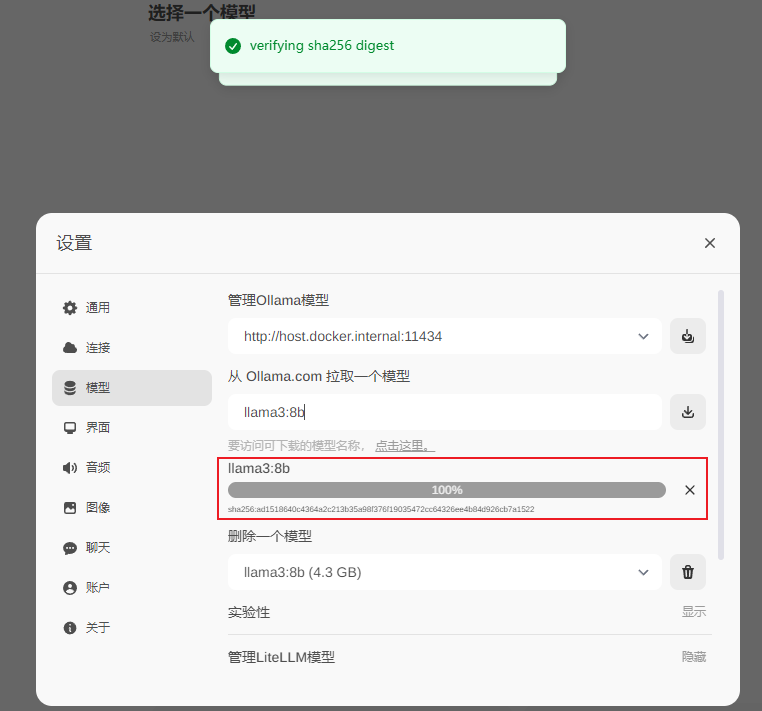

ラマ3:8bモデルをダウンロード

llama3:8b

写真

写真

ダウンロード完了

写真

写真

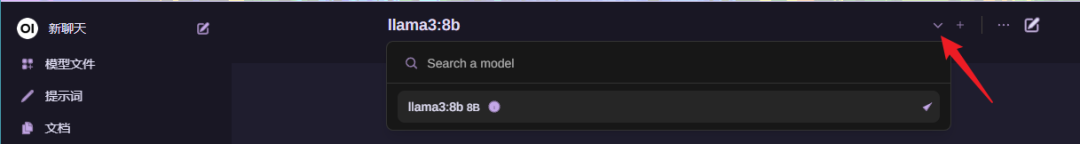

使用

モデルを選択

写真

写真

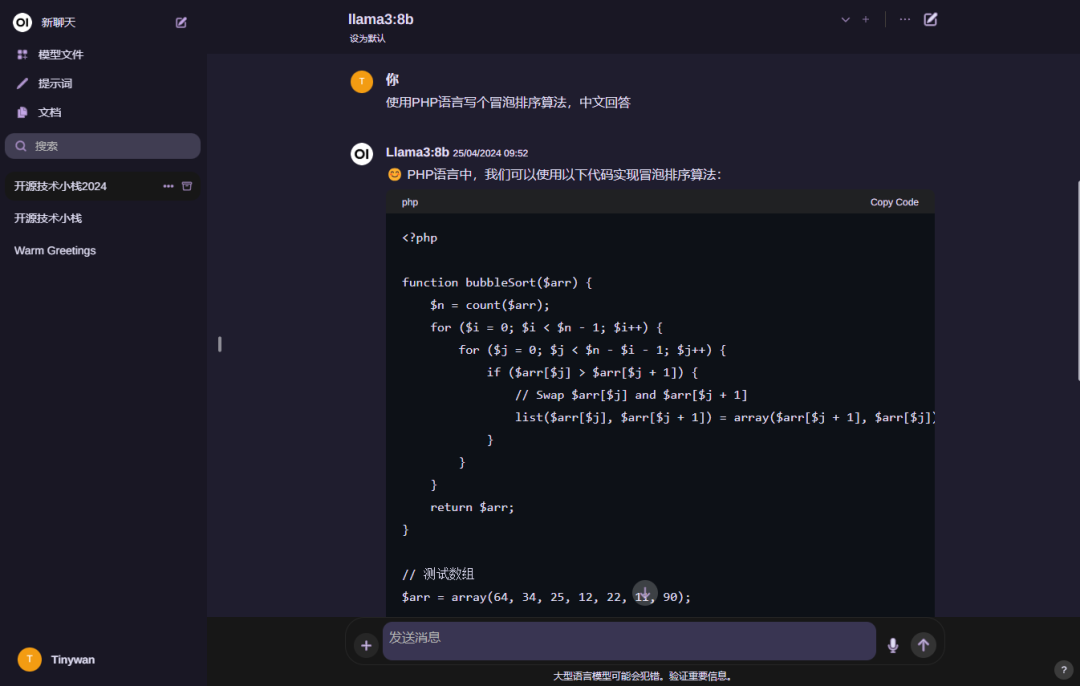

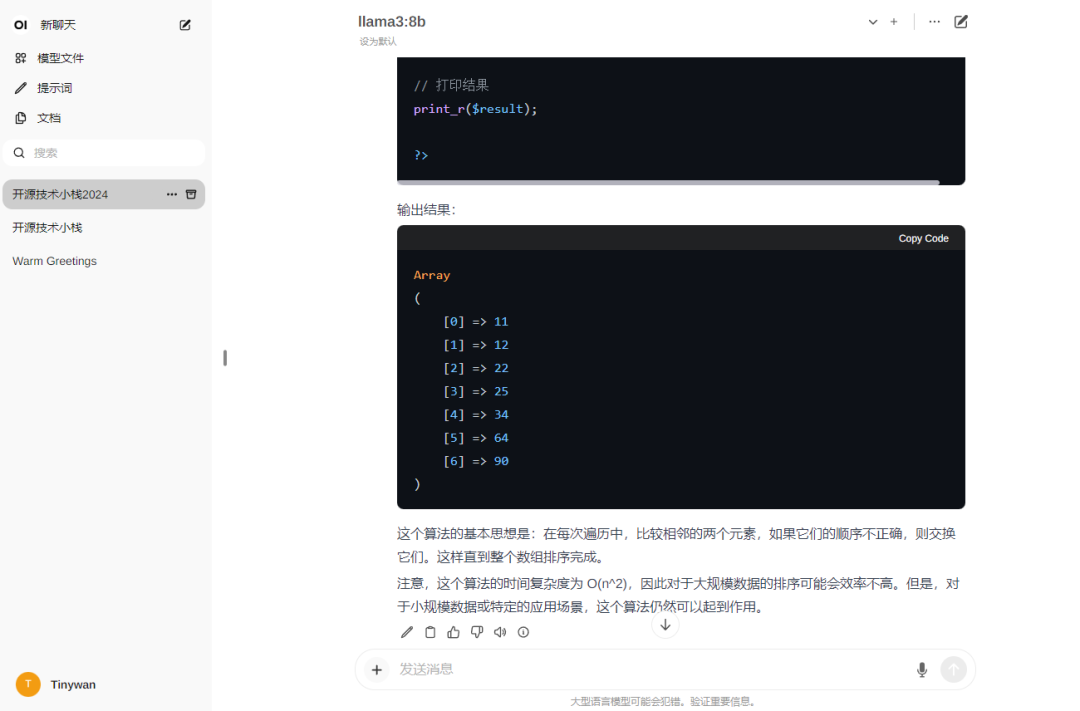

モデルを使用

写真

写真

注: モデルに返信してもらいたい場合中国語で、最初に入力してください: こんにちは!中国語で返信してください

写真

写真

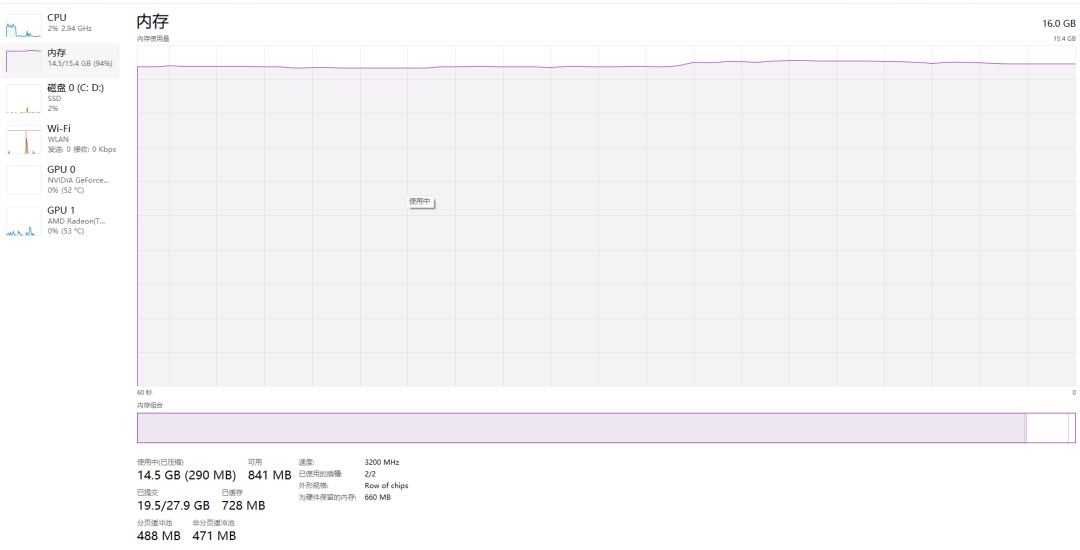

思い出

写真

写真

以上がDocker が LLama3 オープンソース大規模モデルのローカル展開を 3 分で完了の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。