ハイブリッドの深さを導入した DeepMind の新しい設計により、トランスの効率が大幅に向上します。

- #論文のタイトル: 深さの混合: トランスフォーマーベースの言語モデルでのコンピューティングの動的割り当て

- # #論文アドレス: https://arxiv.org/pdf/2404.02258.pdf

彼らは次のように構想しました: 各層で、ネットワークは意思決定を学習する必要がある利用可能なコンピューティング バジェットを動的に割り当てるために、トークンごとに作成されます。特定の実装では、総計算量は、ネットワークが動作する際の実行決定の関数ではなく、トレーニング前にユーザーによって設定され、変更されることはありません。これにより、ハードウェア効率の向上 (メモリ フットプリントの削減や順方向パスごとの FLOP の削減など) を事前に予測して活用することができます。チームの実験では、ネットワーク全体のパフォーマンスを損なうことなく、これらの利点を達成できることが示されています。

#DeepMind のチームは、Mixed Expert (MoE) Transformer と同様のアプローチを採用しており、動的なトークンレベルのルーティング決定がネットワーク深度全体にわたって実行されます。

MoE とは異なり、ここでの選択は、トークンに計算を適用するか (標準の Transformer と同じ)、残りの接続を介してトークンをラップするかです (変更せずにそのままにして、計算を保存します)。 MoE とのもう 1 つの違いは、このルーティング メカニズムが MLP とマルチヘッド アテンションの両方に使用されることです。したがって、これはネットワークによって処理されるキーとクエリにも影響するため、ルートはどのトークンが更新されるかだけでなく、どのトークンが注目に値するかを決定します。

DeepMind は、各トークンが Transformer の深さで異なる数のレイヤーまたはモジュールを通過するという事実を強調するために、この戦略を Mixture-of-Depths (MoD) と名付けました。ここではこれを「混合の深さ」と訳します。図 1 を参照してください。

#MoD は、ユーザーがパフォーマンスと速度を比較検討できるようにサポートします。一方で、ユーザーは通常の Transformer と同じトレーニング FLOP で MoD Transformer をトレーニングでき、最終的な対数確率トレーニング ターゲットを最大 1.5% 向上させることができます。一方、MoD Transformer は、通常の Transformer と同じトレーニング損失を達成するために使用する計算量が少なく、フォワード パスあたりの FLOP が最大 50% 少なくなります。

#MoD は、ユーザーがパフォーマンスと速度を比較検討できるようにサポートします。一方で、ユーザーは通常の Transformer と同じトレーニング FLOP で MoD Transformer をトレーニングでき、最終的な対数確率トレーニング ターゲットを最大 1.5% 向上させることができます。一方、MoD Transformer は、通常の Transformer と同じトレーニング損失を達成するために使用する計算量が少なく、フォワード パスあたりの FLOP が最大 50% 少なくなります。 同等の通常の Transformer が必要とする計算量よりも少ない静的計算バジェットを設定します。これは、量を制限することによって行われます。シーケンス内の計算の数 モジュール計算 (つまり、セルフアテンション モジュールと後続の MLP) に参加できるトークンの数。たとえば、通常の Transformer ではシーケンス内のすべてのトークンがセルフ アテンション計算に参加することを許可できますが、MoD Transformer ではシーケンス内のトークンの 50% のみの使用を制限できます。 各トークンについて、スカラー重みを与えるルーティング アルゴリズムが各モジュールにあります。この重みは、各トークンのルーティング設定 (モジュールの計算に参加するかどうか) を表します。過去を回避するために。 各モジュールで、上位 k 個の最大スカラー重みを見つけます。それに対応するトークンがモジュールの計算に参加します。 k 個のトークンのみがこのモジュールの計算に参加する必要があるため、その計算グラフとテンソル サイズはトレーニング プロセス中は静的です。これらのトークンは、ルーティング アルゴリズムによって認識される動的でコンテキスト関連のトークンです。

#第一に、補助的なバランスを失う必要がありません。

第 2 に、上位 k を選択する操作は配線の重みの大きさに依存するため、この配線スキームでは相対的な配線の重みを使用できるため、現在の配線の重みを決定するのに役立ちます。モジュール どのトークンが最も必要であるかを計算します。ルーティング アルゴリズムは、重みを適切に設定することで、最も重要なトークンが上位 k に含まれるように試みることができます。これは、トークン選択ルーティング スキームでは実行できないことです。特定の使用例では、本質的に null 操作である計算パスがあるため、重要なトークンを null にルーティングすることは避けるべきです。

第三に、ルーティングは 2 つのパスのみを通過するため、単一の top-k 操作でトークンを効率的に 2 つの相互排他的なセットに分割できます (それぞれがパスのセットを計算します)。 、上記の過剰または処理不足の問題に対処できます。

このルーティング スキームの具体的な実装については、元の論文を参照してください。

エキスパートによる選択ルーティングには多くの利点がありますが、明らかな問題もあります。 -k 操作は非因果的です。つまり、特定のトークンのルーティング重みが上位 k に入るかどうかは、その後のルーティング重みの値に依存しますが、自己回帰サンプリングを実行する場合、これらの重みを取得することはできません。

この問題を解決するために、チームは 2 つの方法をテストしました。

最初の方法は、単純な補助損失を導入することです。言語モデリングの主な目標に対するその影響は 0.2% ~ 0.3% であることが実践的に証明されていますが、これにより、モデルは自己回帰的にサンプリングします。彼らは、ルーティング アルゴリズムの出力がロジットを提供するバイナリ クロス エントロピー ロスを使用し、これらのロジットの上位 k を選択することでターゲットを提供できます (つまり、トークンが上位 k にある場合は 1、それ以外の場合は 1)。 0)。

以上がDeepMind がトランスフォーマーをアップグレードし、フォワードパスの FLOP を最大半分に削減可能の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

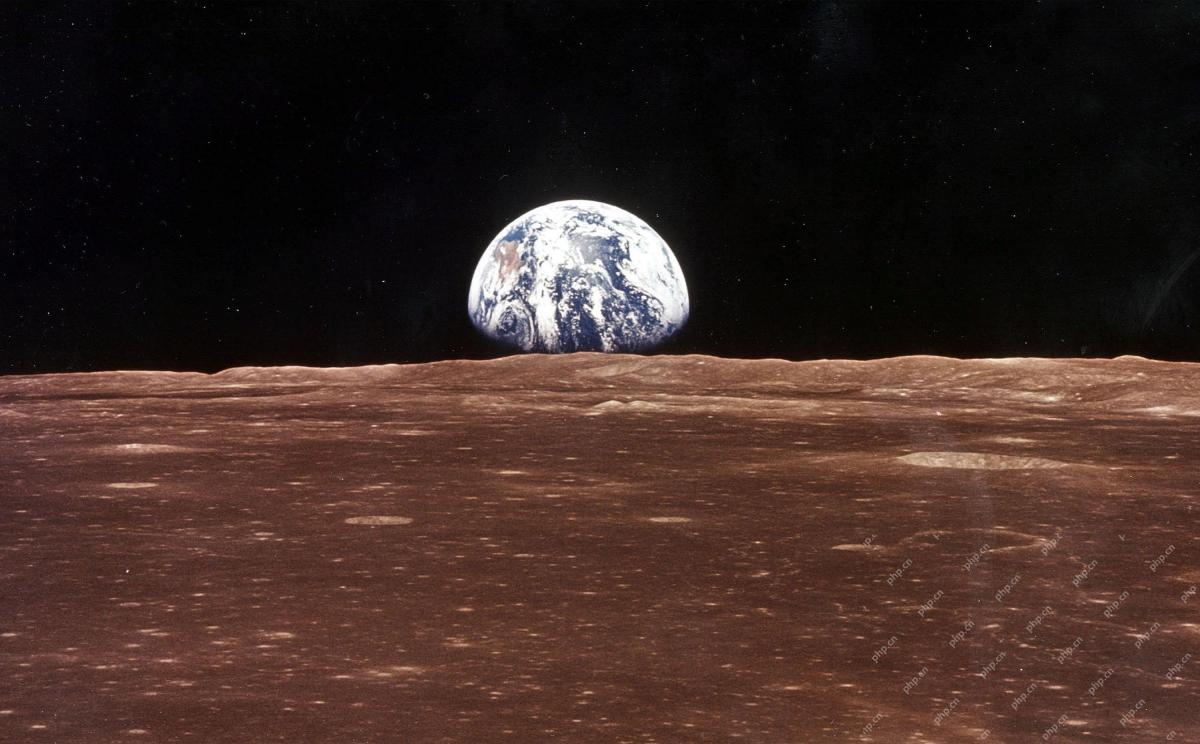

AI宇宙会社が生まれましたMay 12, 2025 am 11:07 AM

AI宇宙会社が生まれましたMay 12, 2025 am 11:07 AMこの記事では、AIが宇宙産業にどのように革命をもたらしているかを示しています。 明日、AIでAIを使用して建設されていないSpaceXのような既存の宇宙企業とは異なり、AIネイティブ企業です。 探検しましょう

インドでの10機の機械学習インターンシップ(2025)May 12, 2025 am 10:47 AM

インドでの10機の機械学習インターンシップ(2025)May 12, 2025 am 10:47 AMインドであなたの夢の機械学習インターンシップを上陸させてください(2025)! 学生や早期キャリアの専門家にとって、機械学習インターンシップは、やりがいのあるキャリアに最適なランチパッドです。 最先端のジェナからの多様なセクターのインド企業

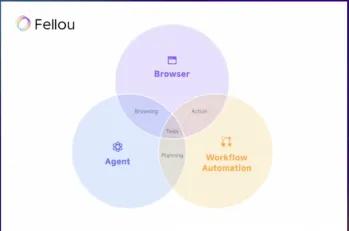

fellou aiを試して、Googleに別れを告げてChatgptを言ってくださいMay 12, 2025 am 10:26 AM

fellou aiを試して、Googleに別れを告げてChatgptを言ってくださいMay 12, 2025 am 10:26 AMオンラインブラウジングの風景は、過去1年間に大きな変化を遂げました。 このシフトは、PrplexityやCopilotなどのプラットフォームからの強化されたパーソナライズされた検索結果から始まり、ChatGPTのWeb Sの統合で加速しました

個人的なハッキングはかなり激しいクマになりますMay 11, 2025 am 11:09 AM

個人的なハッキングはかなり激しいクマになりますMay 11, 2025 am 11:09 AMサイバー攻撃が進化しています。 一般的なフィッシングメールの時代は終わりました。 サイバー犯罪の将来は超個人化されており、高度にターゲットを絞った攻撃を作成するために、容易に利用可能なオンラインデータとAIを活用しています。 あなたの仕事を知っている詐欺師を想像してください、あなたのf

教皇レオXIVは、AIが彼の名前の選択にどのように影響したかを明らかにしますMay 11, 2025 am 11:07 AM

教皇レオXIVは、AIが彼の名前の選択にどのように影響したかを明らかにしますMay 11, 2025 am 11:07 AM枢機of大学への彼の就任演説では、シカゴ生まれのロバート・フランシス・プレボスト、新たに選出された教皇レオ14世は、彼の同名の教皇レオXIIIの影響について議論しました。

初心者および専門家向けのFastapi -MCPチュートリアル-Analytics VidhyaMay 11, 2025 am 10:56 AM

初心者および専門家向けのFastapi -MCPチュートリアル-Analytics VidhyaMay 11, 2025 am 10:56 AMこのチュートリアルでは、モデルコンテキストプロトコル(MCP)とFastAPIを使用して、大規模な言語モデル(LLM)と外部ツールを統合する方法を示しています。 FastAPIを使用して簡単なWebアプリケーションを構築し、それをMCPサーバーに変換し、Lを有効にします

DIA-1.6B TTS:最高のテキストからダイアログの生成モデル - 分析VidhyaMay 11, 2025 am 10:27 AM

DIA-1.6B TTS:最高のテキストからダイアログの生成モデル - 分析VidhyaMay 11, 2025 am 10:27 AMDIA-1.6Bを探索:資金がゼロの2人の学部生によって開発された画期的なテキストからスピーチモデル! この16億個のパラメーターモデルは、笑い声やくしゃみなどの非言語的手がかりを含む、非常に現実的なスピーチを生成します。この記事ガイド

AIがメンターシップをこれまで以上に意味のあるものにする3つの方法May 10, 2025 am 11:17 AM

AIがメンターシップをこれまで以上に意味のあるものにする3つの方法May 10, 2025 am 11:17 AM私は心から同意します。 私の成功は、メンターの指導に密接に関連しています。 特にビジネス管理に関する彼らの洞察は、私の信念と実践の基盤を形成しました。 この経験は、メンターへの私のコミットメントを強調しています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター