Grok-1 は半月も前にオープンソースとして正式に発表され、新しくアップグレードされた Grok-1.5 がリリースされました。

たった今、Musk xAI は、128K コンテキスト Grok-1.5 の推論機能が大幅に向上したことを正式に発表しました。

そして、もうすぐオンラインになります。

11 日前、Grok-1 モデルの重みとアーキテクチャがオープンソース化され、Xai が昨年 11 月までに達成した進歩が実証されました。

Grok-1 は、Llama 2 の 4 倍である 3,140 億個のパラメータを持ち、MoE アーキテクチャを使用しており、8 人の専門家のうち 2 人が現役の専門家です。

Xai 氏は、それ以来、チームが最新モデル Grok-1.5 の推論能力と問題解決能力を向上させてきたと紹介しました。

OpenAI の元開発者担当責任者は、xAI のメジャー リリースのタイミングから、OpenAI のペースと緊迫感がわかると述べました。エキサイティング!

##128K コンテキスト、Grok-1.5 の数学的推論能力は急上昇しました

公式の紹介によると, Grok-1.5 推論機能が向上し、コンテキストの長さは 128K になりました。

Grok-1.5 の最も重要な改善点の 1 つは、コーディングおよび数学関連タスクのパフォーマンスです。

テストでは、Grok-1.5 は数学ベンチマークで 50.6%、GSM8K ベンチマークで 90% のスコアを達成しました。これら 2 つの数学ベンチマークは小学校から高校までをカバーしています。質問。

さらに、Grok-1.5 は、コード生成と問題解決能力を評価する HumanEval ベンチマーク テストで 74.1% という高スコアを達成しました。

以下の図から、Grok-1 と比較して、Grok-1.5 の数学的能力が GSM8K で 62.9% から 90% に大幅に向上していることがわかります。 MATH では 23.9% から 50.6% に増加しました。

128K の長いコンテキストの理解、16 倍の増幅#Grok-1.5 のもう 1 つの新機能は、コンテキスト ウィンドウ内で最大 128K トークンのテキストを処理できることです。

これにより、Grok のメモリ容量が以前のコンテキスト長の 16 倍に増加し、より長いドキュメントからの情報を利用できるようになります。

さらに、新しいモデルは、コンテキスト ウィンドウが拡大しても指示に従う能力を維持しながら、より長く複雑なプロンプトを処理できます。

さらに、新しいモデルは、コンテキスト ウィンドウが拡大しても指示に従う能力を維持しながら、より長く複雑なプロンプトを処理できます。

Needle In A Haystack (NIAH) の評価では、Grok-1.5 は強力な検索機能を実証し、最大 128K バイトの長さのコンテキスト内の埋め込みテキストを取得し、完璧な検索結果を達成しました。

Grok-1.5 インフラストラクチャ

##Grok-1.5 は JAX、Rust、Kubernetes 上に構築されています' カスタマイズされた分散トレーニング フレームワーク。

このトレーニング スタックにより、xAI チームは最小限の投資でアイデアを大規模に構築し、新しいアーキテクチャをトレーニングできるようになります。

大規模なコンピューティング クラスターで LLM をトレーニングする際の主な課題は、トレーニング タスクの信頼性と稼働時間を最大化することです。

xAI のカスタマイズされたトレーニング オーケストレーターにより、問題のあるノードが自動的に検出され、トレーニング タスクから除外されます。

同時に、チェックポイント設定、データの読み込み、トレーニング タスクの再起動も最適化して、障害発生時のダウンタイムを最小限に抑えました。

xAI は、モデルの改善を支援するために、Grok-1.5 が間もなく初期テスターに利用可能になると述べました。

このブログでは、Grok-1.5 が数日以内にリリースするいくつかの新機能もプレビューしました。

最後に、いつものようにxAIから採用情報を掲載しました。

以上が11 日間のオープンソースを経て、マスク氏が再び Grok-1.5 をリリース! 128K コードが GPT-4 を破るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

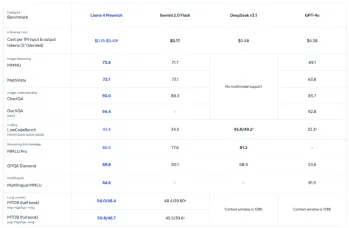

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AM

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AMOpenaiは、強力なGPT-4.1シリーズを発表しました。実際のアプリケーション向けに設計された3つの高度な言語モデルのファミリー。 この大幅な飛躍は、より速い応答時間、理解の強化、およびTと比較した大幅に削減されたコストを提供します

LLMベンチマークとは何ですか?Apr 26, 2025 am 10:13 AM

LLMベンチマークとは何ですか?Apr 26, 2025 am 10:13 AM大規模な言語モデル(LLM)は最新のAIアプリケーションに不可欠になっていますが、その機能を評価することは依然として課題です。従来のベンチマークは長い間LLMパフォーマンスを測定するための標準でしたが、RAでは

7タスクGemini 2.5 Proは他のどのチャットボットよりも優れています!Apr 26, 2025 am 10:00 AM

7タスクGemini 2.5 Proは他のどのチャットボットよりも優れています!Apr 26, 2025 am 10:00 AMAIチャットボットはより賢くなり、その日までにますます洗練されています。 Google Deepmindの最新の実験モデルであるGemini 2.5 Proは、AIチャットボット機能における大きな前進を表しています。 Contexが改善されています

6 O3プロンプト今日試してみる必要があります-AnalyticsVidhyaApr 26, 2025 am 09:56 AM

6 O3プロンプト今日試してみる必要があります-AnalyticsVidhyaApr 26, 2025 am 09:56 AMOpenaiのO3:推論とマルチモーダル機能における前進 OpenaiのO3モデルは、AI推論能力の大きな進歩を表しています。複雑な問題解決、分析タスク、および自律的なツールの使用のために設計されたO3

Canva Codeを試しましたが、ここでそれがどのように進んだかを試しました。Apr 26, 2025 am 09:53 AM

Canva Codeを試しましたが、ここでそれがどのように進んだかを試しました。Apr 26, 2025 am 09:53 AMCanva Create2025:Canva CodeとAIを使用してデザインを革新する CanvaのCreate 2025イベントは、AIを搭載したツール、エンタープライズソリューション、特に開発者ツールにプラットフォームを拡大し、重要な進歩を発表しました。 キーアップデートにはentが含まれています

タスク用のAIチャットボット:AIエージェントがどのように静かにアプリを交換しているかApr 26, 2025 am 09:50 AM

タスク用のAIチャットボット:AIエージェントがどのように静かにアプリを交換しているかApr 26, 2025 am 09:50 AM簡単なタスクのためのApp-Hoppingの時代は終わりです。 1回の会話で休暇を予約したり、請求書を自動的に交渉したりすることを想像してください。 これはAIエージェントの力です - あなたのニーズを予測する新しいデジタルアシスタント、JUSではなく

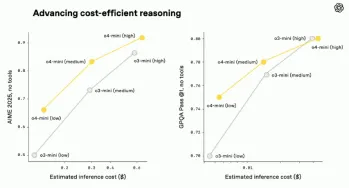

O3およびO4-MINI:Openaiの最も高度な推論モデルApr 26, 2025 am 09:46 AM

O3およびO4-MINI:Openaiの最も高度な推論モデルApr 26, 2025 am 09:46 AMOpenaiの画期的なO3およびO4-MINI推論モデル:AGIへの巨大な飛躍 GPT 4.1ファミリーの打ち上げのかかとで、Openaiは、AIであるO3およびO4-MINI推論モデルでの最新の進歩を発表しました。 これらは単なるAIモデルではありません。

Llama 4とAutogenでAIエージェントを構築しますApr 26, 2025 am 09:44 AM

Llama 4とAutogenでAIエージェントを構築しますApr 26, 2025 am 09:44 AMインテリジェントAIエージェントを構築するためにLlama 4とオートゲンの力を活用する MetaのLlama 4ファミリのモデルはAIの景観を変換しており、インテリジェントなシステム開発に革命をもたらすためにネイティブのマルチモーダル機能を提供しています。 この記事の探検

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

メモ帳++7.3.1

使いやすく無料のコードエディター

ホットトピック

7723

7723 15

15 1643

1643 14

14 1396

1396 52

52 1290

1290 25

25 1233

1233 29

29