タイトル: DECO: ConvNets を使用したクエリベースのエンドツーエンド オブジェクト検出

論文: https://arxiv.org/pdf/2312.13735 .pdf

ソースコード: https://github.com/xinghaochen/DECO

原文: https://zhuanlan.zhihu.com/p/686011746@王云河

はじめに

# Detection Transformer (DETR) の導入後、物体検出の分野で大流行が起こり、その後の多くの研究により、精度と速度の点で元の DETR が改善されました。しかし、トランスフォーマーが視界を完全に支配できるかどうかについては議論が続いている。 ConvNeXt や RepLKNet などのいくつかの研究は、CNN 構造が視覚分野において依然として大きな可能性を秘めていることを示しています。

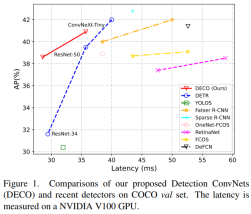

私たちの研究では、純粋な畳み込みアーキテクチャを使用して、高性能の DETR のようなフレームワーク検出器を取得する方法を検討しています。 DETR に敬意を表して、私たちはこのアプローチを DECO (Detection ConvNets) と呼びます。 DETR と同様の構造設定を使用し、異なるバックボーンを使用した DECO は、COCO で 38.6% と 40.8% の AP、V100 で 35 FPS と 28 FPS を達成し、DETR よりも優れたパフォーマンスを達成しました。 RT-DETR と同様のマルチスケール機能などのモジュールと組み合わせることで、DECO は 47.8% AP および 34 FPS の速度を達成し、全体的なパフォーマンスは多くの DETR 改善手法と比較して優れた利点をもたらしました。

手法

ネットワークアーキテクチャ

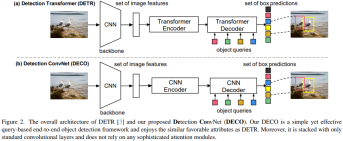

DETRの主な特徴は、Transformer Encoder-Decoderの構造を使用して入力画像を処理することです。クエリのセットは画像特徴と対話し、指定された数の検出フレームを直接出力できるため、NMS などの後処理操作への依存を排除できます。私たちが提案した DECO の全体的なアーキテクチャは DETR と似ており、画像の特徴を抽出するための Backbone、Query と対話するための Encoder-Decoder 構造、そして最終的に特定の数の検出結果を出力する機能も含まれています。唯一の違いは、DECO のエンコーダとデコーダが純粋な畳み込み構造であるため、DECO は純粋な畳み込みで構成されるクエリベースのエンドツーエンド検出器であることです。

Encoder

DETR のエンコーダ構造の置換は比較的簡単で、エンコーダ構造を形成するために 4 つの ConvNeXt ブロックを使用することにしました。具体的には、エンコーダの各層は、7x7 深さの畳み込み、LayerNorm 層、1x1 畳み込み、GELU アクティベーション関数、および別の 1x1 畳み込みを積み重ねることによって実装されます。また、DETRでは、Transformerアーキテクチャが入力に対して順列不変性を持つため、エンコーダの各層の入力に位置エンコーディングを追加する必要がありますが、畳み込みで構成されるEncoderの場合、位置エンコーディングを追加する必要はありません

Decoder

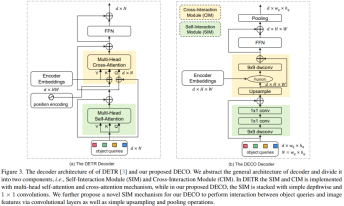

これに比べて、Decoder の置き換えははるかに複雑です。デコーダの主な機能は、画像の特徴およびクエリと完全に対話し、クエリが画像の特徴情報を完全に認識して、画像内のターゲットの座標とカテゴリを予測できるようにすることです。デコーダには主に 2 つの入力が含まれます。エンコーダの特徴出力と学習可能なクエリ ベクトル (クエリ) のセットです。 Decoder の主な構造は、Self-Interaction Module (SIM) と Cross-Interaction Module (CIM) の 2 つのモジュールに分割されます。

ここでは、SIM モジュールは主にクエリの出力と上位のデコーダー層を統合しています。構造のこの部分は、9x9 の深さ方向の畳み込みを使用して、いくつかの畳み込み層で構成できます。 1x1 畳み込みは、それぞれ空間次元とチャネル次元で情報の相互作用を実行し、必要なターゲット情報を完全に取得し、それを後続の CIM モジュールに送信して、ターゲット検出機能をさらに抽出します。クエリはランダムに初期化されたベクトルのセットです。この数によって、検出器が最終的に出力する検出フレームの数が決まります。その具体的な値は、実際のニーズに応じて調整できます。 DECO では、すべての構造が畳み込みで構成されているため、クエリを 2 次元に変換します (たとえば、100 個のクエリは 10x10 次元になります)。

CIM モジュールの主な機能は、画像の特徴とクエリが完全に相互作用できるようにすることで、クエリが画像の特徴情報を完全に認識して、画像内のターゲットの座標とカテゴリを予測できるようにすることです。 Transformer 構造の場合、クロス アテンション メカニズムを使用することでこの目標を達成するのは簡単ですが、畳み込み構造の場合、2 つの機能をどのように完全に相互作用させるかが最大の困難です。

SIM 出力と異なるサイズのエンコーダー出力のグローバル機能を融合するには、まず 2 つを空間的に位置合わせしてから融合する必要があります。まず、SIM 出力で最近傍アップサンプリングを実行します。

アップサンプリングされた特徴をエンコーダーによって出力されるグローバル特徴と同じサイズにし、アップサンプリングされた特徴をエンコーダーによって出力されるグローバル特徴と融合してから、特徴の深度畳み込みを入力します。インタラクション、残りの入力を追加します:

最後に、インタラクションされた特徴は FNN を介したチャネル情報インタラクションに使用され、ターゲット番号にプールされて出力埋め込みを取得します。デコーダ:

最後に、後続の分類と回帰のために出力埋め込みを検出ヘッドに送信します。

マルチスケール機能

元の DETR と同様、上記のフレームワークによって得られた DECO にも共通の欠点があります。それは、高精度に大きな影響を与えるマルチスケール機能の欠如です。ターゲット検出です。変形可能な DETR は、マルチスケールの変形可能なアテンション モジュールを使用して、さまざまなスケールの機能を統合しますが、このメソッドはアテンション オペレーターと強く結合されているため、DECO で直接使用することはできません。 DECO がマルチスケール特徴を処理できるようにするために、Decoder によって出力された特徴の後に、RT-DETR によって提案されたクロススケール特徴融合モジュールを使用します。実際、DETRの誕生以降、一連の改善手法が導き出されており、DECOにも応用できる戦略も数多くあると考えておりますので、ご興味のある方はぜひご議論いただければと思います。

実験

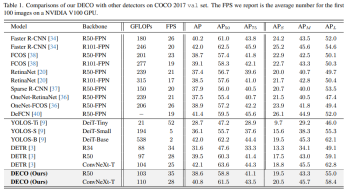

クエリの数やデコーダー層の数を変えるなど、主要なアーキテクチャを変更せずに、COCO で実験を行い、DECO と DETR を比較しました。 DETR の Transformer 構造と、上で説明した畳み込み構造を組み合わせます。 DECO は DETR よりも優れた精度と高速なトレードオフを実現していることがわかります。

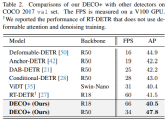

また、以下の図に示すように、DECO をマルチスケール機能と、多くの DETR バリアントを含むより多くのターゲット検出方法と比較しました。DECO が非常に優れた成果を達成していることがわかります。良好な結果が得られ、以前の多くの検出器よりも優れたパフォーマンスを達成しました。

この記事の DECO の構造は、Decoder で選択された特定の融合戦略 (加算、ドット乗算、連結) やそこへのクエリなど、多くのアブレーション実験と視覚化を経ています。また、最適な結果を達成するためのディメンションの設定方法に関する興味深い発見もいくつかあります。より詳細な結果と議論については、元の記事を参照してください。

概要

この記事は、複雑な Transformer アーキテクチャを使用せずに、クエリベースのエンドツーエンドのターゲット検出フレームワークを構築できるかどうかを検討することを目的としています。バックボーン ネットワークと畳み込みエンコーダ/デコーダ構造を含む、Detection ConvNet (DECO) と呼ばれる新しい検出フレームワークが提案されています。 DECO エンコーダを慎重に設計し、新しいメカニズムを導入することにより、DECO デコーダは畳み込み層を介してターゲット クエリと画像特徴の間の相互作用を実現できます。 COCO ベンチマークで以前の検出器との比較が行われ、DECO はシンプルさにもかかわらず、検出精度と実行速度の点で競争力のあるパフォーマンスを達成しました。具体的には、ResNet-50 および ConvNeXt-Tiny バックボーンを使用して、DECO は、それぞれ 35 FPS および 28 FPS に設定された COCO 検証セットで 38.6% と 40.8% の AP を達成し、DET モデルを上回りました。 DECO が物体検出フレームワークの設計に新しい視点を提供することが期待されています。

以上がDECO: 純粋な畳み込みクエリベースの検出器は DETR を超えています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

thinkphp是不是国产框架Sep 26, 2022 pm 05:11 PM

thinkphp是不是国产框架Sep 26, 2022 pm 05:11 PMthinkphp是国产框架。ThinkPHP是一个快速、兼容而且简单的轻量级国产PHP开发框架,是为了简化企业级应用开发和敏捷WEB应用开发而诞生的。ThinkPHP从诞生以来一直秉承简洁实用的设计原则,在保持出色的性能和至简的代码的同时,也注重易用性。

Python 强大的任务调度框架 Celery!Apr 12, 2023 pm 09:55 PM

Python 强大的任务调度框架 Celery!Apr 12, 2023 pm 09:55 PM什么是 celery这次我们来介绍一下 Python 的一个第三方模块 celery,那么 celery 是什么呢? celery 是一个灵活且可靠的,处理大量消息的分布式系统,可以在多个节点之间处理某个任务; celery 是一个专注于实时处理的任务队列,支持任务调度; celery 是开源的,有很多的使用者; celery 完全基于 Python 语言编写;所以 celery 本质上就是一个任务调度框架,类似于 Apache 的 airflow,当然 airflow 也是基于 Python

6个推荐的Python框架,用于构建可解释的人工智能系统(XAI)Apr 26, 2023 am 10:49 AM

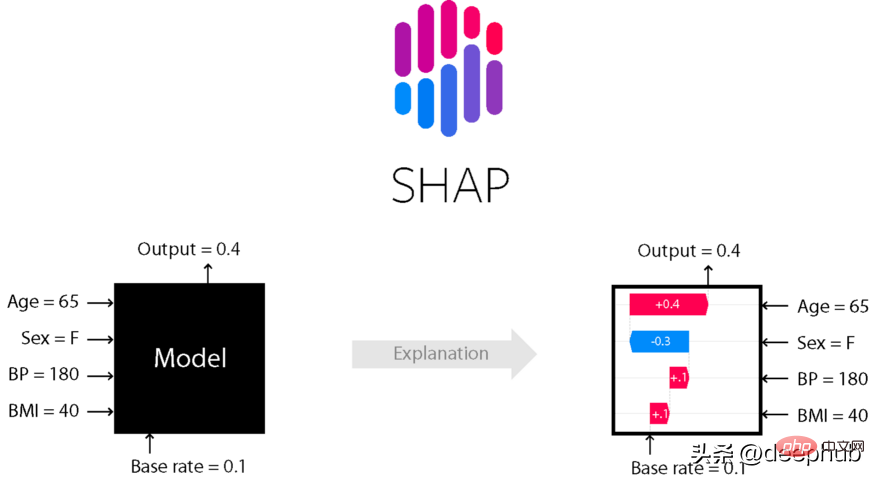

6个推荐的Python框架,用于构建可解释的人工智能系统(XAI)Apr 26, 2023 am 10:49 AMAI就像一个黑匣子,能自己做出决定,但是人们并不清楚其中缘由。建立一个AI模型,输入数据,然后再输出结果,但有一个问题就是我们不能解释AI为何会得出这样的结论。需要了解AI如何得出某个结论背后的原因,而不是仅仅接受一个在没有上下文或解释的情况下输出的结果。可解释性旨在帮助人们理解:如何学习的?学到了什么?针对一个特定输入为什么会做出如此决策?决策是否可靠?在本文中,我将介绍6个用于可解释性的Python框架。SHAPSHapleyAdditiveexplanation(SHapleyAdditi

Microsoft .NET Framework 4.5.2、4.6 和 4.6.1 将于 2022 年 4 月终止支持Apr 17, 2023 pm 02:25 PM

Microsoft .NET Framework 4.5.2、4.6 和 4.6.1 将于 2022 年 4 月终止支持Apr 17, 2023 pm 02:25 PM已安装Microsoft.NET版本4.5.2、4.6或4.6.1的MicrosoftWindows用户如果希望Microsoft将来通过产品更新支持该框架,则必须安装较新版本的Microsoft框架。据微软称,这三个框架都将在2022年4月26日停止支持。支持日期结束后,产品将不会收到“安全修复或技术支持”。大多数家庭设备通过Windows更新保持最新。这些设备已经安装了较新版本的框架,例如.NETFramework4.8。未自动更新的设备可能

如何在PHP中使用AOP框架May 19, 2023 pm 01:21 PM

如何在PHP中使用AOP框架May 19, 2023 pm 01:21 PMAOP(面向切面编程)是一种编程思想,用于解耦业务逻辑和横切关注点(如日志、权限等)。在PHP中,使用AOP框架可以简化编码,提高代码可维护性和可扩展性。本文将介绍在PHP中使用AOP框架的基本原理和实现方法。一、AOP的概念和原理面向切面编程,指的是将程序的业务逻辑和横切关注点分离开来,通过AOP框架来实现统一管理。横切关注点指的是在程序中需要重复出现并且

KB5013943 2022 年 5 月更新使 Windows 11 上的应用程序崩溃Apr 16, 2023 pm 10:52 PM

KB5013943 2022 年 5 月更新使 Windows 11 上的应用程序崩溃Apr 16, 2023 pm 10:52 PM如果你在Windows11上安装了2022年5月累积更新,你可能已经注意到你一直使用的许多应用程序都不像以前那样工作了。强制性安全更新KB5013943正在使某些使用.NET框架的应用程序崩溃。在某些情况下,用户会收到错误代码:0xc0000135。可选更新中报告了类似的问题,但并不普遍。随着2022年5月的更新,该错误似乎已进入生产渠道,这次有更多用户受到影响。崩溃在使用.NETFramework的应用程序中很常见,Discord或MicrosoftTeams等

朱军团队在清华开源了首个基于Transformer的多模态扩散大型模型,经过文本和图像改写全部完成。May 08, 2023 pm 08:34 PM

朱军团队在清华开源了首个基于Transformer的多模态扩散大型模型,经过文本和图像改写全部完成。May 08, 2023 pm 08:34 PM据悉GPT-4将于本周发布,多模态将成为其一大亮点。当前的大语言模型正在成为理解各种模态的通用接口,能够根据不同模态信息来给出回复文本,但大语言模型生成的内容也仅仅局限于文本。另一方面,当前的扩散模型DALL・E2、Imagen、StableDiffusion等在视觉创作上掀起一场革命,但这些模型仅仅支持文到图的单一跨模态功能,离通用式生成模型还有一定距离。而多模态大模型将能够打通各种模态能力,实现任意模态之间转化,被认为是通用式生成模型的未来发展方向。清华大学计算机系朱军教授带领的TSAI

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

SublimeText3 中国語版

中国語版、とても使いやすい

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

メモ帳++7.3.1

使いやすく無料のコードエディター

ドリームウィーバー CS6

ビジュアル Web 開発ツール