Tao Dacheng のチームは、香港大学および UMD と共同で、374 件の関連著作を要約し、LLM 知識蒸留に関する最新のレビューを発表しました。

Large Language Model (LLM) は過去 2 年間で急速に発展し、GPT-4、Gemini、Claude などのいくつかの驚異的なモデルや製品が登場しましたが、そのほとんどはクローズド ソースです。現在研究コミュニティが利用できるほとんどのオープンソース LLM とクローズドソース LLM の間には大きな隔たりがあるため、オープンソース LLM やその他の小規模モデルの機能を改善して、クローズドソースの大規模モデルとの隔たりを減らすことが研究のホットスポットとなっています。この分野で。

LLM、特にクローズドソース LLM の強力な機能により、科学研究者や産業従事者は、独自のモデルをトレーニングする際に、これらの大規模モデルの出力と知識を利用できます。このプロセスは本質的に知識蒸留 (KD) プロセスであり、教師モデル (GPT-4 など) からより小さなモデル (Llama など) に知識を蒸留し、小さなモデルの機能を大幅に向上させます。大規模な言語モデルの知識蒸留テクノロジーは遍在しており、研究者が独自のモデルをトレーニングおよび改善するのに役立つ費用対効果が高く効果的な方法であることがわかります。

それでは、現在の作業では、知識の蒸留とデータ取得のためにクローズドソース LLM をどのように利用しているのでしょうか?この知識を効率的に小さなモデルにトレーニングするにはどうすればよいでしょうか?小さなモデルは教師モデルからどのような強力なスキルを獲得できるでしょうか? LLM の知識の蒸留は、ドメインの特性を持つ業界でどのような役割を果たしますか?これらの問題は、徹底的に考え、研究する価値があります。

2020 年、Tao Dacheng のチームは、ディープラーニングにおける知識蒸留の応用を包括的に調査した「知識蒸留: 調査」を発表しました。このテクノロジーは主にモデルの圧縮と高速化に使用されます。大規模な言語モデルの台頭により、知識蒸留の応用分野は継続的に拡大しており、小規模モデルのパフォーマンスを向上させるだけでなく、モデルの自己改善も実現できます。

2024 年初頭、Tao Dacheng のチームは香港大学およびメリーランド大学と協力して、最新のレビュー「大規模言語モデルの知識蒸留に関する調査」を発表しました。このレビューでは、374 の関連研究が要約され、どのように大規模な言語モデルから学習するため、知識の獲得、小規模なモデルのトレーニング、モデルの圧縮と自己トレーニングにおける知識の蒸留の役割を学びます。同時に、このレビューでは大規模な言語モデルのスキルの抽出と垂直フィールドの抽出も取り上げており、研究者が独自のモデルをトレーニングおよび改善する方法を完全に理解するのに役立ちます。

論文タイトル: 大規模言語モデルの知識蒸留に関する調査

論文リンク: https: //arxiv.org/abs/2402.13116

プロジェクト リンク: https://github.com/Tebmer/Awesome-Knowledge-Distillation-of-LLMs

概要アーキテクチャ

##大規模言語モデルの知識抽出の全体的なフレームワークは次のように要約されます:

知識の引き出し: 教師モデルから知識を取得する方法。このプロセスには主に次のものが含まれます。 a) 最初に、教師モデルから抽出されるスキルまたはコンピテンシーの垂直領域を特定するための指示を作成します。

b) 次に、シード知識 (特定のデータセットなど) を入力として使用して教師モデルを駆動し、対応する応答を生成し、それによって対応する知識をガイドします。

c) 同時に、知識の獲得には、アノテーション、拡張、合成、特徴抽出、フィードバック、独自の知識などの特定のテクノロジーが含まれます。

2.

蒸留アルゴリズム: つまり、取得した知識を学生モデルに注入する方法です。この部分の具体的なアルゴリズムには、教師あり微調整、発散と類似性、強化学習 (AI フィードバックからの強化学習、RLAIF)、およびランキングの最適化が含まれます。 このレビューの分類方法は、このプロセスに基づいて、知識の蒸留アルゴリズム、スキルの蒸留、および垂直フィールドの蒸留という 3 つの側面から関連する作業を要約しています。後の 2 つは、知識抽出アルゴリズムに基づいて抽出されます。この分類の詳細と、それに対応する関連研究の概要を次の図に示します。 知識蒸留アルゴリズム 知識の引き出し 方法については、教師モデルの知識を獲得するために、このレビューではそのテクノロジーをラベル付け、拡張、データ合成、特徴抽出、フィードバック、および自己生成知識に分割しています。 ラベリング : 知識のラベリングとは、教師 LLM が指示または例に基づいて指示を与えることを指します。入力は、対応する出力を生成するためのシード知識として使用されます。たとえば、シード知識は特定のデータセットの入力であり、教師モデルは思考チェーンの出力にラベルを付けます。 拡張: このテクノロジーの重要な機能は、LLM のコンテキスト学習機能を使用して、提供されたシードの例に基づいて例と同様のデータを生成することです。利点は、例を通じてより多様で広範なデータセットを生成できることです。ただし、生成されるデータが増加し続けると、データの均一性の問題が発生する可能性があります。 データ合成 (データキュレーション): データ合成の特徴は、データを最初から合成することです。多様かつ膨大なシード知識として大量のメタ情報(トピック、知識文書、元データなど)を活用し、教師LLMから大規模かつ高品質なデータセットを取得します。 特徴の取得 (Feature): 特徴の知識を取得する一般的な方法は、入力シーケンスと出力シーケンスを教師 LLM に出力し、その内部表現を抽出することです。この方法は主にオープンソース LLM に適しており、モデルの圧縮によく使用されます。 フィードバック: フィードバック知識は通常、生徒の出力に関する教師モデルにフィードバックを提供します。たとえば、生徒がより良い出力を生成できるように導くための設定、評価、または修正情報の提供などです。 自己知識: 知識は生徒自身からも得られます。これは自己生成知識と呼ばれます。この場合、同じモデルが教師と生徒の両方として機能し、テクニックを抽出し、以前に生成された自身の出力を改善することによって反復的に自身を改善します。このアプローチは、オープンソース LLM に適しています。 まとめ: 現在でも拡張方式が広く使われており、高品質なデータを大量に生成できるデータ合成方式が徐々に主流になってきています。フィードバック方法は、学生モデルの調整能力を向上させるのに役立つ知識を提供できます。オープンソースの大規模モデルを教師モデルとして使用することにより、特徴の取得と自己生成の知識手法が普及してきました。特徴取得メソッドはオープンソース モデルの圧縮に役立ち、自己生成知識メソッドは大規模な言語モデルを継続的に改善できます。重要なのは、上記の方法は効果的に組み合わせることができ、研究者はさまざまな組み合わせを探索して、より効果的な知識を引き出すことができるということです。 アルゴリズムの抽出 知識を取得したら、それを学生モデルに抽出する必要があります。蒸留アルゴリズムには、教師あり微調整、発散と類似性、強化学習、ランキングの最適化が含まれます。例を以下に示します。 教師あり微調整: 教師あり微調整 (SFT) は、教師モデルによって生成されたシーケンスの尤度を最大化することで学生モデルを微調整し、学生モデルが教師モデルを模倣できるようにします。これは現在、LLM の知識の蒸留で最も一般的に使用されている手法です。 発散と類似性: このアルゴリズムは、教師モデルの内部パラメーターの知識を生徒モデルのトレーニングの監視信号として使用し、オープンソースの教師モデルに適しています。発散と類似性に基づく方法は、それぞれ確率分布と隠れ状態を調整します。 強化学習 : このアルゴリズムは、教師のフィードバック知識を使用して生徒モデルをトレーニングする、つまり RLAIF テクノロジーに適しています。主な側面は 2 つあります: (1) 教師が生成したフィードバック データを使用して生徒の報酬モデルをトレーニングする、(2) トレーニングされた報酬モデルを通じて期待される報酬を最大化することで生徒のモデルを最適化する。教師が直接報酬モデルとして機能することもできます。 ランクの最適化: ランキングの最適化では、生徒モデルに好みの知識を注入することもできます。その利点は、DPO、RRHF などのいくつかの古典的なアルゴリズムなど、安定性と高い計算効率です。 スキルの抽出 誰もが知っているように、大規模な言語モデルには多くの優れた機能があります。知識蒸留技術を通じて、教師が対応するスキルを含む知識を生成し、生徒モデルをトレーニングしてこれらの能力を習得できるように制御するための指示が提供されます。これらの機能には主に、コンテキスト (指示など) の追跡、位置合わせ、エージェント、自然言語処理 (NLP) タスク、マルチモダリティなどの機能が含まれます。 次の表は、スキル蒸留の古典的な作業を要約し、各作業に関連するスキル、シード知識、教師モデル、生徒モデル、知識獲得方法、蒸留アルゴリズムもまとめています。 垂直ドメイン蒸留 一般的な分野の大規模言語モデルに加えて、現在、大規模言語をトレーニングする多くの作業が行われています。垂直分野のモデル 。これは、研究コミュニティや業界が大規模な言語モデルを適用および展開するのに役立ちます。大規模な言語モデル (GPT-4 など) は、垂直分野におけるドメイン知識が限られていますが、それでもある程度のドメイン知識と機能を提供したり、既存のドメイン データ セットを強化したりできます。ここで扱う分野は主に、(1) 法律、(2) 医療、健康、(3) 金融、(4) 科学、その他の分野です。この部分の分類と関連作業を以下に示します。 今後の方向性 このレビューでは、現在の大規模な言語モデルについて調査します。知識の蒸留と潜在的な将来の研究の方向性には主に次のものが含まれます: データ選択: より良い蒸留結果を達成するためにデータを自動的に選択するにはどうすればよいですか? 複数教師の蒸留: さまざまな教師モデルから 1 つの生徒モデルへの知識の蒸留を調べます。 教師モデルのより豊富な知識 : 教師モデルでは、フィードバックや機能の知識を含むより豊富な知識を探索したり、複数の知識取得方法を探索したりできます。組み合わせ。 蒸留中の壊滅的な忘却の克服: 知識の蒸留または伝達中に元のモデルを効果的に保存する機能は依然として困難な問題です。 信頼できる知識の抽出: 現在、KD はさまざまなスキルの抽出に主に焦点を当てており、大規模なモデルの信頼性にはあまり注意を払っていません。 弱から強への蒸留(弱から強への蒸留)。 OpenAI は、「弱いものから強いものへの一般化」という概念を提案しています。これには、弱いモデルがより強いモデルの学習プロセスを効果的に導くことができるように、革新的な技術戦略を模索する必要があります。 自己調整 (自己蒸留)。フィードバック、批評、説明を生成することで、学生モデルが生成されたコンテンツを自律的に改善し、調整するように指示を設計できます。 結論 このレビューでは、大規模な言語モデルの知識を使用して、次のような学生モデルを改善する方法について包括的かつ包括的にレビューします。オープンソースの大規模言語モデル。最近人気の自己蒸留技術も含めて体系的にまとめられています。このレビューでは、知識の蒸留を知識の取得と蒸留アルゴリズムの 2 つのステップに分け、スキルの蒸留と垂直フィールドの蒸留についてもまとめます。最後に、このレビューでは、大規模言語モデルの知識蒸留の限界を押し広げ、よりアクセスしやすく、効率的、効果的で、信頼できる大規模言語モデルを取得することを期待して、大規模言語モデルの蒸留の将来の方向性を探ります。

以上がTao Dacheng のチームは、香港大学および UMD と共同で、374 件の関連著作を要約し、LLM 知識蒸留に関する最新のレビューを発表しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

エージェントラグシステムはどのようにテクノロジーを変換しますか?Apr 12, 2025 am 09:21 AM

エージェントラグシステムはどのようにテクノロジーを変換しますか?Apr 12, 2025 am 09:21 AM導入 人工知能は新しい時代に入りました。モデルが事前定義されたルールに基づいて単に情報を出力する時代は終わりました。今日のAIの最先端のアプローチは、Ragを中心に展開しています(検索装備

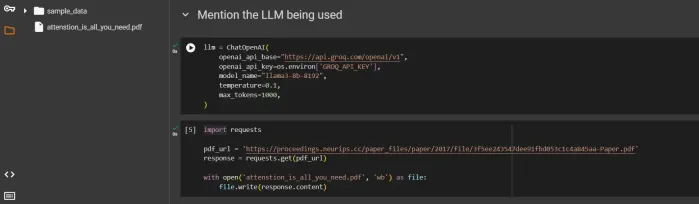

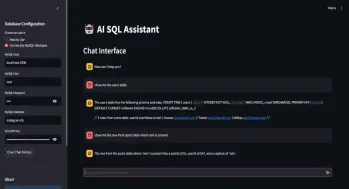

自動生成クエリのSQLアシスタントApr 12, 2025 am 09:13 AM

自動生成クエリのSQLアシスタントApr 12, 2025 am 09:13 AM複雑なSQLクエリを書いたり、スプレッドシートを並べ替えたりせずに、データベースと話をしたり、単純な言語で質問したり、即座に答えを得たりすることを望んだことがありますか? LangchainのSQL Toolkit、Groq a

AIインデックス2025を読む:AIはあなたの友人、敵、または副操縦士ですか?Apr 11, 2025 pm 12:13 PM

AIインデックス2025を読む:AIはあなたの友人、敵、または副操縦士ですか?Apr 11, 2025 pm 12:13 PMスタンフォード大学ヒト指向の人工知能研究所によってリリースされた2025年の人工知能インデックスレポートは、進行中の人工知能革命の良い概要を提供します。 4つの単純な概念で解釈しましょう:認知(何が起こっているのかを理解する)、感謝(利益を見る)、受け入れ(顔の課題)、責任(責任を見つける)。 認知:人工知能はどこにでもあり、急速に発展しています 私たちは、人工知能がどれほど速く発展し、広がっているかを強く認識する必要があります。人工知能システムは絶えず改善されており、数学と複雑な思考テストで優れた結果を達成しており、わずか1年前にこれらのテストで惨めに失敗しました。 2023年以来、複雑なコーディングの問題や大学院レベルの科学的問題を解決することを想像してみてください

Meta Llama 3.2を始めましょう - 分析VidhyaApr 11, 2025 pm 12:04 PM

Meta Llama 3.2を始めましょう - 分析VidhyaApr 11, 2025 pm 12:04 PMメタのラマ3.2:マルチモーダルとモバイルAIの前進 メタは最近、ラマ3.2を発表しました。これは、モバイルデバイス向けに最適化された強力なビジョン機能と軽量テキストモデルを特徴とするAIの大幅な進歩です。 成功に基づいてo

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5などApr 11, 2025 pm 12:01 PM

AVバイト:Meta' s llama 3.2、GoogleのGemini 1.5などApr 11, 2025 pm 12:01 PM今週のAIの風景:進歩、倫理的考慮、規制の議論の旋風。 Openai、Google、Meta、Microsoftのような主要なプレーヤーは、画期的な新しいモデルからLEの重要な変化まで、アップデートの急流を解き放ちました

マシンと話すための人的費用:チャットボットは本当に気にすることができますか?Apr 11, 2025 pm 12:00 PM

マシンと話すための人的費用:チャットボットは本当に気にすることができますか?Apr 11, 2025 pm 12:00 PMつながりの慰めの幻想:私たちはAIとの関係において本当に繁栄していますか? この質問は、MIT Media Labの「AI(AHA)で人間を進める」シンポジウムの楽観的なトーンに挑戦しました。イベントではCondedgを紹介している間

PythonのScipy Libraryの理解Apr 11, 2025 am 11:57 AM

PythonのScipy Libraryの理解Apr 11, 2025 am 11:57 AM導入 あなたが科学者またはエンジニアで複雑な問題に取り組んでいると想像してください - 微分方程式、最適化の課題、またはフーリエ分析。 Pythonの使いやすさとグラフィックスの機能は魅力的ですが、これらのタスクは強力なツールを必要とします

ラマ3.2を実行する3つの方法-Analytics VidhyaApr 11, 2025 am 11:56 AM

ラマ3.2を実行する3つの方法-Analytics VidhyaApr 11, 2025 am 11:56 AMメタのラマ3.2:マルチモーダルAIパワーハウス Metaの最新のマルチモーダルモデルであるLlama 3.2は、AIの大幅な進歩を表しており、言語理解の向上、精度の向上、および優れたテキスト生成機能を誇っています。 その能力t

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。