たった今、Pika が新機能をリリースしました:

申し訳ありませんが、以前はミュートされていました。

今日から、誰でも ビデオ用のサウンドエフェクト をシームレスに生成できるようになります - サウンドエフェクト !

生成には 2 つの方法があります:

- プロンプトを表示して必要なサウンドを説明する;

- または直接生成するPika にビデオ コンテンツに基づいて自動的に生成させます。

そして、ピカは自信満々にこう言いました。「効果音が素晴らしいと思うなら、それは素晴らしい効果だからです。」

車の音、ラジオの音、鷲の音、剣の音、歓声…その音は数え切れないほどあり、効果という意味でも映像との整合性も高いです。

プロモーションビデオが公開されているだけでなく、Pika の公式 Web サイトでは複数のデモも公開されています。

たとえば、何のプロンプトも表示せずに、AI はベーコンを焼くビデオを見ただけで、何の違反感もなく効果音を一致させることができます。

別のプロンプト: 超飽和色、日没時のフィールド上の花火。超飽和色、日没時のフィールド上の花火。

「とてもカーリーで素晴らしい」 と叫んでいましたが、一部の人々は次のように考えていました:

マルチモーダル AI 作成のための「インフィニティ ストーン」をすべて集めています。

エクストリームです!それ!単純! 1つ!

たとえば、プロンプトを 1 つだけ使用すると、ビデオとサウンド効果を「1 つのポットで作成」できます。:

中世のトランペット奏者 .中世のトランペット奏者。

「編集」 をクリックし、「サウンドエフェクト」## を選択します。 #:

次に、希望するサウンドを説明できます。例:

次に、希望するサウンドを説明できます。例:

その車はエンジンを始動します。その後、わずか数秒で、Pika は説明とビデオに基づいて効果音を生成できます。

6 種類のサウンドから選択できます。! サウンドエフェクト機能は現在、Super Collaborator

(Super Collaborator)と Pro ユーザーに対してのみテスト用に公開されていることに注意してください。 しかし、Pika 氏は次のようにも言いました。「この機能をすぐにすべてのユーザーに公開します!」

今、ネチズンのグループがこのベータ版のテストを開始し、次のように述べています:

音響効果はビデオに非常に適しており、多くの雰囲気を加えています。

原理とは何ですか?

効果音の原理については、Pikaは今回は公表していませんが、Soraが人気になった後、音声スタートアップ企業のEvenLabsが同様の吹き替え機能を制作しています。

当時、NVIDIA のシニア サイエンティスト Jim Fan がこれについてさらに詳細な分析を行いました。

彼は、AI が正確な ビデオからオーディオへのマッピングを学習するには、潜在空間における「暗黙の」物理のモデル化も必要であると考えています。

- カテゴリ、材質、および空間的な位置。

- オブジェクト間の高次の相互作用を認識します。たとえば、それはスティック、金属、またはドラムヘッドですか?どのくらいの速度でぶつかりますか?

- 環境を特定します: それはレストラン、宇宙ステーション、またはイエローストーンパークですか?

- オブジェクトや環境の典型的なサウンド パターンをモデルの内部メモリから取得します。

- 「ソフト」を使用して、学習した物理的ルールを使用して、サウンド パターンのパラメータを組み合わせて調整し、その場でまったく新しいサウンドを作成することもできます。これは、ゲーム エンジンの「プロシージャル オーディオ」に似ています。

- シーンが複雑な場合、モデルはオブジェクトの空間位置に応じて複数のサウンド トラックを重ね合わせる必要があります。

The Sound of Pixels## を推奨しました#:

興味のあるお友達は、記事の最後にあるリンクをクリックして詳細をご覧ください。

興味のあるお友達は、記事の最後にあるリンクをクリックして詳細をご覧ください。

One More Thing

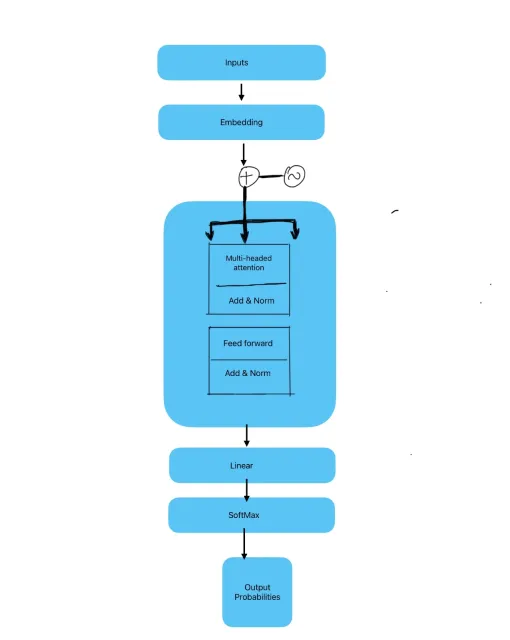

マルチモーダルに関して、最新のインタビューでの LeCun の見解も非常に人気があります。彼は次のように信じています:

言語 (テキスト) は低帯域幅: 12 バイト/秒未満です。最新の LLM は通常、トレーニングに 1x10^13 の 2 バイト トークン (つまり 2x10^13 バイト) を使用します。人間が本を読むには約10万年(1日12時間)かかります。

ビジュアル帯域幅ははるかに高くなります: 約 20MB/秒。 2 本の視神経にはそれぞれ 100 万本の神経線維があり、それぞれが 1 秒あたり約 10 バイトを伝送します。 4 歳児は約 16,000 時間を覚醒状態で過ごします。これはバイトに換算すると約 1x10^15 になります。 視覚のデータ帯域幅は、テキスト言語のデータ帯域幅の約 1,600 万倍です。

4 歳児が目にするデータは、インターネット上で公開されているすべてのテキスト トレーニングの最大の LLM データの 50 倍です。

したがって、LeCun は次のように結論付けました:

したがって、LeCun は次のように結論付けました:

それでは、この見解に同意しますか?

以上がピカの増幅ワザ:今日から映像も効果音も「ワンポット」で制作可能!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

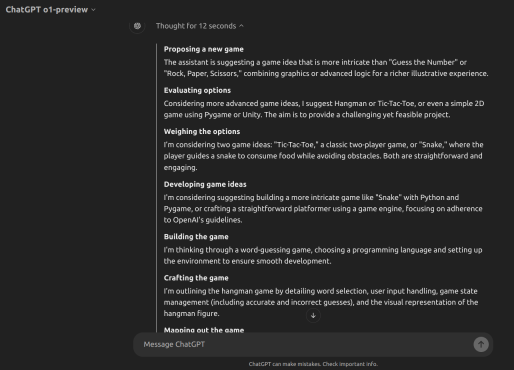

Openai' s o1-preview vs o1-mini:AGIへの一歩Apr 12, 2025 am 10:04 AM

Openai' s o1-preview vs o1-mini:AGIへの一歩Apr 12, 2025 am 10:04 AM導入 9月12日に、Openaiは「LLMSとの推論学習」というタイトルのアップデートをリリースしました。彼らは、複雑な推論タスクに取り組むために補強学習を使用して訓練されたO1モデルを導入しました。このmodを設定するもの

Openai O1でゲームを構築する方法は? - 分析VidhyaApr 12, 2025 am 10:03 AM

Openai O1でゲームを構築する方法は? - 分析VidhyaApr 12, 2025 am 10:03 AM導入 Openai O1モデルファミリは、特に科学、コーディング、問題解決において、推論と経済のパフォーマンスを大幅に進めています。 Openaiの目標は、これまでにない高度なAIとO1モデルを作成することです

顧客クエリ管理のための人気のあるLLMエージェントツールApr 12, 2025 am 10:01 AM

顧客クエリ管理のための人気のあるLLMエージェントツールApr 12, 2025 am 10:01 AM導入 今日、顧客クエリ管理の世界は前例のないペースで動いており、新しいツールが毎日見出しを作っています。大規模な言語モデル(LLM)エージェントは、このコンテキストでの最新のイノベーションであり、CUを後押しします

企業向けの100日生成AI実装計画Apr 12, 2025 am 09:56 AM

企業向けの100日生成AI実装計画Apr 12, 2025 am 09:56 AM導入 生成AIを採用することは、どの企業にとっても変革的な旅になります。ただし、Genaiの実装のプロセスは、しばしば面倒で混乱を招く可能性があります。 Niit Limの会長兼共同設立者であるRajendra Singh Pawar

PIXTRAL 12B対QWEN2-VL-72BApr 12, 2025 am 09:52 AM

PIXTRAL 12B対QWEN2-VL-72BApr 12, 2025 am 09:52 AM導入 AI革命は、テキストからイメージのモデルが芸術、デザイン、テクノロジーの交差点を再定義している創造性の新しい時代を生み出しました。 Pixtral 12bおよびqwen2-vl-72bは、2つの先駆的な力のドリビンです

Paperqaとは何ですか、そしてそれは科学研究をどのように支援しますか?Apr 12, 2025 am 09:51 AM

Paperqaとは何ですか、そしてそれは科学研究をどのように支援しますか?Apr 12, 2025 am 09:51 AM導入 AIの進歩により、科学的研究では大きな変革が見られました。さまざまなテクノロジーやセクターで毎年何百万もの論文が掲載されています。しかし、この情報の海をretrに移動します

Datagemma:幻覚に対するLLMの接地 - 分析VidhyaApr 12, 2025 am 09:46 AM

Datagemma:幻覚に対するLLMの接地 - 分析VidhyaApr 12, 2025 am 09:46 AM導入 大規模な言語モデルは、産業を急速に変革しています。Todayは、銀行業務におけるパーソナライズされたカスタマーサービスからグローバルコミュニケーションのリアルタイム言語翻訳まで、あらゆるものを動かしています。彼らはクエストに答えることができます

CrewaiとOllamaでマルチエージェントシステムを構築する方法は?Apr 12, 2025 am 09:44 AM

CrewaiとOllamaでマルチエージェントシステムを構築する方法は?Apr 12, 2025 am 09:44 AM導入 APIにお金を費やしたくないのですか、それともプライバシーを心配していますか?それとも、LLMSをローカルに実行したいだけですか?心配しないで;このガイドは、ローカルLLMSを使用してエージェントとマルチエージェントフレームワークを構築するのに役立ちます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。