ホームページ >テクノロジー周辺機器 >AI >Stable Diffusion 3 技術レポートがリリース: Sora と同じアーキテクチャの詳細が明らかに

Stable Diffusion 3 技術レポートがリリース: Sora と同じアーキテクチャの詳細が明らかに

- 王林転載

- 2024-03-07 12:01:11862ブラウズ

もうすぐ、「Vincentian グラフィックスの新しい王様」である Stable Diffusion 3 の技術レポートがここに公開されます。

全文は計28ページに及び、誠意が詰まっています。

モデルの機能はさらに改善可能です

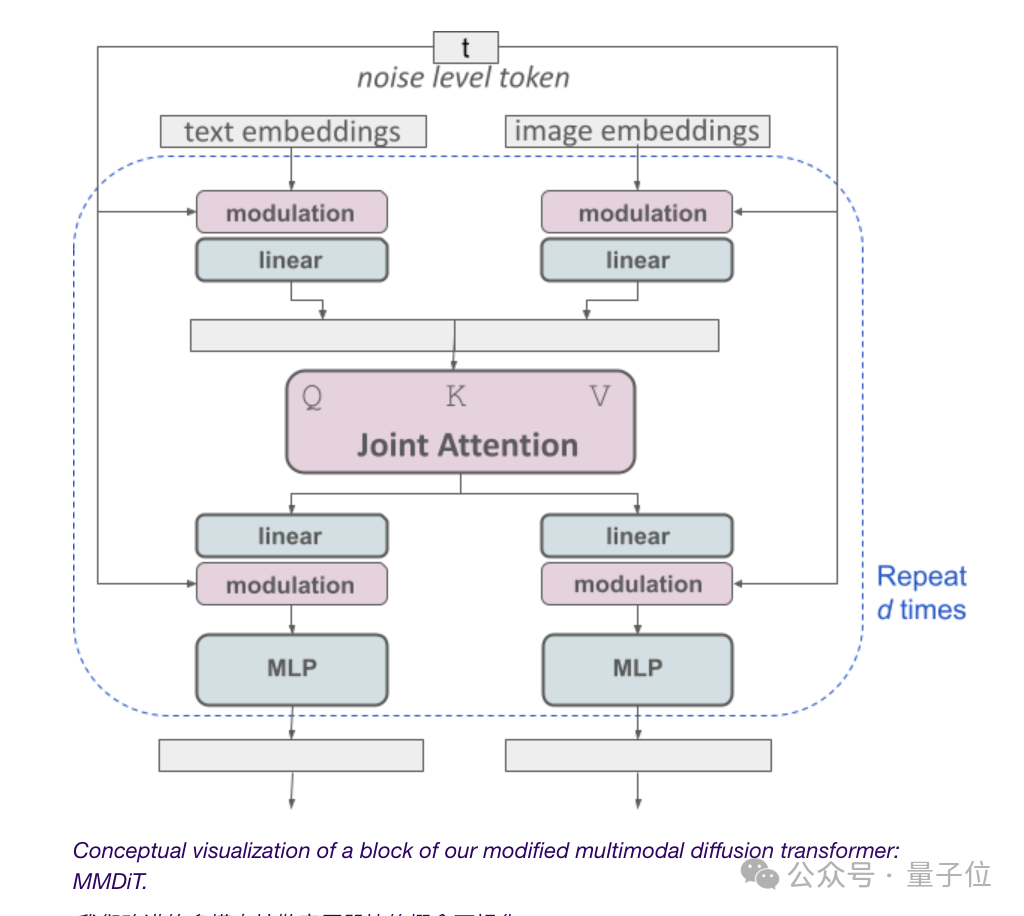

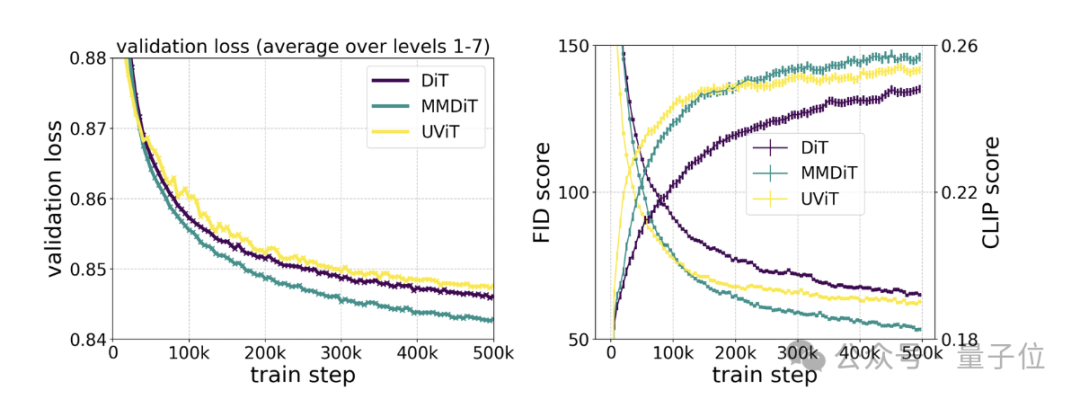

当局は、再重み付けされた RF 手法と MMDiT アーキテクチャを使用したテキストから画像への生成に関するスケーリング研究を実施しました。

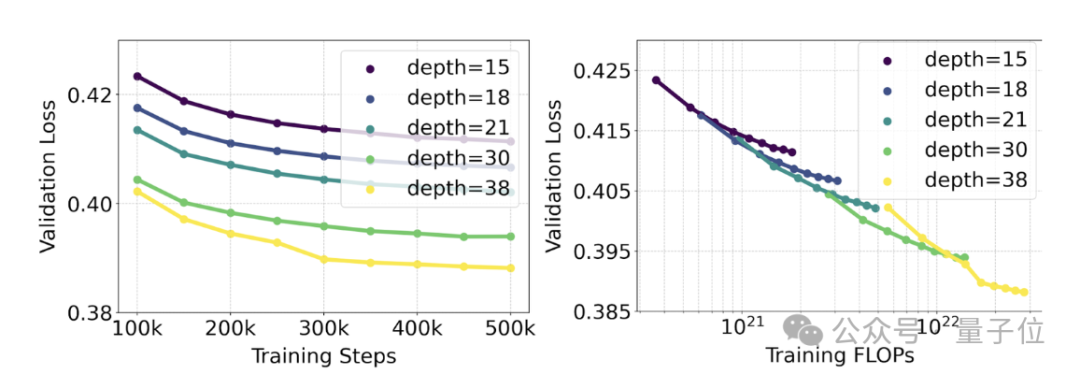

トレーニングされたモデルの範囲は、4 億 5,000 万のパラメーターを含む 15 モジュールから、80 億のパラメーターを含む 38 モジュールまで多岐にわたります。

彼らは、モデルのサイズとトレーニング ステップが増加するにつれて、検証損失が滑らかな下降傾向を示すこと、つまり、モデルが継続的な学習を通じてより複雑なデータに適応することを観察しました。

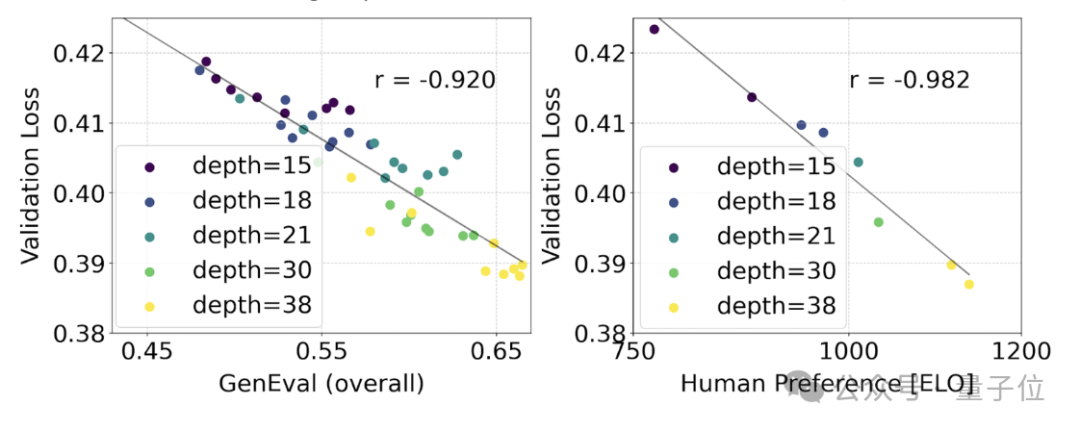

#これがモデル出力のより有意義な改善につながったかどうかをテストするために、自動画像位置合わせメトリクス (GenEval) と人間の評価も行いました。好みの評価 (ELO) 。

結果は次のとおりです:

この 2 つの間には強い相関関係があります。つまり、検証損失は、モデル全体のパフォーマンスを予測するための非常に強力な指標として使用できます。

さらに、ここでの拡張傾向は飽和の兆候を示していないため (つまり、モデル サイズが増加してもパフォーマンスは依然として向上しており、限界に達していません) 、関係者は楽観的です:

SD3 のパフォーマンスは将来的に向上し続ける可能性があります。

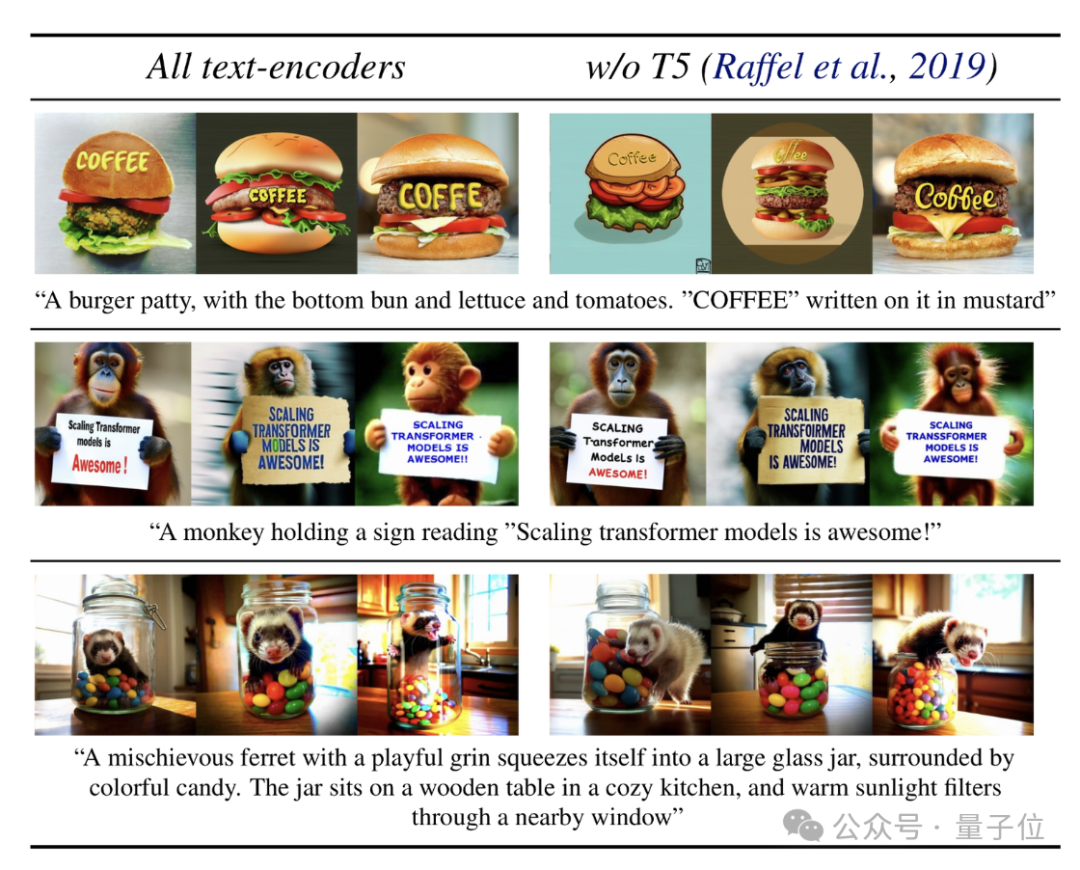

最後に、技術レポートではテキスト エンコーダの問題についても言及しています。

推論に使用されるメモリ集約型の T5 テキスト エンコーダである 47 億パラメータを削除することにより、SD3 のメモリ要件が大幅に削減される可能性があります。削減されましたが、同時にパフォーマンスの損失は非常にわずかです (勝率は 50% から 46% に低下しました)。

ただし、テキスト レンダリング機能の観点から、当局は依然として T5 を削除しないことを推奨しています。これは、T5 がないとテキスト表現の勝率が 38% に低下するためです。

要約すると、SD3 の 3 つのテキスト エンコーダーのうち、テキスト (および非常に詳細なシーン説明画像) を含む画像を生成する場合、T5 が最も大きく貢献します。

ネチズン: オープンソースへの取り組みは予定通り完了しました、ありがとう

SD3レポートが発表されるとすぐに、多くのネチズンはこう言いました:

安定性AIオープンソースへの取り組みが予定通り果たせたことは大変喜ばしいことであり、今後も末永く運営していただきたいと願っています。

OpenAI の名前を発表したばかりの人がまだいます:

さらに嬉しいことです。コメント エリアで言及されている:

SD3 モデルのすべての重みをダウンロードできます。現在の計画では、パラメータは 8 億個、パラメータは 20 億個、パラメータは 80 億個です。

速度はどうですか?

ああ、技術レポートには次のように記載されています:

80 億 SD3 で 24GB RTX 4090 で 1024*1024 画像を生成するには 34 秒かかります (50 サンプリング ステップ)——しかしこれは、最適化を行わない初期の予備的な推論テストの結果にすぎません。

レポートの全文: https://stabilityai-public-packages.s3.us-west-2.amazonaws.com/Stable Diffusion 3 Paper.pdf。

参考リンク:

[1]https://stability.ai/news/stable-diffusion- 3-研究論文。

[2]https://news.ycombinator.com/item?id=39599958。

以上がStable Diffusion 3 技術レポートがリリース: Sora と同じアーキテクチャの詳細が明らかにの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。