EfficientSAM この作品は 5/5/5 の満点を獲得して CVPR 2024 に掲載されました。以下の図に示すように、著者はソーシャル メディアで結果を共有しました。

LeCun Turing Award 受賞者もこの作品を強く推奨しました。

最近の研究で、メタ研究者は、SAM マスキングを使用する新しい改良された方法を提案しました。 (サミ)。このアプローチでは、MAE 事前トレーニング技術と SAM モデルを組み合わせて、高品質の事前トレーニングされた ViT エンコーダーを実現します。 SAMI を通じて、研究者はモデルのパフォーマンスと効率を向上させ、視覚タスクにより良いソリューションを提供しようとしています。この手法の提案は、コンピューター ビジョンとディープ ラーニングの分野をさらに探索し、発展させるための新しいアイデアと機会をもたらします。さまざまな事前トレーニング手法とモデル構造を組み合わせることで、研究者は

- #論文リンク: https://arxiv.org/pdf/2312.00863

- ##コード: github.com/yformer/EfficientSAM

- ホームページ: https://yformer.github.io/efficient-sam/

このアプローチの有効性を検証するために、研究者らはマスクされた画像で事前トレーニングされた転移学習設定を使用しました。具体的には、彼らはまず、画像解像度 224×224 の ImageNet データセット上で再構成損失を含むモデルを事前トレーニングしました。次に、ターゲット タスクからの教師付きデータを使用してモデルを微調整します。この転移学習手法は、モデルが事前トレーニング段階を通じて元のデータから特徴を抽出することを学習しているため、モデルが迅速に学習し、新しいタスクのパフォーマンスを向上させるのに役立ちます。この転移学習戦略は、大規模なデータセットで学習した知識を効果的に利用し、モデルをさまざまなタスクに適応させることを容易にします。 、ViT-Tiny/-Small/-Base などの ImageNet-Train モデルで 1K で使用でき、汎化パフォーマンスが向上します。 ViT-Small モデルの場合、ImageNet-1K で 100 回の微調整を行った後、研究者らは 82.7% のトップ 1 精度を達成しました。これは、他の最先端の画像事前トレーニング ベースラインよりも優れています。

研究者らは、ターゲットの検出、インスタンスのセグメンテーション、セマンティック セグメンテーションに関して事前トレーニングされたモデルを微調整しました。これらすべてのタスクにおいて、私たちの方法は他の事前トレーニングされたベースラインよりも優れた結果を達成し、さらに重要なことに、小さなモデルで大幅な向上を達成します。

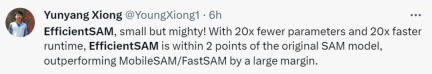

この論文の著者である Yunyang Xiong 氏は、「この記事で提案されている EfficientSAM パラメータは 20 分の 1 に削減されていますが、実行時間は 20 倍高速です。オリジナルとの違い」と述べています。 SAM モデルはわずか 2 パーセント ポイント以内であり、MobileSAM/FastSAM よりも大幅に優れています。

#デモ デモンストレーションでは、写真内の動物をクリックすると、EfficientSAM がオブジェクトをすばやくセグメント化できます。

EfficientSAM は、写真内の人物を正確に識別することもできます:

トライアル アドレス: https: //ab348ea7942fe2af48.gradio.live/

メソッド

メソッド

EfficientSAM には 2 つのステージが含まれています。1) ImageNet での SAMI の事前トレーニング (上)。 2) SA-1B で SAM を微調整します (下)。

EfficientSAM には主に次のコンポーネントが含まれています:

クロスアテンション デコーダ: SAM 機能の監視の下で、この文書では次のことが観察されます。マスク トークンのみがデコーダによって再構築される必要があり、エンコーダの出力は再構築プロセス中にアンカーとして機能します。クロスアテンション デコーダーでは、クエリはマスクされたトークンから取得され、キーと値はエンコーダーからのマスクされていない特徴とマスクされた特徴から導出されます。この論文では、クロスアテンション デコーダーのマスクされたトークンからの出力特徴と、MAE 出力埋め込み用のエンコーダーからのマスクされていないトークンの出力特徴をマージします。これらの結合された特徴は、最終的な MAE 出力内の入力画像トークンの元の位置に並べ替えられます。

リニアプロジェクションヘッド。次に、エンコーダとクロスアテンション デコーダを通じて取得した画像出力を小さなプロジェクト ヘッドに入力し、SAM 画像エンコーダの機能を調整しました。簡単にするために、このペーパーでは、SAM 画像エンコーダーと MAE 出力の間の特徴寸法の不一致を解決するために線形投影ヘッドのみを使用します。

復興損失。各トレーニング反復では、SAMI には、SAM 画像エンコーダーからの前方特徴抽出と、MAE の順方向および逆方向伝播プロセスが含まれます。 SAM 画像エンコーダと MAE 線形投影ヘッドからの出力を比較して、再構成損失を計算します。

事前トレーニング後、エンコーダーはさまざまな視覚的タスクの特徴表現を抽出でき、デコーダーも破棄されます。特に、任意のセグメンテーション タスク用の効率的な SAM モデルを構築するために、この論文では、EfficientSAM の画像エンコーダおよび SAM のデフォルト マスク デコーダとして、SAMI の事前トレーニング済み軽量エンコーダ (ViT-Tiny や ViT-Small など) を採用します。 、図 2 (下) に示すように。この論文では、SA-1B データセット上の EfficientSAM モデルを微調整して、あらゆるタスクのセグメンテーションを実現します。

実験

画像分類。画像分類タスクにおけるこの方法の有効性を評価するために、研究者らは SAMI のアイデアを ViT モデルに適用し、ImageNet-1K でのパフォーマンスを比較しました。

#表 1 に示すように、SAMI は、MAE、iBOT、CAE、BEiT などの事前トレーニング手法、および DeiT や SSTA などの蒸留手法と比較されています。

SAMI-B のトップ 1 精度は 84.8% に達し、事前トレーニングされたベースライン、MAE、DMAE、iBOT、CAE、BEiT よりも高くなっています。 SAMI は、DeiT や SSTA などの蒸留法と比較して大きな改善も示しています。 ViT-Tiny や ViT-Small などの軽量モデルの場合、SAMI の結果は、DeiT、SSTA、DMAE、MAE と比較して大幅な向上を示しています。

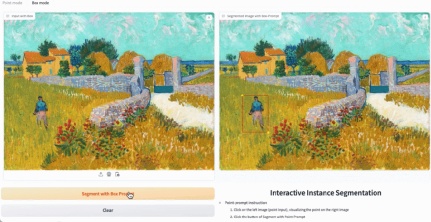

オブジェクトの検出とインスタンスのセグメンテーション。この論文では、SAMI で事前トレーニングされた ViT バックボーンをダウンストリームのオブジェクト検出タスクとインスタンス セグメンテーション タスクまで拡張し、それを COCO データセットで事前トレーニングされたベースラインと比較します。表 2 に示すように、SAMI は他のベースラインのパフォーマンスを常に上回っています。

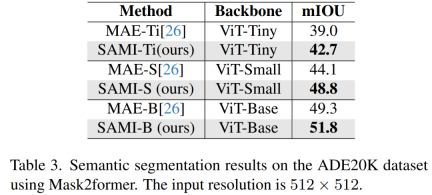

セマンティック セグメンテーション。このペーパーでは、事前トレーニングされたバックボーンをさらにセマンティック セグメンテーション タスクに拡張して、その有効性を評価します。結果を表 3 に示します。SAMI の事前トレーニングされたバックボーンを使用した Mask2former は、MAE の事前トレーニングされたバックボーンを使用した場合よりも、ImageNet-1K 上でより優れた mIoU を達成します。これらの実験結果は、この論文で提案された技術がさまざまな下流タスクにうまく一般化できることを証明しています。

#表 4 では、EfficientSAM と SAM、MobileSAM、および SAM-MAE-Ti を比較しています。 COCO では、EfficientSAM-Ti が MobileSAM を上回ります。 EfficientSAM-Ti には SAMI で事前トレーニングされた重みがあり、MAE で事前トレーニングされた重みよりも優れたパフォーマンスを発揮します。

#表 4 では、EfficientSAM と SAM、MobileSAM、および SAM-MAE-Ti を比較しています。 COCO では、EfficientSAM-Ti が MobileSAM を上回ります。 EfficientSAM-Ti には SAMI で事前トレーニングされた重みがあり、MAE で事前トレーニングされた重みよりも優れたパフォーマンスを発揮します。

さらに、EfficientSAM-S は、COCO ボックスの SAM よりも 1.5 mIoU 低いだけで、LVIS ボックスの SAM より 3.5 mIoU 低く、パラメーターが 20 分の 1 です。この論文では、EfficientSAM が MobileSAM や SAM-MAE-Ti と比較して、複数のクリックでも優れたパフォーマンスを示していることもわかりました。

#表 5 に、ゼロショット インスタンス セグメンテーションの AP、APS、APM、および APL を示します。研究者らは EfficientSAM を MobileSAM および FastSAM と比較しました。その結果、FastSAM と比較して、EfficientSAM-S は COCO で 6.5 を超える AP、LVIS で 7.8 AP を超える AP を獲得したことがわかります。 EffidientSAM-Ti の場合、FastSAM よりも大幅に優れており、COCO では 4.1 AP、LVIS では 5.3 AP ですが、MobileSAM では COCO では 3.6 AP、LVIS では 5.5 AP です。

さらに、EfficientSAM は FastSAM よりもはるかに軽量であり、efficientSAM-Ti のパラメータは 9.8M であるのに対し、FastSAM のパラメータは 68M です。

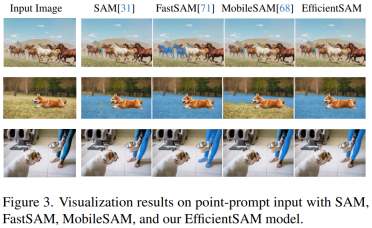

図 3、4、および 5 は、読者が EfficientSAM のインスタンス セグメンテーション機能を補足的に理解できるように、定性的な結果をいくつか示しています。

##研究の詳細については、元の論文を参照してください。

##研究の詳細については、元の論文を参照してください。

以上がVPR 2024 満点用紙! Meta は EfficientSAM を提案しています。すべてを素早く分割します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

外挿の包括的なガイドApr 15, 2025 am 11:38 AM

外挿の包括的なガイドApr 15, 2025 am 11:38 AM導入 数週間で作物の進行を毎日観察する農民がいるとします。彼は成長率を見て、さらに数週間で彼の植物がどれほど背が高くなるかについて熟考し始めます。 thから

ソフトAIの台頭とそれが今日のビジネスにとって何を意味するかApr 15, 2025 am 11:36 AM

ソフトAIの台頭とそれが今日のビジネスにとって何を意味するかApr 15, 2025 am 11:36 AMソフトAIは、おおよその推論、パターン認識、柔軟な意思決定を使用して特定の狭いタスクを実行するように設計されたAIシステムとして定義されていますが、曖昧さを受け入れることにより、人間のような思考を模倣しようとします。 しかし、これはBusineにとって何を意味しますか

AIフロンティア向けの進化するセキュリティフレームワークApr 15, 2025 am 11:34 AM

AIフロンティア向けの進化するセキュリティフレームワークApr 15, 2025 am 11:34 AM答えは明確です。クラウドコンピューティングには、クラウドネイティブセキュリティツールへの移行が必要であるため、AIはAIの独自のニーズに特化した新しい種類のセキュリティソリューションを要求します。 クラウドコンピューティングとセキュリティレッスンの台頭 で

3つの方法生成AIは起業家を増幅します:平均に注意してください!Apr 15, 2025 am 11:33 AM

3つの方法生成AIは起業家を増幅します:平均に注意してください!Apr 15, 2025 am 11:33 AM起業家とAIと生成AIを使用して、ビジネスを改善します。同時に、すべてのテクノロジーと同様に、生成的AIが増幅器であることを覚えておくことが重要です。厳密な2024年の研究o

Andrew Ngによる埋め込みモデルに関する新しいショートコースApr 15, 2025 am 11:32 AM

Andrew Ngによる埋め込みモデルに関する新しいショートコースApr 15, 2025 am 11:32 AM埋め込みモデルのパワーのロックを解除する:Andrew Ngの新しいコースに深く飛び込む マシンがあなたの質問を完全に正確に理解し、応答する未来を想像してください。 これはサイエンスフィクションではありません。 AIの進歩のおかげで、それはRになりつつあります

大規模な言語モデル(LLMS)の幻覚は避けられませんか?Apr 15, 2025 am 11:31 AM

大規模な言語モデル(LLMS)の幻覚は避けられませんか?Apr 15, 2025 am 11:31 AM大規模な言語モデル(LLM)と幻覚の避けられない問題 ChatGpt、Claude、GeminiなどのAIモデルを使用した可能性があります。 これらはすべて、大規模なテキストデータセットでトレーニングされた大規模な言語モデル(LLMS)、強力なAIシステムの例です。

60%の問題 - AI検索がトラフィックを排出する方法Apr 15, 2025 am 11:28 AM

60%の問題 - AI検索がトラフィックを排出する方法Apr 15, 2025 am 11:28 AM最近の研究では、AIの概要により、産業と検索の種類に基づいて、オーガニックトラフィックがなんと15〜64%減少する可能性があることが示されています。この根本的な変化により、マーケティング担当者はデジタルの可視性に関する戦略全体を再考することになっています。 新しい

AI R&Dの中心に人間が繁栄するようにするMITメディアラボApr 15, 2025 am 11:26 AM

AI R&Dの中心に人間が繁栄するようにするMITメディアラボApr 15, 2025 am 11:26 AMElon UniversityがDigital Future Centerを想像している最近のレポートは、300人近くのグローバルテクノロジーの専門家を調査しました。結果のレポート「2035年に人間である」は、ほとんどがTを超えるAIシステムの採用を深めることを懸念していると結論付けました。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

SublimeText3 中国語版

中国語版、とても使いやすい

Dreamweaver Mac版

ビジュアル Web 開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター