ホームページ >テクノロジー周辺機器 >AI >Princeton DeepMind は数学を使用して、LLM がランダムなオウムではないことを証明しました。 「規模が大きいほど能力は強い」には理論的根拠がある

Princeton DeepMind は数学を使用して、LLM がランダムなオウムではないことを証明しました。 「規模が大きいほど能力は強い」には理論的根拠がある

- 王林転載

- 2024-02-19 09:30:25931ブラウズ

今日の物語の主人公は、サンジーブ・アローラとアニルード・ゴヤルという二人の科学者です。

Arora はプリンストン大学の出身で、Goyal は Google DeepMind の出身です。

彼らは集まって、ただ 1 つの疑問を探求したいと考えていました。

つまり、LLM はおしゃべりするだけのランダムなオウムなのでしょうか、それとも本当に何かを学習し、新たな機能を備えたインテリジェントなエージェントに変身したのでしょうか?

AI の先駆者であるヒントン氏とン エンダ氏もこの問題について話し合いましたが、その時点では明確な結論は得られませんでした。

ヒントン氏は、この問題で合意に達できない場合、AIがもたらす可能性のある潜在的な害についても合意に達することが困難になると指摘した。

Arora と Goyal は、LLM は単に機械的な反復学習を模倣するものではないと考えています。彼らは、LLM の出力コンテンツが大量のトレーニング データから単にランダムに生成されるわけではなく、この点はさらに検討する価値があると指摘しました。

2 人がこの論文を共同執筆しました。

論文アドレス: https://arxiv.org/abs/2307.15936

真実は次のとおりです。広範なトレーニングの後、LLM の規模はますます大きくなり、関連する機能が効果的に向上し、新しい機能が開発されます。

これは、通常の並べ替えや組み合わせでは実行できるものではありません。

大規模モデルの「大」

ご存知のとおり、LLM は「ニューロン」を 1 つずつ接続する巨大な人工ニューラル ネットワークです。 1つ。

実際、ここで話しているのはモデルのパラメーターです。パラメータが多いほど、LLM は大きくなります。

まず、LLM トレーニングのメカニズムとリンクについて理解しましょう。

トレーニング プロセスには次のリンクが含まれます。LLM に 1 つの文を提供し、最後の単語を非表示にして、空いている語彙が誰であるかを LLM に確率に基づいて予測させます。

LLM が 1000 個の単語を知っている場合、1000 個の確率が生成されます。最後に、最も確率が高いものを選択して記入してください。

最初、LLM は正しい単語を選択できない可能性があり、アルゴリズムは損失値、つまり高次元の数学空間における最初の答えを返します。 LLM によって与えられる、元の答えと同じ、文の正解間の「距離」を計算し、この値を使用してパラメーターを微調整します。

その後、同じ文について、LLM はより正確な確率分布を計算することができ、上記の損失値はわずかに減少します。

このようにして、LLM の全体的な損失値が悪くないレベルに低下するまで、トレーニング データ内の何十億もの文がこのプロセスで実行されます。

LLM のテストも同様にこのプロセスに従い、損失値に基づいてテスト結果が得られます (もちろん、テストに使用された文は学習データには絶対に含まれません) 、そうでない場合は不正行為ではありません)。

トレーニングとテストの後、LLM は、新しいテキスト プロンプトに遭遇したときに、最も正しい単語を生成する可能性が高くなります。単語が出てくると、それがプロンプトにスローされ、次の単語が生成されます。

ゆっくりと生成され、一見一貫した答えが紙に現れました。

ただし、このプロセスでは、推論が必要な質問に対して、規模の大きい LLM のパフォーマンスが向上するという兆候はありません。

思考の流れに注意してください。示唆はありません。つまり、この結果を示すことができる経験的証拠はありませんが、表面的な事実から判断すると、この結論は次のとおりです。正しい。

言い換えれば、大規模な LLM は、推論能力の点で小規模なモデルよりも優れたパフォーマンスを発揮します。違いはスケールのみです。

アローラは混乱していますが、この能力はどこから来たのでしょうか?

これは、Arora と Goyal の研究の出発点であり、これらの新しい機能がどのように出現するかを分析するための理論的枠組みを構築しようとしています。

そこで彼らは数学の分野に注目し、ランダムグラフと呼ばれるものに狙いを定めました。簡単に言えば、この用語はグラフ理論と確率理論の交差点にあります。

ランダム グラフでは、2 つのノード間を接続するエッジがあるかどうかは、コインを投げるのと同じようにランダムです。

コインが表で投げられた場合、確率 p の片面が存在します。

p の値が変化すると、ランダム グラフ全体のプロパティが突然変化する可能性があります。たとえば、p 値が特定のしきい値を超えると、いくつかの孤立したノード (つまり、他のノードに接続されていない点) が突然消えます。

2 人の科学者は、ランダム グラフのこの機能が大規模な言語モデルをシミュレートする直感的な方法になる可能性があることに気づきました。

ニューラル ネットワークの複雑さは言葉では言い表すことができず、分析はほとんど困難ですが、ランダム グラフの概念は数学者によって長い間研究されており、分析のためのさまざまなツールが開発されてきました。

おそらく、ニューラル ネットワークの研究者は、ランダム グラフの関連理論を通じて、大規模な言語モデルのいくつかの特性を理解して分析することを試みることができます。

ここで、2 人の研究者は、2 種類のノードを含む二部グラフに焦点を当てました。

彼らのモデルでは、1 つのタイプのノードがテキストの断片を表します。ここでのフラグメントの長さは少なくとも 1 段落でなければならず、単一の単語ではなく、数ページの長さになる場合もあることに注意してください。

このようなノードは直線を形成します。

2 番目のタイプのノードは、上記のテキストを理解するために必要なスキルを表します。たとえば、論理的な関係を理解すること、または計算する能力、より具体的には皮肉を理解する能力です。

これらの例を示す目的は、この 2 番目のタイプのノードがさまざまな機能を表し、それらのすべてが含まれていることを明確にすることです。

Arora 氏は、LLM が特定のテキストに皮肉が含まれていることを認識できれば、全体的な理解が大きく変わる可能性があると述べました。

ただし、上で述べたように、2 番目のタイプのノードによって表される機能は、トレーニング プロセス中の LLM の目的がこれらの機能を実現することであることを意味するものではありません。言い換えれば、LLM はトレーニング中に次に考えられる単語を予測する能力のみをトレーニングします。

言い換えると、2 番目のタイプのノードによって表される機能は、LLM によって表示される機能をよりよく理解するために、結果の観点から Arora と Goyal によって設計されました。

セットアップ後、2 種類のノードが相互に接続し始めます。この接続は、LLM がテキストの特定の段落を理解するために必要な機能を表します。それは 1 対 1 の場合もあれば、1 対多の場合もあれば、多対 1 の場合もあります。

皮肉を理解する例を考えてみましょう。このスキル ポイントは、皮肉の要素を含むすべてのテキストとのつながりを確立します。

接続はそれほど単純ではありません。 OpenAI や DeepMind のような大企業は、トレーニング データやテスト データを公開しません。したがって、2 人の研究者はこれらを信頼することはできません。

さらに、彼らが理解したいのは、規模、行動、能力の関係です。

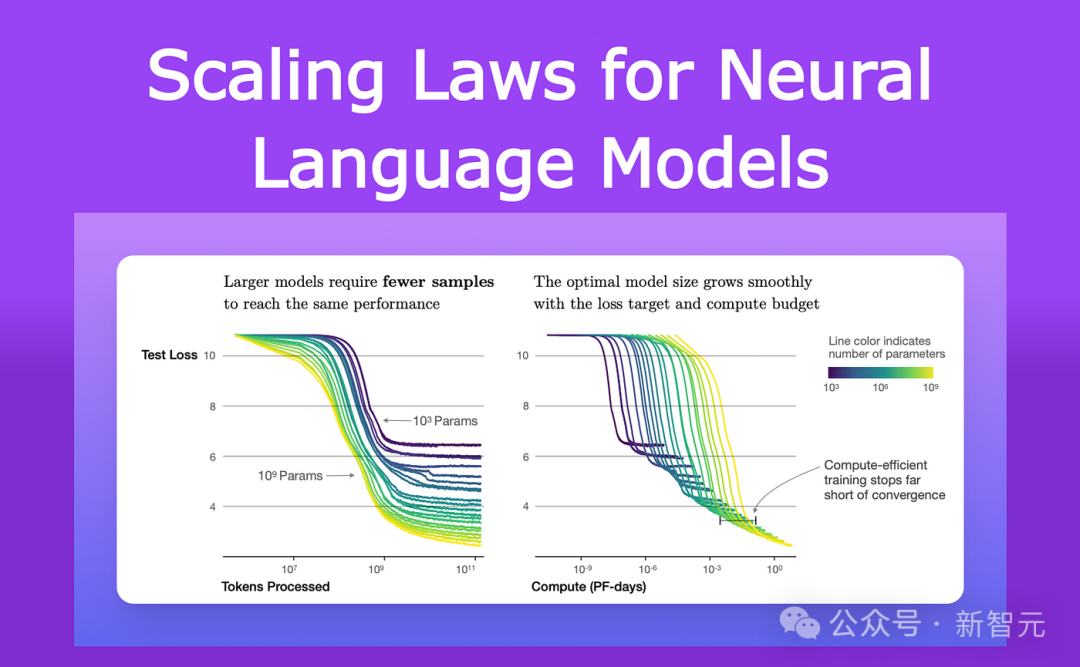

2021 年以来、LLM やその他のニューラル ネットワークのパフォーマンスを研究している研究者は、ある共通の特性を観察しています。

彼らは、モデルがサイズとトレーニング データの量の両方で大きくなるにつれて、テスト データ (トレーニング後の新しいテキストの予測、正解との違い) が失われることに気づきました。 ) は非常に特殊な方法で減少します。

これらの観察結果は、ニューラル スケーリング則と呼ばれる方程式にエンコードされています。

したがって、Arora と Goyal は、自分たちの理論は単一の LLM ケースや特定のトレーニング データとテスト データのセットに依存していないと述べました。 、それはある種の普遍的な法則、つまりスケーリングの法則によって予測される損失です。

彼らのさらなる研究の鍵は、ニューラル スケーリング則と上で紹介した 2 部グラフとの関係です。

二部グラフの借用

まず、研究者は、テスト データ上の LLM の動作に対応する二部グラフが存在すると仮定します。

LLM の損失変化をテスト データ上で利用するために、彼らは LLM がどのようにスキルを獲得するかを記述する次の方法を想像しました。

アイロニーを理解できるスキルを例として考えてみましょう -

この概念はスキル ノードで表されるため、研究者はどのテキスト ノードがこれに該当するかを調べました。スキルノードは に接続されています。

これらの接続されたテキスト ノードのほとんどすべてが成功した場合、つまり、この特定のスキルによって表されるテキストの LLM の予測が非常に正確であることを意味し、LLM はこの特定のスキルに優れています。

ただし、特定の割合を超えるスキル ノードが失敗したテキスト ノードに接続されている場合、LLM はこのスキルで失敗します。

これらの 2 部グラフと LLM 間の接続により、Arora と Goyal はランダム グラフ理論のツールを使用して LLM の動作を分析できるようになります。

これらのグラフを研究すると、ノード間の特定の関係が明らかになります。これらの関係は、大規模な言語モデルがどのようにして予期しない機能を獲得するかを説明する論理的でテスト可能な方法に変換されます。

ここで、Arora と Goyal は最初に重要な動作、つまりなぜ大規模な LLM が比較的小規模なモデルよりも個々のスキルに習熟しているのかについて説明します。

彼らは、ニューラル スケーリングの法則によって予測されるより低いテスト損失から開始しました。

失敗したテスト ノードが少ない場合は、失敗したテスト ノードとスキル ノード間の接続が少ないことを意味します。したがって、成功したテスト ノードに接続されているスキル ノードが多いほど、モデルのスキルの機能が向上していることを示します。

次に、2 人の研究者は、より大きなモデルによって得られる能力を説明する方法を発見しました。LLM のサイズが増加し、テスト損失が減少するにつれて、スキル ノードの開始接続のランダムな組み合わせが増加します。個々のテキストノードに。

これは、LLM が複数のスキルを同時に使用することにも優れており、これらの正確なスキルの組み合わせがどのテキストにも含まれていない場合でも、複数のスキルを使用してテキストを生成し始めたことを示しています。トレーニングデータが表示されました。

たとえば、LLM はすでに 1 つのスキルを使用してテキストを生成できますが、LLM のパラメータまたはトレーニング データの数を一桁増やすと、それは同等になります。 2 つのスキル テキストを必要とするテキストの生成が得意です。

類推すると、また桁違いに、LLM は 4 つのスキルを必要とするタスクを同時に実行できるようになりました。また、各能力の熟練度も同様である。

したがって、大規模な LLM では、スキルを組み合わせる方法がより多くなり、LLM 自体のパフォーマンスが大幅に向上します。

LLM が大きくなるにつれて、トレーニング データ内でこれらすべてのスキルの組み合わせに遭遇する可能性はますます小さくなり、最終的には 0 になります。

ランダム グラフ理論のルールによれば、各組み合わせは可能なスキルのランダム サンプリングから得られます。したがって、グラフ内に約 1,000 の基本的な単一スキル ノードがあり、4 つのスキルを組み合わせたいとすると、約 1,000 の 4 乗通りになり、組み合わせは完全に 1 兆通りになります。

言い換えれば、LLM が 1,000 のスキルのうち 4 つを組み合わせてこれらのタスクを実際に実行できる場合、モデルには汎化機能などが必要であることを意味します。さらに、モデルにはおそらくランダムなオウムではありません。

しかし、Arora と Goyal は、理論を超えて、規模とトレーニング データが増加するにつれて、LLM はより多くのスキルをうまく組み合わせることができるようになり、一般に文化の観点からパフォーマンスが向上するという考えをテストしたいと考えていました。 。

彼らはチームの他のメンバーと協力して、複数のスキルを使用してテキストを生成する LLM の能力を評価するスキル ブレンディングと呼ばれる方法を設計しました。

LLM をテストするために、研究チームは、ランダムに選択されたトピックに関する 3 つの文を生成するよう LLM に依頼しました。これらの文の生成により、LLM のランダムに選択されたスキル ポイントが初めて実証されました。

たとえば、GPT-4 に剣術に関する記事を書くよう依頼し、モデルに自己バイアス、メタファー、統計、物理学の 4 つの分野のスキルをデモンストレーションするよう依頼しました。習得を試みます。

GPT-4 の出力は次のようになります:

このダンス ウィズ スティールでは、(比喩を使用するために) 確かに私の勝利です。物体は自由に落下します (物理実験を使用)。

そして、ほとんどの人が私を知っているように、有名なデュエリストとして、私は自然に柔軟です(統計を使用)。失敗?それは私の欠点(自己バイアス)のせいではなく、戦場が敵側に傾いているからにほかなりません。

実際の結果は、数学的に予測されるように、GPT-4 が GPT-3.5 をはるかに上回っています。

Arora は大胆な推測をします。GPT-4 をはるかに超えるモデルは 1 年以内に登場するでしょうか?

以上がPrinceton DeepMind は数学を使用して、LLM がランダムなオウムではないことを証明しました。 「規模が大きいほど能力は強い」には理論的根拠があるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。