ホームページ >テクノロジー周辺機器 >AI >AI読心技術が進化!メガネがボストンのロボット犬を直接制御し、脳制御ロボットを実現

AI読心技術が進化!メガネがボストンのロボット犬を直接制御し、脳制御ロボットを実現

- 王林転載

- 2024-02-07 08:15:281471ブラウズ

以前の AI 読心スキルをまだ覚えていますか?最近、「あなたの願いをすべて叶える」能力が再び進化しました

-人間が自らの思考でロボットを直接制御できるようになりました!

MIT 研究者は Ddog プロジェクトをリリースしました。彼らは、ボストン・ダイナミクスのロボット犬スポットを制御するためのブレイン・コンピューター・インターフェース(BCI)デバイスを独自に開発した。

犬は人間の思考に従って、特定の場所に移動したり、人間が物を手に入れるのを手伝ったり、写真を撮ったりすることができます。

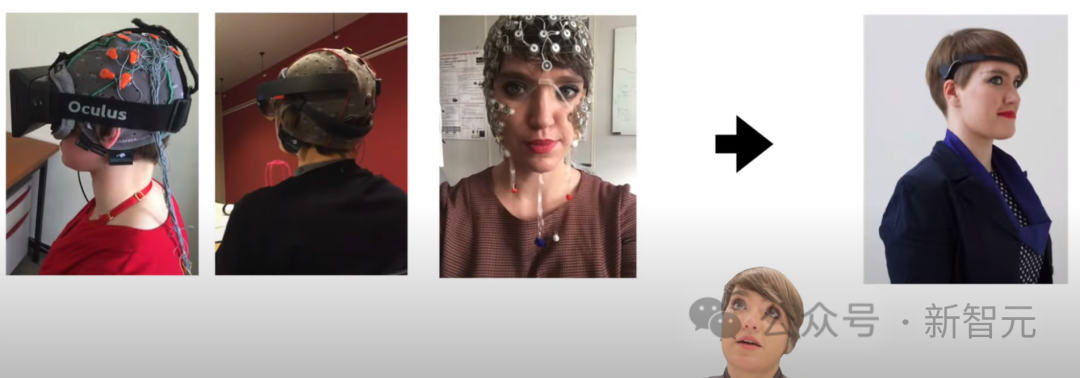

以前は「心を読む」ために多くのセンサーを備えたヘッドギアを使用する必要があったのに対し、今回は脳とコンピューターのインターフェースデバイスがワイヤレスメガネの形で提供されます (AttentivU) 。

ビデオで示されている動作は単純ですが、このシステムの目的は、Spot を ALS、脳性麻痺、脊髄性麻痺などの病気を持つ人々を助けるための基本的なコミュニケーション ツールに変えることです。紐の損傷。

必要なのは 2 台の iPhone とメガネだけで、絶望的な人々に実際的な助けとケアを届けることができます。

そして、関連論文でわかるように、このシステムは実際には非常に複雑なエンジニアリングに基づいて構築されています。

論文アドレス: https://doi.org/10.3390/s24010080

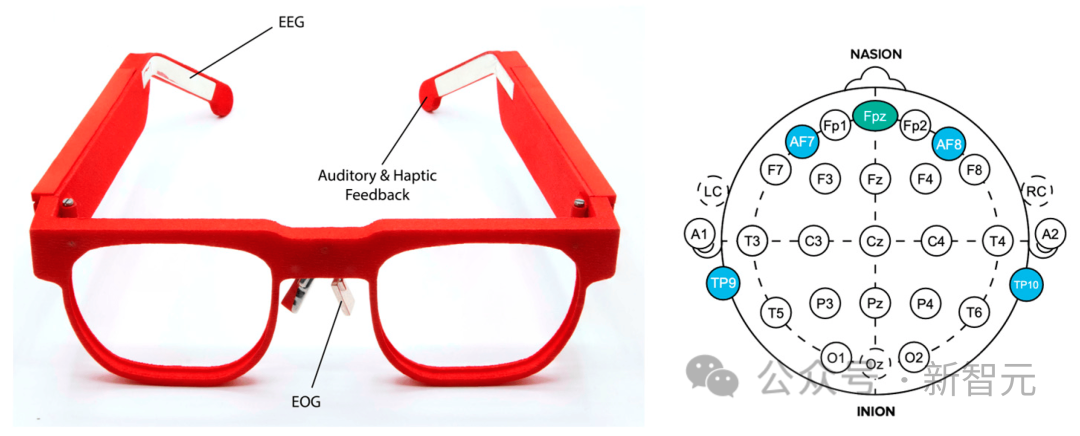

Ddog の使用法システム AttentivU は、人の脳波 (EEG)、つまり脳の活動、および眼電図、つまり目の動きを測定するフレームにセンサーが埋め込まれたブレイン コンピューター インターフェイス システムです。

この研究の基盤は、MIT の Brain Switch です。これは、ユーザーが非言語的かつリアルタイムで介護者とコミュニケーションできるようにするリアルタイムの閉ループ BCI です。

Ddog システムの成功率は 83.4% であり、パーソナル アシスタントのユースケースにおいて、ワイヤレスの非ビジュアル BCI システムが Spot と統合されたのは初めてです。

ビデオでは、ブレイン インターフェイス デバイスの進化と開発者の考えの一部を見ることができます。

これに先立って、研究チームはブレイン・コンピューター・インターフェースとスマートホーム間の相互作用を完了し、現在、移動して操作できるロボットの制御を完了しています。

これらの研究は、特別なグループに一筋の光を与え、彼らに生存の希望を与え、将来的にはより良い生活を送れるようにすることさえ可能にしました。

タコのようなセンサーヘッドギアと比べると、下のメガネのほうが断然カッコいいです。

国立希少疾患機関によると、現在米国には 30,000 人の ALS 患者がおり、それぞれ推定 5,000 人の新規症例が診断されています。年。さらに、脳性麻痺ガイドによると、約 100 万人のアメリカ人が脳性麻痺を患っています。

これらの人々の多くは、歩くこと、服を着ること、話すこと、書くこと、さらには呼吸する能力を失っているか、最終的には失うことになります。

コミュニケーション補助装置は存在しますが、ほとんどはユーザーがコンピュータを使用してコミュニケーションできるようにする視線装置です。ユーザーが周囲の世界と対話できるシステムは多くありません。

この BCI 四足ロボット システムは初期のプロトタイプとして機能し、最新のパーソナル アシスタント ロボットの将来の開発への道を切り開きます。

今後のバージョンではさらに素晴らしい機能が登場することを願っています。

脳制御四足ロボット

この研究では、研究者たちは、ワイヤレスおよびウェアラブル BCI デバイスが四足ロボットをどのように制御できるかを調査します ——Boston Dynamicsスポット。

研究者らが開発した装置は、メガネのフレームに埋め込まれた電極を通じてユーザーの脳波(EEG)と眼電図(EOG)の活動を測定する。

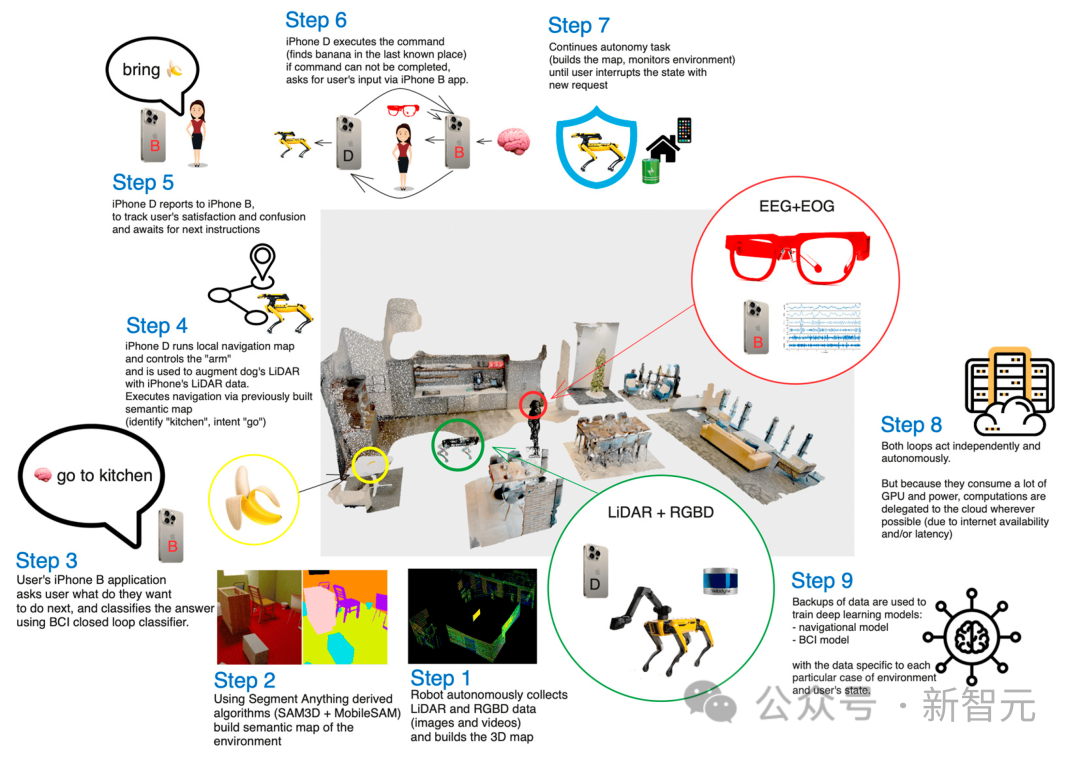

ユーザーは心の中で一連の質問 (「はい」または「いいえ」) に答えます。各質問は、事前に設定された一連のスポット操作に対応します。

たとえば、Spot に部屋の中を歩き、物体 (水の入ったボトルなど) を拾い上げ、ユーザーに代わってそれを取得するように指示します。

ロボットとBCI

今日に至るまで、EEGは最も実用的で応用可能な非侵襲性のブレインコンピューターインターフェース手法の1つです。

BCI システムは、内因性 (自発的) または外因性 (誘発) シグナルを使用して制御できます。

外因性ブレインコンピューターインターフェースでは、人が視覚や聴覚の合図などの外部刺激に注意を払うと、誘発信号が発生します。

このアプローチの利点には、最小限のトレーニングと最大 60 ビット/分の高ビットレートが含まれますが、これにはユーザーが常に刺激に集中する必要があるため、実際の使用は制限されます。生活状況の適用性。さらに、ユーザーは外因性 BCI を使用するとすぐに疲れてしまいます。

内因性ブレイン コンピューター インターフェイスでは、制御信号は外部刺激とは独立して生成され、ユーザーがオンデマンドで完全に実行できます。これにより、感覚障害のあるユーザーにとって、より自然で直感的な対話方法が提供され、ユーザーが自発的にシステムにコマンドを発行できるようになります。

ただし、この方法では通常、より長いトレーニング時間が必要となり、ビット レートが低くなります。

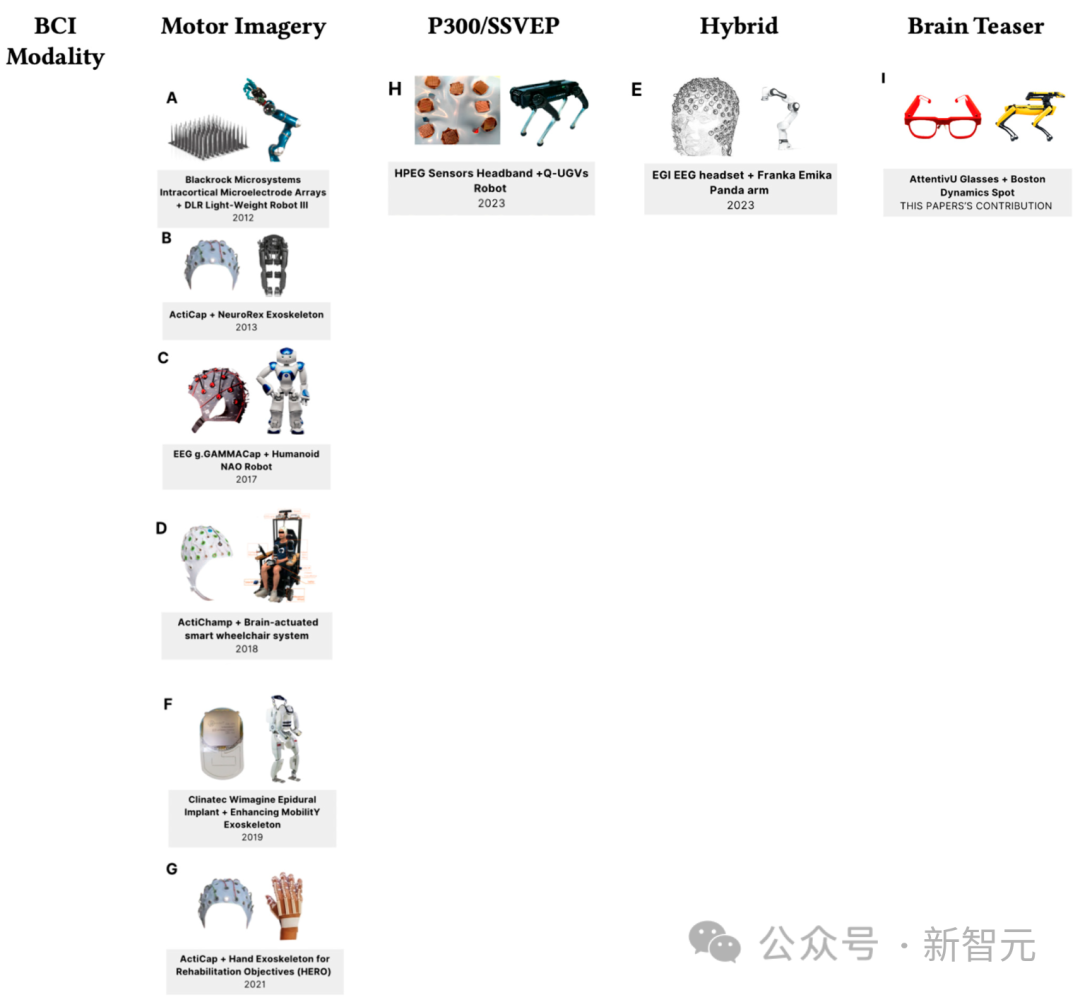

ブレイン コンピューター インターフェイスを使用するロボット アプリケーションは、多くの場合、支援を必要とする人々向けであり、車椅子や外骨格が含まれることがよくあります。

下の図は、2023 年現在のブレイン コンピューター インターフェイスとロボット技術の最新の進歩を示しています。

四足ロボットは、複雑な作業環境や防衛用途でユーザーをサポートするためによく使用されます。

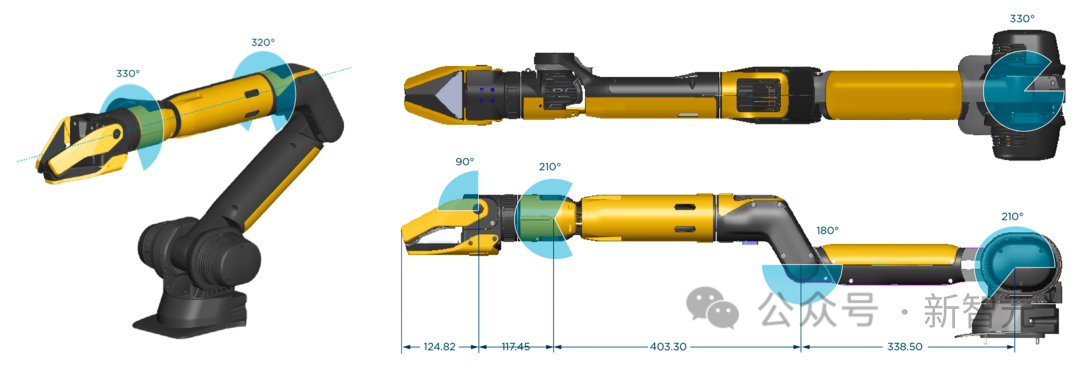

最も有名な四足ロボットの 1 つはボストン ダイナミクスの Spot で、最大 15 kg のペイロードを運ぶことができ、トンネルなどの保守現場の地図を繰り返し作成できます。不動産業界や鉱業業界も、複雑な物流を伴う現場の監視を支援するために、Spot のような四足ロボットを導入しています。

この記事では、モバイル BCI ソリューションによって制御される Spot ロボットを使用し、暗算タスクに基づいています。全体のアーキテクチャは Ddog と呼ばれます。

#Ddog アーキテクチャ

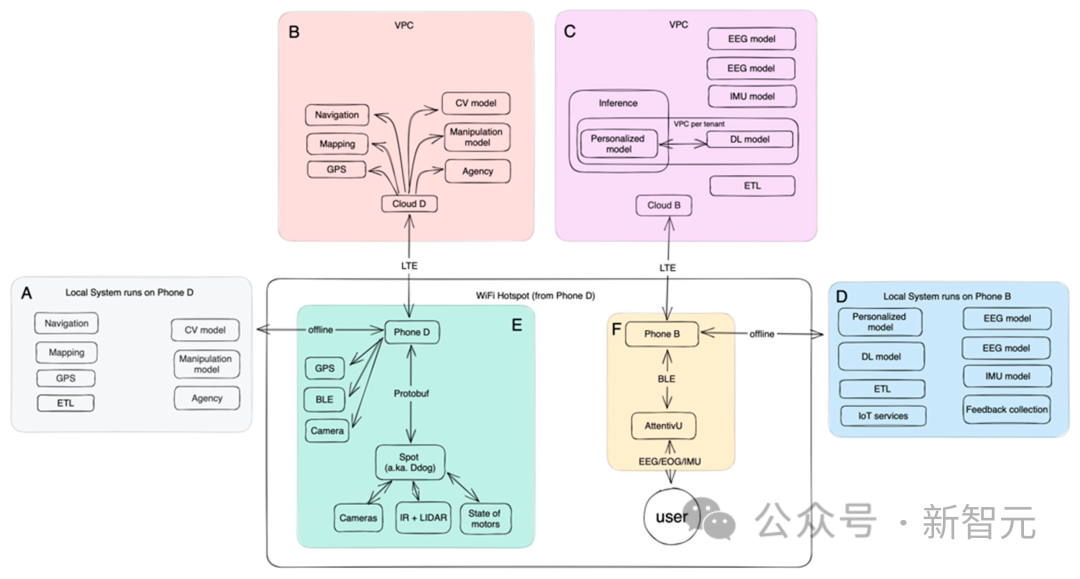

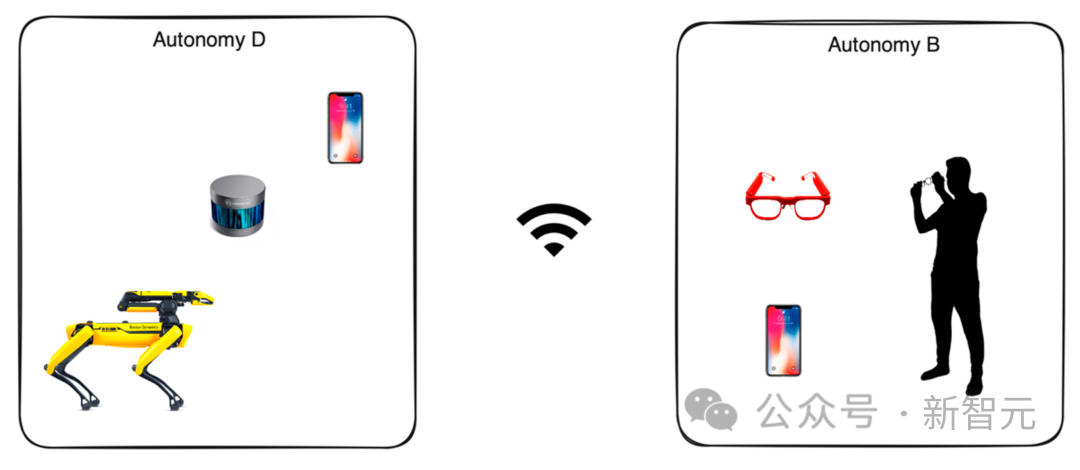

Ddog の全体的な構造を次の図に示します。

#Ddog は、ユーザーが BCI からの入力を通じて Spot ロボットを制御できる自律型アプリであり、アプリは音声を使用してユーザーとその介護者にフィードバックを提供します。

システムは、完全にオフラインでも完全にオンラインでも動作するように設計されています。オンライン バージョンには、より高度な機械学習モデルのセットと、より適切に微調整されたモデルが含まれており、ローカル デバイスの電力効率が高くなります。

システム全体は現実のシナリオ向けに設計されており、ほとんどの部分で迅速な反復が可能です。

クライアント側では、ユーザーは Bluetooth Low Energy (BLE) を使用するモバイル アプリケーションを通じてブレイン コンピューター インターフェイス デバイス (AttentivU) と対話します。 ) プロトコルを使用してデバイスと通信します。

ユーザーのモバイル デバイスは、Spot ロボットを制御する別の電話と通信して、ユーザーへの代理、操作、ナビゲーション、そして最終的な支援を可能にします。

携帯電話間の通信は、Wi-Fi またはモバイル ネットワークを通じて行うことができます。制御された携帯電話は Wi-Fi ホットスポットを確立し、Ddog とユーザーの携帯電話の両方がこのホットスポットに接続されます。オンライン モードを使用すると、クラウド上で実行されているモデルに接続することもできます。

サーバー側

サーバー側は Kubernetes (K8S) クラスターを使用し、各クラスターは独自の Virtual Private Cloud (VPC) にデプロイされます。

クラウドは専用の VPC 内で動作し、通常はエンドユーザーに近い同じアベイラビリティーゾーンにデプロイされ、各サービスの応答遅延を最小限に抑えます。

クラスター内の各コンテナーは単一の目的 (マイクロサービス アーキテクチャ) のために設計されています。各サービスは実行中の AI モデルです。タスクには次が含まれます: ナビゲーション、マッピング、コンピューター ビジョン、操作、ローカリゼーションそして代理店。

マッピング: ロボットの周囲に関する情報をさまざまなソースから収集するサービス。静的で動かないデータ (木、建物、壁) をマッピングしますが、時間の経過とともに変化する動的データ (車、人) も収集します。

ナビゲーション: 以前のサービスで収集および拡張された地図データに基づいて、ナビゲーション サービスは、点 A と点 B の間の空間および時間のパスを構築します。代替ルートの構築や所要時間の見積もりも担当します。

コンピューター ビジョン: ロボット カメラから視覚データを収集し、それを携帯電話からのデータで拡張して、空間的および時間的表現を生成します。このサービスは、各視点をセグメント化し、オブジェクトを識別することも試みます。

クラウドは、脳波 (EEG)、眼電図 (EOG)、慣性測定装置 (IMU) などの BCI 関連モデルのトレーニングを担当します。

携帯電話にデプロイされたオフライン モデルはデータの収集と集計を実行し、TensorFlow のモバイル モデルも使用します (RAM が小さく、ARM CPU に基づいている)リアルタイム推論用に最適化されています。

ビジュアルと操作性

セグメンテーション モデルのデプロイに使用された元のバージョンは、LIDAR データを利用する単一の TensorFlow 3D モデルでした。次に、著者らはこれを少数ショット モデルに拡張し、Neural Radiation Field (NeRF) と RGBD データに対して相補的なモデルを実行することで強化しました。

Ddog によって収集された生データは、5 台のカメラから集約されています。各カメラは、グレースケール、魚眼、深度、および赤外線データを提供できます。また、アームのグリッパー内には 4K 解像度と LED 機能を備えた 6 台目のカメラがあり、事前にトレーニングされた TensorFlow モデルと連携して物体を検出します。

点群は、Ddog と携帯電話からの LIDAR データと RGBD データから生成されます。データ取得が完了すると、データは単一の座標系を通じて正規化され、すべてのイメージング データと 3D 測位データを統合するグローバルな状態と照合されます。

操作は、Ddog に取り付けられたロボット アーム グリッパーの品質に完全に依存します。下の写真は Boston Dynamics によって製造されています。

実験のユースケースを、事前定義された場所にあるオブジェクトとの基本的な対話に限定します。

著者は、広い実験室スペースを描き、それを「キッチン」エリア(さまざまなカップやボトルが入ったトレイ付き)を含む「アパート」として設定しました。 「ルーム」エリア(枕付きの小さなソファと小さなコーヒーテーブル)、および「ウィンドウラウンジ」エリア。

ユースケースの数は増え続けているため、ほとんどのユースケースをカバーする唯一の方法は、システムをデプロイして一定期間継続的に実行することです。時間を節約し、そのデータを使用してそのようなシーケンスとエクスペリエンスを最適化します。

AttentivU

EEG データは AttentivU デバイスから収集されます。 AttentivU ガラスの電極は天然銀でできており、国際 10-20 電極配置システムに従って TP9 と TP10 に配置されています。このメガネには、鼻パッドに配置された 2 つの EOG 電極と、Fpz 位置に配置された EEG 基準電極も含まれています。

これらのセンサーは必要な情報を提供し、必要に応じてリアルタイムの閉ループ介入を可能にします。

このデバイスには、EEG と EOG の 2 つのモードがあり、注意、関与、疲労、認知負荷の信号をリアルタイムでキャプチャするために使用できます。 。 EEG は覚醒と睡眠の間の移行の神経生理学的指標として使用されていますが、EOG は角膜 - 網膜の双極子特性により眼球運動中に誘発される生体電気信号の測定に基づいています。研究によると、目の動きは特定のタスクを実行するために必要な記憶アクセスの種類と相関しており、視覚への関与、注意力、眠気の適切な尺度となることがわかっています。

実験

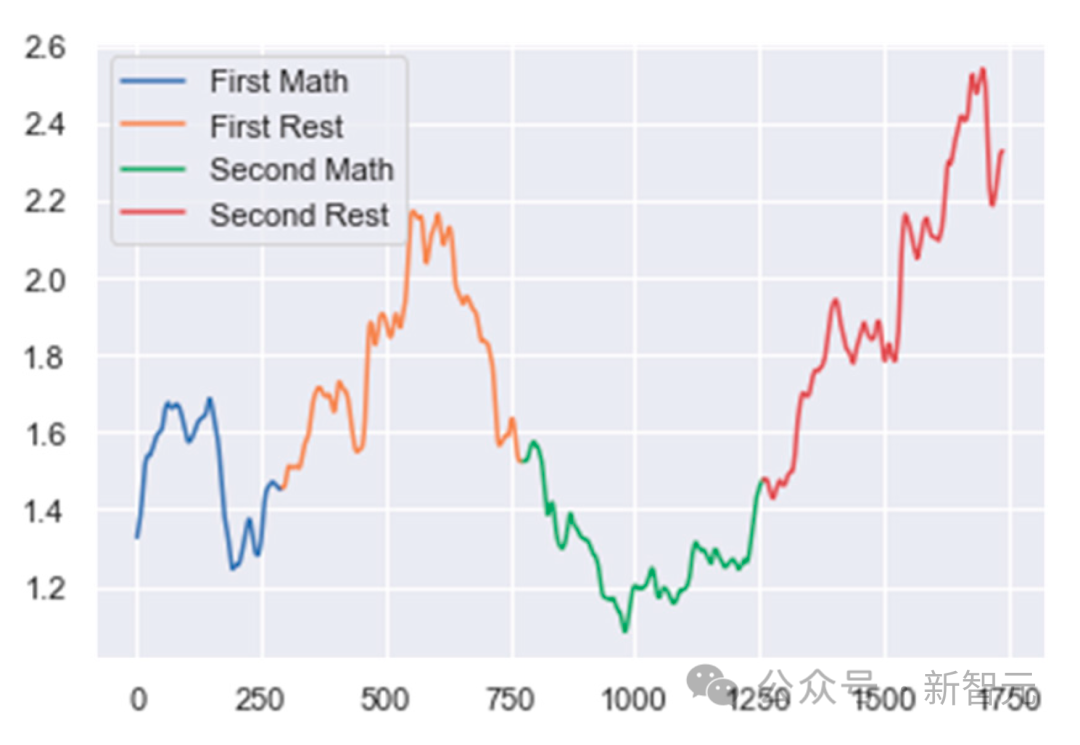

まずEEGデータをいくつかのウィンドウに分割します。各ウィンドウを、前のウィンドウと 75% 重複する 1 秒間の EEG データとして定義します。

次に、データの前処理とクリーニングが始まります。データは、50 Hz ノッチ フィルターと 0.5 Hz ~ 40 Hz の通過帯域を持つバンドパス フィルターの組み合わせを使用してフィルター処理され、電力線ノイズと不要な高周波が確実に除去されました。

次に、著者はアーティファクト除去アルゴリズムを作成しました。連続する 2 つのエポック間の絶対電力差が事前定義されたしきい値より大きい場合、エポックは拒否されます。

分類の最終ステップで、著者らはさまざまなスペクトル帯域パワー比を混合して、各被験者のタスクベースの精神活動を追跡しました。 MA の場合、比率は (アルファ/デルタ) です。 WA の場合、比率は (デルタ/低ベータ)、ME の場合、比率は (デルタ/アルファ) です。

次に、変化点検出アルゴリズムを使用して、これらの比率の変化を追跡します。これらの比率の突然の増加または減少は、ユーザーの精神状態の変化を示します。

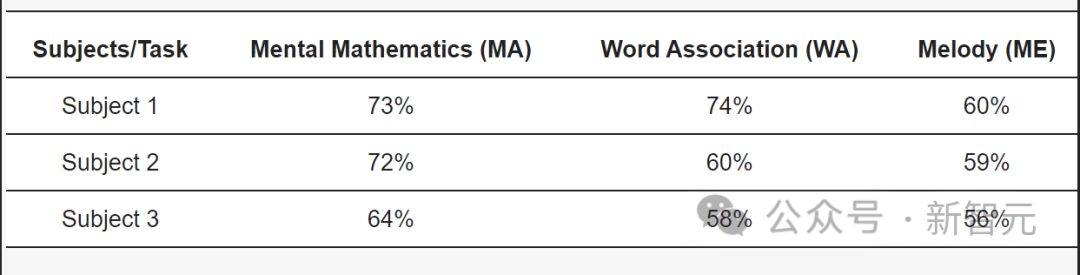

ALS の被験者の場合、私たちのモデルは MA タスクで 73% の精度、WA タスクで 73% の精度を達成しました。は 74% の精度を達成し、ME タスクでは 60% の精度を達成しました。

以上がAI読心技術が進化!メガネがボストンのロボット犬を直接制御し、脳制御ロボットを実現の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。