ホームページ >テクノロジー周辺機器 >AI >GPT-4に匹敵するオープンソースモデルが流出!ミストラルのボスが確認されました:正式版はさらに強力になります

GPT-4に匹敵するオープンソースモデルが流出!ミストラルのボスが確認されました:正式版はさらに強力になります

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-02-01 21:00:471071ブラウズ

Mistral-Medium が誤って漏洩したのですか?以前は API 経由でのみ利用可能でしたが、 パフォーマンスは GPT-4 に近づきました。

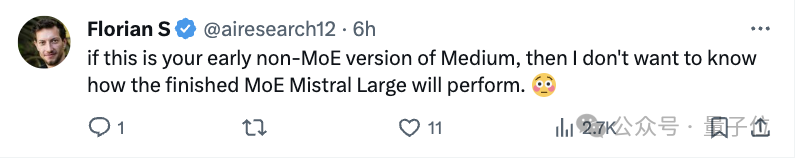

CEO の最新の声明: これは真実であり、初期の顧客従業員によってリークされたものです。しかし、それでも注目してくださいと言いました。

画像

画像

つまり、このバージョンはまだ古いため、実際のバージョンのパフォーマンスはさらに優れています。

ここ 2 日間、「Miqu」という名前の謎のモデルが大規模なモデル コミュニティで話題になっており、多くの人がこれが LIama の微調整版ではないかと疑っています。

写真

写真

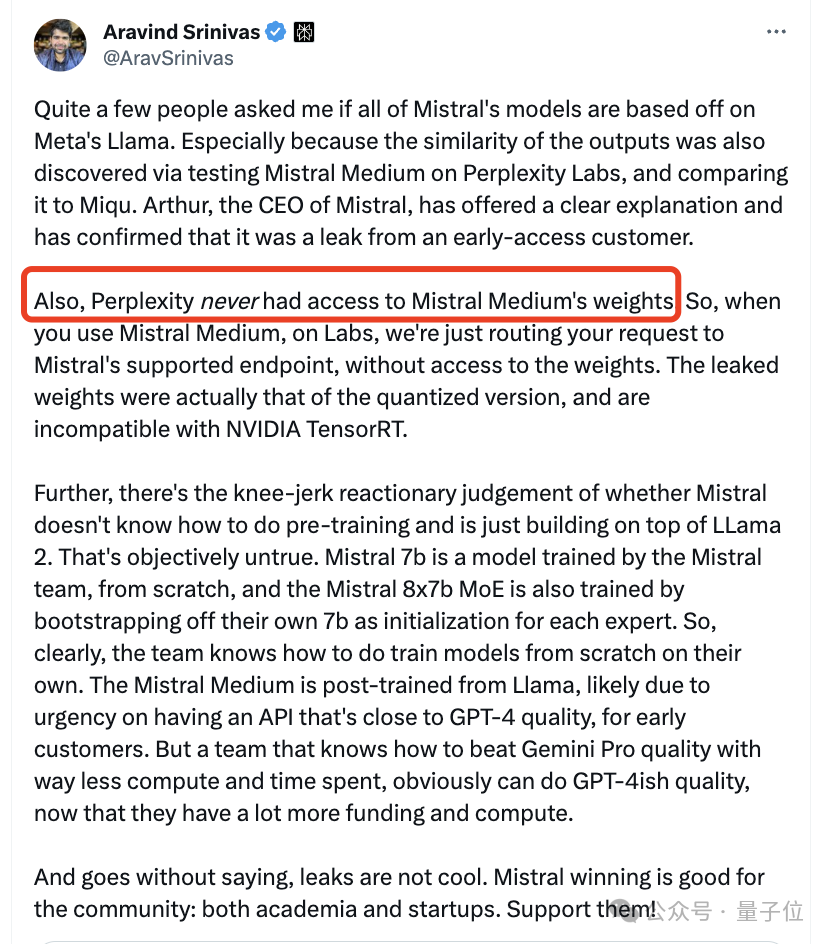

Mistral CEO は、Mistral Medium を再トレーニングし、Llama 2 に基づいて改良したと説明しました。これは、GPT-4 のパフォーマンスに近い API をできるだけ早く初期の顧客に提供するためです。事前トレーニング作業は、ミストラル 7B がリリースされた日に完了しました。

真実が明らかになった今、CEOはまだ秘密を隠しており、多くのネチズンが期待して手を叩いています。

写真

写真

写真

写真

ミストラル-ミディアムが誤って漏洩しました

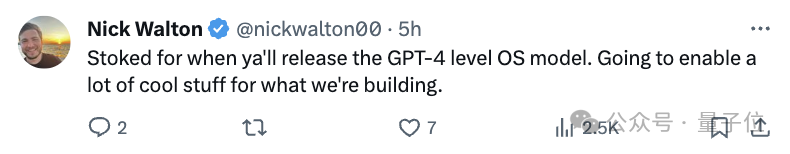

私たちもう一度事件全体を振り返ってみましょう。 1 月 28 日、Miqu Dev という名前の謎のユーザーが一連のファイル「miqu-1-70b」を HuggingFace に投稿しました。

写真

写真

この文書には、新しい LLM の「プロンプト形式」とユーザー対話方法が Mistral と同じであると記載されています。

同日、4chan の匿名ユーザーが miqu-1-70b ファイルへのリンクを投稿しました。

そこで、一部のネチズンがこの謎のモデルに気づき、いくつかのベンチマークテストを実施し始めました。

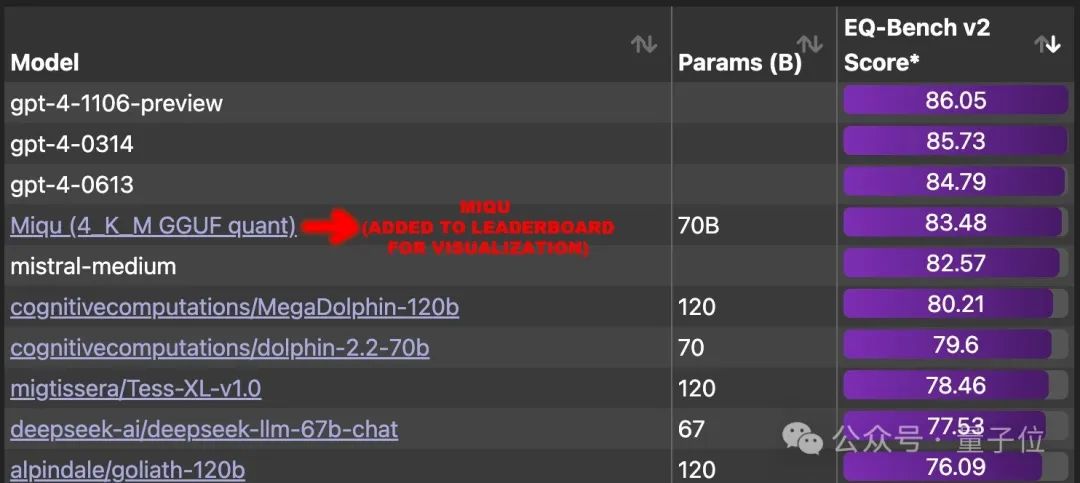

結果は驚くべきものです。EQ-Bench (ローカル評価) で 83.5 のスコアを獲得し、 GPT-4 を除く世界中のすべての大型モデルを上回りました。

一時期、ネチズンはこの大型モデルをランキングに加え、その背後にある本当のモデルを解明するよう強く求めていました。

容疑の主な方向性は 3 つあります。

- これは、Mistral-Medium と同じモデルです。

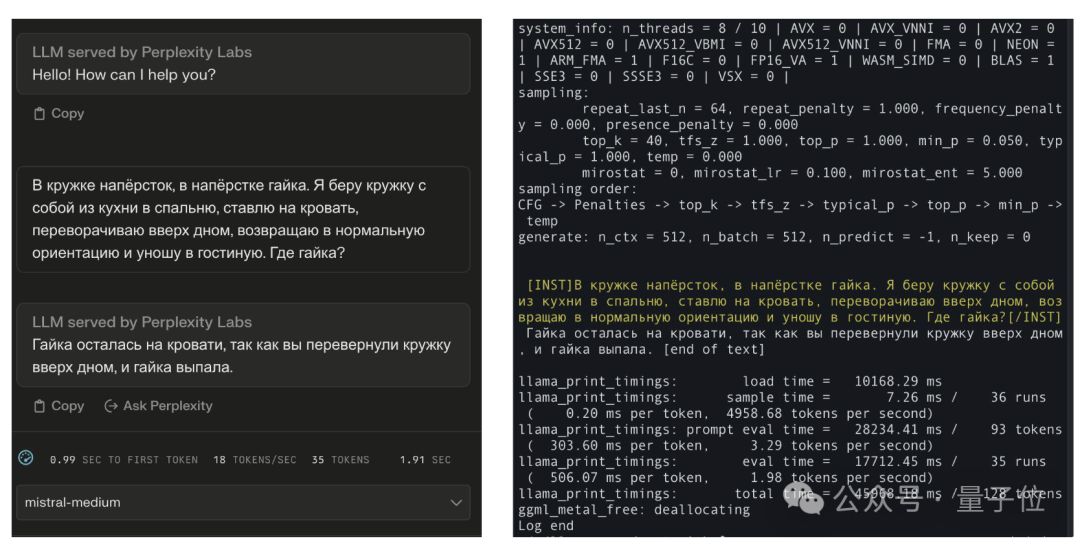

一部のネチズンは比較効果を投稿しました。標準的な答えはわかっており、それは理にかなっていますが、ロシア語の文言がミストラル-ミディアムとまったく同じであることは不可能です。

写真

写真

- Miqu は LIama 2 の微調整バージョンであると考えられています。

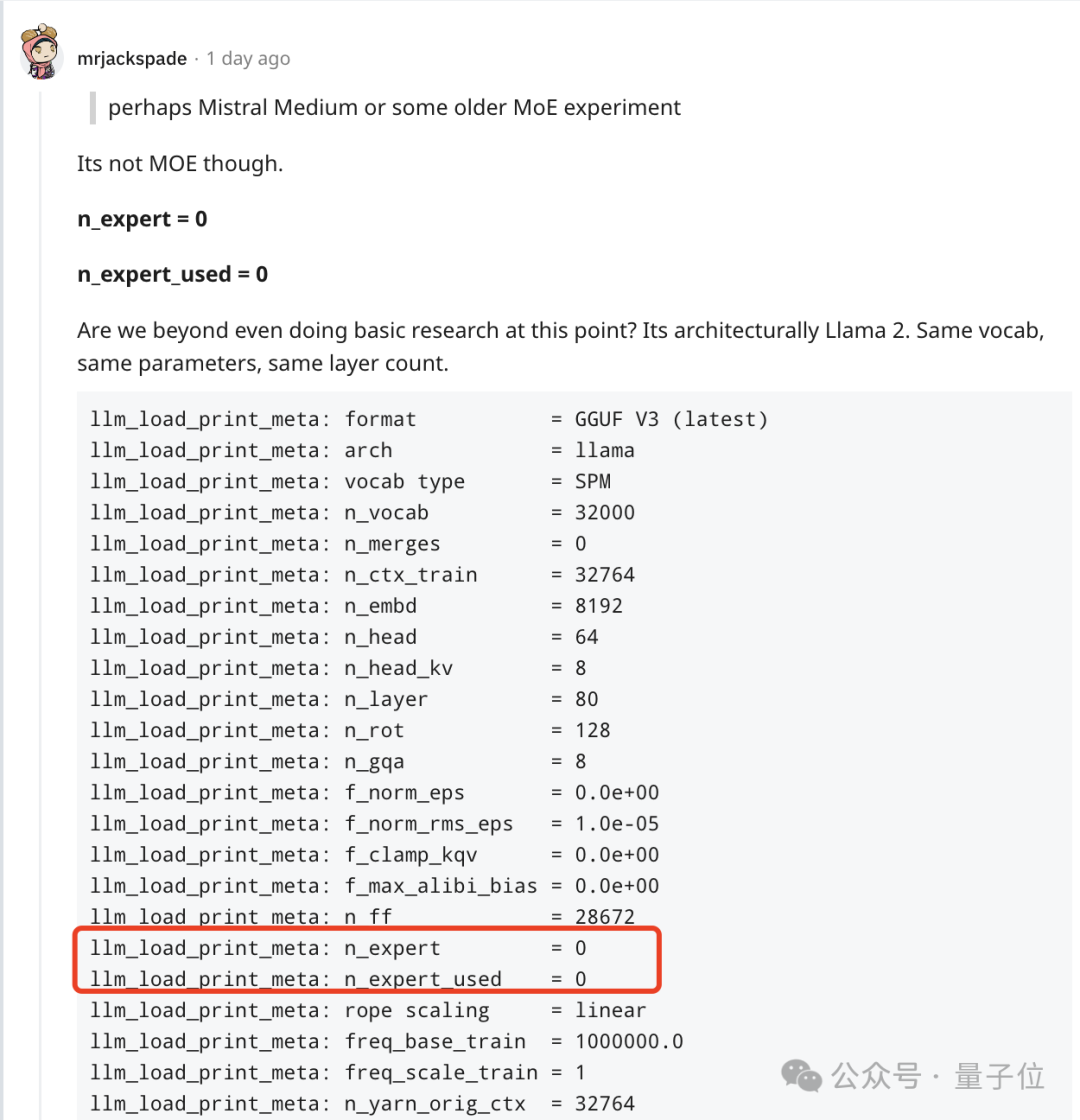

しかし、他のネチズンは、これが MoE モデルではなく、LIama 2 と同じアーキテクチャ、同じパラメータ、同じ数のレイヤーを備えていることを発見しました。

写真

写真

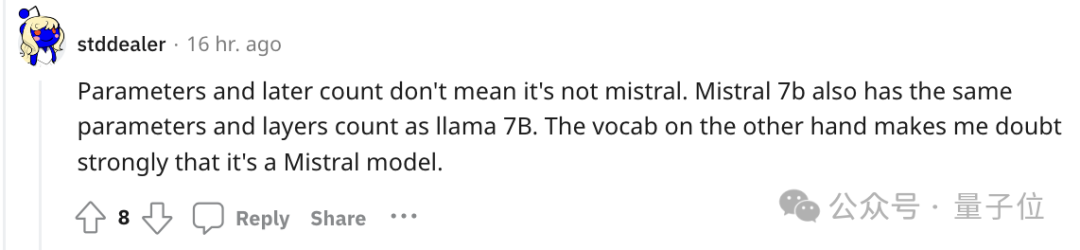

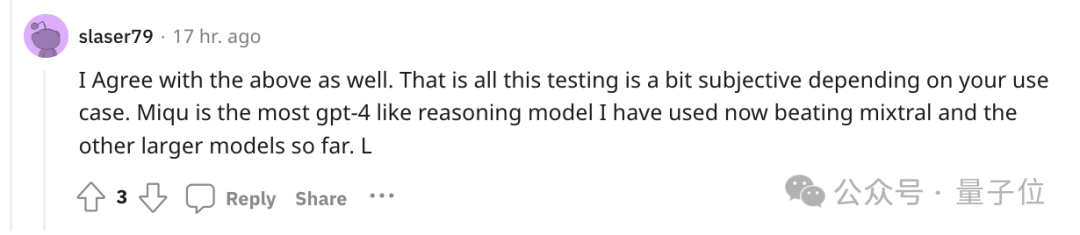

しかし、他のネチズンからすぐに疑問の声が上がりましたが、ミストラル 7b もラマ 7B と同じパラメーターとレイヤー数を持っています。

むしろ、これは Mistral の初期の非 MoE バージョン モデル に似ています。

写真

写真

しかし、多くの議論を経て、多くの人の心の中ではこれが GPT-4 に最も近いモデルであることは否定できません。

写真

写真

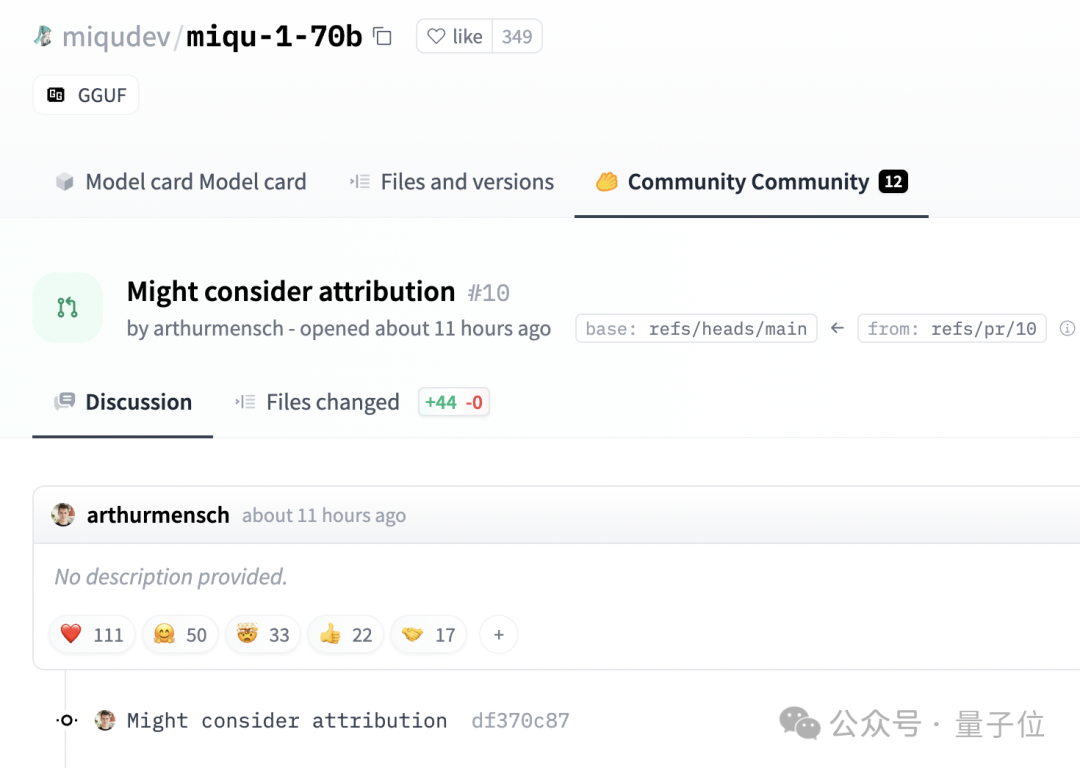

ミストラルの共同創設者兼 CEO のアーサー・メンシュ氏は、漏洩の原因が初期の顧客の 1 社の熱心すぎる従業員によって引き起こされたことを認めています。古いモデルの量子化バージョンがトレーニングされ、公開されました。

Perplexity に関しては、CEO は、Mistral Medium の重みを一度も受けたことがないことも明らかにしました。

写真

写真

ネチズンは、このバージョンが削除されるかどうかを心配しています。

写真

写真

興味深いことに、Mensch は HuggingFace の投稿の削除を求めていません。

写真

写真

代わりに、次のようなコメントを残してください: 帰属の問題が考慮される可能性があります。

参考リンク:

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2] https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4] https://twitter.com/AravSrinivas/status/1752803571035504858

以上がGPT-4に匹敵するオープンソースモデルが流出!ミストラルのボスが確認されました:正式版はさらに強力になりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。