Google の新しいメソッド ASPIRE: LLM に自己採点機能を与え、「錯覚」問題を効果的に解決し、ボリューム モデルの 10 倍を超える

大型モデルの「錯覚」問題は間もなく解決されるでしょうか?

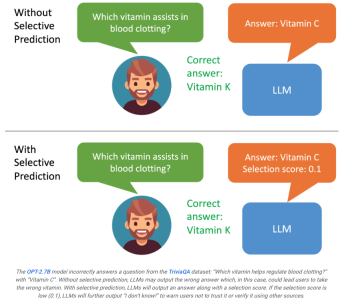

ウィスコンシン大学マディソン校の研究者と Google は最近、大規模モデルの出力を自己評価できる ASPIRE システムを立ち上げました。

ユーザーは、モデルによって生成された結果のスコアが低いことを確認すると、その応答が幻想である可能性があることに気づくでしょう。

システムがスコアに基づいて出力をさらにフィルタリングできる場合、たとえばスコアが低い場合、大規模なモデルは次のようなものを生成できます。幻覚の問題を最大限に改善できる可能性があるこの質問には、私は答えることができません。」

論文アドレス: https://aclanthology.org/2023.findings-emnlp.345.pdf

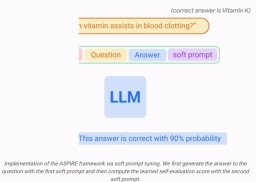

ASPIRE を使用すると、LLM は答えとその答えの信頼スコアを出力できます。

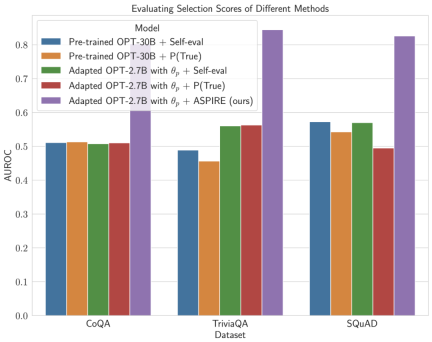

研究者らの実験結果は、ASPIRE が CoQA ベンチマークなどのさまざまな QA データセットに対して従来の選択的予測手法を大幅に上回るパフォーマンスを示していることを示しています。

LLM は質問に答えるだけでなく、その回答を評価することもできます。

選択的予測のベンチマーク テストでは、研究者は ASPIRE システムを通じてモデルのスケールの 10 倍を超える結果を達成しました。

#教科書の後ろで生徒に自分の答えを確認させるようなものです。少し信憑性がありませんが、よく考えてみると、 , 皆さん 質問を完了すると、確かに回答の満足度のスコアが表示されます。

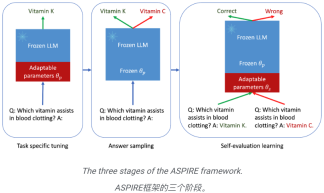

これは ASPIRE の本質であり、次の 3 つのフェーズが含まれます:

(1) 特定のタスクの調整

(2) 解答サンプリング、

(3) 自己評価学習。

研究者の目には、ASPIRE は単なるフレームワークではなく、LLM の信頼性を包括的に向上させ、幻覚を軽減する明るい未来を表しています。

LLM が意思決定プロセスにおいて信頼できるパートナーになれれば。

選択的予測を行う能力を継続的に最適化することで、人間は大規模モデルの可能性を完全に実現することに一歩近づきます。

研究者たちは、ASPIRE を使用して次世代 LLM の進化を開始し、それによってより信頼性が高く自己認識型の人工知能を作成したいと考えています。

ASPIRE の仕組み

特定のタスクの微調整

ASPIRE は、LLM をフリーズしながら、タスク固有の微調整を実行して適応パラメーターをトレーニングします。  生成タスク用のトレーニング データセットが与えられると、事前トレーニングされた LLM を微調整して予測パフォーマンスを向上させます。

生成タスク用のトレーニング データセットが与えられると、事前トレーニングされた LLM を微調整して予測パフォーマンスを向上させます。

この目的のために、パラメータ効率の高い微調整技術 (ソフトキューワード微調整や LoRA など) を使用して、タスクに関する事前トレーニング済み LLM を微調整できます。 、少数のターゲットで効率的に取得できるため、強力な汎化タスク データ。

具体的には、LLM パラメータ (θ) が固定され、微調整のために適応パラメータ

が追加されます。  標準的な LLM トレーニング損失 (クロスエントロピーなど) を最小限に抑えるために θ (p) のみを更新します。

標準的な LLM トレーニング損失 (クロスエントロピーなど) を最小限に抑えるために θ (p) のみを更新します。

この種の微調整により、予測精度が向上するだけでなく、シーケンスが正しく出力される可能性も高まるため、選択的予測のパフォーマンスを向上させることができます。

#回答のサンプリング

## 特定のタスク向けに調整された後、ASPIRE は LLM を使用して学習  さまざまな回答を生成するトレーニングの質問ごとに、自己評価学習用のデータセットを作成します。

さまざまな回答を生成するトレーニングの質問ごとに、自己評価学習用のデータセットを作成します。

研究者の目標は、高い確率で出力シーケンスを生成することです。彼らは、復号化アルゴリズムとしてビーム検索を使用して、尤度の高い出力シーケンスを生成し、生成された出力シーケンスが正しいかどうかを判断するために Rouge-L メトリックを使用しました。

自己評価学習

各クエリの可能性の高い出力をサンプリングした後、ASPIRE は自己評価を追加しますパラメータ  を調整し、自己評価を学習するために

を調整し、自己評価を学習するために  のみを微調整します。

のみを微調整します。

出力シーケンスの生成は θ と  のみに依存するため、θ と学習された

のみに依存するため、θ と学習された  をフリーズすると次のようになります。自己評価を学習する際の LLM の予測動作の変更を回避しました。

をフリーズすると次のようになります。自己評価を学習する際の LLM の予測動作の変更を回避しました。

研究者らは、適応された LLM が自ら正解と不正解を区別できるように  を最適化しました。

を最適化しました。

このフレームワークでは、パラメータ有効な微調整メソッドを使用して  と ## をトレーニングできます。 #。

と ## をトレーニングできます。 #。

このアプローチの背後にある核心は、自己評価を効果的に刺激する手がかりを開発できれば、目標を絞ったトレーニング目標と組み合わせたソフトな手がかりを微調整することで発見できるはずであるという認識です。チップ。

と  をトレーニングした後、研究者はビーム検索によって解読しました。クエリの予測 (ビーム検索デコード)。

をトレーニングした後、研究者はビーム検索によって解読しました。クエリの予測 (ビーム検索デコード)。

結果

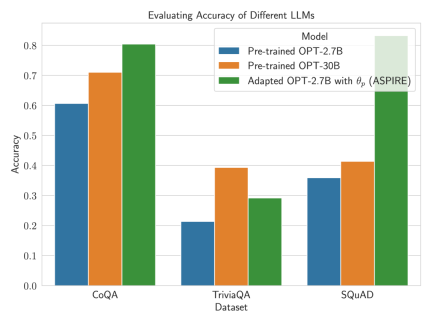

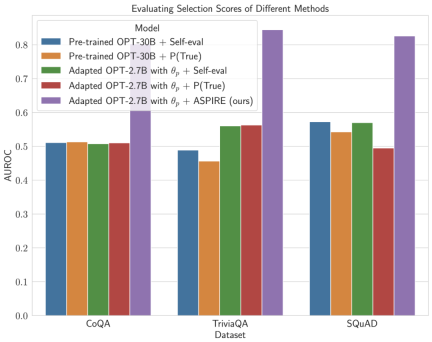

ASPIRE の効果を実証するために、研究者らは 3 つの質問と回答に対してさまざまなオープン事前トレーニング済みトランスフォーマー (OPT) モデルを使用しました。データ セット (CoQA、TriviaQA、SQuAD) で評価します。

ソフトキューを使用してトレーニングを調整することにより、 たとえば、ASPIRE を使用した OPT-2.7B モデルは、CoQA および SQuAD データセットを使用して事前トレーニングされた大規模な OPT-30B モデルよりも優れたパフォーマンスを示しました。 これらの結果は、適切な調整を行うことで、より小さな LLM が状況によってはより大きなモデルの精度に匹敵する、またはそれを超える可能性があることを示唆しています。 固定モデル予測の選択スコアの計算を詳しく調べると、ASPIRE はすべてのデータセット (ランダムな確率) でベースライン手法よりも高い AUROC スコアを達成しました。選択された正しい出力シーケンスは、ランダムに選択された誤った出力シーケンスよりも高い選択スコアを持ちます)。 たとえば、CoQA ベンチマークでは、ASPIRE はベースラインと比較して AUROC を 51.3% から 80.3% に改善します。 TriviaQA データセットの評価から、興味深いパターンが明らかになりました。 事前トレーニング済み OPT-30B モデルはより高いベースライン精度を示しますが、従来の自己評価方法 (自己評価および P(True)) を適用する場合の選択 性別予測のパフォーマンス大幅には改善されていません。 対照的に、はるかに小型の OPT-2.7B モデルは、ASPIRE で強化された後、この点で他のモデルよりも優れた性能を発揮しました。 この違いは重要な問題を反映しています。従来の自己評価手法を利用する大規模な LLM は、小規模な ASPIRE 拡張モデルほど選択的予測において効果的ではない可能性があります。 研究者による ASPIRE での実験の旅は、LLM の状況における重要な変化を浮き彫りにしています。言語モデルの能力がすべてではなく、最終的なものではありません。そのパフォーマンスのすべてを。 代わりに、ポリシーの調整によってモデルの有効性を大幅に向上させることができ、小規模なモデルでもより正確で信頼性の高い予測が可能になります。 したがって、ASPIRE は、LLM が自身の答えの確実性を賢明に判断し、選択的予測タスクにおいて他の LLM のサイズを 10 倍大幅に上回る可能性を示しています。  研究者らは、LLM の精度が大幅に向上することを観察しました。

研究者らは、LLM の精度が大幅に向上することを観察しました。

以上がGoogle の新しいメソッド ASPIRE: LLM に自己採点機能を与え、「錯覚」問題を効果的に解決し、ボリューム モデルの 10 倍を超えるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

踊りましょう:私たちの人間のニューラルネットを微調整するための構造化された動きApr 27, 2025 am 11:09 AM

踊りましょう:私たちの人間のニューラルネットを微調整するための構造化された動きApr 27, 2025 am 11:09 AM科学者は、彼らの機能を理解するために、人間とより単純なニューラルネットワーク(C. elegansのものと同様)を広く研究してきました。 ただし、重要な疑問が生じます。新しいAIと一緒に効果的に作業するために独自のニューラルネットワークをどのように適応させるのか

新しいGoogleリークは、Gemini AIのサブスクリプションの変更を明らかにしますApr 27, 2025 am 11:08 AM

新しいGoogleリークは、Gemini AIのサブスクリプションの変更を明らかにしますApr 27, 2025 am 11:08 AMGoogleのGemini Advanced:Horizonの新しいサブスクリプションティア 現在、Gemini Advancedにアクセスするには、1か月あたり19.99ドルのGoogle One AIプレミアムプランが必要です。 ただし、Android Authorityのレポートは、今後の変更を示唆しています。 最新のGoogle p

データ分析の加速がAIの隠されたボトルネックをどのように解決しているかApr 27, 2025 am 11:07 AM

データ分析の加速がAIの隠されたボトルネックをどのように解決しているかApr 27, 2025 am 11:07 AM高度なAI機能を取り巻く誇大宣伝にもかかわらず、エンタープライズAIの展開内に大きな課題が潜んでいます:データ処理ボトルネック。 CEOがAIの進歩を祝う間、エンジニアはクエリの遅い時間、過負荷のパイプライン、

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AM

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AMドキュメントの取り扱いは、AIプロジェクトでファイルを開くだけでなく、カオスを明確に変えることです。 PDF、PowerPoint、Wordなどのドキュメントは、あらゆる形状とサイズでワークフローをフラッシュします。構造化された取得

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AM

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AMGoogleのエージェント開発キット(ADK)のパワーを活用して、実際の機能を備えたインテリジェントエージェントを作成します。このチュートリアルは、ADKを使用して会話エージェントを構築し、GeminiやGPTなどのさまざまな言語モデルをサポートすることをガイドします。 w

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AM

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AMまとめ: Small Language Model(SLM)は、効率のために設計されています。それらは、リソース不足、リアルタイム、プライバシーに敏感な環境の大手言語モデル(LLM)よりも優れています。 特にドメインの特異性、制御可能性、解釈可能性が一般的な知識や創造性よりも重要である場合、フォーカスベースのタスクに最適です。 SLMはLLMSの代替品ではありませんが、精度、速度、費用対効果が重要な場合に理想的です。 テクノロジーは、より少ないリソースでより多くを達成するのに役立ちます。それは常にドライバーではなく、プロモーターでした。蒸気エンジンの時代からインターネットバブル時代まで、テクノロジーの力は、問題の解決に役立つ範囲にあります。人工知能(AI)および最近では生成AIも例外ではありません

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AM

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AMコンピュータービジョンのためのGoogleGeminiの力を活用:包括的なガイド 大手AIチャットボットであるGoogle Geminiは、その機能を会話を超えて拡張して、強力なコンピュータービジョン機能を網羅しています。 このガイドの利用方法については、

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM2025年のAIランドスケープは、GoogleのGemini 2.0 FlashとOpenaiのO4-Miniの到着とともに感動的です。 数週間離れたこれらの最先端のモデルは、同等の高度な機能と印象的なベンチマークスコアを誇っています。この詳細な比較

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

ドリームウィーバー CS6

ビジュアル Web 開発ツール

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

Dreamweaver Mac版

ビジュアル Web 開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

ホットトピック

7751

7751 15

15 1643

1643 14

14 1398

1398 52

52 1293

1293 25

25 1234

1234 29

29