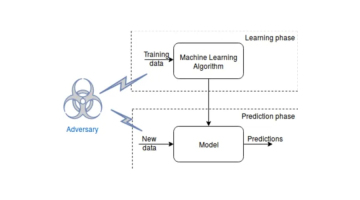

敵対的学習は、敵対的にトレーニングすることでモデルの堅牢性を向上させる機械学習手法です。このトレーニング方法の目的は、挑戦的なサンプルを意図的に導入することで、モデルが不正確または誤った予測を生成するようにすることです。このようにして、トレーニングされたモデルは実世界のデータの変化によりよく適応できるようになり、パフォーマンスの安定性が向上します。

機械学習モデルに対する敵対的攻撃

機械学習モデルに対する攻撃は、ホワイト ボックス攻撃とブラック ボックス攻撃の 2 つのカテゴリに分類できます。ホワイトボックス攻撃は、攻撃者がモデルの構造とパラメータにアクセスして攻撃を実行できることを意味しますが、ブラックボックス攻撃は、攻撃者がこの情報にアクセスできないことを意味します。一般的な敵対的攻撃手法には、高速勾配符号法 (FGSM)、基本反復法 (BIM)、ヤコビアン行列ベースの顕著性マップ攻撃 (JSMA) などがあります。

モデルの堅牢性を向上させるために敵対的学習が重要なのはなぜですか?

敵対的学習は、モデルの堅牢性を向上させる上で重要な役割を果たします。これにより、モデルの一般化が向上し、データ構造を特定して適応できるため、堅牢性が向上します。さらに、敵対的学習はモデルの弱点を発見し、モデルを改善するためのガイダンスを提供することもできます。したがって、敵対的学習はモデルのトレーニングと最適化にとって非常に重要です。

敵対的学習を機械学習モデルに組み込むにはどうすればよいですか?

敵対的学習を機械学習モデルに組み込むには、敵対的サンプルを生成することと、これらのサンプルをトレーニング プロセスに組み込むことの 2 つのステップが必要です。

敵対的な例の生成とトレーニング

情報を生成するには、勾配ベースの方法、遺伝的アルゴリズム、強化学習など、さまざまな方法があります。その中で、勾配ベースの方法が最も一般的に使用されます。この方法では、入力損失関数の勾配を計算し、勾配の方向に基づいて情報を調整して損失を増加させます。

敵対的なサンプルは、敵対的なトレーニングと敵対的な強化を通じてトレーニング プロセスに組み込むことができます。トレーニング中に、敵対的サンプルを使用してモデル パラメーターを更新すると同時に、敵対的サンプルをトレーニング データに追加することでモデルの堅牢性を向上させます。

拡張データは、モデルのパフォーマンスを向上させるために広く使用されている、シンプルで効果的な実用的な方法です。基本的な考え方は、敵対的な例をトレーニング データに導入し、拡張データでモデルをトレーニングすることです。トレーニングされたモデルは、元の例と敵対的な例のクラス ラベルを正確に予測できるため、データの変更や歪みに対してより堅牢になります。この方法は実際のアプリケーションでは非常に一般的です。

敵対的学習の応用例

敵対的学習は、コンピューター ビジョン、音声認識、自然言語処理など、さまざまな機械学習タスクに適用されています。

コンピューター ビジョンでは、画像分類モデルの堅牢性を向上させるために、畳み込みニューラル ネットワーク (CNN) の堅牢性を調整することで、目に見えないデータの精度を向上させることができます。

敵対的学習は、音声認識における自動音声認識 (ASR) システムの堅牢性を向上させる役割を果たします。この方法は、敵対的な例を使用して、人間には知覚できないように設計された方法で入力音声信号を変更しますが、ASR システムが誤って転写するように設計されています。研究によると、敵対的トレーニングにより、これらの敵対的な例に対する ASR システムの堅牢性が向上し、それによって認識の精度と信頼性が向上することが示されています。

自然言語処理では、感情分析モデルの堅牢性を向上させるために敵対的学習が使用されてきました。 NLP のこの分野の敵対的な例は、不正確で不正確なモデル予測をもたらす方法で入力テキストを操作することを目的としています。敵対的トレーニングは、この種の敵対的例に対する感情分析モデルの堅牢性を向上させ、その結果、精度と堅牢性が向上することが示されています。

以上が機械学習における敵対的学習手法の詳細な分析の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

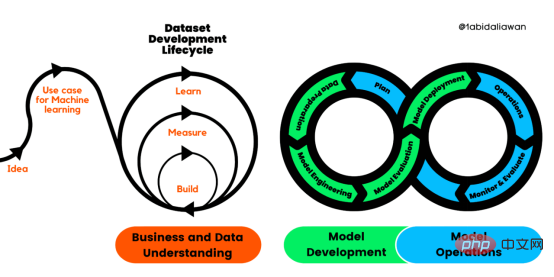

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM机器学习是一个不断发展的学科,一直在创造新的想法和技术。本文罗列了2023年机器学习的十大概念和技术。 本文罗列了2023年机器学习的十大概念和技术。2023年机器学习的十大概念和技术是一个教计算机从数据中学习的过程,无需明确的编程。机器学习是一个不断发展的学科,一直在创造新的想法和技术。为了保持领先,数据科学家应该关注其中一些网站,以跟上最新的发展。这将有助于了解机器学习中的技术如何在实践中使用,并为自己的业务或工作领域中的可能应用提供想法。2023年机器学习的十大概念和技术:1. 深度神经网

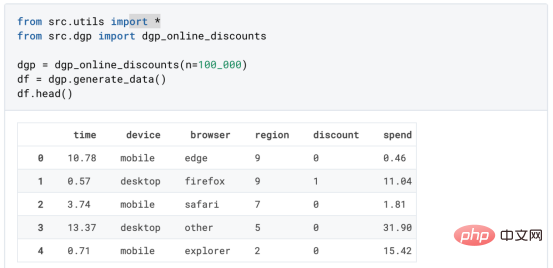

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM译者 | 朱先忠审校 | 孙淑娟在我之前的博客中,我们已经了解了如何使用因果树来评估政策的异质处理效应。如果你还没有阅读过,我建议你在阅读本文前先读一遍,因为我们在本文中认为你已经了解了此文中的部分与本文相关的内容。为什么是异质处理效应(HTE:heterogenous treatment effects)呢?首先,对异质处理效应的估计允许我们根据它们的预期结果(疾病、公司收入、客户满意度等)选择提供处理(药物、广告、产品等)的用户(患者、用户、客户等)。换句话说,估计HTE有助于我

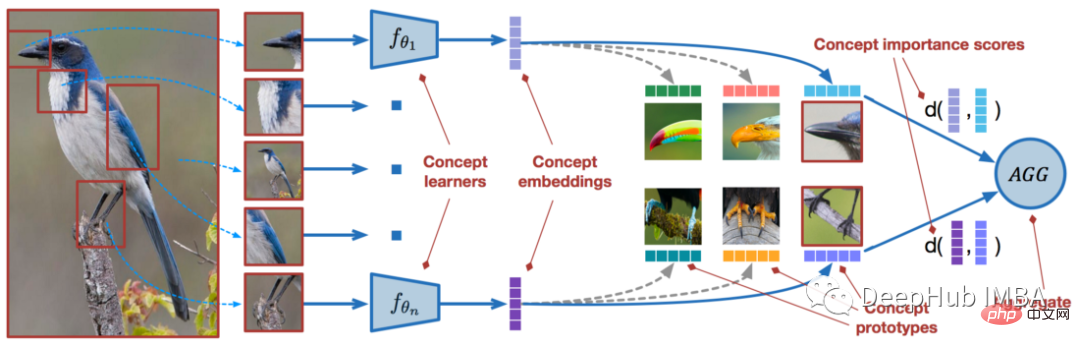

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM近年来,基于深度学习的模型在目标检测和图像识别等任务中表现出色。像ImageNet这样具有挑战性的图像分类数据集,包含1000种不同的对象分类,现在一些模型已经超过了人类水平上。但是这些模型依赖于监督训练流程,标记训练数据的可用性对它们有重大影响,并且模型能够检测到的类别也仅限于它们接受训练的类。由于在训练过程中没有足够的标记图像用于所有类,这些模型在现实环境中可能不太有用。并且我们希望的模型能够识别它在训练期间没有见到过的类,因为几乎不可能在所有潜在对象的图像上进行训练。我们将从几个样本中学习

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。 摘要本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。本文包括的内容如下:简介LazyPredict模块的安装在分类模型中实施LazyPredict

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM

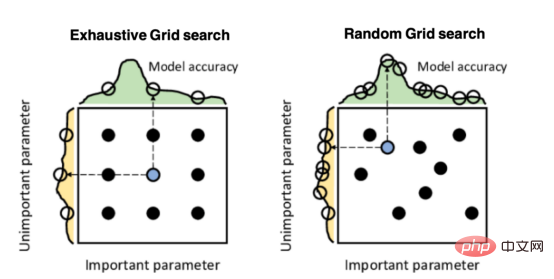

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM译者 | 朱先忠审校 | 孙淑娟引言模型超参数(或模型设置)的优化可能是训练机器学习算法中最重要的一步,因为它可以找到最小化模型损失函数的最佳参数。这一步对于构建不易过拟合的泛化模型也是必不可少的。优化模型超参数的最著名技术是穷举网格搜索和随机网格搜索。在第一种方法中,搜索空间被定义为跨越每个模型超参数的域的网格。通过在网格的每个点上训练模型来获得最优超参数。尽管网格搜索非常容易实现,但它在计算上变得昂贵,尤其是当要优化的变量数量很大时。另一方面,随机网格搜索是一种更快的优化方法,可以提供更好的

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM实现自我完善的过程是“机器学习”。机器学习是人工智能核心,是使计算机具有智能的根本途径;它使计算机能模拟人的学习行为,自动地通过学习来获取知识和技能,不断改善性能,实现自我完善。机器学习主要研究三方面问题:1、学习机理,人类获取知识、技能和抽象概念的天赋能力;2、学习方法,对生物学习机理进行简化的基础上,用计算的方法进行再现;3、学习系统,能够在一定程度上实现机器学习的系统。

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM本文将详细介绍用来提高机器学习效果的最常见的超参数优化方法。 译者 | 朱先忠审校 | 孙淑娟简介通常,在尝试改进机器学习模型时,人们首先想到的解决方案是添加更多的训练数据。额外的数据通常是有帮助(在某些情况下除外)的,但生成高质量的数据可能非常昂贵。通过使用现有数据获得最佳模型性能,超参数优化可以节省我们的时间和资源。顾名思义,超参数优化是为机器学习模型确定最佳超参数组合以满足优化函数(即,给定研究中的数据集,最大化模型的性能)的过程。换句话说,每个模型都会提供多个有关选项的调整“按钮

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

SublimeText3 中国語版

中国語版、とても使いやすい

Dreamweaver Mac版

ビジュアル Web 開発ツール

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

ホットトピック

7433

7433 15

15 1359

1359 52

52