オプティマイザは、重みとバイアスを調整して損失関数を最小限に抑え、モデルの精度を向上させるニューラル ネットワークのアルゴリズムです。トレーニング中、オプティマイザーは主にパラメーターを更新し、モデルがより良い方向に最適化されるようにガイドするために使用されます。オプティマイザは勾配降下法などの方法を通じて重みとバイアスを自動的に調整し、モデルが徐々に最適解に近づくようにします。このようにして、ネットワークはより適切に学習し、予測パフォーマンスを向上させることができます。

オプティマイザは、損失関数の勾配に基づいてモデル パラメーターを更新し、損失関数を最小化し、モデルの精度を向上させます。

オプティマイザの機能の 1 つは、学習速度を向上させることです。損失関数の勾配に基づいて学習率を調整し、ニューラル ネットワークをより適切にトレーニングすることで機能します。学習率が大きすぎると、トレーニング プロセス中にモデルが収束することが難しくなり、学習率が小さすぎると、モデルのトレーニングが遅くなります。したがって、オプティマイザーは、モデルのトレーニング効果を向上させるための適切な学習率を見つけるのに役立ちます。

過学習の回避はオプティマイザの重要なタスクであり、正則化手法 (L1、L2 正則化など) によって実現できます。過学習とは、モデルがトレーニング データでは良好にパフォーマンスするのに、テスト データではパフォーマンスが低下する現象を指します。正則化手法を使用すると、モデルの複雑さが軽減され、モデルがトレーニング データに過剰適合することがなくなり、モデルの汎化能力が向上します。

一般的なオプティマイザー アルゴリズムには、勾配降下法、確率的勾配降下法、Adam オプティマイザーなどがあります。モデルパラメータの調整にはそれぞれメリット・デメリットがあり、実際の状況に応じて選択・調整する必要があります。

ニューラル ネットワークにおけるオプティマイザーの動作原理

オプティマイザーは、損失を最小限に抑えるために、現在の重みとバイアスに基づいて損失関数の勾配を計算することにより、パラメーター調整の方向を決定します。関数の目標。計算された勾配に基づいて、オプティマイザーはニューラル ネットワーク内の重みとバイアスを更新します。この更新プロセスでは、勾配降下法、確率的勾配降下法、Adam オプティマイザーなどのさまざまな方法を使用できます。これらの最適化アルゴリズムは、現在の勾配と学習率に基づいてパラメーターを更新するため、損失関数が徐々に減少し、それによってニューラル ネットワークのパフォーマンスが向上します。

オプティマイザは、現在の学習の進行状況に基づいて学習率を自動的に調整し、ニューラル ネットワークのトレーニングを改善します。学習率が大きすぎるとモデルは収束しにくくなり、学習率が小さすぎるとモデルのトレーニングが遅くなります。

最後に、オプティマイザーは正則化メソッドを使用して過学習を回避し、それによってモデルの汎化能力を向上させます。

モデル パラメーターの調整において、オプティマイザー アルゴリズムが異なると、それぞれ独自の長所と短所があることに注意してください。オプティマイザの選択や調整の際には、実際の状況に基づいて判断する必要があります。たとえば、Adam オプティマイザーは、従来の勾配降下法よりも収束速度が速く、汎化能力が優れています。したがって、ディープ ラーニング モデルをトレーニングするときは、トレーニング効率とモデルのパフォーマンスを向上させるために Adam オプティマイザーの使用を検討できます。

以上がニューラル ネットワークにおけるオプティマイザーの重要性の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AM

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AMドキュメントの取り扱いは、AIプロジェクトでファイルを開くだけでなく、カオスを明確に変えることです。 PDF、PowerPoint、Wordなどのドキュメントは、あらゆる形状とサイズでワークフローをフラッシュします。構造化された取得

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AM

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AMGoogleのエージェント開発キット(ADK)のパワーを活用して、実際の機能を備えたインテリジェントエージェントを作成します。このチュートリアルは、ADKを使用して会話エージェントを構築し、GeminiやGPTなどのさまざまな言語モデルをサポートすることをガイドします。 w

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AM

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AMまとめ: Small Language Model(SLM)は、効率のために設計されています。それらは、リソース不足、リアルタイム、プライバシーに敏感な環境の大手言語モデル(LLM)よりも優れています。 特にドメインの特異性、制御可能性、解釈可能性が一般的な知識や創造性よりも重要である場合、フォーカスベースのタスクに最適です。 SLMはLLMSの代替品ではありませんが、精度、速度、費用対効果が重要な場合に理想的です。 テクノロジーは、より少ないリソースでより多くを達成するのに役立ちます。それは常にドライバーではなく、プロモーターでした。蒸気エンジンの時代からインターネットバブル時代まで、テクノロジーの力は、問題の解決に役立つ範囲にあります。人工知能(AI)および最近では生成AIも例外ではありません

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AM

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AMコンピュータービジョンのためのGoogleGeminiの力を活用:包括的なガイド 大手AIチャットボットであるGoogle Geminiは、その機能を会話を超えて拡張して、強力なコンピュータービジョン機能を網羅しています。 このガイドの利用方法については、

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM2025年のAIランドスケープは、GoogleのGemini 2.0 FlashとOpenaiのO4-Miniの到着とともに感動的です。 数週間離れたこれらの最先端のモデルは、同等の高度な機能と印象的なベンチマークスコアを誇っています。この詳細な比較

Openai GPT-IMAGE-1 APIを使用して画像を生成および編集する方法Apr 27, 2025 am 09:16 AM

Openai GPT-IMAGE-1 APIを使用して画像を生成および編集する方法Apr 27, 2025 am 09:16 AMOpenaiの最新のマルチモーダルモデルであるGPT-Image-1は、ChatGPT内およびAPIを介して画像生成に革命をもたらします。 この記事では、その機能、使用法、アプリケーションについて説明します。 目次 GPT-Image-1の理解 GPT-Image-1の重要な機能

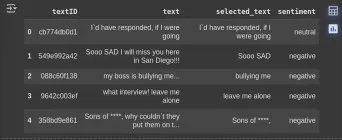

CleanLabを使用してデータの前処理を実行する方法は? - 分析VidhyaApr 27, 2025 am 09:15 AM

CleanLabを使用してデータの前処理を実行する方法は? - 分析VidhyaApr 27, 2025 am 09:15 AMデータの前処理は、機械学習を成功させるために最も重要ですが、実際のデータセットにはエラーが含まれることがよくあります。 CleanLabは、Pythonパッケージを使用して自信のある学習アルゴリズムを実装する効率的なソリューションを提供します。 検出を自動化します

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM「AI-Ready労働力」という用語は頻繁に使用されますが、サプライチェーン業界ではどういう意味ですか? サプライチェーン管理協会(ASCM)のCEOであるAbe Eshkenaziによると、批評家ができる専門家を意味します

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

Dreamweaver Mac版

ビジュアル Web 開発ツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

WebStorm Mac版

便利なJavaScript開発ツール

ホットトピック

7751

7751 15

15 1643

1643 14

14 1397

1397 52

52 1293

1293 25

25 1234

1234 29

29