ホームページ >テクノロジー周辺機器 >AI >機械学習における ReLU 関数を理解する

機械学習における ReLU 関数を理解する

- 王林転載

- 2024-01-22 22:36:102060ブラウズ

ReLU関数とは何ですか?

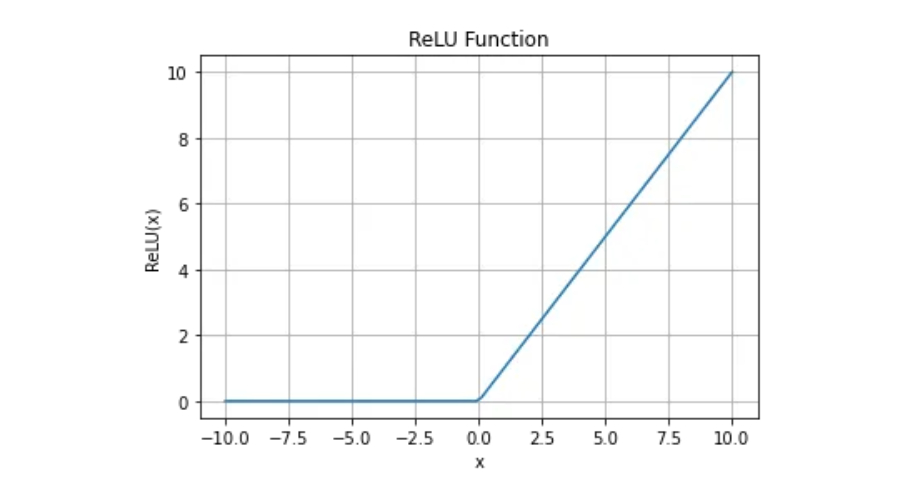

ReLU 関数は、f(x)=max(0,x) として定義される数学関数です。ここで、x は任意の実数です。簡単に言えば、x が 0 以下の場合、関数は 0 を返します。それ以外の場合は x を返します。

ReLU 関数の連続性と微分可能性

微分可能関数の場合、まず連続的である必要があります。 ReLU 関数は連続性の要件を満たしていますが、x=0 での導関数が存在しないため、この時点では ReLU 関数は微分可能ではありません。

それでは、なぜ ReLU 関数が依然として深層学習で使用されているのでしょうか?

ReLU 関数は x=0 では微分可能ではありませんが、最適化アルゴリズムを微調整することで深層学習に適用できます。勾配降下法は、コスト関数を最小化するために使用される最適化アルゴリズムです。 ReLU 関数に x=0 で導関数が定義されていない場合は、それを 0 またはその他の値に設定して、最適化プロセスを続行できます。このようにして、ReLU 関数の非線形特性を利用して深層学習モデルのパフォーマンスを向上させることができます。

一般に、ReLU 活性化関数は、深層学習ネットワークで最も人気のある活性化関数の 1 つです。そのシンプルさと高い計算効率により、トレーニング中の収束を向上させるための重要なツールになります。 x=0 では微分可能ではありませんが、勾配降下法での応用には影響しません。したがって、ReLU 関数は機械学習の分野において多用途かつ強力なツールです。

ReLU関数のメリット

1. 計算が簡単。

整流関数は実装が非常に簡単で、max() 関数が必要です。

2. 表現のスパース性

スパース表現は、学習の高速化とモデルの簡素化に役立つため、表現学習において望ましい特性です。これにより、ニューラル ネットワークの隠れ層のアクティブ化に 1 つ以上の真のゼロ値を含めることができます。これは、負の入力でも真のゼロ値を出力できることを意味します。この機能により、ニューラル ネットワークで大規模なデータをより適切に処理できるようになり、コンピューティング リソースとストレージ リソースの必要性が軽減されます。したがって、スパース表現はニューラル ネットワークのパフォーマンスと効率を最適化するために非常に重要です。

3. 線形動作

整流関数は、線形活性化関数と同様に見え、同様に動作します。線形または線形に近い動作の最適化に適しています。

以上が機械学習における ReLU 関数を理解するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。