Transformer モデルは、セルフアテンション メカニズムを使用するシーケンス間モデルであり、自然言語処理の分野で広く普及しています。位置エンコーディングは Transformer モデルの重要なコンポーネントであり、シーケンス内の順序情報を効果的にモデルに導入できるため、シーケンス データの処理が向上します。位置エンコーディングを使用すると、モデルはシーケンス内の位置に基づいて単語をモデル化し、語順に関するコンテキスト情報を提供できます。この方法は、長いシーケンスを処理する際の従来のリカレント ニューラル ネットワーク (RNN) の勾配の消失または爆発の問題を回避します。位置エンコードは通常、学習可能なベクトルまたは固定サイン/コサイン関数を追加することによって実現されます。 Transformer モデルでは、位置エンコーディングの導入により、モデルがシーケンス データの順序関係をよりよく理解できるようになり、パフォーマンスと表現能力が向上します。

Transformer モデルでは、位置エンコーディングは独立した位置エンコーディング マトリックスを通じて実装されます。各行は位置エンコード ベクトルに対応し、入力シーケンス内の各単語に位置エンコード情報を追加するために入力単語埋め込みベクトルに追加されます。この方法により、モデルはシーケンス内のさまざまな単語の相対的な位置関係を捉えることができるため、入力シーケンスの意味をより深く理解できるようになります。

これらの位置エンコード ベクトルの生成方法には、sin 関数と cos 関数が使用されます。各位置 i および各次元 j について、位置エンコード行列の値は次の式で計算されます:

PE_{(pos,2i)}=sin(pos/ 10000^ {2i/d_{モデル}})

#PE_{(pos,2i 1)}=cos(pos/10000^{2i/d_{モデル}})このうち、posは現在位置、iは現在の次元、d_modelはモデルの次元を表します。ご覧のとおり、sin 関数と cos 関数はどちらも指数項を使用しており、この指数項の底は 10000 であり、指数項の累乗は位置と次元に基づいて計算されます。 では、なぜ位置エンコーディングとして sin 関数と cos 関数を使用するのでしょうか? 1. 周期性 sin 関数と cos 関数はどちらも周期関数であり、反復周期モデルを生成できます。シーケンスデータでは、通常、位置情報は周期的であり、たとえば自然言語処理では、文中の単語の位置は通常周期的です。 sin 関数と cos 関数を使用すると、モデルがこの周期的な情報を取得し、シーケンス データをより適切に処理できるようになります。 2. 異なる位置間のコーディングの違い sin 関数と cos 関数を使用すると、異なる位置間のコーディングの違いが生じる可能性があります。そして異なる位置でのcos関数の値は異なります。この違いは、モデルが異なる位置間の違いをより適切に区別し、シーケンス データをより適切に処理するのに役立ちます。 3. 解釈可能性 sin 関数と cos 関数を位置エンコーディングとして使用するもう 1 つの利点は、解釈可能であることです。これらの関数は数学の古典的な関数であるため、その特性と特性が非常に明確であるため、モデルへの影響をよりよく理解できます。 一般に、sin 関数と cos 関数を位置エンコーディングとして使用することは、Transformer モデルがシーケンス データをより適切に処理できるようにするための非常に効果的な方法です。同時に、この方法には一定の解釈可能性もあり、モデルの動作メカニズムをより深く理解するのに役立ちます。

以上が位置エンコーディングのためにトランスフォーマーで sin 関数と cos 関数を使用するのはなぜですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

GeminiとGroqによるドラフトプロンプトのチェーンApr 24, 2025 am 10:46 AM

GeminiとGroqによるドラフトプロンプトのチェーンApr 24, 2025 am 10:46 AMOpenaiのO1やDeepseek R1などの推論モデルの最近の進歩により、LLMSを推進し、Chain of Thound(COT)などのテクニックを通じて印象的なパフォーマンスを実現しました。ただし、COTの冗長性がつながります

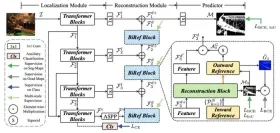

RF-DERT:オブジェクト検出のブリッジ速度と精度Apr 24, 2025 am 10:40 AM

RF-DERT:オブジェクト検出のブリッジ速度と精度Apr 24, 2025 am 10:40 AM読者を歓迎します、CVクラスはセッションに戻ってきました!これまでのところ、以前のブログでこれまでに30の異なるコンピュータービジョンモデルを調査しました。

エージェントSDK vs Crewai vs Langchain:いつ使用するのか?Apr 24, 2025 am 10:39 AM

エージェントSDK vs Crewai vs Langchain:いつ使用するのか?Apr 24, 2025 am 10:39 AMこの記事では、AIエージェントを構築するための3つの一般的なフレームワークを比較します:OpenaiのエージェントSDK、Langchain、およびCrewai。 それぞれが、タスクを自動化し、意思決定を強化するためのユニークな強みを提供します。 この記事では、最高のフラムを選択することをガイドします

Pydanticを使用した構造化された研究自動化システムの構築Apr 24, 2025 am 10:32 AM

Pydanticを使用した構造化された研究自動化システムの構築Apr 24, 2025 am 10:32 AM学術研究の動的な分野では、効率的な情報収集、統合、およびプレゼンテーションが最重要です。 文献レビューの手動プロセスは時間がかかり、より深い分析を妨げています。 マルチエージェントリサーチアシスタントシステムBUI

10 GPT-4Oの画像生成が今日試してみるようにプロンプトします!Apr 24, 2025 am 10:26 AM

10 GPT-4Oの画像生成が今日試してみるようにプロンプトします!Apr 24, 2025 am 10:26 AMAIの世界では絶対に野生のものが起こっています。 Openaiのネイティブイメージの生成は今、非常識です。私たちは顎を落とすビジュアル、恐ろしい良いディテール、そして洗練された出力について話しています。

Windsurfを使用したバイブコーディングのガイドApr 24, 2025 am 10:25 AM

Windsurfを使用したバイブコーディングのガイドApr 24, 2025 am 10:25 AMAIを搭載したコーディングコンパニオンであるCodeiumのWindsurfで、コーディングのビジョンを楽に命を吹き込みます。 Windsurfは、コーディングやデバッグから最適化まで、ソフトウェア開発ライフサイクル全体を合理化し、プロセスをINTUに変換します

RMGB V2.0を使用した画像のバックグラウンド削除の調査Apr 24, 2025 am 10:20 AM

RMGB V2.0を使用した画像のバックグラウンド削除の調査Apr 24, 2025 am 10:20 AMBraiaiのRMGB V2.0:強力なオープンソースバックグラウンド除去モデル 画像セグメンテーションモデルはさまざまな分野に革命をもたらし、バックグラウンドの削除が進歩の重要な分野です。 BraiaiのRMGB V2.0は、最先端のオープンソースmとして際立っています

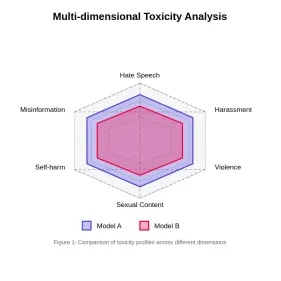

大規模な言語モデルでの毒性の評価Apr 24, 2025 am 10:14 AM

大規模な言語モデルでの毒性の評価Apr 24, 2025 am 10:14 AMこの記事では、大規模な言語モデル(LLM)における毒性の重要な問題と、それを評価して軽減するために使用される方法について説明します。 LLMSは、チャットボットからコンテンツ生成までさまざまなアプリケーションを電力を供給し、堅牢な評価メトリック、ウィットを必要とします

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 中国語版

中国語版、とても使いやすい

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

WebStorm Mac版

便利なJavaScript開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。