ホームページ >テクノロジー周辺機器 >AI >Stability AI がローカルで実行され、GPU を必要としない安定したコード 3B モデルをリリース

Stability AI がローカルで実行され、GPU を必要としない安定したコード 3B モデルをリリース

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-01-17 16:03:061062ブラウズ

Stability AI は最近、Stable Code 3B と呼ばれる最初の AI モデルを 2024 年にリリースしました。このモデルには 30 億のパラメーターがあり、補助コード タスクに焦点を当てています。

専用の GPU を必要とせずにラップトップでネイティブに実行しながら、Meta の CodeLLaMA 7B のような大規模モデルでも競争力のあるパフォーマンスを提供します。

2023 年末、Stability AI は、テキスト生成用の StableLM Zephyr 3B モデルなど、より小さく、よりコンパクトで、より強力なモデルの開発を促進し始めました。

2024 年初頭に、Stability AI は Stable Code 3B と呼ばれる重要な言語モデルをリリースしました。実際、そのプレビュー バージョンである Stable Code Alpha 3B は、すでに昨年 8 月にリリースされていました。それ以来、Stability AI はテクノロジーの改善を続けてきました。この新しいバージョンの Stable Code 3B は、コード補完専用に設計されており、さまざまな追加機能も備えています。

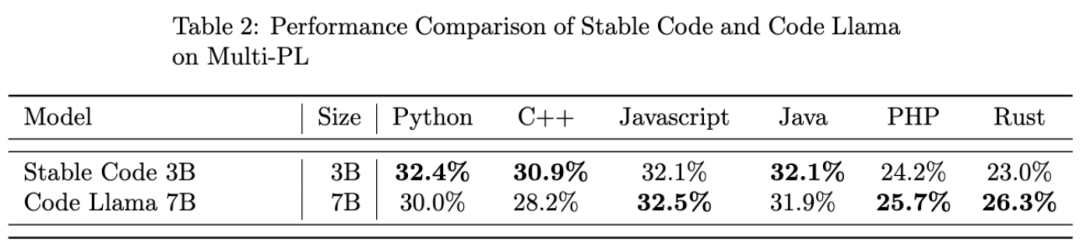

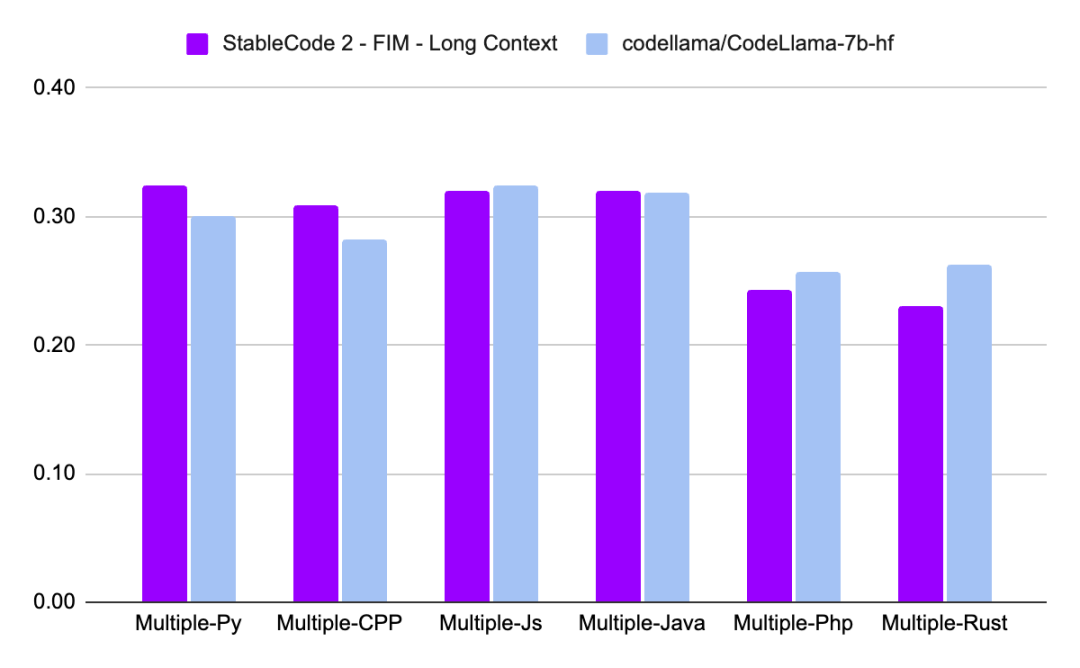

CodeLLaMA 7b と比較すると、Stable Code 3B はサイズが 60% 小さいですが、プログラミング タスクでは前者と同等のパフォーマンスを実現します。

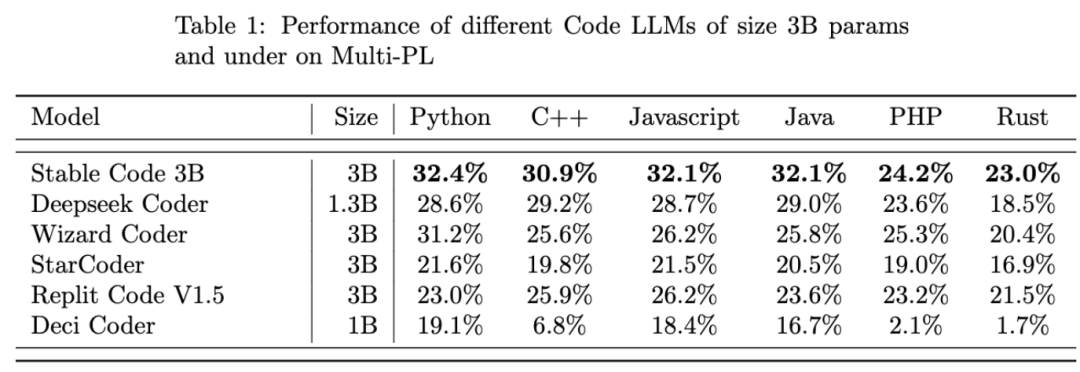

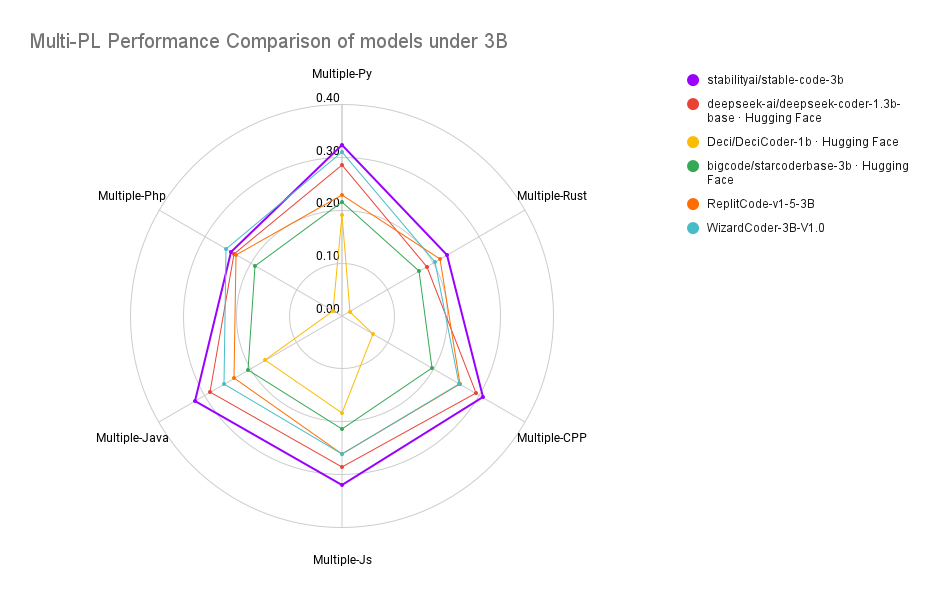

Stable Code 3B は、MultiPL-E ベンチマークで (同様のサイズのモデルと比較して) SOTA パフォーマンスを達成します (Python の Stable Code 3B など)。 C、JavaScript、Java、PHP、Rust プログラミング言語では StarCoder よりも優れています。

研究紹介

Stable Code 3B は、Stable LM 3B に基づいてトレーニングされています。トークンは4兆にも達します。さらに、Stable Code はソフトウェア エンジニアリングに固有のデータもトレーニングに使用します。

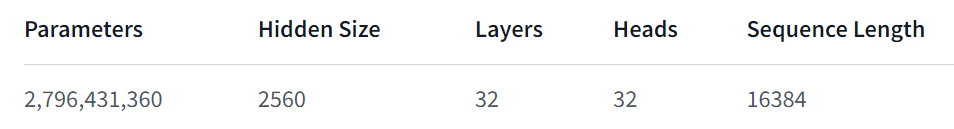

Stable Code 3B は、より多くの機能を提供し、複数の言語間でも良好なパフォーマンスを発揮します。また、FIM (Fill in the Middle、新しいトレーニング手法) 機能のサポートなどの利点もあります。コンテキスト サイズを拡張することもできます。基本的な安定したコードは、最大 16,384 個のトークン シーケンスでトレーニングされ、CodeLlama と同様のアプローチ、つまりロータリー エンベディングを使用し、オプションで最大 1,000,000 個の回転ベースの変更を許可します。モデルのコンテキスト長はさらに 100k トークンまで拡張されます。 。

モデル アーキテクチャの観点から見ると、Stable Code 3B モデルは、LLaMA アーキテクチャに似た純粋なデコーダ トランスフォーマですが、次の変更が加えられています。

- 位置埋め込み: スループットを向上させるために、回転された位置埋め込みがヘッド埋め込み次元の最初の 25% に適用されます。

- トークナイザー: GPTNeoX Tokenizer.NeoX の修正バージョンを使用し、

、 などの FIM 関数をトレーニングするための特別なトークンを追加します。

#トレーニング

トレーニング データ セット

Stable Code 3B のトレーニング データ セットは、Falcon RefinedWeb、CommitPackFT、Github Issues、StarCoder など、HuggingFace Hub で提供されるオープンソースの大規模データ セットをフィルター処理した混合物で構成されており、さらにデータが補足されています。数学の分野から。

#トレーニング インフラストラクチャ

##ハードウェア: Stability AI 256 NVIDIA の安定コード 3B A100 40GB GPU はトレーニング用にクラスターで使用されます。- ソフトウェア: 安定版コード 3B は gpt-neox のブランチを採用し、ZeRO-1 を使用して 2D 並列処理 (データおよびテンソル並列処理) でトレーニングし、フラッシュ アテンション、SwiGLU に依存します。 FlashAttendant-2 のローテーション埋め込みカーネル。

- 最後に、安定版コード 3B のパフォーマンスを見てみましょう:

Stable Code 3B に関するより詳細な技術レポートは、後日公開される予定ですので、楽しみにお待ちください。

Stable Code 3B に関するより詳細な技術レポートは、後日公開される予定ですので、楽しみにお待ちください。

以上がStability AI がローカルで実行され、GPU を必要としない安定したコード 3B モデルをリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。