人間と四足ロボットの間のシンプルかつ効果的なインタラクションは、有能なインテリジェントなアシスタント ロボットを作成する方法であり、テクノロジーが私たちの想像を超えた方法で私たちの生活を改善する未来を示しています。このような人間とロボットの対話システムの場合、鍵となるのは、四足ロボットに自然言語コマンドに応答する能力を与えることです。 #大規模言語モデル (LLM) は最近急速に開発され、高レベルの計画を実行できる可能性が示されています。ただし、特に本質的に不安定で高周波数の制御信号を必要とする脚式ロボットの場合、LLM が関節角度目標やモーター トルクなどの低レベルの命令を理解することは依然として困難です。したがって、既存の研究のほとんどは、ロボットの動作を決定する高レベルの API が LLM に提供されていることを前提としており、これによりシステムの表現能力が根本的に制限されます。 CoRL 2023 論文「SayTap: Language to Quadrupedal Locomotion」で、Google DeepMind と東京大学は、足の接触パターンを接続として使用する新しい方法を提案しました。人間の自然言語命令と低レベルのコマンドを出力するモーション コントローラー。

- 論文アドレス: https://arxiv.org/abs/2306.07580

- プロジェクト Web サイト: https://saytap.github.io/

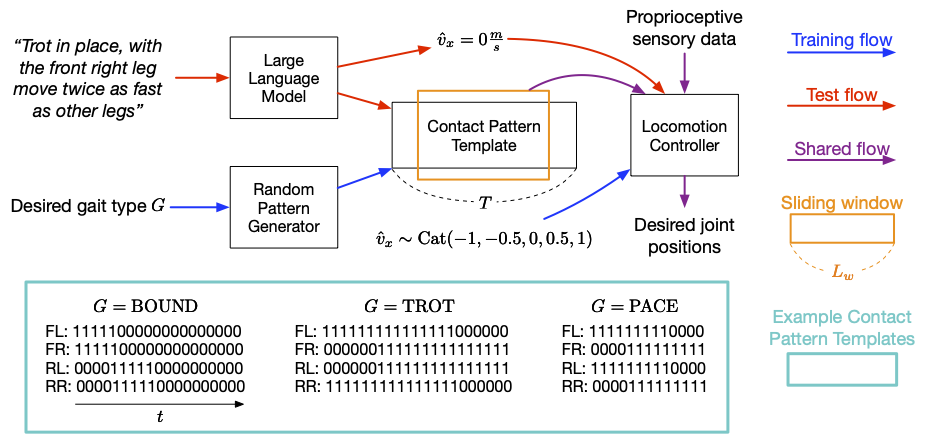

フット コンタクト パターンは、四足エージェントが移動するときの足のコンタクト パターンを指します。それらが地面に置かれる順序と方法。これに基づいて、ユーザーが簡単な言語を使ってロボットに歩く、走る、ジャンプするなどの動作を命令できるなど、さまざまな動作動作を柔軟に開発できる対話型四足ロボットシステムを開発しました。 彼らの貢献には、LLM プロンプト設計、報酬関数、および SayTap コントローラーが実現可能な接触パターン分布を使用できるようにするメソッドが含まれます。 研究によると、SayTap コントローラーは複数のモーション モードを実装でき、これらの機能は実際のロボット ハードウェアにも転送できることがわかっています。 SayTap メソッドは、4 つの連絡先パターン テンプレートを使用します。マトリックスの各行は、上から下に、それぞれ左前足部 (FL)、右前足部 (FR)、左後足部 (RL)、および右後足部 (RR) の足の接地パターンを示します。 SayTap の制御周波数は 50 Hz で、0 または 1 がそれぞれ 0.02 秒続くことを意味します。この研究では、望ましい足の接地パターンを、サイズ L_w および形状 4 X L_w の周期的なスライディング ウィンドウとして定義します。スライディング ウィンドウは、接触パターン テンプレートから四足接地フラグを抽出します。これは、時間 t 1 と t L_w の間にロボットの足が地面にあったか空中にあったかを示します。 SayTap メソッドの概要を次の図に示します。

#SayTap の概要望ましい足の接触パターンは、自然言語のユーザー コマンドとモーション コントローラーの間の新しいインターフェイスとして機能します。モーション コントローラーは、主要なタスク (指定された速度に従うなど) を実行し、達成される足の接触パターンが望ましい接触パターンにできるだけ近くなるように、特定の時間にロボットの足を地面に置くために使用されます。

これを行うために、各タイム ステップで、モーション コントローラーは、希望する足の接触パターンに加えて、関節の位置や速度などの固有受容データとタスク関連のデータを入力として受け取ります。入力 (ユーザー固有の速度コマンドなど)。 DeepMind は強化学習を使用してモーション コントローラーをトレーニングし、それをディープ ニューラル ネットワークとして表現しました。コントローラーのトレーニング中に、研究者らはランダムジェネレーターを使用して望ましい足の接触パターンをサンプリングし、その後、望ましい足の接触パターンを達成する低レベルのロボットアクションを出力するようにポリシーを最適化しました。テスト時には、LLM を使用してユーザー コマンドを足の接触パターンに変換します。 SayTap は、自然言語のユーザー コマンドと低レベルの制御コマンドの間の橋渡しとして足の接触パターンを使用します。 SayTap は、単純で直接的な指示 (「ゆっくり前にジョギングしてください」など) とあいまいなユーザー コマンド (「良いニュースです。今週末ピクニックに行きます!」など) の両方をサポートしています。強化学習に基づくモーション コントローラーを通じて、4 つの

研究によると、適切に設計されたプロンプトを使用することで、LLM はユーザー コマンドを特定の形式に正確にマッピングすることができます。ユーザーのコマンドが構造化されていない、または曖昧な場合でも、研究者らはランダム パターン ジェネレーターを使用して、特定のステップに基づいてパターン長 T が異なる複数の接触パターン テンプレートを生成しました。 1 サイクルにおける状態タイプ G の接触率により、モーション コントローラーは広範囲のモーション パターン分布を学習し、より優れた一般化機能を取得できます。詳細については、論文を参照してください。 #一般的な足の接触パターンのコンテキスト サンプルを 3 つだけ含む単純なプロンプトを使用することで、LLM はさまざまな人間のコマンドを正確に翻訳することができます。 #SayTap プロンプトは簡潔でコンパクトで、次の 4 つのコンポーネントが含まれています。

#(1) LLM が完了する必要があるタスクを説明するために使用される一般的な説明; (2) 四足歩行に関する基本的な知識に焦点を当てるために Remind LLM を使用した歩行定義および感情との関連性;(4) LLM がコンテキストで学習できるようにする例を示します。 研究者らはまた、ロボットが前進または後進、速くまたは遅く、または静止できるように、5 つの速度を設定しました。 #以下のアニメーションは、SayTap が直接明確なコマンドを正常に実行する例を示しています。一部のコマンドは 3 つのコンテキストの例に含まれていませんが、LLM は引き続き実行できます。これは、上記のプロンプトの 2 番目のモジュールである「歩行定義モジュール」をプロンプトで使用します。

構造化されていない、または曖昧なコマンドに従います

ただし、さらに興味深いのは、構造化されていない曖昧な命令を処理できる SayTap の機能です。いくつかのヒントを使用するだけで、特定の歩き方を一般的な感情的な印象に結びつけることができます。たとえば、ロボットが何か楽しいこと (「ピクニックに行こう!」など) を聞いた後に飛び跳ねるなどです。また、「地面がとても熱い」と言われると、ロボットは足を地面にできるだけ触れないよう素早く移動するなど、情景を正確に表現することができます。

SayTap は四足ロボット用の対話型システムです。さまざまな動作動作を柔軟に開発します。 SayTap は、自然言語と低レベル コントローラーの間のインターフェイスとして、望ましい足の接触パターンを導入します。新しいインターフェースは簡単かつ柔軟であり、ロボットが直接の指示と、ロボットがどのように動作するかを明示的に記述していないコマンドの両方に従うことができます。 DeepMind の研究者らは、今後の主な研究の方向性は、特定の感情を暗示するコマンドによって LLM が望ましい歩行を出力できるかどうかをテストすることであると述べました。上記の結果の歩行定義モジュールで、研究者らは幸せな感情を跳躍歩行に結び付ける文を提供しました。より多くの情報を提供すると、暗黙の感情の解読など、コマンドを解釈する LLM の能力が強化される可能性があります。実験評価では、幸せな感情と弾むような歩き方のリンクにより、ロボットは人間の漠然とした指示に従いながらも精力的に行動することができました。もう 1 つの興味深い将来の研究の方向性は、ビデオやオーディオなどのマルチモーダル入力の導入です。理論的には、これらの信号から変換された足の接触パターンは、ここで新しく提案されたワークフローにも適しており、より興味深い使用例が生まれることが期待されます。 元のリンク: https://blog.research.google/2023/08/saytap- language-to-quadrupedal.html

以上がGoogleは大型モデルを使用してロボット犬を訓練し、曖昧な指示を理解できるようにし、ピクニックに行くことに興奮しているの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。