ホームページ >テクノロジー周辺機器 >AI >Meta、キャラクターの会話シーンの吹き替えを生成するための音声から画像への AI フレームワークを開始

Meta、キャラクターの会話シーンの吹き替えを生成するための音声から画像への AI フレームワークを開始

- PHPz転載

- 2024-01-13 11:39:061057ブラウズ

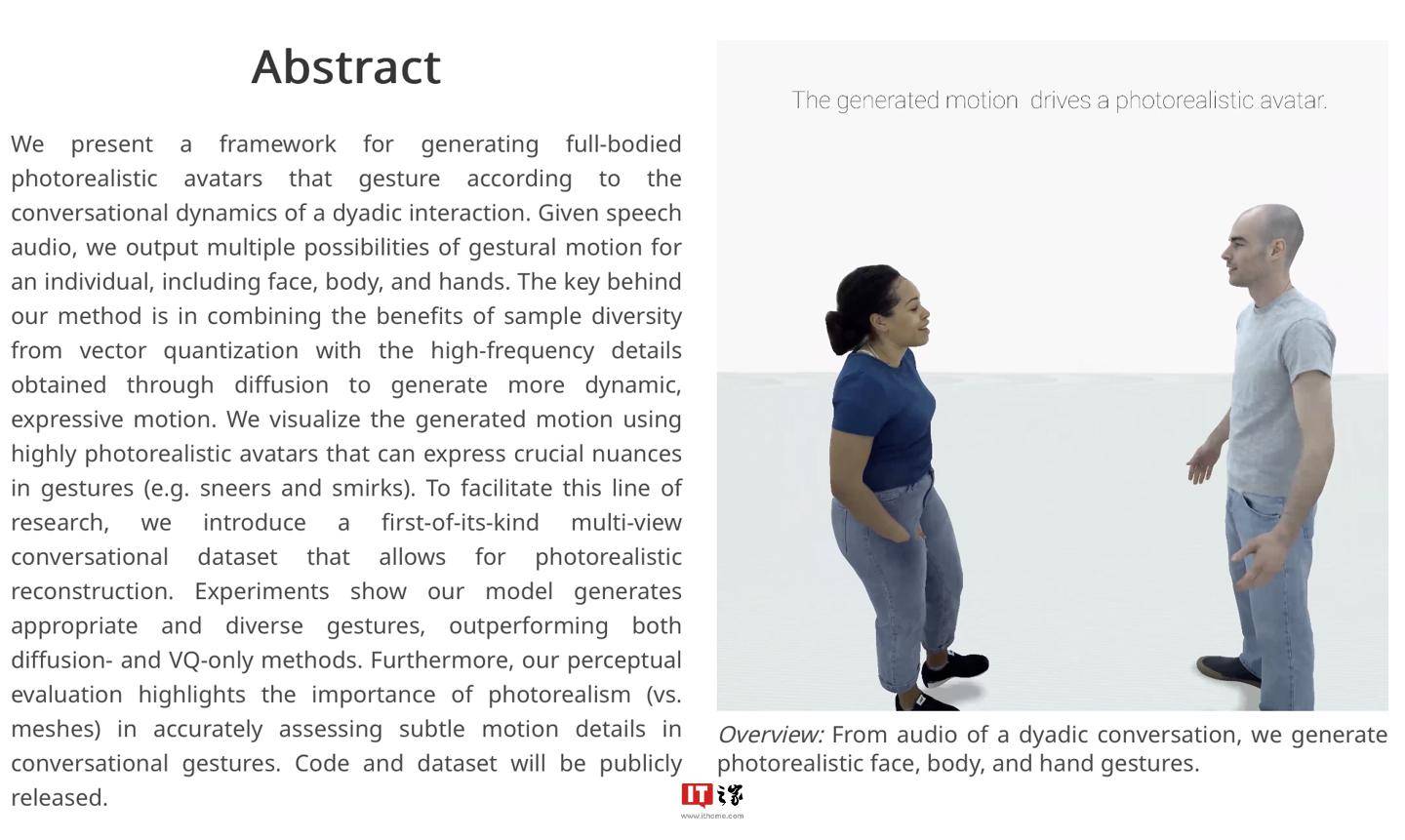

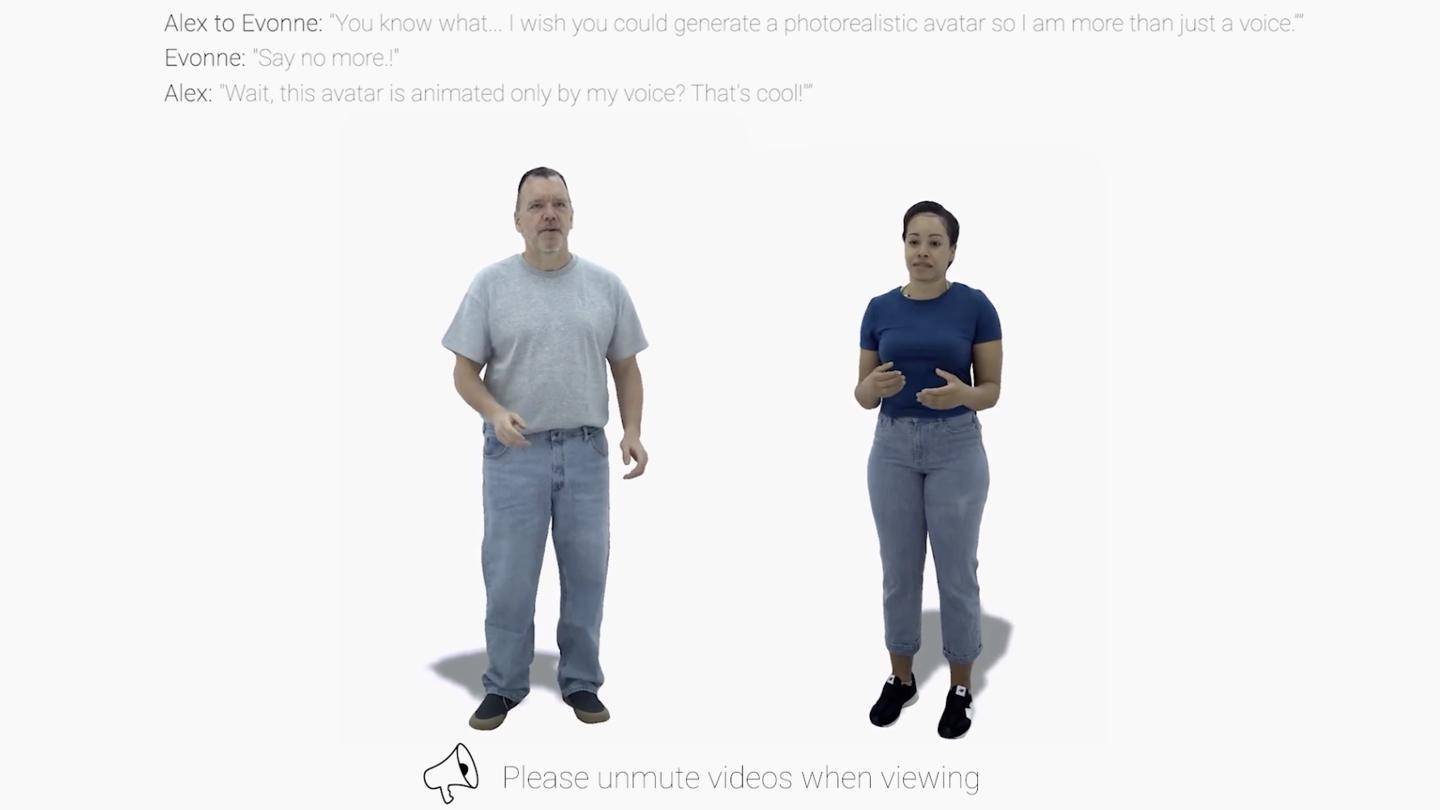

IT House News 1 月 9 日、Meta は最近、audio2photoreal と呼ばれる AI フレームワークを発表しました。これは、一連のリアルな NPC キャラクター モデルを生成し、既存の吹き替えファイルを利用してキャラクター モデルを自動的に「リップシンク」することができます。モーション"。

▲ 画像出典 メタリサーチレポート(以下同)

IT ハウスは、公式調査報告書から、ダビング ファイルを受け取った後、Audio2photoreal フレームワークが最初に一連の NPC モデルを生成し、次に量子化技術と拡散アルゴリズムを使用してモデル アクションを生成することを知りました。定量化技術は、モデルのアクション サンプルを提供します。フレームワークによって生成されるキャラクターやアクションの効果を向上させるために、参照拡散アルゴリズムが使用されます。

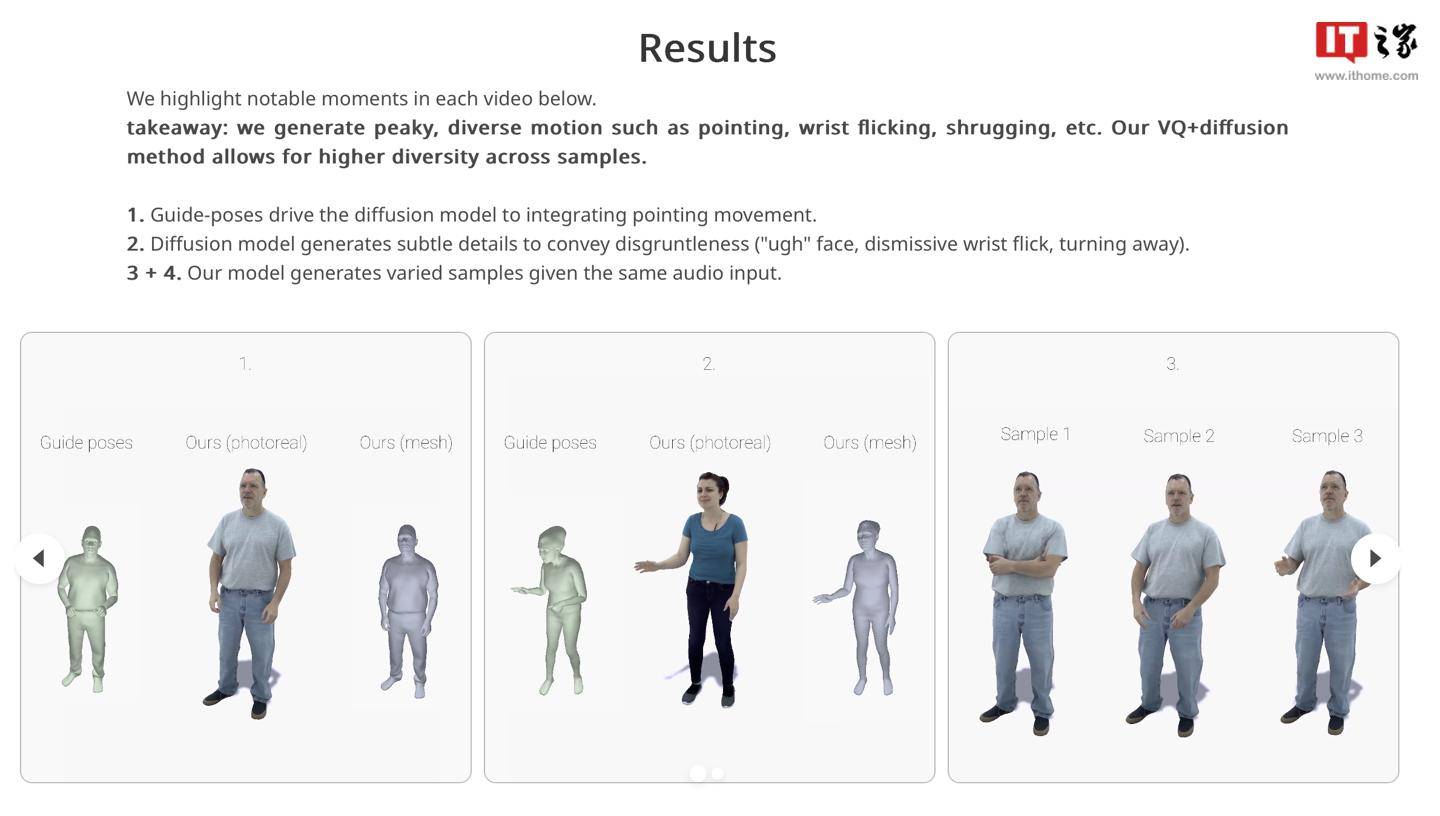

研究者らは、このフレームワークは 30 FPS で「高品質のアクション サンプル」を生成でき、会話中に「指を指す」「手首を回す」「肩をすくめる」などの無意識の「習慣的なアクション」をシミュレートすることもできると述べました。 」。

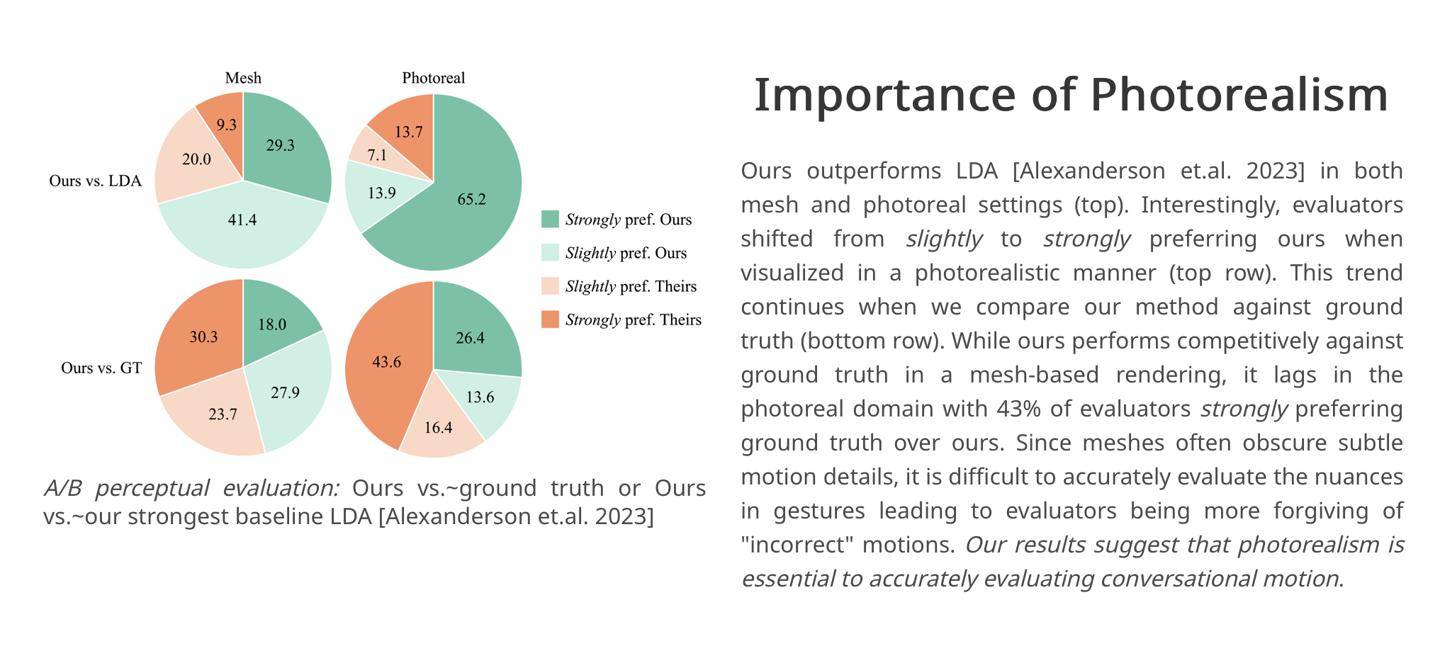

研究者らは独自の実験結果を引用しました。対照実験では、評価者の 43% がフレームワークによって生成されたキャラクターの対話シーンに「非常に満足」しました。したがって、研究者らは、Audio2photoreal フレームワークは「業界の競合製品と比較して、よりダイナミックな「表現力豊かなアクション」を実現します。

研究チームが関連するコードとデータセットを GitHub で公開したと報告されています。興味のあるパートナーは、ここをクリックしてアクセスしてください。

以上がMeta、キャラクターの会話シーンの吹き替えを生成するための音声から画像への AI フレームワークを開始の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。