ホームページ >テクノロジー周辺機器 >AI >写真とアクションコマンドだけで、Animate124 は簡単に 3D ビデオを生成できます

写真とアクションコマンドだけで、Animate124 は簡単に 3D ビデオを生成できます

- 王林転載

- 2024-01-12 11:12:101037ブラウズ

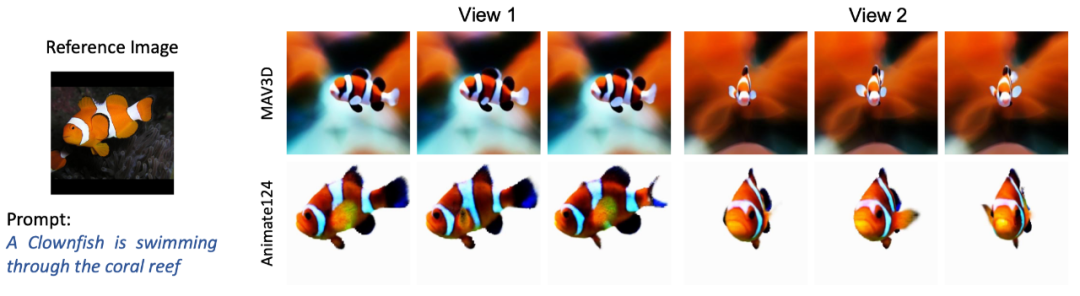

Animate124 を使用すると、1 枚の写真を簡単に 3D ビデオに変換できます。

- プロジェクトのホームページ: https://animate124.github.io/

- 論文アドレス: https://animate124.github.io/

- ://arxiv.org/abs/2311.14603

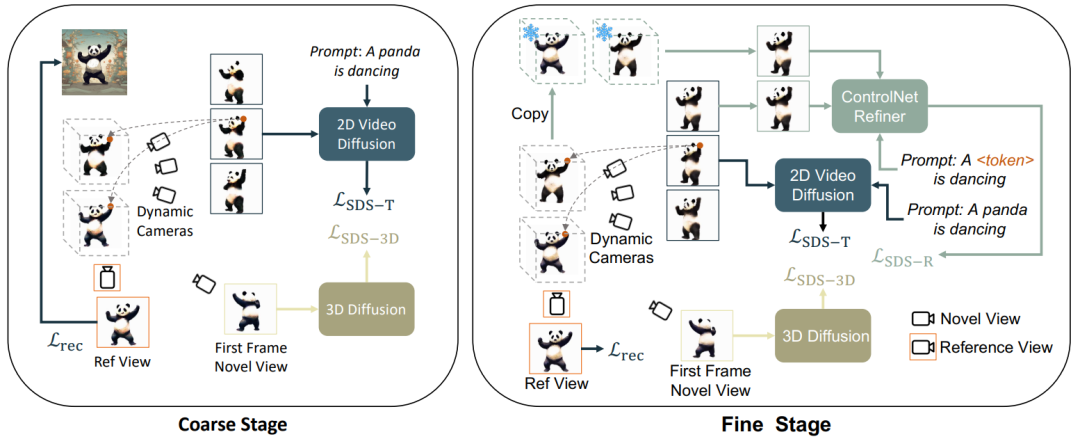

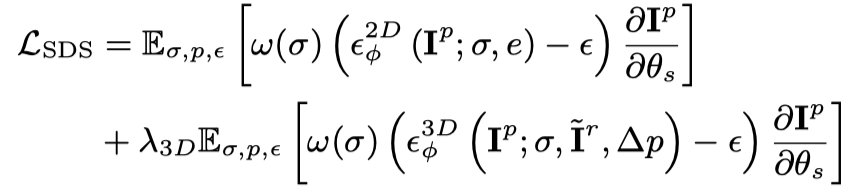

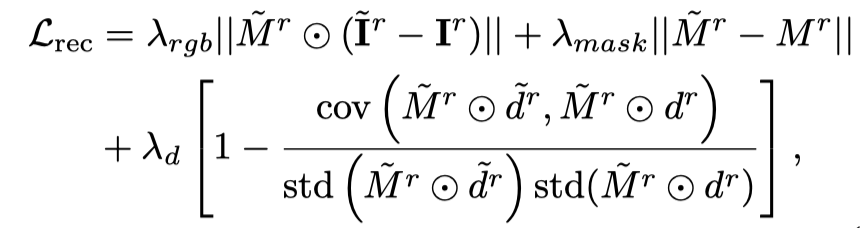

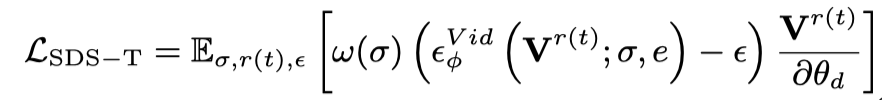

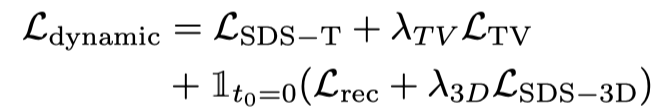

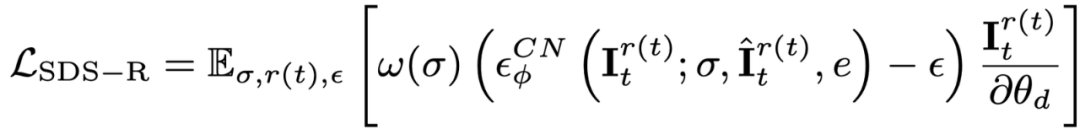

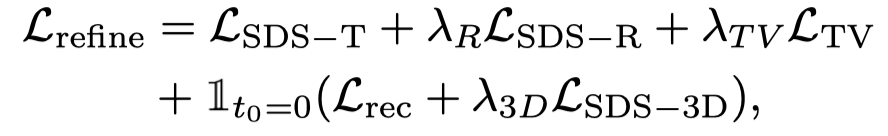

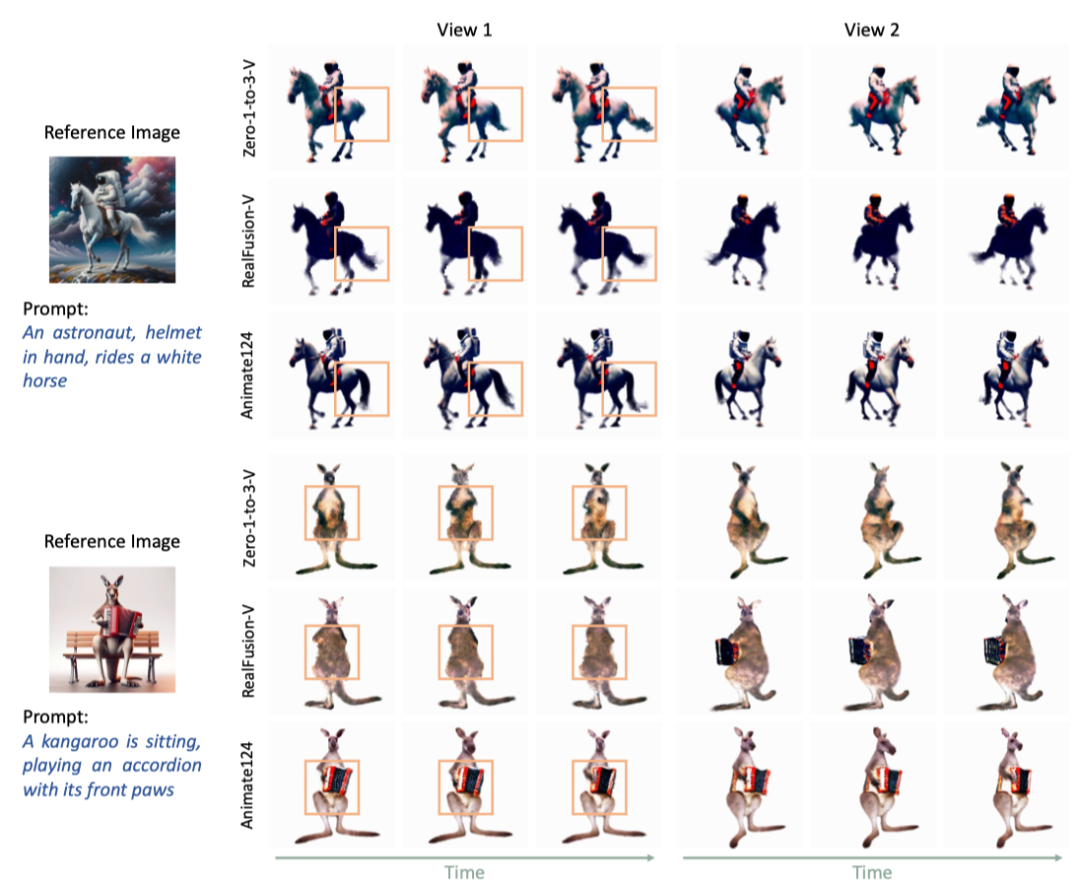

静的最適化と動的最適化、粗い最適化と細かい最適化に従って、この記事では 3D ビデオ生成を 3 つの段階に分割します: 1) 静的生成段階: 鹿肉グラフと 3D グラフ拡散モデルを使用して、単一の画像から 3D オブジェクトを生成します。2)動的ラフ生成ステージ: Vincent ビデオ モデルを使用して、言語記述に基づいてアクションを最適化します; 3) セマンティック最適化ステージ: さらに、パーソナライズされた微調整 ControlNet を使用して、第 2 ステージで言語記述によって引き起こされるオフセットを最適化および改善します。

静的最適化と動的最適化、粗い最適化と細かい最適化に従って、この記事では 3D ビデオ生成を 3 つの段階に分割します: 1) 静的生成段階: 鹿肉グラフと 3D グラフ拡散モデルを使用して、単一の画像から 3D オブジェクトを生成します。2)動的ラフ生成ステージ: Vincent ビデオ モデルを使用して、言語記述に基づいてアクションを最適化します; 3) セマンティック最適化ステージ: さらに、パーソナライズされた微調整 ControlNet を使用して、第 2 ステージで言語記述によって引き起こされるオフセットを最適化および改善します。

Vincent ビデオの蒸留損失のみを使用すると、3D モデルが画像の内容を忘れてしまい、ランダム サンプリングではビデオの初期段階と終了段階でのトレーニングが不十分になります。したがって、この論文の研究者は、開始タイムスタンプと終了タイムスタンプをオーバーサンプリングしました。また、最初のフレームをサンプリングするときに、最適化 (3D グラフの SDS 蒸留損失) のために追加の静的関数が使用されます。

Vincent ビデオの蒸留損失のみを使用すると、3D モデルが画像の内容を忘れてしまい、ランダム サンプリングではビデオの初期段階と終了段階でのトレーニングが不十分になります。したがって、この論文の研究者は、開始タイムスタンプと終了タイムスタンプをオーバーサンプリングしました。また、最初のフレームをサンプリングするときに、最適化 (3D グラフの SDS 蒸留損失) のために追加の静的関数が使用されます。

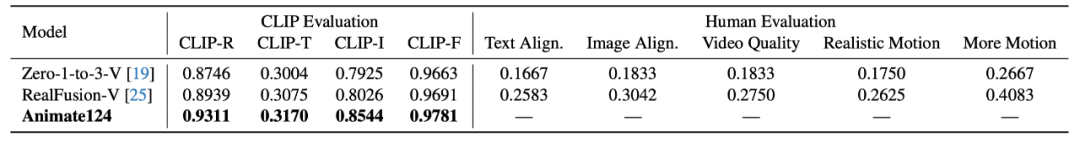

この記事では、CLIP と手動評価を使用して品質を生成しています。CLIP 指標には、テキストとの類似性、検索精度、画像品質が含まれます。類似性と時間的一貫性。手動評価指標には、テキストとの類似性、写真との類似性、ビデオ品質、動きのリアルさ、動きの振幅が含まれます。手動評価は、対応するメトリックにおける Animate124 の選択に対する単一モデルの比率で表されます。

2 つのベースライン モデルと比較して、Animate124 は CLIP 評価と手動評価の両方でより良い結果を達成しています。

##概要

以上が写真とアクションコマンドだけで、Animate124 は簡単に 3D ビデオを生成できますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

声明:

この記事はjiqizhixin.comで複製されています。侵害がある場合は、admin@php.cn までご連絡ください。

前の記事:2023年年次総括:ファーウェイのデータセンターネットワークが「作戦」に呼応して台頭しAI時代に新たな勢いを与える次の記事:2023年年次総括:ファーウェイのデータセンターネットワークが「作戦」に呼応して台頭しAI時代に新たな勢いを与える

関連記事

続きを見る- インテルは 4 つの主要なビジネス分野における業界に対する深い洞察を持っており、アプリケーション例、革新的な製品、ソリューションを解釈しています丨インテル ビジョン

- Luxshare Precision: 人型ロボットなどの新興産業に参入するための成熟した能力とビジネス基盤を備えています

- Yuanverse 業界の発展を支援するために、このモバイル通信の革新的なアプリケーション コンテストが開始されました。

- 10,000 ワードの長文丨 AI セキュリティ産業チェーン、ソリューション、起業の機会を解体する

- 2023年第1回長江デルタロボット産業チェーン共同開発サミットフォーラムが安徽省蕪湖市で成功裡に開催された